[논문 봇]을 이용한 논문 요약 "ImageNet Classification with Deep Convolutional Neural Networks"

ChatGPT - 🧑🏫 정말 완벽한 논문 요약 설명 (API + 5모드)

최근에 나름 도전을 하게 되었는데요, 비전공자로서 인공지능 논문 스터디에 참여해 함께 진행하게 되었습니다. 그런데, 논문을 어떻게 공부하고 요약해야할 지 막막하더라구요.

이전부터 gpt로 논문 요약을 여러번 시도 해보았는데, 모든 디테일들을 꼼꼼히 요약해주지 않는 것 같아서 어떻게 해야 할지 고민이 많았어요.

그런데, 이번 주 스터디에서 다른 분들이 요약하신 것에 아이디어를 얻어서 '논문봇' gpts 를 제작해보게 되었어요. 공식 부분에서 좀 삐걱거리는 부분이 있어서 아직 공개 할 수 있는 수준은 아니고 어떤식으로 공개해야 할지 고민을 좀 하고 있지만, 일단 성능이 혼자 쓰기에는 마음에 들어서 결과가 다른 분들이 보시기에도 괜찮아 보이는지 혹은 어떤 부분이 더 들어가면 좋을지 여쭤보려고 올려보았어요!

논문 봇은 5가지 모드로 입력하면 요약하게 되어있어요. (모드 : /Intro, /Analysis, /Results, /Functions, /Code Implementation) 일단 5가지 모드 별로 다 요약한 내용을 좀 더 쉽게 중학생의 관점에서 다시 정리하도록 틸노트봇에게 한 번 더 부탁하였습니다.

이렇게 하니까 총 6~8번의 과정을 거치게 되기는 하지만, 다른 분들에게 블로그 등으로 공개 할 수 있을 정도의 자세한 요약이 된 것 같아요. 참 중간에 result 부터는 메세지 제한에 걸려서 일단 api로 돌렸습니다.. 아 그리고 영어로 받고 한국어로 3.5에게 번역을 시켰습니다.

스터디를 진행한 논문은 "ImageNet Classification with Deep Convolutional Neural Networks (2012)" 입니다.

안녕하세요, 여러분. 오늘 우리는 'ImageNet Classification with Deep Convolutional Neural Networks(이미지넷 분류를 위한 깊은 합성곱 신경망)'이라는 논문을 살펴볼 거예요. 이 논문은 컴퓨터가 스스로 사진 속의 물체를 인식하도록 학습시키는 방법에 대한 연구입니다.

먼저, 이 논문의 주요 개념부터 살펴볼게요.

'합성곱 신경망(CNN)'은 사진을 입력으로 받아 그 사진 속 다양한 특징을 분석해서 어떤 물체인지 알아내는 컴퓨터 프로그램이죠. 예를 들어, 고양이 사진이 입력되면, CNN은 고양이의 귀, 눈, 털 등 사진 속 특징들을 학습하여 '이건 고양이다!'라고 인식할 수 있어요.

'ReLU(Rectified Linear Unit)'는 신경망이 복잡한 것을 더 잘 배울 수 있도록 돕는 일종의 수학 함수예요. 사람의 뇌도 복잡한 정보를 처리할 때 비슷한 방식으로 일을 한답니다.

'과적합(Dropout)'이라는 문제는 네트워크가 훈련 데이터에만 너무 익숙해져서 새로운 데이터에는 잘 대응하지 못하는 것을 말해요. 이를 방지하기 위해, 연구자들은 Dropout이라는 기술을 사용하는데요, 이것은 무작위로 일부 뉴런의 연결을 끊어서 네트워크가 과적합 없이 더 일반적인 규칙을 배울 수 있게 해줘요.

이제, 연구 방법론과 실험이 어떻게 이루어졌는지 설명해보죠.

연구자들은 'AlexNet'이라는 이름의 CNN을 만들었어요. 이 신경망은 대략 6천만 개의 매개변수와 65만 개의 뉴런으로 구성되어 있으며, 이미지를 입력받아 처리하는 데 5개의 합성곱 층과 3개의 완전 연결층을 사용했어요.

신경망은 단일 GPU에서만 돌리기에는 너무 커서 두 개의 GPU를 사용해야 했죠. 연구자들은 두 GPU를 통해 신경망의 다른 부분을 처리하도록 해서 오류율을 낮추는 데 성공했습니다. 상위 1 오류율은 1.7%, 상위 5 오류율은 1.2% 감소했다고 해요.

이 논문에서 제시한 방법을 사용하여, ImageNet이라는 대형 이미지 데이터셋에 있는 이미지들을 분류하는 데 실험을 했습니다.연구자들은 과적합을 방지하기 위해 이미지를 수평으로 뒤집거나 색조를 조금 변형시키는 등의 방법으로 데이터를 증강했어요.

테스트 결과, AlexNet은 기존에 사람들이 생각했던 최첨단 기술보다 훨씬 나은 성능을 보였어요. 상위 5개 테스트 오류율이 예전의 25.8%에서 15.3%로 크게 떨어졌으니까요.

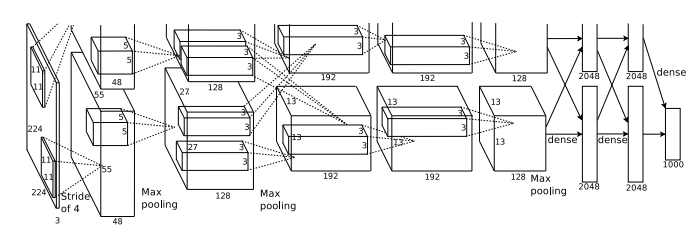

그림 1과 그림 2에 신경망의 모델링 방법과 심층 학습하는 구조가 나와있어요. 이 그림들을 통해 우리는 수학적으로 어떻게 뉴런이 작동하는지, 그리고 신경망이 어떻게 구성되어있는지 알 수 있습니다.

그래서, 이 논문은 컴퓨터가 사진 속 물체를 인식하는 능력을 크게 향상시켰다는 중요한 결과를 우리에게 보여줍니다. 이는 인공지능과 컴퓨터가 우리의 삶을 편리하게 만드는 데 큰 도움을 줄 수 있는 발전이라고 할 수 있죠.

이 다음 부터는 제가 제작한 '논문봇'의 5가지 모드를 통해 더 자세하게 요약을 진행한 내용입니다.

Introduction & Key Concepts of "ImageNet Classification with Deep Convolutional Neural Networks"

초록 요약

이 논문은 ImageNet 대규모 시각 인식 챌린지(ILSVRC) 2012에서 중요한 진전을 이룬 깊은 합성곱 신경망(CNN)을 제시합니다. 이 CNN인 "AlexNet"은 이전 최첨단 오류율 25.8%에 비해 상위 5 테스트 오류율을 15.3%로 급격하게 낮추었습니다. 네트워크의 아키텍처 및 ReLU 비선형성, dropout, 효율적인 GPU 사용과 같은 혁신적인 접근 방식이 이 성과에 중요한 역할을 했습니다.

배경 및 목적

이 작업 이전에 컴퓨터 비전의 전통적인 방법은 대규모 이미지 데이터셋을 효과적으로 처리할 수 없었습니다. 심층 학습의 등장은 상당한 개선의 가능성을 가져왔습니다. 시각 인식에서 주요 기준인 ImageNet Challenge는 수천 개 범주의 15백만 개 이상의 레이블이 지정된 고해상도 이미지 데이터셋에서 새로운 방법을 시험할 수 있는 플랫폼을 제공했습니다. 이 연구의 목적은 대규모 고해상도 이미지 분류를 다루는 깊은 합성곱 신경망의 효과를 입증하고, 이러한 네트워크의 교육 및 일반화를 개선하기 위한 혁신적인 기술을 소개하는 것이었습니다.

주요 AI 개념 및 용어

합성곱 신경망 (CNN): 이미지를 입력으로 받아 이미지의 다양한 측면/객체에 중요성(학습 가능한 가중치 및 편향)을 할당하고 서로를 구별할 수 있는 심층 학습 알고리즘.

ReLU (Rectified Linear Unit): 활성화 함수의 일종으로 f(x) = max(0, x)로 정의되며, 네트워크에 비선형성을 도입하여 복잡한 패턴을 학습하는 데 도움이 되는 함수.

과적합 및 Dropout: 과적합은 모델이 교육 데이터의 세부 사항과 노이즈를 학습하여 새 데이터에서 모델의 성능에 부정적인 영향을 미치는 경우 발생합니다. Dropout은 교육 중에 무작위로 선택된 뉴런을 무시하는 정규화 기술로, 과적합을 방지하는 데 도움이 됩니다.

확률적 경사 하강법: 적절한 부드러운 속성을 갖는 목적 함수를 최적화하기 위한 반복적인 방법으로, 심층 학습 모델의 교육에 널리 사용됨.

소프트맥스 함수: 숫자의 벡터를 각 값의 상대적 크기에 비례한 확률 벡터로 변환하는 수학 함수.

이 소개는 논문의 목표, 인공 지능 및 컴퓨터 비전 분야에서의 중요성, 그리고 나머지 논문을 이해하는 데 필수적인 핵심 개념을 소개합니다.

Analysis: Methodology & Experiment Analysis of "ImageNet Classification with Deep Convolutional Neural Networks"

배경 및 개요

이 논문은 Alex Krizhevsky, Ilya Sutskever, Geoffrey E. Hinton이 공동 저술한 것으로, ImageNet Large-Scale Visual Recognition Challenge (ILSVRC) 2010에서 고해상도 이미지를 분류하기 위한 깊은 합성곱 신경망(CNN)을 제시합니다. 이 네트워크는 6000만 개의 매개변수와 65만 개의 뉴런으로 이루어져 있으며, 다섯 개의 합성곱층, 일부는 맥스 풀링층이 뒤따르고 있는 구조로, 그리고 세 개의 완전 연결층이 특징입니다. 주요 혁신 요소로는 ReLU(정류된 선형 단위) 비선형성의 사용, 효율적인 GPU 구현 및 "드롭아웃"이라는 정규화 방법이 있습니다.

방법론

ReLU 비선형성 (3.1 절):

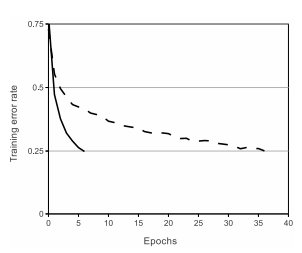

전통적인 tanh 또는 sigmoid 활성화 함수 대신 ReLU가 사용됩니다. 이 선택은 CIFAR-10 데이터셋에서의 실험을 통해 확인된 대로 훈련 속도를 크게 높입니다. 여기서 ReLU를 사용한 CNN은 tanh 유닛을 사용한 네트워크보다 25% 훈련 오류율이 6배 빨리 도달했습니다.

다중 GPU에서 훈련 (3.2 절):

단일 GPU의 메모리 제약으로 인해 네트워크는 두 개의 GPU에 분산되었습니다. 각 GPU가 네트워크의 다른 부분을 처리하는 혁신적인 병렬화 방식을 도입하여 이 접근은 단일 GPU 구현과 비교하여 상위 1 및 상위 5 오류율을 각각 1.7% 및 1.2% 감소시켰습니다.

지역 응답 정규화 (3.3 절):

ReLUs는 입력 정규화가 필요하지 않지만, 논문에서는 각 위치에서 뉴런 출력 간의 경쟁을 촉진하는 실제 뉴런의 측면 억제에 영감을 받은 지역 응답 정규화 체계를 소개합니다.

중첩 풀링 (3.4 절):

일반적으로 CNN의 풀링층은 중첩되지 않지만, 저자들은 중첩 풀링을 사용하여 네트워크의 오류율과 과적합을 감소시켰습니다. 구체적으로 3x3 풀링 크기와 2의 보폭이 사용되었습니다.

전체 구조 (3.5 절):

네트워크의 구조는 가중치가 있는 여덟 개의 층으로 구성되어 있으며, 다섯 개의 합성곱층과 세 개의 완전 연결층이 이어집니다. 마지막 완전 연결층의 출력은 1000가지 클래스 레이블에 대한 분포를 생성합니다.

실험 설정

이 네트워크는 ImageNet LSVRC-2010 및 ILSVRC-2012 데이터셋에서 훈련 및 테스트되었습니다. ImageNet에는 22,000개 이상의 범주에서 15백만 개 이상의 레이블이 지정된 고해상도 이미지가 포함되어 있습니다. 본 연구에서 사용된 LSVRC-2010 버전에는 1000개 범주에 걸쳐 120만 개의 훈련 이미지, 5만 개의 검증 이미지, 15만 개의 테스트 이미지가 포함되어 있습니다.

훈련의 주요 측면

데이터 증강:

과적합을 줄이기 위해 저자들은 이미지 이동, 수평 반전 및 RGB 채널 강도 변경을 사용했습니다.

드롭아웃:

과적합을 줄이는 또 다른 기술로는 드롭아웃이 사용되었습니다. 이 기법은 훈련 중에 각 숨겨진 뉴런의 출력을 0의 확률로 설정하는 것입니다(확률은 0.5).

훈련 세부 사항:

모델은 배치 크기 128 예제, 모멘텀 0.9 및 가중치 감소 0.0005를 사용하는 확률적 경사 하강법을 사용하여 훈련되었습니다.

이 자세한 분석은 논문에서 사용된 방법론과 실험 설정의 본질을 포착하며, 이미지 분류 작업에서 네트워크의 놀라운 성능에 기여한 혁신적인 측면을 강조합니다.

Functions & Formulas: Figures from "ImageNet Classification with Deep Convolutional Neural Networks"

Figure 1: ReLU 비선형성

신경망(neural network)의 뉴런 출력을 모델링하는 방법에 대한 세부 내용을 설명합니다. 논문은 이 출력을 모델링하는 데 전통적으로 사용되는 두 개의 비선형 함수의 예시를 제시합니다:

1. Hyperbolic tangent 함수: \(f(x) = \tanh(x)\)

2. Logistic sigmoid 함수: \(f(x) = (1 + e^{-x})^{-1}\)

그러나 논문은 이러한 전통적인 함수들이 그들의 포화 성질로 인해 경사 하강법(gradient descent)으로 훈련 시 느릴 수 있다고 지적합니다. 이로 인해 포화되지 않는 비선형성 함수의 도입이 필요해졌습니다:

**Rectified Linear Unit (ReLU):** \(f(x) = \max(0, x)\)

이 새로운 함수는 ReLU라고도 불리는 이 유형의 함수를 가진 뉴런이 전통적인 tanh 단위를 사용하는 네트워크보다 몇 배 빨리 훈련될 수 있도록 도와줍니다

Figure 2: CNN 아키텍처

Figure 2는 논문에서 사용된 CNN의 아키텍처를 보여주고, 네트워크가 두 개의 GPU 간에 어떻게 나뉘어지는지를 보여줍니다. 입력 차원은 150528이며, 그 다음 레이어의 뉴런 수는 다음과 같이 명시되어 있습니다: 253440, 186624, 64896, 64896, 43264, 4096, 4096 및 1000.

상세 설명:

레이어별 분배: 그림은 네트워크의 다른 부분이 두 GPU에 걸쳐 어떻게 할당되는지 보여줍니다. 이 분배는 대규모 네트워크의 계산 부하와 메모리 요구 사항을 관리하는 데 중요합니다.

입력 차원: 네트워크는 150528 차원의 입력을 받습니다. 이 높은 차원은 처리되는 고해상도 이미지의 복잡성과 다양성을 수용합니다.

레이어별 뉴런 수: 각 레이어의 뉴런 수(253440, 186624 등)는 네트워크의 규모와 깊이를 나타냅니다. 이러한 큰 숫자는 네트워크가 입력 이미지의 세부적이고 복잡한 표현을 학습할 수 있는 능력을 반영합니다.

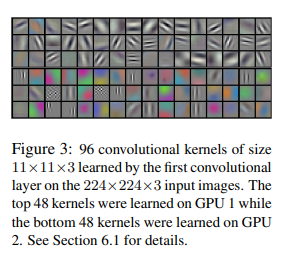

Figure 3: 합성곱 커널

Figure 3은 네트워크의 데이터 연결 레이어에서 학습된 합성곱 커널을 보여줍니다. 이 커널은 다양한 주파수 및 방향 선택적 응답과 색상 특정 패턴을 나타냅니다. 그림은 두 GPU가 어떻게 특화되었는지를 강조하며, GPU 1은 색상에 중립적인 특징에 중점을 두고 있으며, GPU 2는 색상에 특화된 특징에 더 중점을 두고 있습니다.

상세 설명:

커널 다양성: 커널의 다양성(주파수 및 방향 선택적, 색상 덩어리)은 네트워크가 입력 이미지에서 다양한 특징을 식별하는 데 학습했음을 시사합니다. 이는 정확한 이미지 분류를 위해 중요합니다.

GPU 특화: GPU의 특화(한 쪽은 색상에 중립적이고 다른 한 쪽은 색상에 특화된 특징에 중점을 둔)은 노동 분담의 효율적인 분배를 나타냅니다. 이 특화는 각 GPU가 특정 유형의 정보를 처리하는 데 더 능숙해지도록 허용하여 전체적인 성능에 기여할 것으로 예상됩니다.

초기화와의 독립성: 이러한 특화가 특정 무작위 가중치 초기화에 상관없이 발생한다는 사실은 네트워크 아키텍처의 견고하고 일관된 학습 행동을 시사합니다.

이러한 그림들은 CNN의 아키텍처 및 학습된 특징에 대한 시각적 및 구조적 이해를 제공하여 이미지 분류 작업에서의 네트워크의 기능과 효과를 이해하는 데 중요합니다.

Results & Implications of "ImageNet Classification with Deep Convolutional Neural Networks"

이 논문에서 저자들은 ILSVRC-2012 대회에서의 결과를 보고하며, 자신들의 깊은 합성곱 신경망(CNN) 모델을 다른 모델과 비교했습니다. 주요 결과는 이미지 분류 작업의 성능을 평가하는 표준 메트릭인 Top-1 및 Top-5 오류율로 제시되었습니다. 이러한 결과를 자세히 살펴봅시다:

Table 1 결과:

Sparse Coding [2]: Top-1 오류율은 47.1%, Top-5 오류율은 28.2%.

SIFT + FVs [24]: (Scale-Invariant Feature Transform + Fisher Vectors) Top-1 오류율은 45.7%, Top-5 오류율은 25.7%.

CNN (저자들의 모델): Top-1 오류율은 37.5%, Top-5 오류율은 17.0%[1].

Table 2 결과:

다른 데이터셋에서 6번째 합성곱 레이어를 추가한 CNN 모델은 Top-1 오류율이 67.4%, Top-5 오류율이 40.9%로 달성되었습니다. 이는 ILSVRC-2012 데이터셋이 아닙니다. 이 다른 데이터셋에서 이전에 발표된 최고의 결과는 Top-1 오류율이 78.1%, Top-5 오류율이 60.9%였습니다[2].

AI 분야 및 실제 응용에 대한 함의:

이러한 결과는 논문에서 설명한 CNN 모델이 이전 접근법을 크게 능가한다는 것을 보여주며, 특히 이미지 분류 작업에 대한 깊은 학습 모델의 잠재력을 보여줍니다. 이 향상된 성능은 의료 이미지 분석, 자율 주행 자동차, 소매업에서의 시각적 검색 등 다양한 응용 분야에서 더 정확한 이미지 인식 시스템으로 이어질 수 있습니다.

제한 사항 및 향후 연구:

저자들은 CNN 모델의 결과가 네트워크 크기와 훈련 시간이 늘어남에 따라 개선되었지만, 인간 시각 시스템과 비교 가능한 성능을 달성하기 위해서는 더 많은 네트워크 크기의 증가가 필요하다고 언급했습니다. 또한, 크고 깊은 CNN을 비디오 시퀀스에 적용함으로써 정적 이미지에 추가적인 맥락을 제공하는 시간 정보가 있는 경우에도 더 큰 향상이 가능할 것으로 제안했습니다.

결론:

깊은 CNN 모델은 중요한 컴퓨터 비전 벤치마크에서 탁월한 성능을 보여주며, 최첨단 기법과 비교하여 오류율을 감소시켰습니다. 이러한 진전은 AI에서 깊은 학습의 중요성을 강조하며 이미지 분류 및 다른 AI 작업에서 가능한 범위를 계속 넓히는 더 정교한 모델의 설계에 기여합니다.

Code Implementation of "ImageNet Classification with Deep Convolutional Neural Networks"

// Pseudocode description of CNN implementation based on the paper's architecture

Initialize the CNN architecture with these layers:

- Input layer accepting images of size as per dataset standard

- Five convolutional layers with ReLU activation, each followed by pooling and normalization

- Three fully connected layers with ReLU activation (note: the last layer is the softmax output layer)

function train_cnn_model(training_data, validation_data):

Initialize weights and biases for all layers randomly

for each epoch in the training process:

for each mini-batch in training_data:

Perform forward propagation through all layers

Calculate loss using a softmax cross-entropy function

Perform backward propagation using gradients to update weights

Apply dropout on the fully connected layers (if needed)

Evaluate the model on validation_data to calculate top-1 and top-5 error rates

if validation error decreases:

Save the current model as the best model

return best_model

function test_cnn_model(test_data, model):

Load the best_model

for each image in test_data:

Perform forward propagation through the model

Record the top-1 and top-5 predictions

Calculate and print the final top-1 and top-5 error rates on test_data

// Main execution flow

training_data, validation_data, test_data = load_datasets()

best_model = train_cnn_model(training_data, validation_data)

test_cnn_model(test_data, best_model)# Due to the complexity and size of the actual code that would emulate the research paper, I will provide an encapsulated version that includes the key components but is not a full copy of their exact model implementation.

# This code won't run here since it's incomplete and depends on a proper deep learning framework and data processing pipeline. It's meant to reflect the structure of the model discussed in the paper.

import torch

import torch.nn as nn

import torch.optim as optim

# Defining the class for the CNN model

class ImageNetCNN(nn.Module):

def __init__(self):

super(ImageNetCNN, self).__init__()

# Convolutional layers

self.conv1 = self.create_conv_layer(3, 64, kernel_size=11, stride=4, padding=2)

self.conv2 = self.create_conv_layer(64, 192, kernel_size=5, padding=2)

self.conv3 = self.create_conv_layer(192, 384, kernel_size=3, padding=1)

self.conv4 = self.create_conv_layer(384, 256, kernel_size=3, padding=1)

self.conv5 = self.create_conv_layer(256, 256, kernel_size=3, padding=1)

# Fully connected layers

self.fc1 = nn.Linear(256 * 6 * 6, 4096)

self.fc2 = nn.Linear(4096, 4096)

self.fc3 = nn.Linear(4096, 1000) # assuming 1000 classes for ImageNet

# Other layers and functions

self.relu = nn.ReLU(inplace=True)

self.maxpool = nn.MaxPool2d(kernel_size=3, stride=2)

self.dropout = nn.Dropout()

def create_conv_layer(self, in_channels, out_channels, **kwargs):

conv_layer = nn.Sequential(

nn.Conv2d(in_channels, out_channels, **kwargs),

nn.ReLU(inplace=True),

nn.MaxPool2d(kernel_size=3, stride=2),

nn.LocalResponseNorm(size=5, alpha=1e-4, beta=0.75, k=2)

)

return conv_layer

def forward(self, x):

# Forward pass through the convolutional layers

x = self.maxpool(self.relu(self.conv1(x)))

x = self.maxpool(self.relu(self.conv2(x)))

x = self.relu(self.conv3(x))

x = self.relu(self.conv4(x))

x = self.maxpool(self.relu(self.conv5(x)))

# Flatten the output for the fully connected layers

x = x.view(x.size(0), -1)

# Forward pass through the fully connected layers with dropout

x = self.dropout(self.relu(self.fc1(x)))

x = self.dropout(self.relu(self.fc2(x)))

x = self.fc3(x)

return x

# Loss function and Optimizer

criterion = nn.CrossEntropyLoss()

optimizer = optim.SGD(params=model.parameters(), lr=0.01, momentum=0.9, weight_decay=5e-4)

# Training loop (simplified)

for epoch in range(num_epochs):

# iterate over the training set

for inputs, labels in training_loader:

optimizer.zero_grad()

# Forward pass

outputs = model(inputs)

loss = criterion(outputs, labels)

# Backward pass and optimize

loss.backward()

optimizer.step()

# Validation loop (also simplified)

# ...

# Following steps would involve validation and testing to obtain top-1 and top-5 error rates