Qwen3-ASR: 다국어 음성 인식 모델 기능 및 라인업 총정리

개요

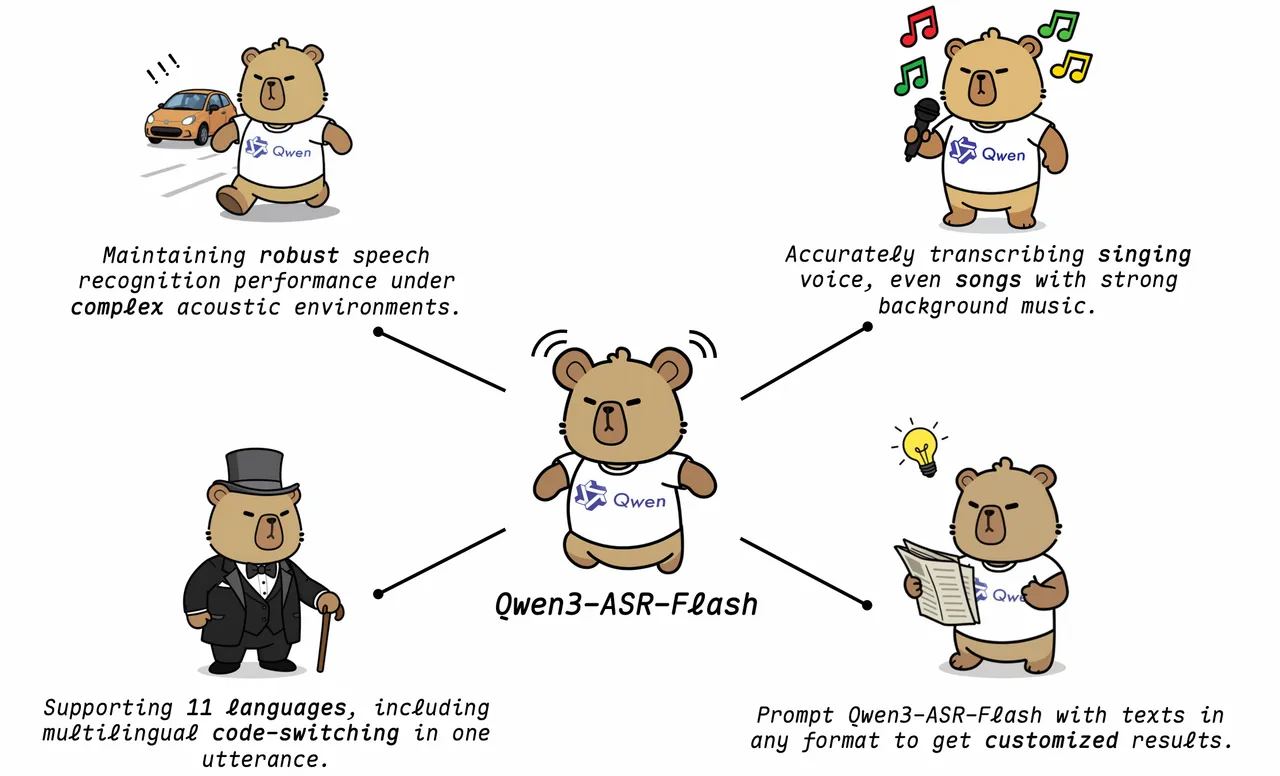

Qwen3-ASR은 Qwen3-Omni 기반의 음성 인식(ASR) 모델/서비스 라인으로, 다국어 인식, 스트리밍/오프라인 통합 추론, 복잡한 소음 환경 대응, 그리고 가창(노래) 음성 전사 같은 실제 서비스 지향 기능을 강조한다12. 2025년에는 API 형태의 Qwen3-ASR-Flash가 소개되었고1, 2026년에는 Qwen3-ASR-1.7B/0.6B 및 강제 정렬(Forced Alignment) 모델이 오픈소스로 공개되며 "모델 패밀리"로 확장되었다2.

제품/모델 라인업

2025년 공개된 Qwen3-ASR-Flash는 "단일 모델로 11개 언어" 지원, 다양한 악센트/방언 대응, 컨텍스트 기반 편향(문맥 주입) 기능을 특징으로 하는 ASR API 서비스로 소개됐다1. 또한 침묵/잡음 같은 비음성 구간을 거부하고, 언어 식별(LID)을 제공하는 점을 전면에 내세운다1.

2026년 오픈소스 발표에서는 Qwen3-ASR-1.7B(정확도 최우선)와 Qwen3-ASR-0.6B(정확도-효율 균형) 두 모델이 공개되었고, 여기에 비자기회귀(NAR) 방식의 타임스탬프 예측기 Qwen3-ForcedAligner-0.6B가 추가됐다2. 이 라인업은 "스트리밍 및 오프라인 통합", "언어 식별", "가창/배경음악 포함 노래 전사" 등을 핵심으로 한다2.

지원 언어와 방언 범위

Qwen3-ASR-Flash는 중국어(표준어 + 주요 방언)와 영어(지역 악센트 포함) 및 프랑스어, 독일어, 러시아어, 이탈리아어, 스페인어, 포르투갈어, 일본어, 한국어, 아랍어 등 총 11개 언어를 지원한다고 정리되어 있다1.

오픈소스 Qwen3-ASR 패밀리(1.7B/0.6B)는 52개 언어 및 악센트 지원을 표방하며, 중국 내 지역 방언(예: Anhui, Dongbei, Fujian 등)과 광동어(홍콩/광둥 악센트), 오어, 민난어 등 방언 커버리지를 별도로 강조한다2. (문서 내 표/서술에서 "30개 언어 + 22개 중국 방언"이라는 표현도 함께 등장하므로, 실제 제공 범위는 공개 체크포인트/설정에 따라 정리해 확인하는 편이 안전하다2.)

핵심 기능

Qwen3-ASR이 반복적으로 강조하는 기능은 "강인함(robustness)"과 "커스터마이즈 가능한 인식"이다. 소음이 섞인 환경에서도 인식 성능을 유지하고, 어려운 텍스트 패턴에서도 안정적으로 전사 결과를 만든다는 점이 기능 설명의 중심에 있다12.

특히 컨텍스트 기반 편향(Contextual Biasing)은 Qwen3-ASR-Flash의 차별점으로 소개된다. 사용자는 키워드 리스트뿐 아니라 "문단/문서 전체" 같은 장문의 배경 텍스트를 전처리 없이 그대로 제공해, 특정 용어·고유명사·도메인 표현이 더 잘 맞도록 유도할 수 있다1. 흥미로운 점은 무관하거나 다소 의미 없는 컨텍스트를 넣어도 일반 인식 성능이 크게 흔들리지 않는다고 설명한다1.

또 다른 특징은 가창/노래 전사다. 배경 음악(BGM)이 깔린 곡도 가사를 전사하는 능력을 명시적으로 내세우며, 오픈소스 발표에서는 중국어/영어 곡 기준 WER 수치도 제시한다12.

성능 및 효율 포지셔닝

Qwen3-ASR-Flash는 중국어/영어 및 기타 언어 벤치마크에서 경쟁 모델 대비 높은 정확도를 강조한다(도표로 비교 결과 제시)1. 오픈소스 Qwen3-ASR-1.7B는 오픈웨이트 ASR 중 SOTA급 성능을 주장하며, 일부 평가에서는 상용 API들과도 경쟁적이라는 포지셔닝을 취한다2.

효율 측면에서는 Qwen3-ASR-0.6B가 강하게 부각된다. 평균 TTFT(time-to-first-token) 92ms, 높은 동시성(예: concurrency 128)에서 대량 처리량 같은 서버 운영 지표를 제시하며, "정확도-효율 트레이드오프 최적" 모델로 설명한다2. 또한 단일 입력에서 최대 20분 길이 오디오 전사를 지원한다고 언급된다2.

배포/사용 방식

Qwen3-ASR은 크게 "상용 API로 호출"하는 흐름과 "오픈소스 모델을 직접 서빙"하는 흐름으로 나뉜다. Qwen3-ASR-Flash는 API 서비스로 제공되며, 긴 오디오 처리 시 API 길이 제한(예: 3분)을 우회하기 위해 VAD 기반 분할 및 병렬 호출을 수행하는 공식 툴킷이 별도로 제공된다3.

오픈소스 모델은 vLLM로도 배포할 수 있으며, 로컬에서 vllm serve Qwen/Qwen3-ASR-1.7B처럼 서버를 띄운 뒤 OpenAI 호환 API(채팅/전사 엔드포인트) 형태로 호출하는 예시가 문서로 제공된다4. 데모는 Hugging Face Spaces에서도 제공되어, 설치 없이 품질을 빠르게 확인할 수 있다5.

Qwen3-ASR-Toolkit(긴 오디오 전사 실무)

Qwen3-ASR-Toolkit은 Qwen-ASR API(문서 기준 "구 Qwen3-ASR-Flash")를 대상으로, 긴 오디오/비디오를 VAD로 자연스러운 무음 구간 중심으로 분할하고, 멀티스레딩으로 병렬 전사한 뒤, 결과를 합치는 CLI 중심 도구다3. 후처리로 반복/환각성 아티팩트를 제거하고, VAD 세그먼트 기반 SRT 자막 파일도 생성할 수 있어 "롱폼 미디어 전사 파이프라인"을 빠르게 구축하는 데 초점이 맞춰져 있다3.

실시간(스트리밍) 인식

Model Studio 문서에서는 라이브 스트리밍/온라인 회의 등에서 쓰는 실시간 음성 인식(Qwen3-ASR-Flash-Realtime)을 별도 모델로 안내한다. WebSocket 기반으로 오디오를 chunk 단위로 보내고, 중간 전사 결과 이벤트를 받는 예시를 제공하며, 컨텍스트(코퍼스) 주입으로 전문 용어 인식을 높일 수 있음을 강조한다6. 또한 배포 지역(싱가포르/베이징)에 따라 엔드포인트와 API 키가 분리되는 운영상의 차이를 명시한다6.

Forced Alignment(강제 정렬) 역할

Qwen3-ForcedAligner-0.6B는 "주어진 텍스트와 음성의 타임스탬프 정렬"을 위한 모델로, 다국어(11개 언어)에서 임의 단위의 구간 타임스탬프를 예측하는 NAR 기반 접근을 제시한다2. 이는 자막 싱크, 코퍼스 구축(음성-문장 정렬), 발화 단위 데이터 전처리 같은 워크플로에 유용한 구성요소로 볼 수 있다.

참고 이미지

이미지 출처: Qwen3 ASR: Hear clearly, transcribe smartly.

참고

1Qwen3 ASR: Hear clearly, transcribe smartly.

2Qwen3-ASR & Qwen3-ForcedAligner is Now Open Sourced: Robust, Streaming and Multilingual!

3GitHub - QwenLM/Qwen3-ASR-Toolkit

4Qwen3-ASR Usage Guide - vLLM Recipes

5Qwen3 ASR Demo - Hugging Face Space

6Alibaba Cloud Model Studio: Real-time speech recognition - Qwen

이 노트는 요약·비평·학습 목적으로 작성되었습니다. 저작권 문의가 있으시면 에서 알려주세요.