TranslateGemma 개요와 기술적 특징 정리

개요

TranslateGemma는 구글이 공개한 오픈 소스 기계번역(머신 트랜스레이션) 모델 제품군으로, Gemma 3 기반 언어 모델을 번역 작업에 특화해 미세 조정한 모델이다.13 4B, 12B, 27B 파라미터 크기로 제공되며, 최대 55개 언어 쌍에서 높은 품질의 번역을 제공하도록 설계되었다.1

이 모델은 대형 모델(Gemini)의 번역 능력을 더 작은 오픈 모델 안에 증류(distillation)해, 적은 자원으로도 높은 품질을 내는 것이 핵심 목표다.1 그 결과, 같은 크기의 기존 Gemma 3 번역 성능을 크게 능가하거나, 더 작은 모델이 더 큰 기존 모델과 비슷한 수준을 보이는 효율성을 보여준다.13

TranslateGemma란 무엇인가

TranslateGemma는 Gemma 3라는 범용 대규모 언어 모델을 기반으로, 번역 태스크에 최적화되도록 2단계 파인튜닝을 거쳐 만들어진 기계번역 특화 모델군이다.13 자연어 처리 전반을 다루는 일반 LLM과 달리, 번역 품질·정확도·문맥 자연스러움에 초점을 맞춘 점이 특징이다.

이 모델군은 영어-다른 언어, 주요 세계 언어 간 번역뿐 아니라, 저자원 언어(low‑resource language)까지 포함하는 광범위한 언어를 지원하도록 설계되었다.13 특히 연구자와 개발자가 자신의 데이터로 추가 미세 조정을 해서, 특정 언어 쌍이나 도메인(법률, 의료 등)에 특화된 번역 모델을 만드는 기반 모델로 활용하는 것을 중요한 목표로 삼고 있다.1

모델 크기와 배포 대상

TranslateGemma는 세 가지 크기의 모델로 제공되며, 각 크기는 목적과 배포 환경이 다르게 설계되어 있다.1

4B 모델: 약 40억 파라미터 규모로, 모바일 기기나 엣지(Edge) 환경 등 제한된 자원에서의 추론에 최적화되어 있다.1 12B 베이스라인과 비슷한 성능을 보인다고 보고되어, 경량 기기에서도 실용적인 번역 품질을 기대할 수 있다.1

12B 모델: 일반 소비자용 노트북에서도 구동 가능한 수준을 목표로 하며, 연구 및 개발 환경에서 고품질 번역을 제공하는 '주력' 크기 모델이다.1

27B 모델: 최대 품질(fidelity)을 지향하는 대형 모델로, 클라우드 환경에서 H100 GPU나 TPU 한 대로 구동이 가능하도록 설계되었다.1

이렇게 크기를 다양화함으로써, 모바일 앱부터 온디바이스 번역, 연구용 로컬 실행, 클라우드 서비스까지 폭넓은 배포 시나리오를 지원한다.1

학습 및 파인튜닝 방식

1단계: 감독 학습(Supervised Fine-Tuning, SFT)

첫 번째 단계는 감독 학습 기반 파인튜닝으로, 대규모 평행 말뭉치(parallel data)를 활용한다.13 이 평행 데이터는 사람 번역 문장과, 최신 Gemini 모델이 생성한 고품질 합성 번역 데이터를 혼합해 구성되었다.1

이 접근법은 두 가지 목적을 가진다. 하나는 검증된 인간 번역을 통해 기본적인 정확성과 자연스러움을 확보하는 것이고, 다른 하나는 대형 모델(Gemini)의 지식을 합성 데이터 형태로 작은 모델에 '증류(distill)'해, 저자원 언어나 희귀 표현에 대한 커버리지를 넓히는 것이다.13

2단계: 강화학습(Reinforcement Learning, RL)

두 번째 단계에서는 번역 품질을 추가로 끌어올리기 위해 강화학습을 적용한다.13 이 단계에서 TranslateGemma는 여러 개의 보상 모델(reward model) 앙상블을 사용하며, MetricX‑QE, AutoMQM 같은 첨단 자동 평가 지표를 활용해 보상을 설계한다.13

강화학습의 목적은 단순히 문자 단위의 정확성을 맞추는 것을 넘어서, 문맥에 더 잘 맞고 자연스럽게 읽히는 번역을 생성하도록 모델을 유도하는 것이다.13 이 과정에서, 문장 흐름, 의미 보존, 스타일 등을 종합적으로 고려해 보상을 주는 방식이 사용된다.

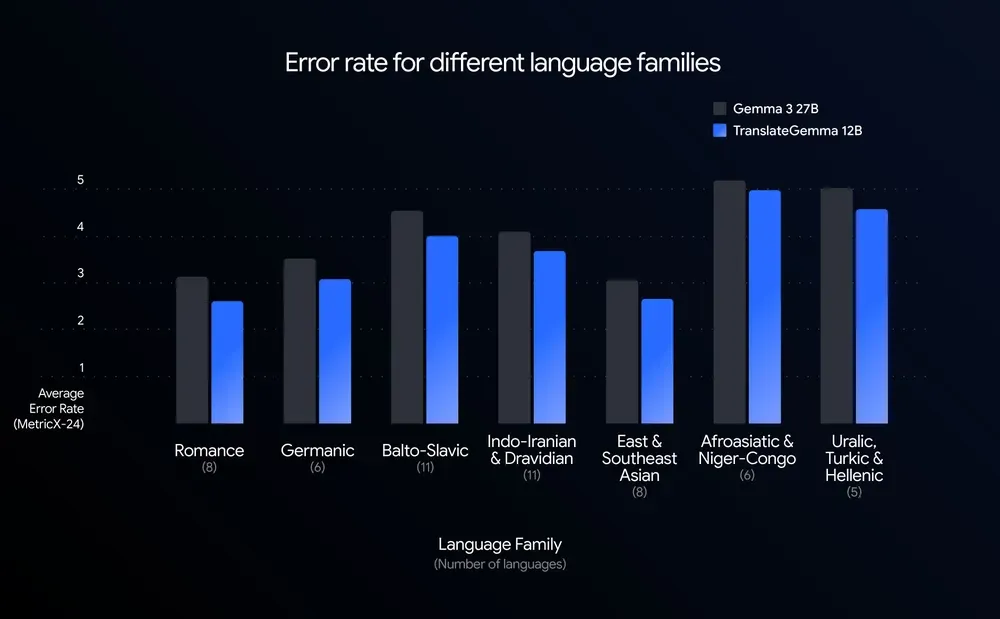

성능과 효율성

TranslateGemma는 WMT24++ 벤치마크(55개 언어, 다양한 언어 계열 포함)를 기준으로 평가되었으며, 모든 언어에서 기존 Gemma 3 기반 번역 모델보다 오류율을 눈에 띄게 줄였다.1 특히 고자원·중자원·저자원 언어를 모두 포함해, 전반적인 품질 향상을 보이는 것이 보고되었다.13

성능 측면에서 가장 두드러지는 특징은 모델 크기 대비 효율이다. 12B TranslateGemma는 MetricX 기준 WMT24++에서 27B Gemma 3 베이스라인을 능가하는 성능을 보였고, 4B TranslateGemma 또한 12B 베이스라인에 필적하는 성능을 기록했다.1 이는 파라미터 수가 절반 이하임에도 동일 혹은 더 좋은 번역 품질을 달성한다는 의미로, 처리량(throughput)과 지연시간(latency) 면에서 큰 이점을 제공한다.13

이러한 효율성 덕분에, 개발자는 더 적은 연산 자원으로도 고품질 번역을 구현할 수 있고, 특히 온디바이스·엣지 환경에서 실시간 번역 애플리케이션을 만드는 데 유리하다.1

언어 커버리지와 확장성

TranslateGemma는 우선 55개 언어 쌍을 대상으로 엄격하게 학습·평가되어, 이 언어들에 대해서는 신뢰할 수 있는 번역 품질이 보고되어 있다.13 여기에는 스페인어, 프랑스어, 중국어, 힌디어 등 주요 세계 언어뿐 아니라, 저자원 언어들도 다수 포함된다.1

또한 이 핵심 세트 외에도 약 500개에 달하는 추가 언어 쌍에 대해 학습을 시도하여, 훨씬 넓은 언어 범위를 포괄할 수 있도록 설계되었다.13 다만 이 확장된 언어 쌍에 대해서는 아직 공식 평가 지표가 모두 정리되지는 않았으며, 관련 목록과 정보는 기술 보고서에 공개해 커뮤니티가 추가 연구와 실험을 진행할 수 있도록 했다.13

이러한 설계는 TranslateGemma를 "기반 모델(foundation)"로 활용해, 특정 언어권·지역·전문 도메인에 특화된 번역 시스템을 만들기 싶은 연구자·기업에게 좋은 출발점이 되도록 의도된 것이다.1

멀티모달(이미지 번역) 능력

TranslateGemma는 텍스트 번역뿐 아니라 멀티모달 능력, 특히 이미지 안의 텍스트 번역에도 강점을 보인다.13 Vistra 이미지 번역 벤치마크에서의 테스트 결과, 텍스트 번역 품질이 향상되면서 이미지 내 텍스트 번역 성능도 함께 개선되는 것으로 나타났다.13

흥미로운 점은, TranslateGemma를 학습할 때 별도의 멀티모달 전용 파인튜닝 없이도 이런 성능 향상이 이루어졌다는 점이다.1 이는 기본이 되는 Gemma 3가 가진 멀티모달 능력이 번역 특화 학습 이후에도 유지·강화되었음을 시사한다.3 따라서, 사진 속 간판·문서·UI 텍스트 등을 자동으로 번역하는 응용 분야에서 유용하게 활용될 수 있다.

활용 방법과 배포 채널

TranslateGemma는 연구자와 개발자가 쉽게 활용할 수 있도록 여러 채널을 통해 제공된다.13

기술 보고서(arXiv): 모델 구조, 학습 데이터 구성, 평가 방법 및 결과를 포함한 상세 기술 자료를 통해 TranslateGemma의 과학적 배경을 이해할 수 있다.3

Kaggle 모델 허브: 미리 학습된 모델 가중치를 다운로드해 로컬 또는 자체 인프라에서 직접 추론·파인튜닝에 사용할 수 있다.1

Hugging Face 컬렉션: Hugging Face 상에서 손쉽게 모델을 불러와 Python 코드나 노트북 환경에서 사용할 수 있도록 제공된다.1

Gemma Cookbook(Colab 노트북): Colab 기반 예제 노트북을 통해 TranslateGemma를 실습해볼 수 있는 코드와 활용 예시가 제공된다.1

Vertex AI Model Garden: Google Cloud Vertex AI에서 TranslateGemma를 선택해, 클라우드 상에서 손쉽게 배포·추론·파이프라인 통합을 할 수 있다.12

이러한 채널을 통해 온프레미스 환경, 퍼블릭 클라우드, 연구용 노트북, 모바일·엣지까지 다양한 환경에서 TranslateGemma를 사용할 수 있다.1

의의와 한계, 향후 전망

TranslateGemma의 가장 큰 의의는, 고성능 번역 모델을 오픈 형태로 제공하면서도 자원 효율성과 광범위한 언어 커버리지를 동시에 추구했다는 점이다.13 이를 통해 상용 클라우드 API에만 의존하지 않고도, 각 조직이 자체적으로 번역 시스템을 구축·통제할 수 있는 선택지를 넓혀준다.

또한 저자원 언어와 멀티모달 번역에 대한 성능 개선은, 디지털 소외 언어권 사용자들에게 더 나은 접근성을 제공할 가능성을 보여준다.13 다만 약 500개 추가 언어 쌍에 대해서는 아직 정량적 평가가 충분히 이루어지지 않았기 때문에, 실제 품질 검증과 언어별 편향·오류 분석 등은 연구 커뮤니티의 후속 작업이 필요하다.13

향후에는 더 많은 언어와 도메인에서의 인적 평가, 안전성·편향성 분석, 도메인 특화 파인튜닝 방법론 등이 함께 발전하면서, TranslateGemma를 기반으로 한 다양한 번역·로컬라이제이션·접근성 도구가 등장할 것으로 예상된다.3

참고

이 노트는 요약·비평·학습 목적으로 작성되었습니다. 저작권 문의가 있으시면 에서 알려주세요.