NVIDIA Vera Rubin NVL144 CPX 플랫폼과 Rubin CPX GPU 완벽 정리

개요

NVIDIA Rubin CPX GPU와 Vera Rubin NVL144 CPX 플랫폼은 "백만 토큰 문맥" 같은 초장문 맥락을 처리하기 위해 설계된 차세대 AI 인프라다.1 코드 어시스턴트가 대형 코드베이스 전체를 이해하고, 1시간 분량의 고해상도 영상을 맥락으로 삼아 생성·검색하는 작업을 실제 서비스 규모에서 돌리기 위한 하드웨어라는 점이 핵심이다.12

Rubin CPX는 대규모 문맥을 해석하는 '컨텍스트 단계'에 최적화된 전용 GPU이며, Vera Rubin NVL144 CPX 플랫폼은 이 Rubin CPX, 일반 Rubin GPU, Vera CPU를 한 랙(rack)에 통합해 8엑사플롭스(8 exaFLOPS) AI 성능과 100TB 메모리를 제공한다.12 이를 통해 기존 GB300 NVL72 대비 최대 7.5배의 AI 성능과 3배 향상된 attention 속도를 제공하며, 같은 투자로 훨씬 많은 "토큰"을 처리해 수익을 극대화하는 것을 목표로 한다.12

GB300 NVL72 개요: Rubin CPX 이전 세대 기준 플랫폼

GB300 NVL72는 NVIDIA Blackwell Ultra 아키텍처 기반의 랙 스케일 AI 시스템으로, 72개의 Blackwell Ultra GPU와 36개의 Grace CPU를 하나의 완전 수냉 랙에 통합한 플랫폼이다.56 한 랙이 사실상 "단일 거대 GPU"처럼 동작하도록 설계되어, 대규모 LLM 추론·테스트타임 스케일링(test-time scaling)·AI reasoning 워크로드를 고밀도로 처리하는 것이 핵심 목표다.56

이 시스템은 Blackwell 대비 1.5배 높은 FP4(또는 NVFP4 계열) 연산 성능과 2배 빠른 attention 가속을 제공하며, Hopper 세대와 비교하면 사용자당 TPS, 전력당 TPS를 크게 끌어올려 최대 50배 수준의 AI 팩토리 출력 향상을 제공하는 것으로 제시된다.5 고용량 HBM3E 메모리(전체 20TB, 최대 576TB/s 대역폭)와 최대 37TB의 고속 메모리 풀, 130TB/s NVLink 대역폭을 통해 대형 모델·긴 컨텍스트를 하나의 NVL72 도메인 안에서 처리하는 구조다.5

네트워킹 측면에서는 GPU당 800Gb/s급 대역폭을 제공하는 ConnectX‑8 SuperNIC와 Quantum‑X800 InfiniBand 또는 Spectrum‑X Ethernet을 사용해, 여러 GB300 NVL72 랙을 엮어 'AI 팩토리'로 확장할 수 있도록 설계되었다.57 Rubin CPX·Vera Rubin NVL144 CPX는 바로 이 GB300 NVL72를 기준선으로 삼아, 같은 투자 대비 최대 7.5배 AI 성능·3배 attention 속도 향상을 목표로 하는 차세대 massive‑context 특화 플랫폼이라고 볼 수 있다.7

Rubin CPX GPU: massive-context 전용 가속기

Rubin CPX는 "massive-context processing", 즉 수백만 토큰 수준의 긴 입력을 처리하도록 특별히 설계된 새로운 클래스의 CUDA GPU다.1 일반적인 LLM 추론에서 컨텍스트(프롬프트) 길이가 길어질수록 attention 연산량이 폭발적으로 증가하는데, Rubin CPX는 이 부분을 집중적으로 가속해 긴 문맥에서도 속도를 유지하도록 만든 것이다.12 이 GPU는 NVIDIA Rubin 아키텍처를 기반으로 하며, 비용 효율적인 모놀리식 다이(monolithic die) 설계를 채택해 하나의 큰 칩 안에 연산 코어와 메모리 인터페이스, 비디오 인코더·디코더 기능을 집약했다.1 모놀리식 다이는 여러 칩렛을 묶는 방식보다 설계 난이도와 수율 문제는 어려울 수 있지만, 대역폭·지연 시간 측면에서 유리해 긴 문맥 처리에 중요한 데이터 이동 비용을 줄이는 데 도움이 된다.1 Rubin CPX의 핵심 특징은 NVFP4라는 저정밀 데이터 타입을 활용해 30 PFLOPS(페타플롭스)의 연산 성능을 내는 점이다.12 NVFP4는 추론용으로 특화된 4비트 정밀도 포맷으로, 적절한 양자화·스케일링 기법과 함께 사용하면 LLM 추론에서 정확도를 크게 잃지 않으면서 연산량과 전력 사용을 대폭 줄일 수 있다.12 메모리는 128GB의 GDDR7를 탑재해 HBM(고대역폭 메모리) 대신 보다 저렴하고 용량 확보가 쉬운 DRAM 기반으로 대규모 문맥을 처리할 수 있도록 설계되었다.13 컨텍스트 단계는 주로 계산 집약적이고, NVLink를 통한 GPU 간 초고속 통신보다는 개별 GPU 내부의 처리량이 중요하기 때문에, HBM 대신 GDDR7를 사용해 비용 대비 성능(ROI)을 최적화한 구성이라고 볼 수 있다.23 또한 Rubin CPX는 기존 NVIDIA GB300 NVL72 시스템 대비 attention 연산을 최대 3배 빠르게 처리하도록 설계되었다.12 attention은 긴 문맥에서 가장 큰 병목을 만드는 연산이므로, 이 부분의 전용 가속은 긴 입력을 다루는 모든 LLM·멀티모달 모델의 체감 속도 향상으로 이어진다.12

Vera Rubin NVL144 CPX 플랫폼 구성

Vera Rubin NVL144 CPX 플랫폼은 Rubin CPX GPU, Rubin GPU, Vera CPU를 하나의 MGX 기반 시스템 랙에 통합한 형태로, 긴 문맥 LLM 추론을 "컨텍스트 단계"와 "생성 단계"로 분리해 각각에 최적화된 하드웨어를 배치하는 'disaggregated inference' 철학을 구현한 대표 사례다.124 이 랙에는 144개의 Rubin CPX GPU와 144개의 Rubin GPU, 그리고 36개의 Vera CPU가 탑재된다.2 Rubin CPX는 긴 입력을 읽어들이고, key-value 캐시를 생성하는 컨텍스트 처리에 집중하고, Rubin GPU는 NVLink를 통해 서로 연결된 상태에서 토큰을 하나씩 생성하는 생성 단계에 특화된 역할을 맡는다.24 각 랙은 MGX 설계 기반의 컴퓨트 트레이(블레이드) 여러 개로 구성되며, 한 트레이에는 2개의 Vera CPU, 4개의 Rubin GPU, 8개의 Rubin CPX GPU가 들어간다.23 이렇게 하면 한 트레이에서만 12개의 GPU가 컨텍스트·생성 작업을 협업 수행할 수 있고, 랙 전체로 확장할 경우 144개의 Rubin CPX와 144개의 Rubin GPU가 함께 동작하는 대규모 추론 팩토리를 구성할 수 있다.23 Rubin CPX 전용 컴퓨트 트레이도 별도 옵션으로 제공되어, 기존 Vera Rubin NVL144 랙을 쓰고 있는 고객이 전체 랙을 새로 바꾸지 않고도 Rubin CPX를 추가해 긴 문맥 처리 성능을 개선할 수 있도록 했다.1 이는 이미 Vera Rubin 기반 인프라를 구축해 둔 대규모 클라우드·엔터프라이즈 고객에게 업그레이드 경로를 제공하는 전략적 구성이다.1

성능 지표: 8엑사플롭스, 100TB 메모리, 1.7PB/s 대역폭

Vera Rubin NVL144 CPX 랙 하나는 NVFP4 기준 최대 8 엑사플롭스(8,000 PFLOPS)의 AI 연산 성능을 제공한다.12 이는 동일 세대의 일반 Vera Rubin NVL72 랙 구성과 비교해도 매우 공격적인 수치이며, 특히 긴 문맥 추론에 초점을 맞추고 있다는 점에서 특징적이다.1 메모리 측면에서는 랙당 100TB의 고속 메모리를 제공하고, 전체 메모리 대역폭은 1.7PB/s(페타바이트/초)에 달한다.12 Rubin CPX가 GDDR7 128GB를 사용하고, Rubin GPU가 HBM4 기반 초고속 메모리를 사용하는 구조를 복합적으로 활용해, 컨텍스트 단계에서는 대용량 문맥을 수용하면서, 생성 단계에서는 토큰당 지연 시간을 최소화하는 방식으로 전체 시스템이 설계되었다.23 개별 Rubin CPX GPU는 NVFP4 기준 30 PFLOPS의 추론 성능을 제공하며, 128GB의 GDDR7 메모리를 통해 백만 토큰급 컨텍스트를 처리할 수 있는 용량을 확보한다.123 이와 함께 Rubin GPU는 HBM4 메모리와 고속 NVLink 인터커넥트를 통해 생성 단계에서 높은 토큰 처리량을 유지한다.3 이 전체 시스템은 긴 문맥을 빠르게 읽어들이고, 생성 단계에서 병목 없이 토큰을 뽑아내도록 설계되어, 개발자 경험 측면에서는 "긴 프롬프트를 넣어도 거의 실시간에 가까운 응답"을 목표로 하고 있다.12

GB300 NVL72 대비 성능 향상

Vera Rubin NVL144 CPX는 이전 세대인 Blackwell 기반 GB300 NVL72 시스템 대비 AI 성능이 최대 7.5배 향상된 것으로 제시된다.12 이는 단순히 GPU 성능 향상뿐 아니라, 컨텍스트와 생성을 분리한 구조, Rubin CPX의 도입, 그리고 전체 스택 최적화가 합쳐진 결과다.12 특히 attention 연산 속도는 GB300 NVL72 대비 최대 3배 빠르게 향상되었다.12 긴 문맥 LLM에서 attention은 O(n²)로 늘어나는 핵심 병목이기 때문에, 이 부분의 3배 가속은 전체 지연 시간 감소와 처리 가능한 컨텍스트 길이 확장에 직접적인 영향을 미친다.12 또한 Rubin GPU 자체도 HBM4 메모리 대역폭이 GB300 대비 약 2.8배 증가하고, NVLink 대역폭 역시 2배로 늘어나는 등, 생성 단계에서의 모델 토큰 처리량도 크게 향상되어 있다.3 다만 Vera Rubin NVL72와 Rubin CPX 기반 NVL144 CPX는 설계 목적이 조금 다르므로, 순수 성능 비교뿐 아니라 "긴 문맥 용도에 얼마나 최적화되어 있는지"가 핵심 차별점이다.24

주요 활용 분야: 100만 토큰 문맥, 대규모 코드, 장시간 비디오

Rubin CPX와 Vera Rubin NVL144 CPX가 겨냥하는 대표적인 워크로드는 크게 세 가지로 나뉜다: 대규모 코드베이스를 다루는 코딩 어시스턴트, 100만 토큰급 긴 문맥 LLM, 그리고 장시간·고품질 비디오 생성 및 검색이다.12 소프트웨어 개발에서는 AI 시스템이 전체 코드 저장소, 수년치 이슈·커밋 히스토리, 문서, 의존 라이브러리까지 한 번에 문맥으로 읽어들여, 단순 코드 자동완성을 넘어 "프로젝트 수준에서 설계·리팩터링·버그 추적"까지 돕는 형태로 진화하고 있다.12 Rubin CPX는 이러한 대규모 문맥 분석을 고속으로 처리해, 개발자가 기다리는 시간을 줄이고, 더 자주·깊게 AI에게 코드를 맡길 수 있도록 설계되었다.1 비디오 영역에서는 1시간 분량의 영상 하나를 처리하는 데만 최대 100만 토큰 수준의 입력이 필요할 수 있다.1 Rubin CPX는 비디오 디코더·인코더와 긴 문맥 추론 가속을 하나의 칩에 통합하여, 장시간 영상의 검색(예: "이 영상에서 특정 인물이 이 행동을 하는 구간 찾기"), 장면 기반 편집, 고품질 비디오 생성 같은 작업을 더 현실적인 시간 안에 수행할 수 있게 한다.12 연구·지식 작업에서도 수많은 문서·논문·데이터를 한 번에 문맥으로 넣어 "긴 맥락을 유지한 채 깊이 있는 질의응답"을 하는 에이전트형 AI가 점점 중요해지고 있으며, Rubin CPX는 이러한 에이전트가 수십만·수백만 토큰 단위의 정보를 다루는 기반 인프라 역할을 하도록 설계되었다.2

비즈니스 관점: 투자 대비 토큰 수익성과 파트너 사례

NVIDIA는 Vera Rubin NVL144 CPX가 제공하는 경제성을 매우 강조한다. 대규모 배포 시 이 플랫폼은 30~50배 수준의 투자 수익률(ROI)을 제공할 수 있으며, 자본 지출(CAPEX) 1억 달러당 최대 50억 달러 규모의 토큰 기반 수익을 창출할 수 있다는 전망을 제시한다.2 이는 동일 투자로 더 많은 요청을 처리하고, 더 긴 문맥을 지원해 프리미엄 요금을 받을 수 있다는 계산에 기반한다.12 이 플랫폼을 활용하려는 대표적인 AI 기업으로는 Cursor, Runway, Magic이 소개된다.1 Cursor는 개발자용 AI 코드 에디터를 제공하는 회사로, Rubin CPX를 통해 "번개 같은 코드 생성 속도"와 더 깊은 코드 이해를 제공해 개발자 생산성을 극대화하는 것을 목표로 한다.1 이는 앞서 언급한 대규모 코드베이스 문맥 처리 능력에 직접적으로 기대를 거는 사례다.1 Runway는 생성형 비디오 도구를 제공하는 기업으로, Rubin CPX와 Vera Rubin 플랫폼을 활용해 더 긴 영상, 더 사실적인 효과, 더 유연한 "에이전트 기반 창작 워크플로"를 지원하려 한다.1 긴 문맥 비디오 생성·편집이 핵심이므로 Rubin CPX의 비디오·long-context 통합 설계의 대표적인 수혜자라고 볼 수 있다.1 Magic은 1억 토큰에 달하는 컨텍스트 윈도우를 지원하는 모델을 개발해, 하나의 에이전트가 코드베이스 전체, 상호작용 이력, 문서와 라이브러리를 한 번에 인지하도록 하는 것을 목표로 한다.1 이들은 Rubin CPX가 이러한 초대형 컨텍스트 윈도우 모델의 추론 비용을 줄이고 속도를 높이는 데 중요한 역할을 할 것으로 보고 있다.1

네트워킹 및 확장: Quantum‑X800, Spectrum‑X, ConnectX‑9

Vera Rubin NVL144 CPX 플랫폼은 단일 랙을 넘어 대규모 클러스터로 확장될 수 있도록, NVIDIA의 최신 네트워킹 솔루션과 긴밀하게 통합되도록 설계되었다.12 핵심은 InfiniBand 기반의 Quantum‑X800와 Ethernet 기반의 Spectrum‑X / Spectrum‑XGS, 그리고 ConnectX‑9 SuperNIC이다.12 Quantum‑X800 InfiniBand는 초저지연·초고대역폭의 HPC·AI 전용 네트워크 패브릭으로, 여러 NVL144 CPX 랙을 묶어 하나의 거대 "AI 팩토리"를 만들 때 활용된다.12 InfiniBand는 특히 분산 파이프라인·텐서 패럴렐 같은 정교한 분산 추론·학습에서 중요한 역할을 한다.2 Spectrum‑X 및 Spectrum‑XGS Ethernet는 AI 워크로드에 최적화된 Ethernet 솔루션으로, 일반 데이터센터 네트워크 인프라와의 호환성을 유지하면서도, LLM·멀티모달 추론에 필요한 고대역폭·QoS·혼잡 제어 기능을 제공한다.12 이를 통해 기존 Ethernet 중심 데이터센터를 운영하는 기업도 Rubin CPX 기반 인프라를 도입하기 쉬워진다.1 ConnectX‑9 SuperNICs는 이러한 패브릭과 서버를 연결하는 고성능 네트워크 인터페이스로, CUDA‑X와 같이 최적화된 소프트웨어 스택, 그리고 Dynamo 같은 오케스트레이션 레이어와 함께 동작해, 컨텍스트·생성 단계 간 KV 캐시 전송, LLM-aware 라우팅, 메모리 관리 등을 효율적으로 수행하도록 돕는다.2 결국 Rubin CPX와 Vera Rubin NVL144 CPX는 GPU만의 문제가 아니라, 네트워크와 소프트웨어까지 포함한 "풀스택 설계"의 결과물이다.12

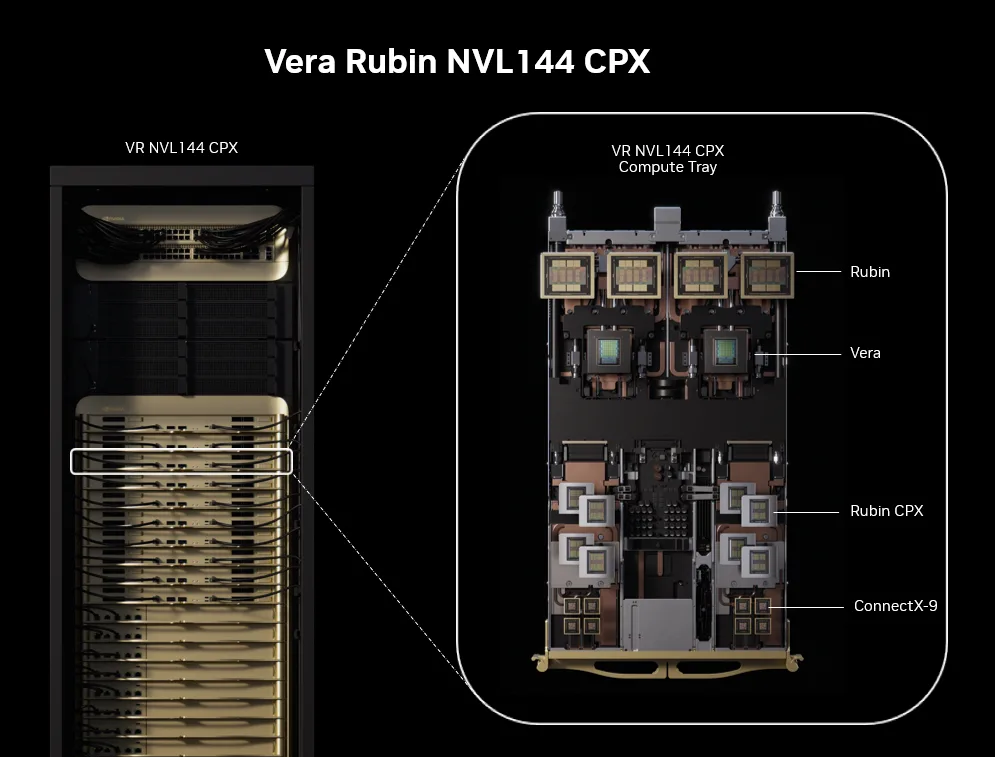

아키텍처를 한눈에 보기

아래 그림은 Vera Rubin NVL144 CPX 랙과, 그 안에 들어가는 하나의 컴퓨트 트레이 구성을 동시에 보여준다.2 왼쪽에는 전체 랙에 144 Rubin CPX, 144 Rubin GPU, 36 Vera CPU가 탑재된 모습이, 오른쪽에는 2 Vera CPU, 4 Rubin GPU, 8 Rubin CPX가 들어간 단일 트레이 구성이 나타나 있다.2 이를 통해 Rubin CPX가 독립된 별도 가속기가 아니라, Vera CPU·Rubin GPU와 함께 긴 문맥 추론 파이프라인을 나눠 맡는 "컨텍스트 전용 GPU"라는 점을 직관적으로 이해할 수 있다.2

정리 및 시사점

Rubin CPX GPU와 Vera Rubin NVL144 CPX 플랫폼은 "모든 것을 한 번에 다 이해하는" 초장문 맥락 AI를 현실적인 비용과 지연 시간 안에서 제공하기 위해 설계된, 첫 세대의 본격적인 massive-context 인프라라고 볼 수 있다.12 컨텍스트와 생성 단계의 분리, NVFP4 기반 저정밀 최적화, GDDR7·HBM4의 적절한 역할 분담, 그리고 InfiniBand·Ethernet·SuperNIC까지 포함한 전체 스택 설계가 결합된 점이 특징이다.124 비즈니스 관점에서는 "1억 달러 투자당 50억 달러 토큰 수익"이라는 공격적인 ROI를 내세우며, 코딩 어시스턴트, 생성형 비디오, 에이전트형 소프트웨어 개발 도구 등 수익성이 높은 서비스 영역을 노리는 기업에게 강력한 인프라 옵션이 된다.12 기술적으로는 긴 문맥 처리와 비디오·코딩·에이전트 워크로드가 앞으로의 핵심이라는 NVIDIA의 전략 방향을 보여주는 사례로, 차세대 AI 서비스 기획 시 Rubin CPX가 어떤 워크로드에 강점이 있는지 이해해 두면 인프라·비즈니스 양쪽에서 도움이 될 것이다.124

1NVIDIA Unveils Rubin CPX: A New Class of GPU Designed for Massive-Context Inference [^2]: NVIDIA Rubin CPX Accelerates Inference Performance and Efficiency for 1M+ Token Context Workloads [^3]: Every conference is an AI conference as Nvidia unpacks its Vera Rubin CPUs and GPUs at CES [^4]: Nvidia Rubin CPX forms one half of new, "disaggregated" AI inference architecture -- approach splits work between compute- and bandwidth-optimized chips for best performance

참고

5Designed for AI Reasoning Performance & Efficiency | NVIDIA GB300 NVL72

6NVIDIA Blackwell Ultra AI Factory Platform Paves Way for Age of AI Reasoning

7NVIDIA Unveils Rubin CPX: A New Class of GPU Designed for Massive-Context Inference