TurboDiffusion과 실시간 비디오 디퓨전 모델의 활용과 영향

개요

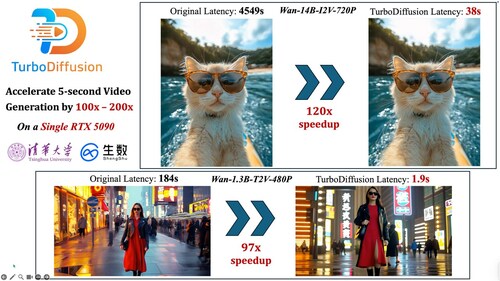

TurboDiffusion은 기존 비디오 디퓨전 모델의 추론 속도를 100~200배까지 줄이면서도 시각적 품질을 거의 유지하는 것을 목표로 하는 가속 프레임워크다.12 연구진은 Wan2.x 계열의 대형 비디오 생성 모델을 대상으로, 단일 RTX 5090 GPU에서 수천 초 걸리던 5~8초짜리 고해상도 비디오 생성을 수십 초, 경우에 따라 수 초대로 단축했다.13 이 수준이면 더 이상 "오프라인 렌더링"이 아니라, 사용자 인터랙션에 반응하며 비디오를 만들어줄 수 있는, 실시간 혹은 준실시간 영역에 진입하게 된다.23

RTX 5090은 32GB 정도의 VRAM 구성

이러한 성능 향상은 단순한 하드웨어 업그레이드의 결과가 아니라, 저비트 양자화, 희소 어텐션, 스텝 증류, 커스텀 CUDA/Triton 커널을 결합한 시스템·알고리즘 공진화의 결과다.134 그 결과, 과거에는 대규모 GPU 팜이 필요하다고 여겨졌던 고품질 비디오 생성이, 이제는 단일 워크스테이션급 GPU를 활용한 서비스 수준으로 내려오고 있다.24 이는 향후 UI, 운영체제, 게임 엔진, 크리에이티브 도구 전반에서 "비디오를 실시간으로 합성하는" 방식의 인터페이스가 일상화될 수 있음을 의미한다.

TurboDiffusion 기술 개요

TurboDiffusion의 핵심 목표는 "기존 비디오 디퓨전 모델을 거의 손상 없이 100~200배 빠르게 만든다"는 것이다.123 이를 위해 사용된 네 가지 축은 저비트 어텐션(SageAttention), 희소-선형 어텐션(Sparse-Linear Attention, SLA), 스텝 증류(rCM), 그리고 8비트 양자화(W8A8)다.1234

먼저 어텐션 계산을 위해 SageAttention이라는 저비트 어텐션 커널을 사용한다. 이는 쿼리·키·밸류를 8비트 정수로 블록 단위 양자화해 텐서코어에서 효율적으로 곱셈·덧셈을 수행하도록 설계된 방식으로, 기존 FP16 기반 어텐션보다 여러 배 빠른 연산을 제공하면서도 수치 오차를 최소화한다.134 여기에 SLA를 결합해, 각 위치에서 상위 Top-K 키만 선택해 연산하는 구조적 희소성을 도입함으로써, 어텐션의 FLOPs와 메모리를 이론적으로 α(예: 0.1) 배 수준으로 줄인다.13 실제 구현에서는 SageAttention 위에 SLA를 얹어 17~20배 수준의 추가 어텐션 가속을 달성했다고 보고된다.24

두 번째 축은 스텝 증류다. 일반적인 확산 비디오 모델은 100단계 내외의 샘플링 스텝을 거쳐서 노이즈를 점진적으로 제거하지만, TurboDiffusion에서는 rCM이라는 최신 증류 기법을 사용해, 같은 품질을 훨씬 적은 스텝(연구 논문 기준 33~44스텝, PR 자료에서는 3~4스텝까지 언급)으로 달성하도록 학생 모델을 학습시킨다.1234 이 과정은 연속시간 일관성(continuous-time consistency)을 활용해, 전체 노이즈 스케줄에 걸쳐 교사 모델과 학생 모델의 점수 함수를 맞추는 식으로 진행된다.3

마지막으로, 선형 레이어 전체를 대상으로 가중치(W)와 활성값(A)을 모두 INT8로 표현하는 W8A8 양자화를 적용해, 모델 메모리를 절반 수준으로 줄이고 선형 연산을 1.5~2배가량 추가로 가속한다.13 이 외에도 LayerNorm, RMSNorm 등 자주 호출되는 연산을 Triton·CUDA로 재구현한 커널, VAE 인코딩/디코딩 시의 데이터 전송 최적화 등이 결합되어 전체 파이프라인의 병목을 줄였다.13

이러한 요소를 모두 합치면, Wan2.1-T2V-14B-720P 같은 대형 모델 기준으로 추론 지연 시간이 약 4767초에서 24초 수준으로 줄어들며, 이론상 약 200배에 달하는 속도 향상을 보여준다.13 INT8 양자화 덕분에 모델 메모리도 약 28GB(FP16)에서 14GB(INT8) 정도로 줄어들어, 단일 고급 GPU에 올려 동작시키기 훨씬 수월해진다.3

단일 GPU 기반 실시간 비디오 생성의 등장

TurboDiffusion이 주는 가장 즉각적인 변화는 "단일 워크스테이션 GPU에서도 고품질 비디오를 실시간에 가깝게 생성할 수 있게 되었다"는 점이다.1234 Wan2.1-T2V-1.3B-480P 모델에서 5초짜리 비디오를 생성하는 데 걸리는 시간이 184초에서 1.9초로 줄어들었다는 실험 결과가 대표적이다.13 Wan2.2-I2V-A14B-720P처럼 훨씬 더 크고 해상도가 높은 모델에서도 4549초가 38초로 줄어드는 등, 모든 구성에서 100배 안팎의 속도 향상이 보고되고 있다.13

기업 보도자료에서는 상용 Vidu 모델 기준으로 1080p, 8초짜리 고품질 비디오 한 편이 900초에서 약 8초로 단축되었다고 언급한다.2 이 정도면 사용자가 프롬프트를 입력한 뒤 몇 분을 기다리는 "렌더 작업"이 아니라, 버튼을 누르고 잠깐 숨 고르는 사이에 결과를 확인하고, 마음에 안 들면 바로 다시 수정하고 재생성하는 상호작용적인 경험이 가능해진다.

과거에는 이 정도 수준의 비디오 생성을 서비스로 제공하려면 여러 장의 GPU가 붙은 서버를 묶어 배치 처리하거나, 클라우드 상에서 대규모 GPU 클러스터를 운영해야 했다. 이제는 고급이지만 소비자용 범주에 속하는 RTX 5090 한 장만으로도 준실시간 텍스트-투-비디오 서비스나 이미지-투-비디오 편집 서비스를 운영하는 것이 현실적인 옵션으로 떠오르기 시작했다.124 중국 매체 보도에서도 TurboDiffusion이 이러한 속도 향상을 통해 "실시간 생성 시대"의 문을 열었다고 평가하고 있다.4

전통적인 렌더링/그래픽스와 디퓨전 비디오 생성의 메커니즘 차이

전통적인 컴퓨터 그래픽스 파이프라인은 장면(scene)을 사람이 명시적으로 구성하는 방식에 기반한다. 아티스트와 개발자가 3D 모델, 메시, 머티리얼, 라이트, 카메라 위치, 애니메이션 곡선 등을 모든 프레임에 대해 정의하고, 렌더러는 광선 추적(ray tracing)이나 래스터라이제이션을 통해 각 픽셀의 색상을 물리 법칙에 따라 계산한다. 이 과정에서 수많은 수작업과 규칙 기반 최적화, 쉐이더 레벨의 "해킹"이 총동원되며, 특히 영화·광고와 같이 품질이 중요한 작업에서는 렌더 팜을 구성해 프레임당 수 분~수십 분을 계산하는 것이 일반적이다.

반면 비디오 디퓨전 모델은 "장면을 구성하고 조명과 물리 법칙을 계산한다"기보다, 거대한 데이터셋에서 학습한 분포를 따라 노이즈를 점진적으로 제거하며 이미지를 생성한다. 모델 내부에는 전통적인 의미의 메시나 카메라, 조명이 존재하지 않고, 그 대신 텍스트 프롬프트와 과거 프레임 정보, 잠재(latent) 표현을 입력받아, 수백만 개의 파라미터가 학습한 패턴에 따라 다음 프레임의 잠재 공간을 업데이트한다. 물리 정확도나 일관성이 명시적으로 보장되는 것은 아니지만, 데이터 분포에서 본 풍부한 사례를 통해 "그럴듯한" 시각적 결과를 단시간에 만들어 낼 수 있다.

TurboDiffusion 같은 가속 프레임워크는 이 확산 기반 생성 과정을 극단적으로 효율화한다. 스텝 수를 줄이고, 어텐션 계산을 희소화하고, 저비트 양자화를 도입함으로써, 원래는 각 프레임을 위해 수십~수백 번 반복해야 했던 노이즈 제거 과정을, 소수의 고속 연산으로 대체한다.13 그 결과, 전통 렌더링이 "정확하지만 느린" 방식이라면, 디퓨전 기반 비디오 생성은 "물리적으로 완벽하진 않지만 시각적으로 convincing하고 매우 빠른" 대안으로 자리 잡기 시작했다. 앞으로는 이 둘이 경쟁 관계라기보다, 영화·게임 제작에서 서로 보완적으로 쓰이는 하이브리드 파이프라인이 등장할 가능성이 크다.

실시간 비디오 디퓨전이 바꿀 UI·OS·게임 엔진 패러다임

실시간 비디오 디퓨전의 등장은 단지 "비디오 생성이 빨라졌다"는 차원을 넘어, 컴퓨터를 사용하는 방식 자체를 바꿀 잠재력이 있다. 지금까지의 UI와 운영체제, 게임 엔진은 기본적으로 정적 자산(아이콘, 버튼, UI 스킨, 미리 제작된 3D 모델 등)을 사전에 제작해두고, 그것들을 조합해서 화면에 그리는 구조에 최적화되어 있었다.

하지만 터보급 비디오 디퓨전 모델이 단일 GPU에서 실시간에 가까운 속도로 동작한다면, UI 요소나 배경, 애니메이션, 심지어 캐릭터의 표정과 동작까지도 "미리 만들어 두는 것"이 아니라 "요청될 때마다 모델이 새로 합성하는 것"으로 바뀔 수 있다. 예를 들어, 운영체제의 데스크톱 배경이나 위젯들이 사용자의 현재 작업 맥락, 감정 상태, 시간대에 맞춰 매번 새롭게 생성되는 환경을 상상해볼 수 있다. 사용자는 자연어로 "지금 기분을 편안하게 해줄 애니메이션 배경을 만들어줘"라고 말하면, 시스템이 즉석에서 그런 분위기의 비디오를 생성해 배경으로 설정하는 식이다.

게임 엔진에서도 비슷한 변화가 가능하다. 지금까지는 레벨 디자이너가 모든 지형·오브젝트를 배치하고, 애니메이터가 커트씬과 모션을 미리 만들어둬야 했다. 실시간 비디오 디퓨전이 충분히 빨라지고 안정적이 된다면, 플레이어의 선택과 행동에 따라 그때그때 새로운 장면과 컷신이 합성되는 "즉석 시네마틱"이 가능해진다. 이는 전통적인 게임 엔진의 렌더링 파이프라인과, 디퓨전 기반의 비디오 합성이 긴밀하게 연결된 새로운 형태의 런타임을 요구하게 될 것이다.

Genie 2, ControlNet과 비디오 기반 월드 모델의 가능성

최근에는 텍스트·이미지뿐 아니라 비디오 자체를 입력·출력으로 사용하는 월드 모델(world model)들이 등장하고 있다. 예를 들어 Genie 2와 같은 모델은 사용자가 낙서 수준의 간단한 입력이나 짧은 프롬프트로 2D 게임 환경을 생성하고, 그 안에서 상호작용하는 에이전트의 행동까지 영상 형태로 예측하는 방향을 지향한다. 여기에 ControlNet 계열의 조건부 제어 기법을 결합하면, 사용자가 제공하는 스케치, 깊이 맵, 포즈, 세그멘테이션 마스크 등 구조 정보를 기반으로 비디오 생성 모델의 출력을 정교하게 제어할 수 있다.

TurboDiffusion 같은 가속 기술이 이러한 비디오 기반 월드 모델과 결합되면, "학습된 물리·상식·시각 세계 모델에 기반해, 사용자가 원하는 규칙과 스타일을 가진 상호작용 세계를 실시간으로 합성하는 게임 엔진"이 장기적으로 가능해진다. 즉, 전통 엔진처럼 모든 자산과 규칙을 사람이 명시적으로 코딩하는 것이 아니라, 월드 모델이 세계의 기본 동역학과 시각적 표현을 담당하고, 개발자는 그 위에 최소한의 규칙·제약·목표만 정의하는 식이다.

이런 엔진에서는 레벨 디자인과 콘텐츠 제작의 단위가 "템플릿과 파라미터"로 바뀔 수 있다. 예를 들어, "중세 판타지 마을, 비 오는 밤, 상점가에는 플레이어가 상호작용할 수 있는 NPC가 5명 이상" 같은 고수준 스펙만 던져주면, 월드 모델이 이에 부합하는 시각적·상호작용적 세계를 비디오·중간 표현 형태로 합성하고, 엔진이 이를 런타임에서 스트리밍하듯 보여주는 구조를 상상할 수 있다. TurboDiffusion급 가속이 없다면 이런 접근은 계산량 때문에 비현실적이지만, 100~200배 가속이 이뤄진다면 "제험 가능한 프로토타입" 수준까지는 충분히 접근 가능해진다.13

현재의 한계와 100~200배 추가 가속 이후의 전망

물론 TurboDiffusion이 모든 문제를 해결한 것은 아니다. 연구팀과 정리된 리뷰 자료에서도, 스텝 수를 극단적으로 줄였을 때 일부 장면에서 미묘한 시간적 떨림(temporal flicker)이나 일관성 저하가 관찰된다고 언급한다.3 또한 현재의 가속은 주로 잠재 공간(latent space) 기반 디퓨전에 초점을 맞추고 있으며, 픽셀 공간에서 직접 비디오를 생성하는 모델이나, 순차적인 오토리그레시브 비디오 모델에는 그대로 적용되기 어렵다.13

지연 시간 측면에서도, RTX 5090 수준의 상위 소비자 GPU에서는 "사람이 체감하기에 실시간에 가깝다"는 영역에 들어섰지만, 모바일 디바이스나 저가형 GPU 환경에서는 여전히 부담이 크다. 더불어 클라우드 서비스에서는 지연 시간 외에도 동시 접속자 수에 따른 스케일링 문제, GPU 비용, 에너지 소비 등 경제적 제약이 남아 있다.

그럼에도 TurboDiffusion은 "지금 있는 하드웨어에서 알고리즘과 시스템만 바꿔도 100~200배의 여유가 생긴다"는 것을 실증했다는 점에서, 앞으로의 로드맵을 크게 바꾸어 놓는다.1234 향후 더 향상된 양자화 기법(예: 4비트, 혼합 정밀도), 더 공격적인 스텝 증류, 모듈별 동적 실행(dynamic routing), 전용 비디오 추론 ASIC 등과 결합된다면, 다시 그만큼의 추가 가속이 가능할 여지가 있다. 그렇게 되면 단일 소비자 GPU, 혹은 경량 클라우드 인스턴스에서의 완전한 실시간(수십 FPS 수준) 비디오 생성·편집·합성이 보편화될 수 있다.

이 시점에 이르면 비디오 디퓨전 모델은 기존의 "사전 제작 콘텐츠를 재생하는 미디어 엔진"에서 "실시간으로 세계를 합성하고 조작하는 상호작용 플랫폼"으로 역할이 전환될 가능성이 크다. UI와 OS는 자연어와 제스처로 세계를 명령하고, 게임 엔진은 코드보다 프롬프트와 예시 플레이 영상으로 시스템을 정의하는 쪽으로 진화할 수 있다. TurboDiffusion은 그 방향으로 나아가는 첫 대규모 실증 사례라는 점에서 기술적·산업적 의미가 크다.

결론

TurboDiffusion은 비디오 디퓨전 모델의 추론을 100~200배 가속하면서 품질 저하를 최소화하는 데 성공함으로써, "실시간 AI 비디오 생성"이라는 오래된 목표에 산업적으로 유의미한 발걸음을 내디뎠다.1234 단일 고급 GPU에서 수 초~수십 초 수준의 지연 시간으로 고해상도 비디오를 생성할 수 있게 되면서, 텍스트-투-비디오 서비스, 실시간 영상 편집, 인터랙티브 컷신, 동적 UI, 비디오 기반 월드 모델 등 다양한 응용 가능성이 현실적인 의제로 떠오르고 있다.

아직 품질·지연·비용 면에서 해결해야 할 과제는 많지만, TurboDiffusion이 보여준 "알고리즘·시스템 공진화에 의한 100~200배 가속"은 앞으로의 비디오 생성 연구와 제품 설계에서 강력한 기준점이 될 것이다. 전통적인 렌더링·그래픽스와 디퓨전 기반 비디오 생성이 서로의 장단점을 보완하며 융합되는 과정에서, 우리는 소프트웨어·게임·미디어·운영체제 전반의 패러다임 전환을 마주하게 될 가능성이 높다.

참고

1TurboDiffusion: Accelerating Video Diffusion Models by 100-200 Times

이 노트는 요약·비평·학습 목적으로 작성되었습니다. 저작권 문의가 있으시면 에서 알려주세요.