Claude와 Hugging Face Skills로 누구나 가능한 인공지능 오픈소스 LLM 미세 조정 가이드

AI와 인공지능(인공 지능)의 시대, 이제 복잡한 대형 언어 모델(LLM)의 미세 조정도 전문가의 전유물이 아닙니다! 최근 Hugging Face와 Claude의 만남으로 “나만의 AI”를 쉽고 빠르게 만들 수 있는 시대가 펼쳐졌습니다. 이번 글에서는 Claude가 새로운 도구인 Hugging Face Skills로 오픈 소스 LLM을 미세 조정하는 방법을 알기 쉽게 소개합니다. 초보부터 현업 개발자까지, 세상에서 단 하나뿐인 나만의 AI 모델을 만드는 방법을 자세히 알아보세요.

Claude와 Hugging Face Skills란? LLM 미세 조정을 손쉽게 해주는 조합

Claude는 Anthropic에서 개발된 대형 언어 모델이자, 다양한 프로그래밍 작업을 자동화하는 ‘코딩 에이전트’로 각광받고 있습니다. 여기에 Hugging Face Skills라는 새로운 오픈 소스 도구가 결합되면, 복잡한 모델 미세 조정이 대화 몇 줄로 끝나는 마법 같은 일이 됩니다.

이미지 출처: githubusercontent

이미지 출처: githubusercontent

Hugging Face Skills는 Claude, Codex, Gemini 등 최신 AI 코딩 에이전트들이 “스킬(skill)”이라는 플러그인 모듈을 붙여 원하는 작업을 수행하게 하는 시스템입니다. 대표적인 hf-llm-trainer 스킬은 “이 모델을 이 데이터셋으로 미세 조정해줘”라고 지시하는 순간, 최적의 GPU 선택, 데이터셋 검증, 스크립트 작성, 모니터링 대시보드 설정, 모델 푸시까지 모든 과정을 자동으로 처리합니다.

미세 조정, 왜 필요한가? “나만의 AI”를 뛰어넘은 실용성

기존 대형 언어 모델(LLM)은 범용 데이터로 학습되어 있지만, 비즈니스나 특정 서비스에 적용하려면 내 업무에 특화된 미세 조정(파인튜닝)이 필수입니다. 예를 들어, 신규 고객 상담 로그, 전자상거래 리뷰, 전문용어가 가득한 의료 데이터 등 “나만의 데이터”로 LLM을 추가 학습하면 성능이 크게 향상됩니다.

하지만 기존에는 수천 줄이 넘는 코드, 복잡한 하드웨어 세팅, 예산 걱정 등 높은 진입장벽이 있었습니다. Claude와 Hugging Face Skills를 활용하면, 아래처럼 대화하듯 명령하면 끝!

Fine-tune Qwen3-0.6B on the open-r1/codeforces-cots dataset for instruction following.Claude는 데이터셋 형식이 맞는지 검증하고, 최적의 GPU(T4-small)를 자동 선택, 훈련 스크립트와 모니터링까지 한 번에 세팅합니다.

파인튜닝에서 생산까지, Claude Skills의 자동화 단계

Claude의 Hugging Face Skills는 파인튜닝 과정을 아래의 순서로 자동 처리합니다:

데이터셋 자동 검증: 형식이 잘못되면 빠르게 알려줍니다.

GPU 및 비용 추천: 모델 크기에 맞는 GPU를 추천하고, 예산 예측도 바로 확인 가능.

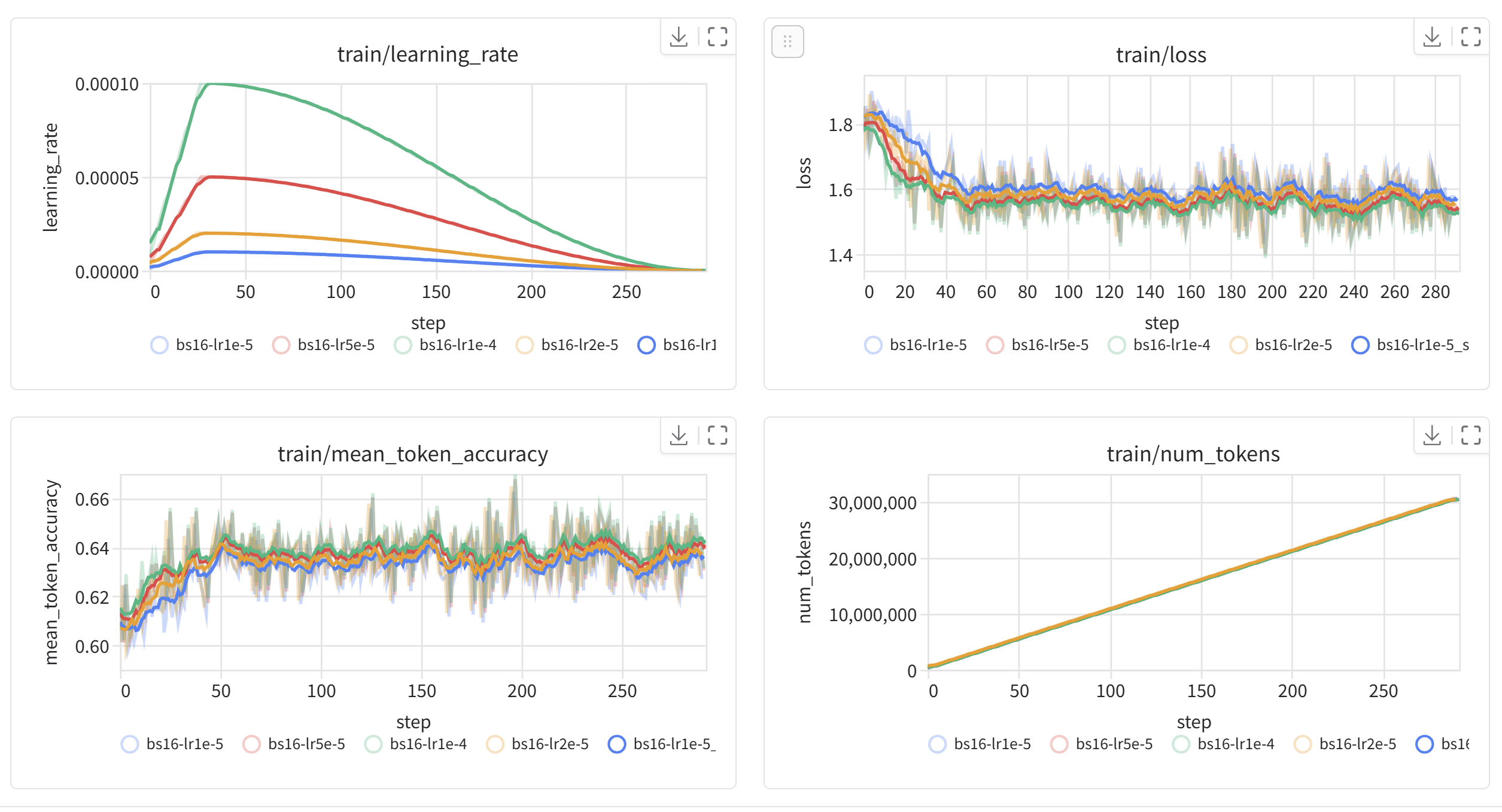

학습 스크립트 및 모니터링 대시보드 자동 생성: 실시간으로 학습 성과(손실, 정확도 등) 확인.

클라우드에서 학습: 모든 작업이 Hugging Face 인프라에서 돌아가니, 내 노트북은 꺼도 OK!

Hub에 모델 자동 업로드: 학습이 끝나면 내 모델이 Hugging Face Hub에 바로 올라갑니다.

GGUF로 변환, 로컬 배포: llama.cpp, LM Studio, Ollama 등 인기 툴로 집PC에서도 실행.

이미지 출처: githubusercontent

이미지 출처: githubusercontent

어떤 학습법이 좋을까? SFT, DPO, GRPO 파헤치기

Claude Skills는 실제 현업에서 쓰이는 3가지 대표 미세 조정 기법을 한 번에 지원합니다.

SFT(Supervised Fine-Tuning, 지도학습 기반 추가학습):

“이런 입력에는 이렇게 대답해!” 직접 예시(프롬프트-정답 쌍)가 있는 경우에 적합합니다.DPO(Direct Preference Optimization, 직접 선호도 최적화):

답변 여러 개 중에 더 나은 선택이 표시된 데이터에 적합. 고객의 선호 도출 등에서 유용합니다.GRPO(Group Relative Policy Optimization, 그룹 상대 정책 최적화):

“이 수학 문제를 풀어라”처럼 정답이 명확히 있는 문제(예: 코드 생성, 논리 추론)에 효과적입니다.

Claude Skills가 학습 목적에 따라 자동으로 추천해주니, 복잡한 알고리즘 이론을 몰라도 실전 적용이 가능합니다.

실제 파인튜닝 예시: 대화만으로 AI를 실전에 배포

예를 들어 사내 고객 상담 로그로 6억 매개변수급 Qwen3 모델을 SFT 방식으로 파인튜닝하고 싶을 때 필요한 건 아래 한 줄 뿐입니다.

Fine-tune Qwen3-0.6B on my-company/support-chats for 3 epochs.Claude가 자동으로 데이터를 스캔해서,

T4-small GPU로 충분한지 확인

데이터가 잘못되었으면 수정방법까지 제안

훈련 중에는 실시간 대시보드(Trackio)에서 Loss와 성능 변화를 확인

학습 완료된 모델은 Hugging Face Hub에 자동 배포, 이후 “GGUF”로 변환해 내 데스크탑, 노트북, LM Studio, Ollama 등 다양한 환경에서 손쉽게 로컬 실행도 가능합니다.

비용 절감의 비밀: 하드웨어-학습 전략 자동 최적화

대형 모델 파인튜닝은 비용 걱정이 가장 큽니다. Hugging Face Skills는 모델 크기에 따라 최적화된 GPU와 비용을 자동 계산해 추천해줍니다.

10억 미만 모델: t4-small으로 시간당 $0.75, 실전 예제는 $0.30이면 OK.

10억~30억 모델: t4-medium이나 a10g-small 사용, 여러 시간 학습해도 $5~15 범위.

30억~70억 모델: a10g-large나 a100-large, 여기서 LoRA/QLoRA 등 메모리 절약형 기법도 자동 적용.

LoRA와 QLoRA 덕분에 데스크탑 한 대로도 웬만한 모델 미세 조정이 가능한 시대가 왔습니다.

LoRA는 전체 가중치 대신 핵심부만 미세 조정해서 메모리와 비용을 크게 줄여주고,

QLoRA는 4비트로 모델을 압축해 랩탑이나 싱글 GPU에서도 대형 모델을 훈련 가능합니다.

실패 없는 데이터 검증과 실시간 문제 해결

훈련 실패의 90%는 데이터 형식 때문! Claude Skills는 학습 전 데이터셋을 미리 검사해서 잘못된 포맷은 바로 알려주고, 자동 변환 코드까지 지원합니다.

파인튜닝이 진행되는 동안에는 “학습이 어디까지 됐어?”, “문제가 생겼어!”처럼 Claude에게 대화하듯 물으면, 실시간으로 상태를 요약해주고, 오류가 발생하면 원인과 해결책(배치 크기 조정, 하드웨어 업그레이드 등)도 제안해줍니다.

GGUF 변환으로 로컬에서 AI 운영까지 원스톱

학습이 끝난 모델은 GGUF(GGML Universal File) 포맷으로 변환할 수 있습니다.

GGUF는 llama.cpp, LM Studio, Ollama 등 다양한 오픈소스 LLM 실행기에서 표준적으로 쓰이기 때문에, 클라우드가 아니라 집/회사 PC에서 원하는 대로 자유롭게 쓸 수 있습니다.

변환도 Claude Skills 한 줄이면 끝:

Convert my fine-tuned model to GGUF with Q4_K_M quantization.로컬에서 빠르고 가볍게, 개인정보도 안전하게 내 AI 모델을 운용하세요.

Claude Skills, 요즘 AI 개발의 대세: 열린 표준과 에이전트 기반 자동화

Claude Skills는 오픈소스로 공개되어 누구나 자유롭게 확장, 커스터마이징이 가능합니다.

최근에는 OpenRouter와 결합해, Claude Code 안에서도 Anthropic 모델뿐 아니라 OpenAI, Google, Meta 등 300가지 LLM과 자유롭게 호환도 가능합니다.

(예시: OpenAI의 GPT-4o나 Meta의 Llama-3를 Claude의 엔진으로 선택!)

이제 LLM 개발은 모델 이름과 복잡한 코드보다는, “나의 워크플로우”를 얼마나 자동화했는지가 더 중요해지는 세상입니다.

시사점: AI, 오픈소스 LLM 파인튜닝의 민주화

Claude Skills와 Hugging Face Skills로 이제 인공지능 모델 미세 조정이 “전문가만의 영역”에서 누구나 활용 가능한 일로 바뀌고 있습니다.

전문가가 아님에도 쉽게 파인튜닝 가능: 데이터셋만 준비하면, AI 에이전트가 나머지를 자동 처리

비용 및 하드웨어 최적화: LoRA/QLoRA 등 최신 기법과 GPU 매핑 자동화로 리스크 최소화

로컬 배포와 오픈소스 생태계 연동: GGUF 등 호환 표준과 다양한 실행기 연결, 개인정보 보호/데이터 소유권 유지

업무에 특화된 AI, 안전한 사내 비서, 맞춤형 챗봇을 만들고 싶다면? Claude와 Hugging Face Skills로 “이 모델을 내 데이터셋으로 파인튜닝 해줘!” 한 마디면 됩니다. 더 이상 어려운 코드와 복잡한 클라우드 환경은 필요 없습니다.

참고

[1] We Got Claude to Fine-Tune an Open Source LLM - Hugging Face Blog

[2] Fine-Tuning Large Language Models with LoRA and QLoRA - DEV Community

[3] Claude (language model) - Wikipedia

[4] llama.cpp - Wikipedia

[5] Use OpenRouter in Claude Code: Model Freedom Arrives - StartupHub.ai