Codex 오픈소싱: 인공지능 코드 에이전트의 혁명과 실전 활용법

‘AI 코드 에이전트가 스스로 AI 모델을 만들고 개선한다면?’—이제 상상이 아닌 현실입니다. OpenAI의 Codex가 인공지능 모델을 오픈소싱하며 Hugging Face Skills와 통합된 새로운 패러다임을 연 지금, 누구나 손쉽게 강력한 머신러닝 실험부터 실전 배포까지 가능해졌죠. 이 글에서는 Codex와 Hugging Face Skills의 실제 사용법, 자동화된 AI 훈련 라이프사이클, 그리고 이 변화가 코딩과 인공지능 생태계에 미치는 영향을 쉽고 재미있게 풀어보겠습니다.

Codex란 무엇이고, 왜 오픈소싱이 혁신인가?

Codex는 GPT 기반의 AI 코드 에이전트로, 코드를 자동으로 작성하고, 수정하며, 개발자의 업무를 가속하는 도구입니다. 초기에는 GPT-3가 깃허브 Copilot에 활용되었지만, 이제 ChatGPT, Codex CLI, IDE 확장(예: VS Code, Windsurf) 등 다양한 환경에서 활용됩니다. OpenAI는 Codex를 오픈소스로 공개하고 있으며, Hugging Face Skills와도 완벽하게 호환되어 보다 손쉽게 복잡한 머신러닝 작업을 실행할 수 있게 되었죠.

이 혁신의 핵심은 단순 코딩 자동화를 넘어서, AI 스스로를 개선하는 ‘자기 개선 루프’를 현실화했다는 점입니다. 실제로 OpenAI 개발자들은 Codex 자체를 Codex가 직접 코딩하도록 활용하고 있습니다.

Hugging Face Skills: AI 에이전트에게 ML 전문가의 노하우를 전수하다

Hugging Face Skills는 일종의 ‘디지털 직업훈련소’입니다. SKILL.md, AGENTS.md 등 명확한 문서와 스크립트가 담긴 레포지토리를 통해, Codex나 Claude Code 같은 에이전트가 직접 모델 훈련·평가·배포까지 전체 과정을 자동화할 수 있게 하죠.

예를 들어, "Qwen3-0.6B 모델을 codeforces-cots 데이터셋으로 미세조정(fine-tuning)해줘"라고 명령하면 Codex는:

데이터셋 포맷을 자동 검증

최적의 GPU 하드웨어 선정

실시간 훈련/평가 스크립트 생성 및 실행

훈련 결과를 리포트로 정리

오류 발생 시 자동 디버깅

까지 모든 과정을 알아서 처리합니다. 수동 설정, 복잡한 코드 관리, 자원 최적화 등의 장벽을 없애며, 누구나 한 줄 프롬프트로 ‘연구자 수준의 ML 워크플로우’를 구동할 수 있게 만든 것이죠.

직접 실험: 한 줄 명령으로 “끝까지 자동화되는” AI 모델 훈련 라이프사이클

머신러닝 실험은 ‘데이터 준비-모델 선택-훈련-평가-배포’라는 복잡한 과정을 거칩니다. Codex와 Hugging Face Skills 통합의 진가는 이 모든 단계를 한 프롬프트로 자동화한다는 데 있습니다.

실제 예시:

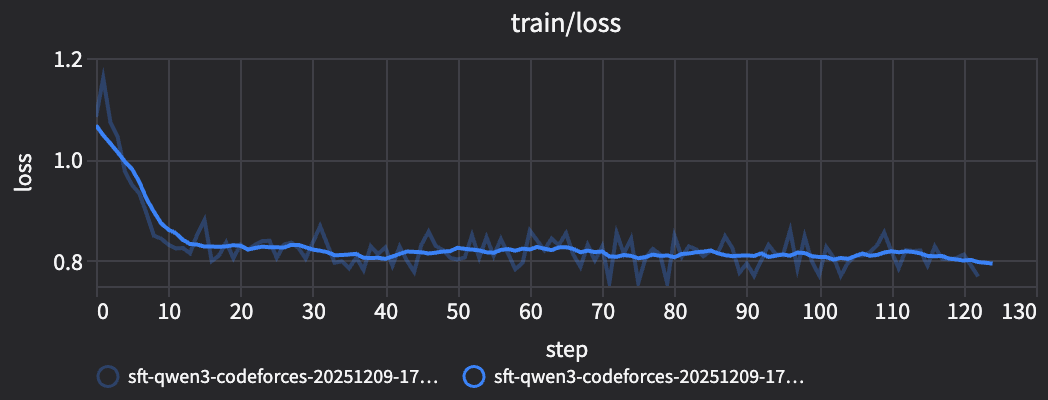

“코드 풀이 능력을 높이기 위한 SFT 미세조정 실험 시작해줘. 리포트 작성하고 HumanEval 벤치마크로 평가해.”

Codex는 훈련 설정부터 GPU 비용 계산, 진행 상황 실시간 업데이트, 평가표 자동 작성까지 ‘손하나 까딱할 틈’ 없이 알아서 실행합니다.

이미지 출처: huggingface

이미지 출처: huggingface

실험이 끝나면 결과는 리포트로 자동 정리되고, 짧은 코드 한 줄로 바로 모델을 로컬 또는 Hugging Face Hub에 배포할 수 있습니다.

GGUF로 로컬 배포: 내 PC에서도 강력한 AI 코딩 에이전트를!

AI 모델은 꼭 클라우드에서만 돌리는 게 아닙니다. Codex Skills를 활용하면 모델을 GGUF 형식으로 간편하게 변환, 여러분의 개인 PC나 자체 서버에서 낮은 비용으로 돌릴 수 있습니다.

GGUF는 최신 모델 압축 기술로, 모델 사이즈와 메모리 사용을 획기적으로 줄이면서도 품질을 거의 유지합니다. 덕분에 Qwen, DeepSeek, Llama 등 최신 오픈소스 모델을 로컬로, 심지어 8~16GB 시스템에서도 구동 가능하죠.

예시:

“내 미세조정 모델 GGUF으로 변환하고 퀀타이즈(Q4_K_M) 해줘. 로컬에 배포해.”

이렇게 변환된 모델은 llama.cpp, Ollama, LM Studio 등 다양한 엔진 및 IDE플러그인으로 즉시 활용할 수 있습니다.

하드웨어와 비용관리: 초보도 쓰기 쉬운 자동화된 최적화

머신러닝에서 ‘최적 GPU 선택과 비용 예측’은 숙련 개발자도 고민하는 영역입니다. Codex는 모델 크기별로 최적의 GPU를 자동 선정하고, 예상 시간과 비용도 미리 보여줍니다.

1B 미만 모델: t4-small(몇백 원이면 실험 가능!)

1~3B 모델: t4-medium, a10g-small(수 시간·만원 안팎)

3~7B 모델: a10g-large, a100-large(몇만원대, LoRA로 효율 극대화)

7B 이상: 현재 점진적 지원 확대 중

덕분에 연구용 빠른 실험부터 실제 서비스 모델까지, 자원 낭비 없이 현명하게 ML 실험을 할 수 있죠.

에이전트의 진화: ‘스킬’ 기반 자동화 생태계로의 확장

Codex와 Hugging Face Skills의 등장으로 AI 자동화 생태계도 빠르게 확장 중입니다. ‘스킬’ 기반 구조라서, AI 에이전트가 필요한 기능을 폴더 추가/Markdown 파일 수정만으로 즉시 배울 수 있습니다.

Anthropic Claude, Gemini CLI 등 주요 에이전트와도 호환되므로, "이제는 어떤 에이전트든 자연어로 ML 실험을 지시하고 실시간 결과를 받을 수 있다"는 의미죠. 커뮤니티의 다양한 스킬 문서, 실험 스크립트, 활용 가이드가 끊임없이 쌓여 새로운 자동화 혁신이 계속 이어지고 있습니다.

시사점: AI, 오픈소스를 넘어 누구나 손쉽게 사용하는 자동화 도구로

이번 Codex 오픈소싱과 Hugging Face Skills 통합은 진정한 ‘AI 평등화’의 출발입니다. 이제 복잡한 머신러닝·AI 서비스 구축이 연구자·대기업만의 영역이 아니라, 누구나 한 줄 입력으로 자동화할 수 있는 일상이 된 것이죠.

개발자, 스타트업, 교육기관, 연구자 모두에게:

복잡한 코드와 인프라 걱정 없이 실험에서 배포까지 전 자동화

오픈소스 커뮤니티의 빠른 혁신과 공정한 정보 공유

로컬 배포로 비용·보안·개인화 모두 챙김

AI 에이전트에 ‘새로운 스킬’ 즉시 추가해 내 업무 맞춤형 자동화까지!

앞으로 AI 자동화의 민주화는 더욱 가속화 될 것이며, 자동화된 에이전트와 오픈소스 생태계가 개발과 혁신의 중심이 될 것입니다.

참고

[1] Codex is Open Sourcing AI models - Hugging Face

[2] How Codex and Hugging Face Skills Automate Open Source AI Model Training - Joshua Berkowitz

[3] Hugging Face Skills: Teaching AI Agents the Art of Machine Learning - Joshua Berkowitz

[4] OpenAI are quietly adopting skills, now available in ChatGPT and Codex CLI - Simon Willison

[5] How OpenAI is using GPT-5 Codex to improve the AI tool itself - Ars Technica