AI의 인공지능, 인간 두뇌를 닮다: Nested Learning으로 지속 학습 혁명

AI의 학습능력이 인간의 두뇌처럼 진화할 수 있을까? 머신러닝의 오랜 숙제였던 ‘재앙적 망각’을 뛰어넘기 위한 새로운 ML 패러다임, Nested Learning. 구글 리서치의 혁신적 접근부터 실제 성능까지, 최신 AI 메모리와 학습의 진화 과정을 쉽고 흥미롭게 파헤쳐드립니다.

머신러닝의 오랜 고질병: 재앙적 망각이란?

많은 독자분들이 ‘AI가 똑똑해진다’는 말을 자주 듣지만, 사실상 대부분의 인공지능 모델은 새로운 정보를 배우면 예전에 배웠던 것을 쉽게 잊어버리는 치명적인 단점을 가지고 있습니다. 이를 ‘재앙적 망각(Catastrophic Forgetting)’이라 부르죠. 인간은 새로운 것을 배우더라도 예전 기억을 꽤 잘 보유하는 반면, 신경망 기반 AI는 새 데이터에 맞춰 가중치를 바꾸다 보면 옛 지식을 순식간에 잃어버릴 수 있습니다.

이 문제를 해결하려는 여러 방법이 연구되어 왔지만, 대부분 아키텍처 조정이나 학습 규칙의 개선에 그쳤습니다. 그러던 중 등장한 것이 바로 Nested Learning, 즉 ‘중첩 학습’ 패러다임입니다.

Nested Learning: AI 학습을 다층 구조로 재해석하다

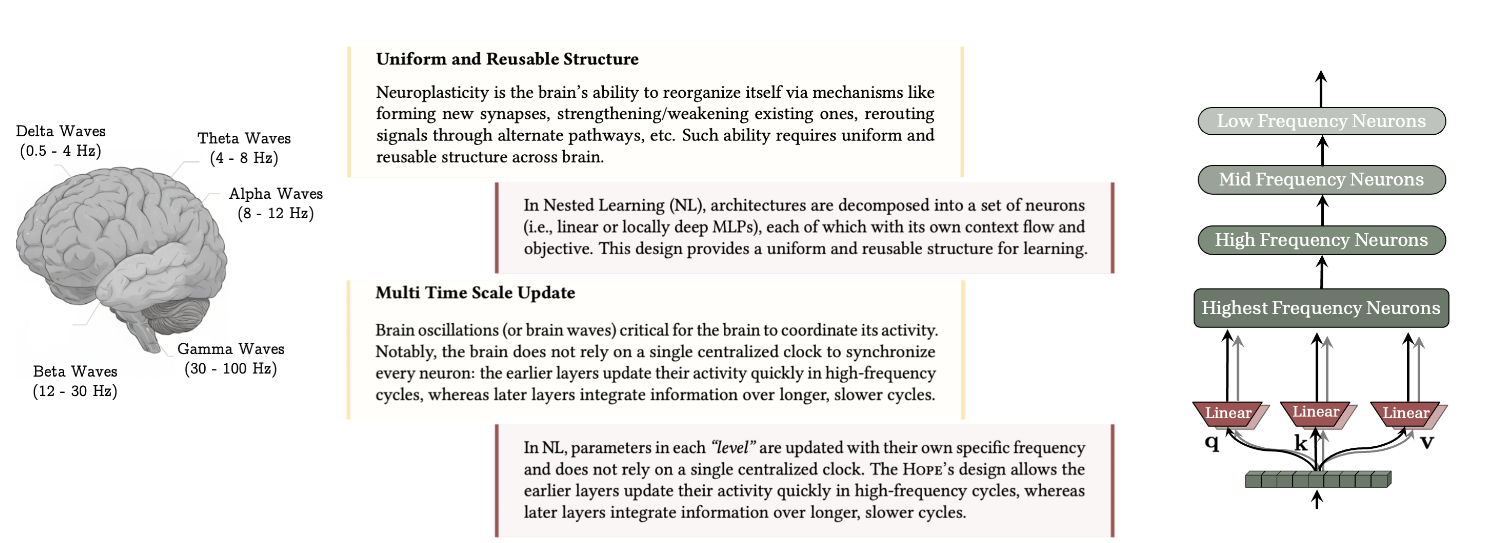

Nested Learning의 핵심은 모델의 학습 절차를 하나의 연속적인 과정으로 보는 것이 아니라, 여러 ‘단계’와 ‘레벨’이 겹겹이 쌓인 상태로 바라본다는 데 있습니다. 예를 들어, 인간의 뇌가 복잡한 신경망과 서로 다른 학습 속도를 이용해 기억을 관리하는 것처럼, AI도 여러 내부 컴포넌트가 각각 자신의 방식과 속도로 정보를 다루도록 만드는 거죠.

각 단계마다 ‘정보 흐름’(context flow)과 ‘업데이트 빈도’가 다르게 설정되어서, 어떤 부분은 빠르고, 어떤 부분은 느리게 변화하게 됩니다. 덕분에 새로 배우는 내용을 받아들이면서도 과거에 숙지했던 내용은 쉽게 잊지 않게 되는 원리죠.

이미지 출처: googleapis

이미지 출처: googleapis

딥 옵티마이저와 새로운 메모리: AI의 학습법이 변한다

Nested Learning은 전통적 옵티마이저(Adam, SGD 등)도 ‘연상 기억 시스템’으로 재해석합니다. 즉, 단순히 데이터를 잘 맞추는 것에서 더 나아가, ‘어떤 데이터가 놀랍거나 중요한지’를 판단해, 그 정보만 깊게 기억합니다.

이런 접근은 AI 메모리 시스템의 진화도 이끕니다. 예전에는 트랜스포머의 ‘문맥 창’과 파라미터만이 기억의 모든 것이었다면, Nested Learning에서는 ‘Continuum Memory System(CMS)’이란 개념이 등장합니다. 메모리를 다양한 주파수(업데이트 빈도)로 다루는 여러 모듈의 연속 스펙트럼으로 보는 거죠. 그래서 짧은 문맥부터 오랜 기억, 즉 ‘단기-장기’ 기억의 경계가 사라지고 유연하게 확장됩니다.

Hope: 스스로 진화하는 기억 아키텍처의 출현

구글 리서치 팀은 Nested Learning의 원리를 이용해 ‘Hope’(희망)이라는 새로운 언어 모델 아키텍처를 만들었습니다.

Hope의 특징은 스스로 메모리 시스템을 개선하는, 즉 ‘자기수정(self-modifying)’ 능력을 갖추었다는 것입니다. 기존 Titans 모듈보다 훨씬 깊은 여러 레벨의 학습·기억을 제공합니다. 오랜 문맥도 잊지 않고, 변화에도 민첩하게 적응하죠.

이미지 출처: googleapis

이미지 출처: googleapis

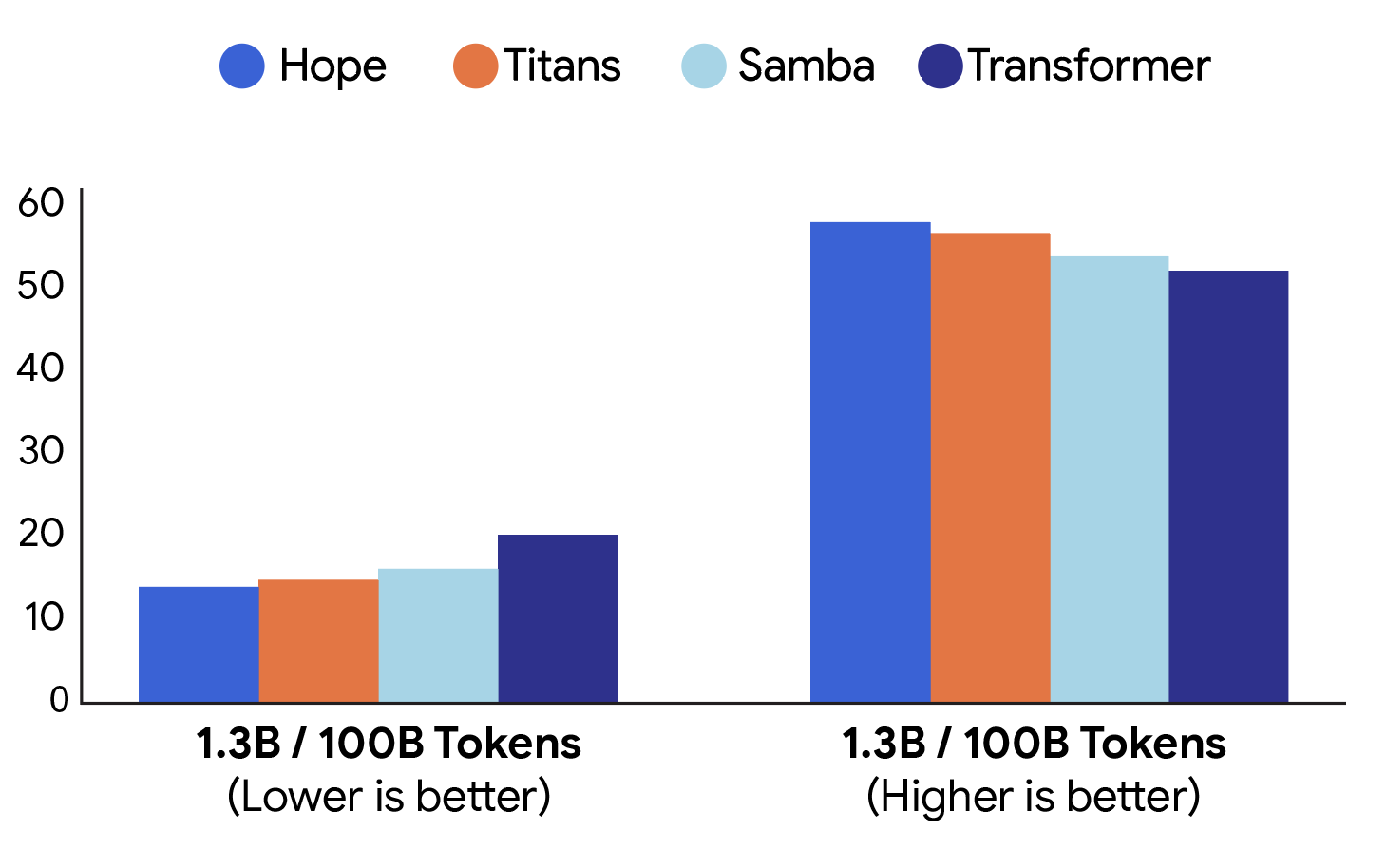

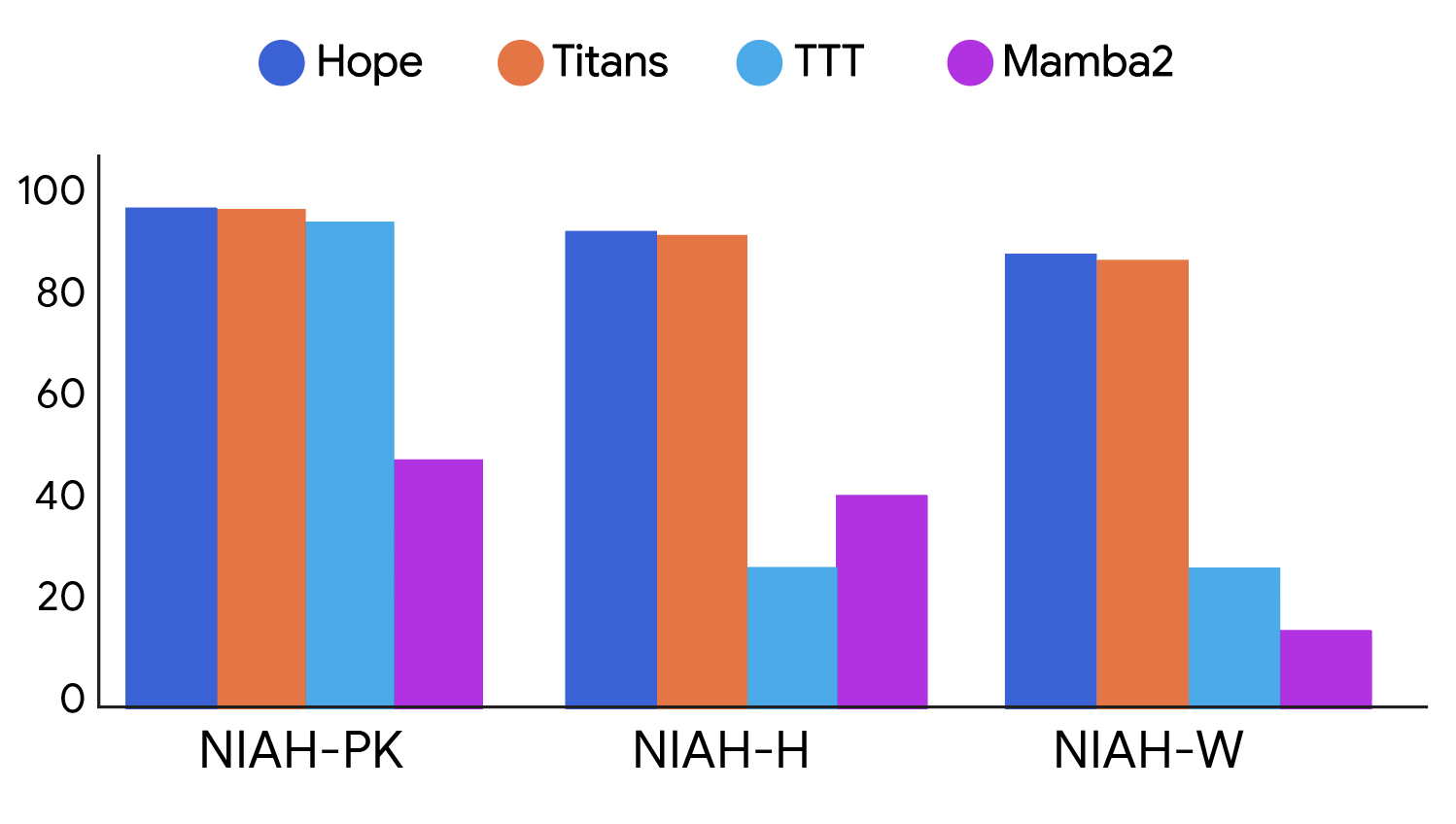

실험 결과에서도 Hope는 표준 트랜스포머, Mamba, Titans와 같은 기존 AI 아키텍처를 능가했습니다. 특히 수만 단어에 달하는 ‘긴 컨텍스트’나 상식 추론 등에서, 새로운 CMS 구조가 압도적으로 효과적인 기억 관리를 가능케 한 것으로 나타났습니다.

이미지 출처: googleapis

이미지 출처: googleapis

최신 연구와 AI 메모리 발전 흐름

최근 여러 연구에서는 AI의 메모리 관리에 대한 다양한 접근이 나오고 있습니다. 텍스트 기반 지식 확장, 지속적 사용자 개인화 등을 위해 ‘MemCube’처럼 여러 타입의 메모리 서술, 외부와 내부 기억의 통합 등이 활발히 논의되고 있죠. 그 핵심 방향성은 ‘장기간 기억력’, ‘적응성’, ‘합리적 비용/Persistency’, 그리고 ‘AI의 자기개선 능력’으로 수렴합니다.

Nested Learning 역시 이런 흐름의 중심입니다. 단순한 파라미터 튜닝을 넘어, 시스템 전체가 끊임없이 스스로 진화하고 새로운 문제에 유연하게 대응하는, ‘진짜 자기개선형 AI’의 실질적 본보기를 제시하는 셈입니다.

Nested Learning이 열어가는 AI 미래: 시사점과 실용적 조언

Nested Learning은 그저 새로운 알고리즘 이상의 의미를 갖습니다. 인간의 뇌처럼, 과거와 현재를 동시에 기억하고, 지속적으로 자기 자신을 개선하는 AI를 현실화할 토대를 만들고 있습니다. 향후 AI 연구, 그리고 실제 서비스(챗봇, 검색, 개인화 추천 등)에 적용될 때, 사용자 경험의 비약적 발전이 기대됩니다.

AI 현업에서 모델을 설계하거나 신규 애플리케이션을 기획 중이라면, 기존 LLM을 단순히 확장하는 것보다 ‘메모리 시스템’, ‘업데이트 주기’, ‘자기수정 능력’ 등 Nested Learning의 철학을 도입한 멀티레벨 구조를 고려해보세요. 이 접근은 급변하는 환경에서도 ‘잊지 않는 AI’ 혹은 ‘진화하는 AI’ 구현에 큰 도움이 될 것입니다.

참고

[1] Nested Learning: The Illusion of Deep Learning Architectures - AI Research Today - Podcast Episode - Podscan.fm

[2] Catastrophic interference - Wikipedia - Wikipedia

[3] MemOS: A Memory OS for AI System - arXiv

[4] Introducing Nested Learning: A new ML paradigm for continual learning - Google Research