Nvidia, 자율주행과 음성 AI의 미래를 열다: Alpamayo-R1과 MultiTalker 전격 분석

인공지능(AI)의 역사는 늘 한계에 도전하는 여정이었습니다. 2025년 NeurIPS AI 컨퍼런스에서 Nvidia가 공개한 최신 AI 모델들은 ‘자율주행 자동차’와 ‘다중화자 음성 인식’이라는 오랫동안 해결되지 못한 과제에 혁신적 해답을 제시합니다. 이 글에서는 Nvidia의 신작 AI, Alpamayo-R1과 MultiTalker가 어떻게 업계를 뒤흔들고 있는지 쉽고 재밌게 풀어드립니다.

Alpamayo-R1: 자율주행차에 ‘생각’을 심다

자율주행 자동차가 스스로 길을 찾는 건 이제 흔한 일이지만, ‘왜 그렇게 결정했는지 설명하는 차량’을 상상해본 적 있으신가요? 바로 이 지점에서 Nvidia의 Alpamayo-R1이 등장합니다.

Alpamayo-R1은 ‘Vision-Language-Action(VLA)’ 모델로, 차량 센서 데이터와 주변 상황을 조합해 단계별로 추론합니다. 예를 들어, 복잡한 교차로나 자전거 도로 옆을 지나갈 때, 그저 이동하는 것이 아니라 “저기 자전거 도로가 있으니 차선을 바꿔야겠다”와 같은 내부 논리를 생성해 결정의 근거를 설명합니다.

이 과정은 ‘Chain-of-Thought Reasoning(연쇄적 사고 추론)’ 기법으로 이뤄집니다. 덕분에 엔지니어는 자동차의 행동 속 논리를 실시간으로 파악할 수 있고, 문제가 발생해도 원인을 정확히 찾을 수 있습니다. 이전의 자율주행 시스템이 ‘블랙박스’처럼 작동했다면, Alpamayo-R1은 말 그대로 ‘생각을 소리내는 자동차’인 셈입니다.

또 주목할 점은, 이 모델이 오픈소스로 공개되어 전 세계 연구자와 개발자가 자유롭게 벤치마킹과 실험용으로 활용할 수 있게 되었다는 점입니다. 안전성 향상과 규제 대응에 불필요한 장벽이 사라진 셈이죠.

이미지 출처: nvidia

이미지 출처: nvidia

Cosmos Reason, AlpaSim, LidarGen: 로보틱스와 자율주행 시뮬레이션의 총집합

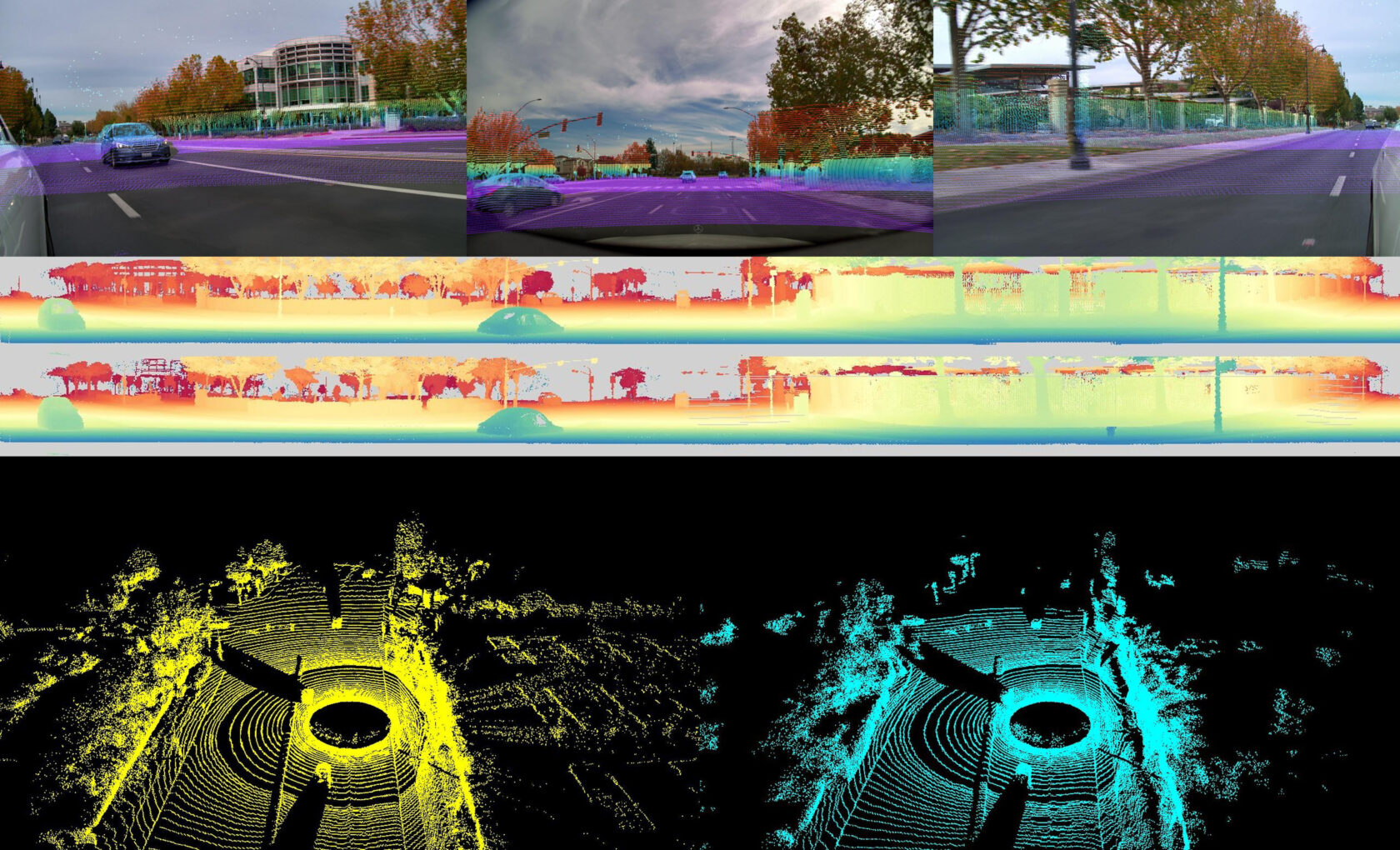

Alpamayo-R1의 뿌리가 되는 ‘Cosmos Reason’ 플랫폼은 로봇공학과 자율주행을 위한 AI 개발을 뒷받침합니다. 실제 Nvidia는 이번 발표와 함께 AlpaSim(성능 평가 도구), LidarGen(라이다 데이터 생성), ProtoMotions3(디지털 휴먼/로봇 시뮬레이션) 등 고급 툴도 공개했습니다.

예를 들어, LidarGen을 활용하면 실제 차량 센서처럼 정교한 라이다 데이터를 시뮬레이션에서 생성할 수 있어, 자율주행 테스트의 품질이 획기적으로 높아집니다. 또 Cosmos 기반 로봇 정책 생성 프레임워크는 실제 로봇의 행동패턴을 영상 기반으로 손쉽게 훈련할 수 있어, 미래의 로봇 자동화를 앞당깁니다.

이미지 출처: nvidia

이미지 출처: nvidia

MultiTalker: ‘동시다발’ 대화도 척척 분리하는 음성 AI

음성 AI 분야에서도 Nvidia는 강력한 한 방을 선보입니다. MultiTalker 모델은 여러 사람이 동시에 이야기해도 각 화자의 발화를 정확히 분리하고, 각각을 자동으로 필사(transcription)하는 기술입니다.

기존의 음성 인식기들은 두 사람이 겹쳐 말하면 혼란에 빠지는 경우가 많았죠. 하지만 MultiTalker는 각 음성의 특성을 빠르게 파악해 누가 어떤 말을 했는지 실시간으로 구분할 수 있습니다. 실시간 회의록 작성, 컨택센터 상담 분석, 미래의 스마트 스피커 등 다양하게 활용될 수 있습니다.

여기에 Sortformer(실시간 화자 구분), Nemotron Content Safety Reasoning(안전 규칙에 따라 음성/텍스트 자동 체크), NeMo Gym(강화학습 환경 구축) 등 다양한 음성 AI 툴과 데이터셋도 함께 개방되어, 음성 분야 혁신이 가속화될 전망입니다.

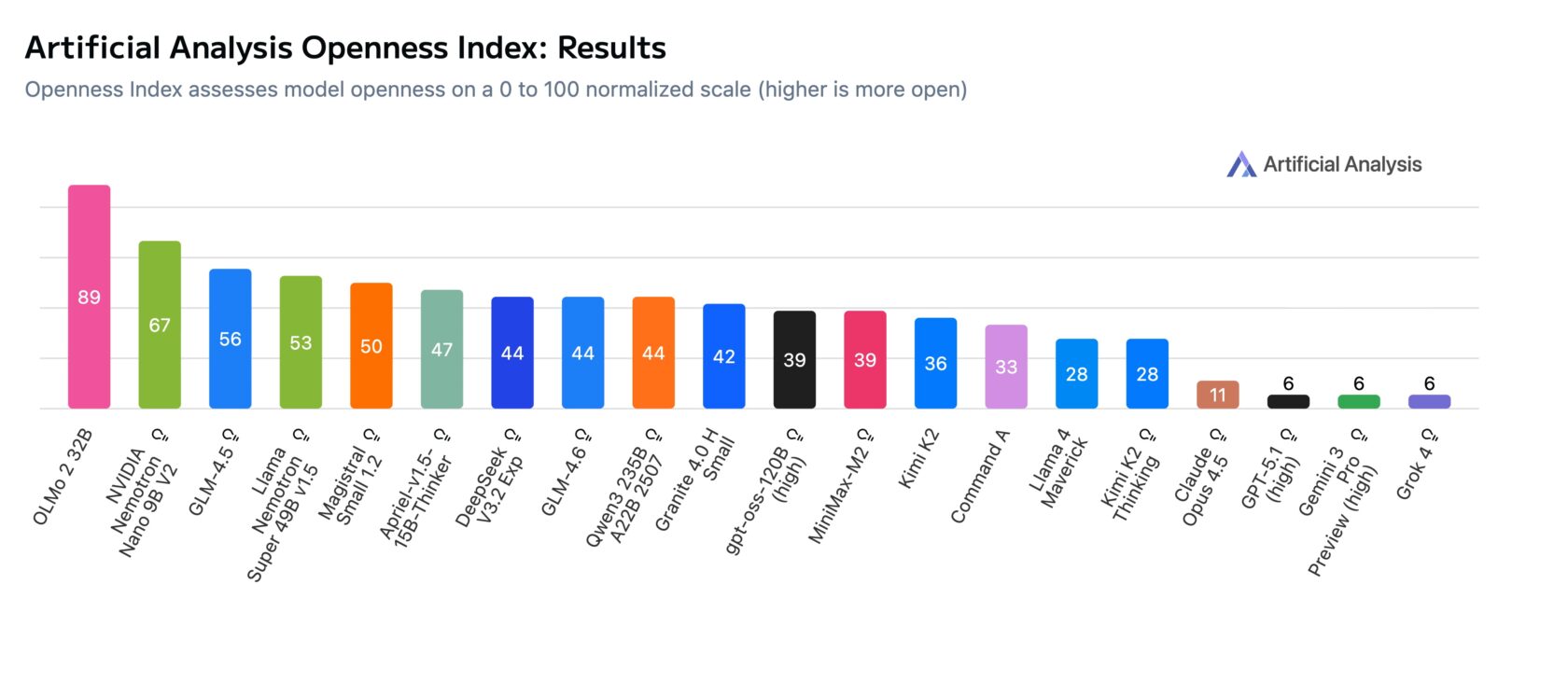

오픈소스 혁신, 업계 투명성의 새로운 기준

Nvidia의 Alpamayo-R1과 관련 툴킷, 그리고 최신 음성 AI 모델은 모두 오픈소스로 공개되었으며, 비상업적 연구나 실험에 누구나 활용할 수 있습니다. ‘지극히 투명하고 개방적’이라는 점에서 독립기관 Artificial Analysis의 Openness Index(오픈성 지수)에서도 업계 최고 수준의 평가를 받았습니다.

특히 이번 공개는 AI 안전성, 규제 대응, 그리고 연구 커뮤니티의 협업을 크게 촉진할 수 있는 토대가 됩니다. 개발자와 연구자는 Github, Hugging Face 등에서 모델과 데이터를 직접 받을 수 있습니다.

실용 포인트: 왜 이번 Nvidia의 AI가 중요한가?

자율주행 안전성 강화: 행동의 근거를 설명할 수 있는 AI 덕분에 사고 원인 분석과 규제 대응이 크게 용이해집니다.

음성 인식 정확성 혁신: 동시다발 대화 분리, 화자 식별, 안전 콘텐츠 체크 등 다양한 발화 환경에서 신뢰도 높은 성능을 기대할 수 있습니다.

오픈소스 생태계 확대: 세계 각국 연구자가 자유롭게 모델을 개선, 평가, 실험할 수 있어 AI 기술 발전의 속도가 현저히 빨라질 것입니다.

로보틱스 및 시뮬레이션 강화: Cosmos Reason, LidarGen 등 고급 툴로 물리 세계를 모사하고, 로봇 정책 훈련까지 한 번에 가능해집니다.

시사점: AI가 ‘생각하는 이유’를 설명하는 시대

이제 AI는 단순히 ‘정답’을 내놓는 것이 아니라, ‘왜 그런 선택을 했는지’까지 투명하게 보여주는 단계에 접어들었습니다. Alpamayo-R1의 “생각을 소리내는 자동차”, MultiTalker의 “동시 대화 분리”는 결국 더 안전하고 신뢰할 수 있는 AI의 길로 나아가게 합니다.

앞으로 자율주행, 로보틱스, 음성 인식 분야의 혁신을 고민하는 개발자나 업계 관계자라면, 이번 Nvidia의 오픈소스 생태계에 주목할 만합니다. 현장 실증과 연구 협업의 기회를 노려보세요. AI 기술은 역시 ‘함께’ 진화할 때 가장 빠르게 성장합니다.

참고

[1] NVIDIA Advances Open Model Development for Digital and Physical AI - NVIDIA Blog

[2] Nvidia’s Open AI Model Alpamayo-R1 Teaches Self-Driving Cars to ‘Think Out Loud’ - Technology Org

[3] Nvidia announces new open AI models and tools for autonomous driving research - TechCrunch

[4] NVIDIA Open Sources Reasoning Model for Autonomous Driving at NeurIPS 2025 - Analytics India Magazine