구글이 AI 시대를 위해 만든 13만 노드 Kubernetes 클러스터의 모든 것

인공지능(AI)의 비약적인 발전과 함께, 그 뒤에서 데이터를 다루고 학습시키는 시스템도 상상을 초월하게 커지고 있습니다. 구글 클라우드는 최근 실험적으로 단일 클러스터에 13만 개 노드(=서버)를 운영하는 데 성공했습니다. 이 기록적인 규모는 Kubernetes와 GKE(Google Kubernetes Engine)의 한계를 두 배로 확장하며, 앞으로 AI 인프라가 얼마나 커질지에 대한 방향성을 제시합니다.

이 글에서는 Kubernetes 클러스터가 왜 급성장하는지, 13만 노드급 클러스터를 어떻게 설계하고 운용했는지, 그리고 여기서 얻은 교훈이 우리에게 어떤 실질적 가치와 아이디어를 주는지 쉽고 재미있게 설명합니다.

1. AI가 만들어낸 클러스터 초대형화: 왜 13만 노드가 필요한가?

AI와 머신러닝, 그리고 대형 언어 모델(LLM)의 훈련에는 엄청난 컴퓨팅 파워가 필요합니다. 예전에는 서버 몇 백 대면 큰 규모였지만, 이제 GPU 수만 개가 연결된 초대형 클러스터가 ‘현실’이 됐죠.

특히 한 개의 고성능 GPU, 예를 들어 NVIDIA GB200은 2,700와트의 전력을 씁니다. 수천~수만 개 GPU가 모이면 그 클러스터 하나로 발전소 한 두 개 분량의 전기를 필요로 할 수준이 됩니다. 이 때문에 구글은 전 세계 여러 데이터센터를 연결해 클러스터를 분산 운영해야 했고, 단일 Kubernetes 클러스터의 한계를 극적으로 늘려야만 했습니다.

“이제 AI 클러스터는 칩 공급이 아니라 전력 공급이 진짜 문제!”라는 말이 나오는 이유입니다.

2. 스케일의 벽을 뛰어넘는 혁신: GKE의 새로운 설계

13만 노드 클러스터를 만들면서 구글이 바꾼 점은 단순히 서버 숫자만 늘린 게 아니었습니다. 모든 중요한 요소, 즉

컨트롤 플레인(제어 부문)

스케줄러(작업 배치·관리)

저장소 구조(데이터 저장과 관리)

를 처음부터 다시 설계한 셈입니다.

API 서버와 캐시 강화: 읽기도 단번에 처리!

노드와 파드(Pod)가 수십~수백만 개가 되면, 컨트롤 부문에서 생기는 요청량은 기하급수적으로 늘어납니다. 기존 Kubernetes에서는 데이터베이스에 반복적으로 요청을 날려야 했는데, 구글은 인메모리 캐시를 일관성 있게 관리하는 방식(KEP-2340, KEP-4988)을 도입했습니다.

즉, ‘이번엔 메모리에서 바로 최신 상태를 확인하세요!’라는 접근이며, 덕분에 빠르고, 수백만 개 객체를 동시에 조회해도 데이터베이스가 버티지 못해 다운되는 일이 없었습니다.

분산 스토리지: Google Spanner 기반으로 초고속 확장

대용량 클러스터에서는 스토리지도 성능이 따라줘야 합니다. 구글은 자체 분산 데이터베이스(Spanner)를 활용해, 초당 13,000회 이상의 데이터를 동시에 갱신할 수 있도록 엔지니어링했습니다. 덕분에 노드 상태 체크, 리더 선출 등 핵심 운영도 무리 없이 돌아갔죠.

3. AI 시대 클러스터의 새로운 두뇌: Kueue와 워크로드 인식 스케줄링

일반 Kubernetes 스케줄러는 파드 단위로만 작업을 배분합니다. 하지만 AI 훈련 환경에서는 ‘작업 전체(배치)’ 단위의 성능과 자원 관리가 필수입니다.

구글은 Kueue라는 고급 큐 컨트롤러를 도입했습니다. 이것은 단순한 파드 배치가 아니라,

우선순위와 자원 요구량에 따라

“이 작업 필요한 리소스 다 못 쓰면, 아예 실행 안 함~”

여러 작업이 경쟁하면 전체적 효율과 공정성을 고려해 배치

등을 적용합니다.

앞으로 Kubernetes 스케줄러도 ‘워크로드 전체의 맥락’을 반영하는 방향으로 발전할 예정이며, 이 변화는 AI·ML 뿐만 아니라 하이퍼스케일 컴퓨팅 전체에 중요한 진화일 것입니다.

4. 데이터 접근 속도, 인공지능의 성패를 좌우한다

AI/ML 환경의 또 다른 핵심은 데이터 입출력입니다. 구글은 GCS FUSE와 Google Cloud Managed Lustre와 같은 도구를 활용했습니다.

이것을 이용하면, 데이터가 클라우드에 저장돼 있더라도 마치 로컬 파일처럼 빠르게 접근할 수 있고, 캐싱이나 병렬 다운로드로 지연시간을 최대 70%까지 줄일 수 있습니다. 덕분에 AI 트레이닝·추론 작업에 빠른 데이터 공급이 가능해졌고, 다중 페타바이트까지도 문제 없이 처리할 수 있었습니다.

5. 13만 노드 벤치마크: AI/ML 현실을 그대로 재현하다

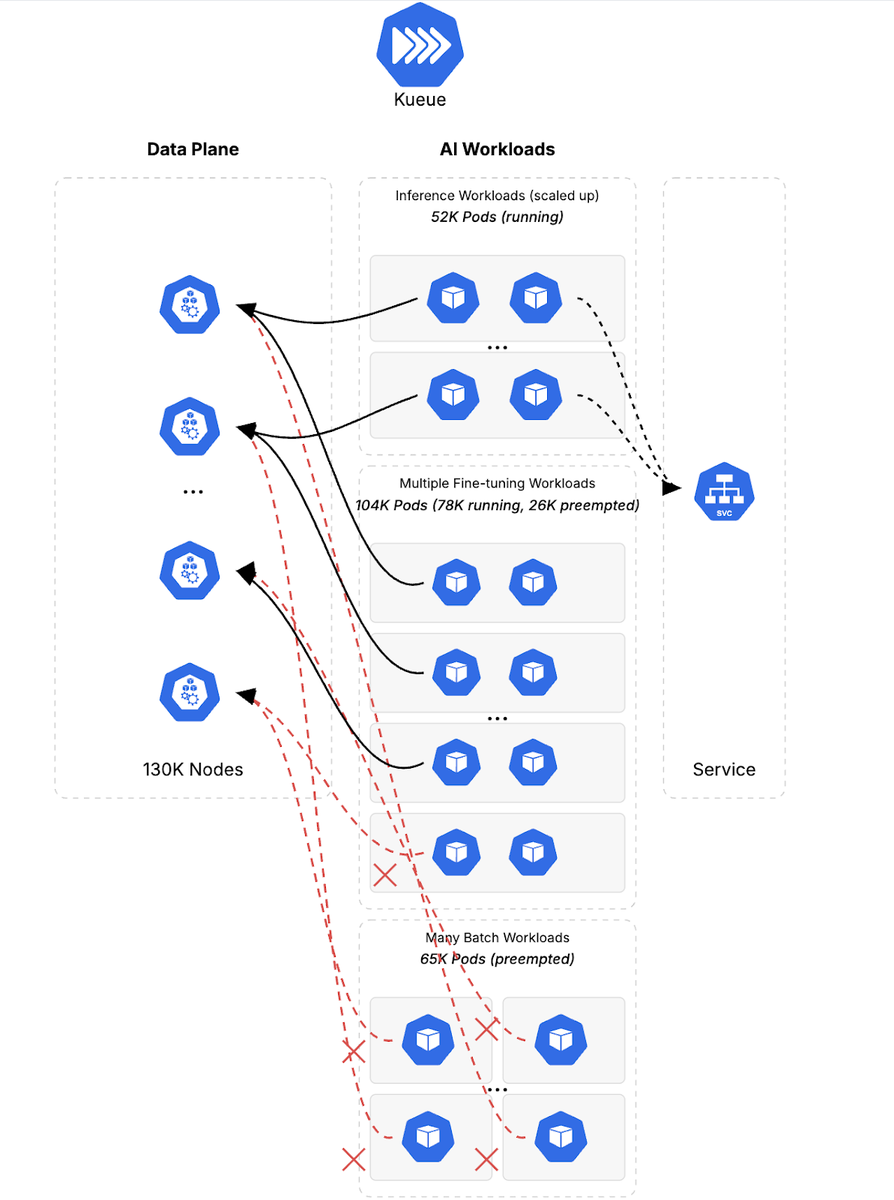

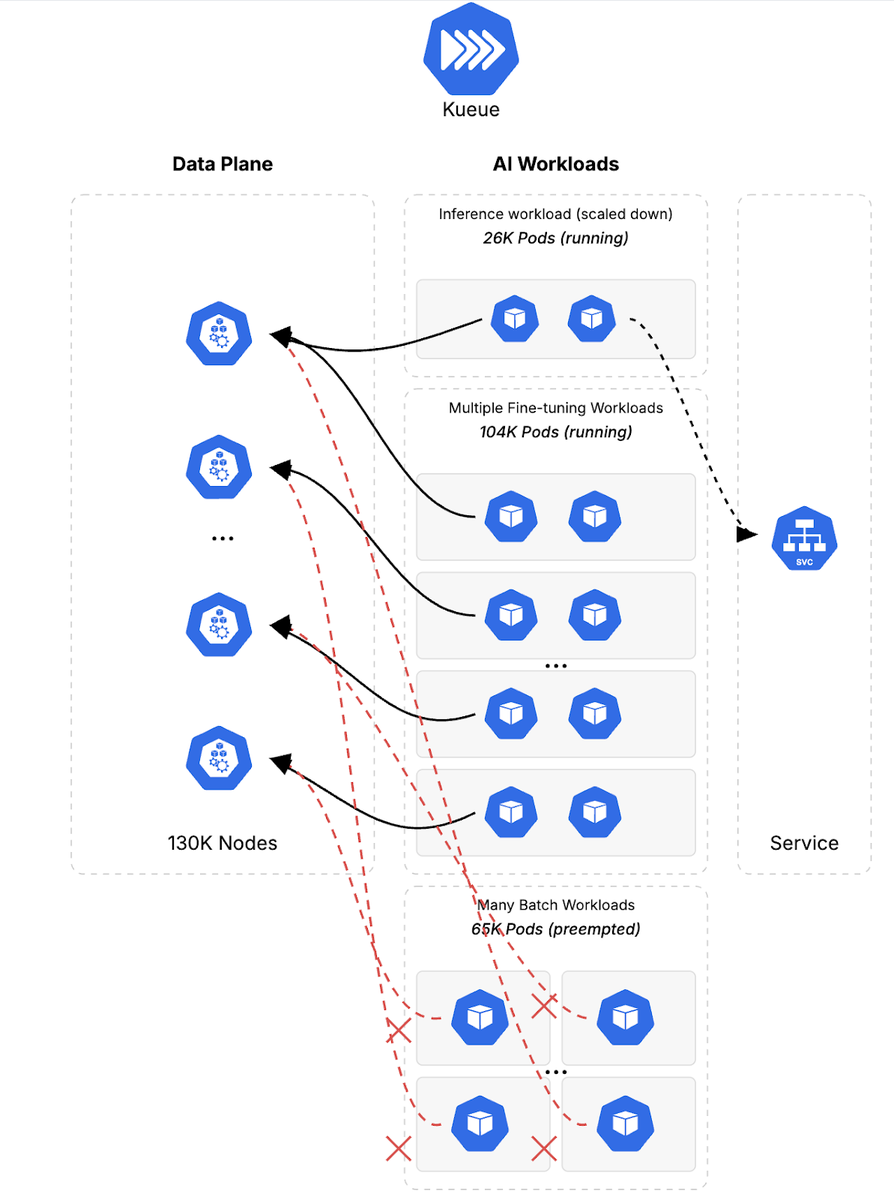

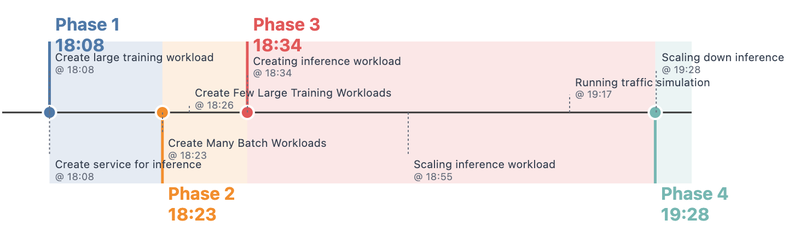

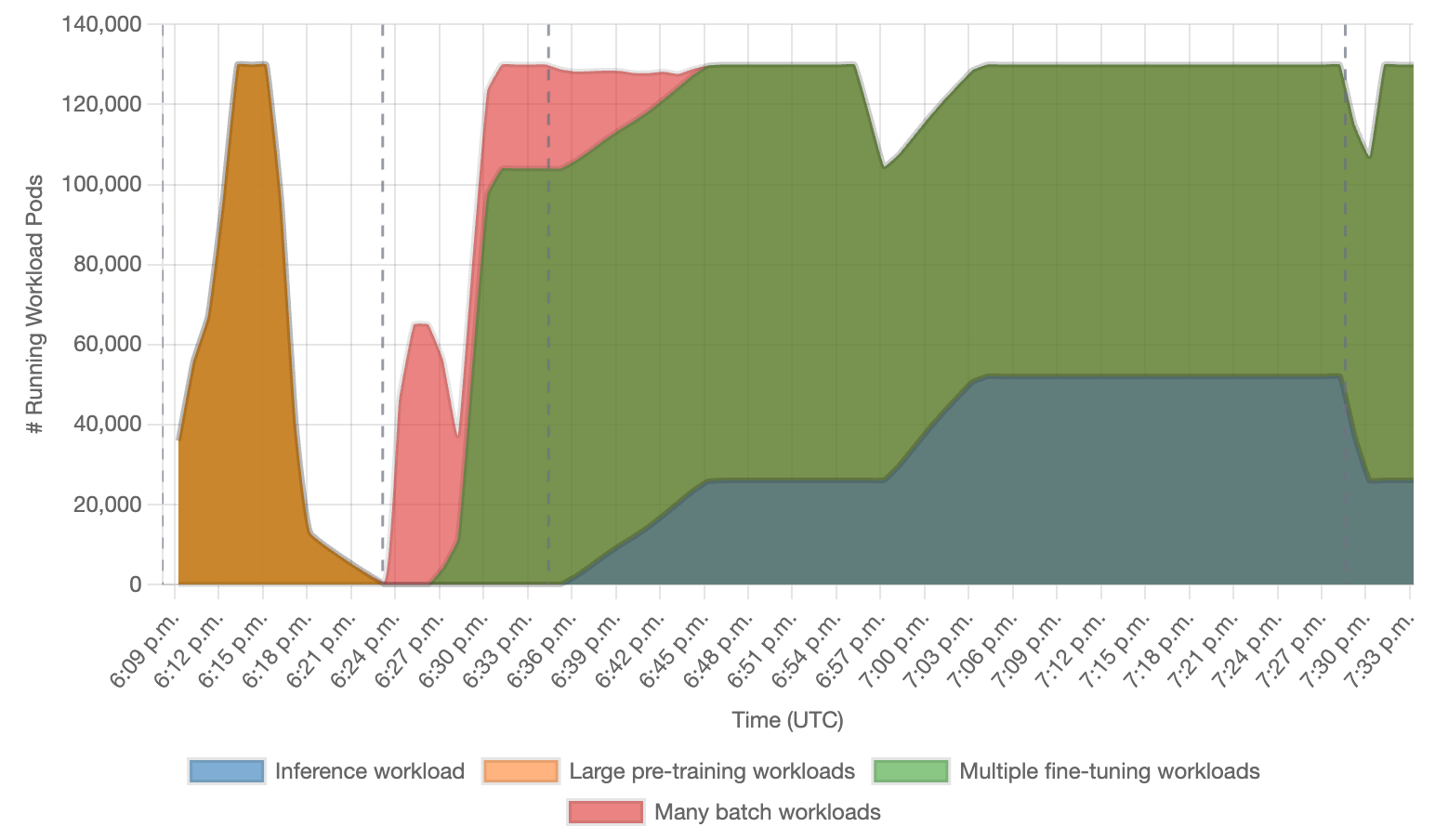

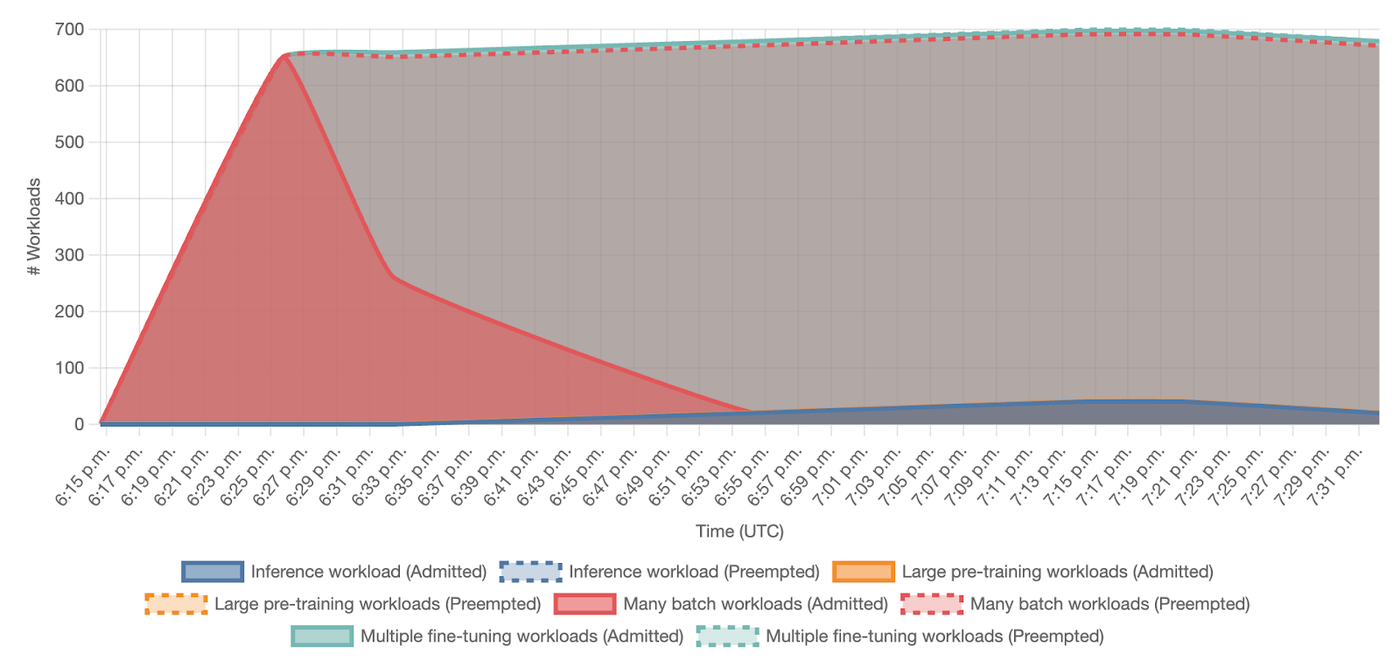

실제로 130,000 노드 규모의 클러스터를 벤치마킹하는 과정은 흡사 AI 플랫폼의 ‘하루 일과’와 같았습니다. 주요 단계를 보면:

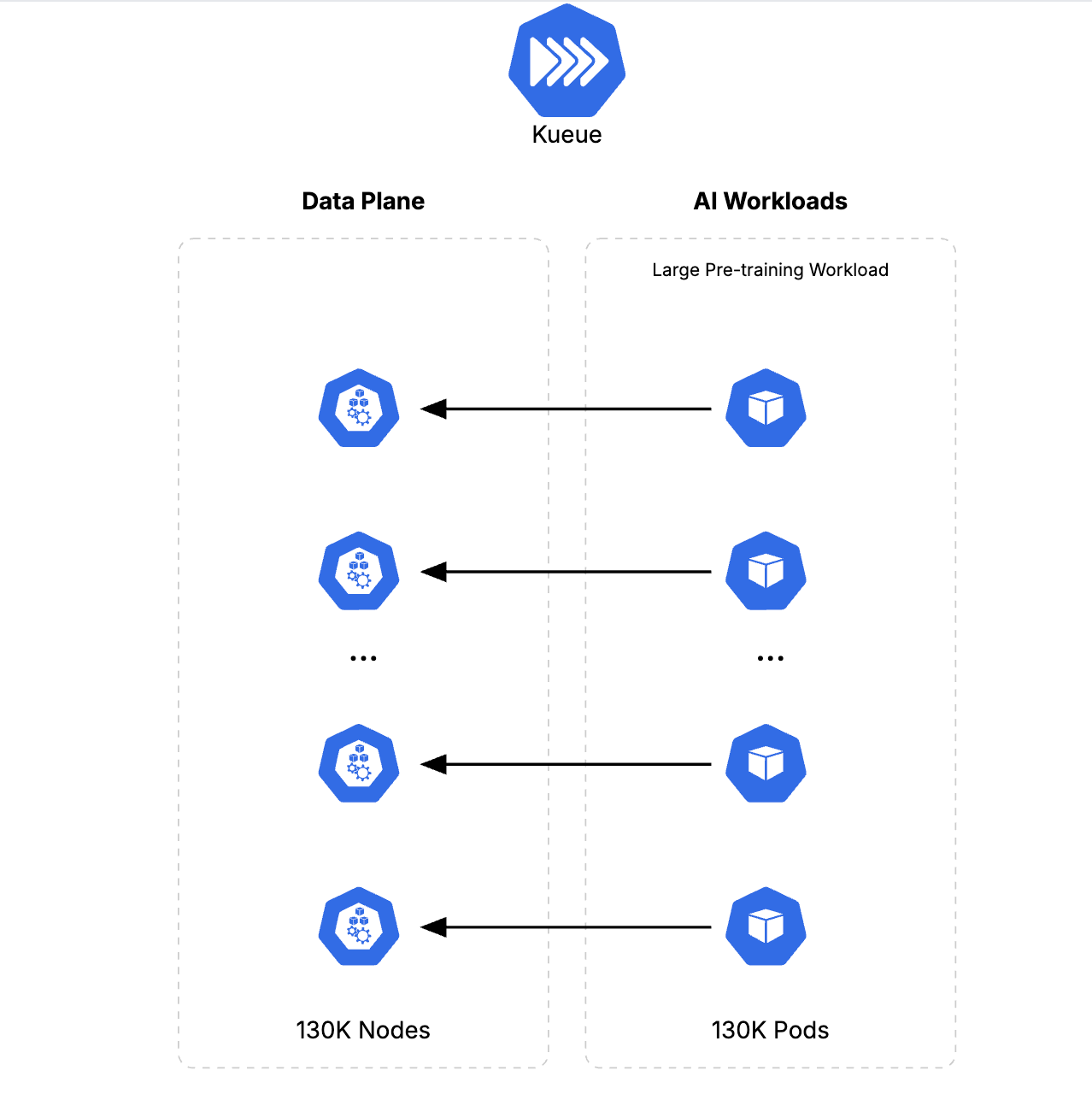

1단계: 중간 우선순위의 트레이닝 작업 13만 파드 동시 배치

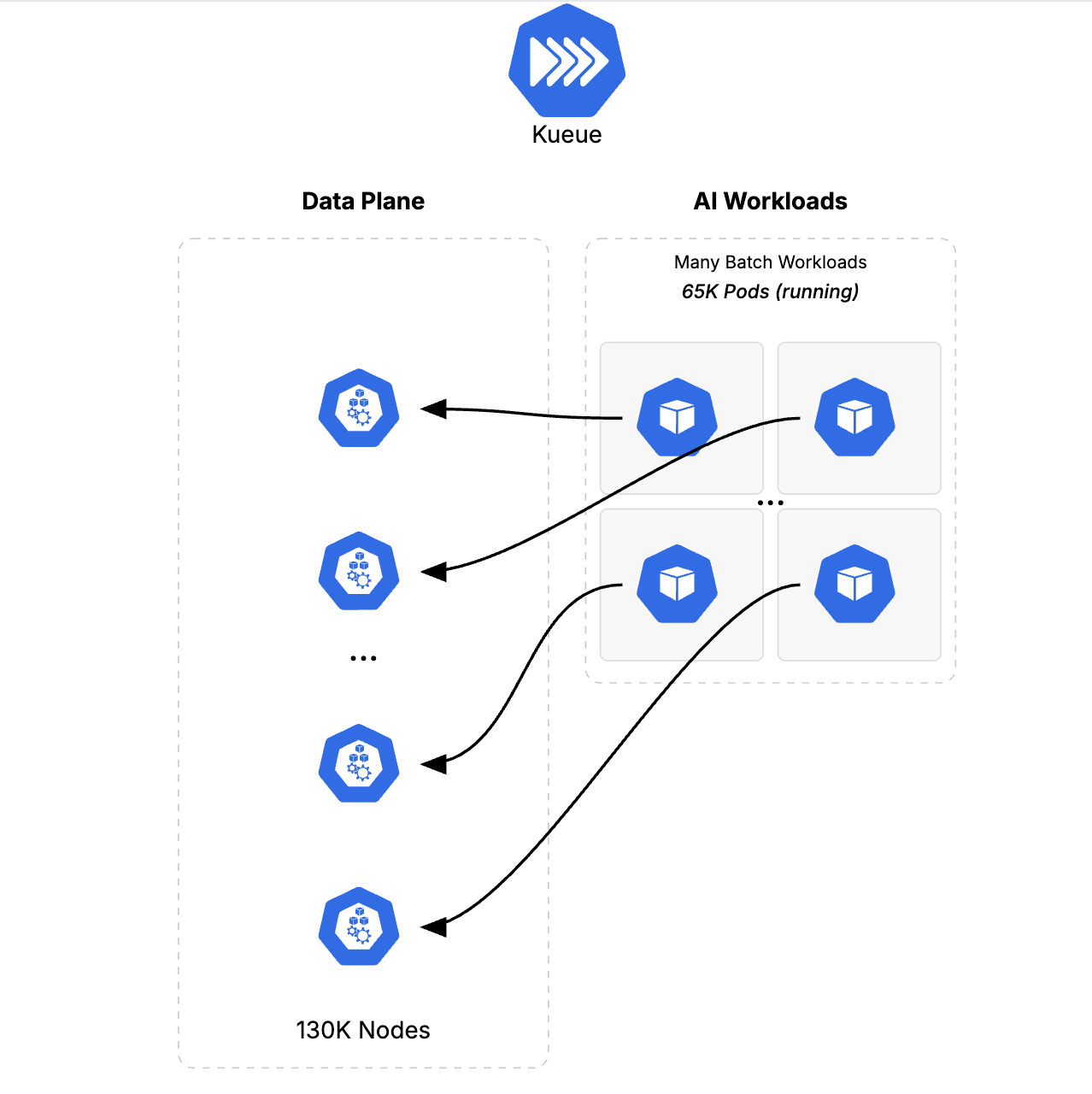

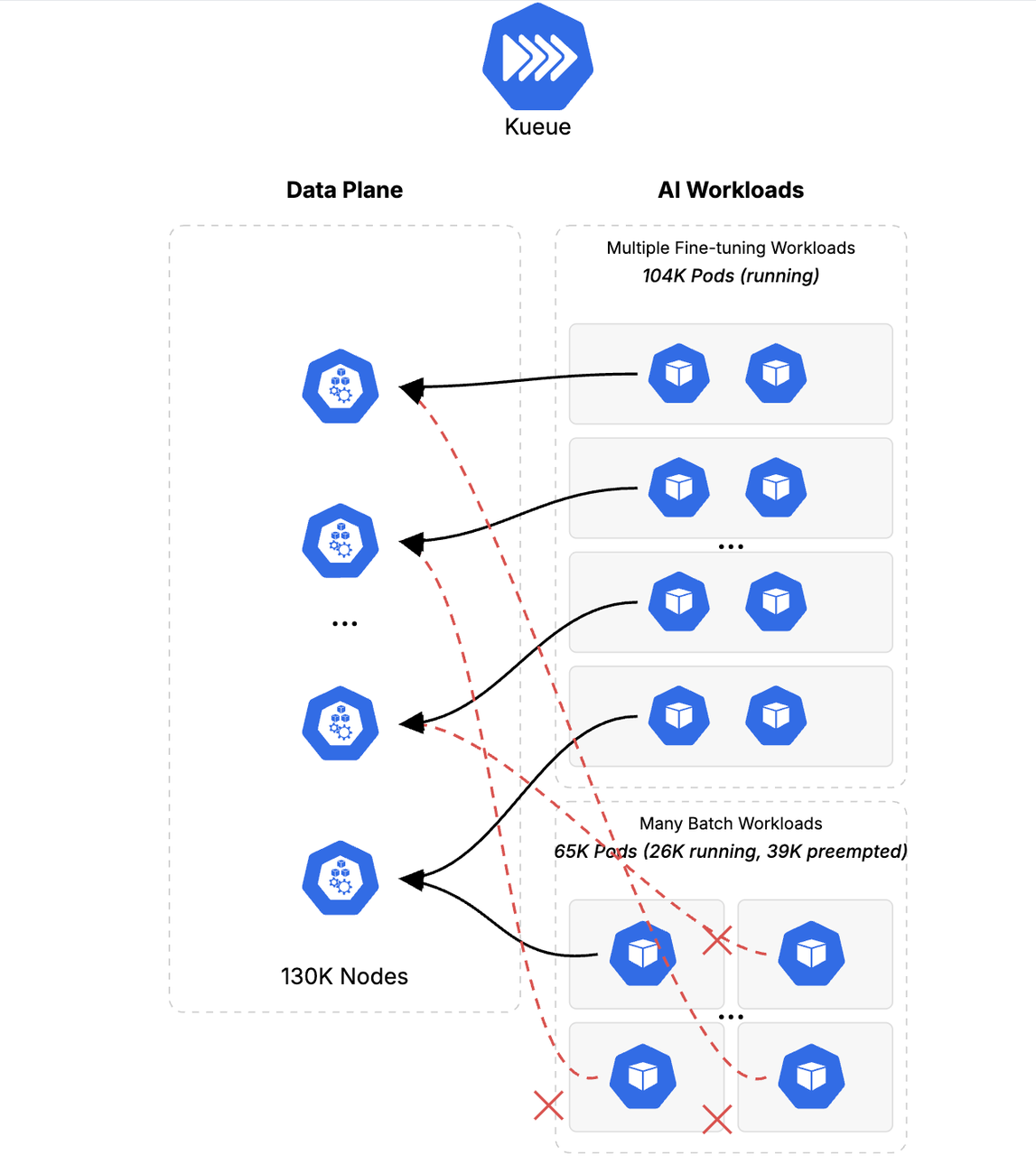

2단계: 저우선순위 배치 작업(데이터 준비 등) 65,000 파드 → 8개 대형 트레이닝(104,000 파드) 추가/전환

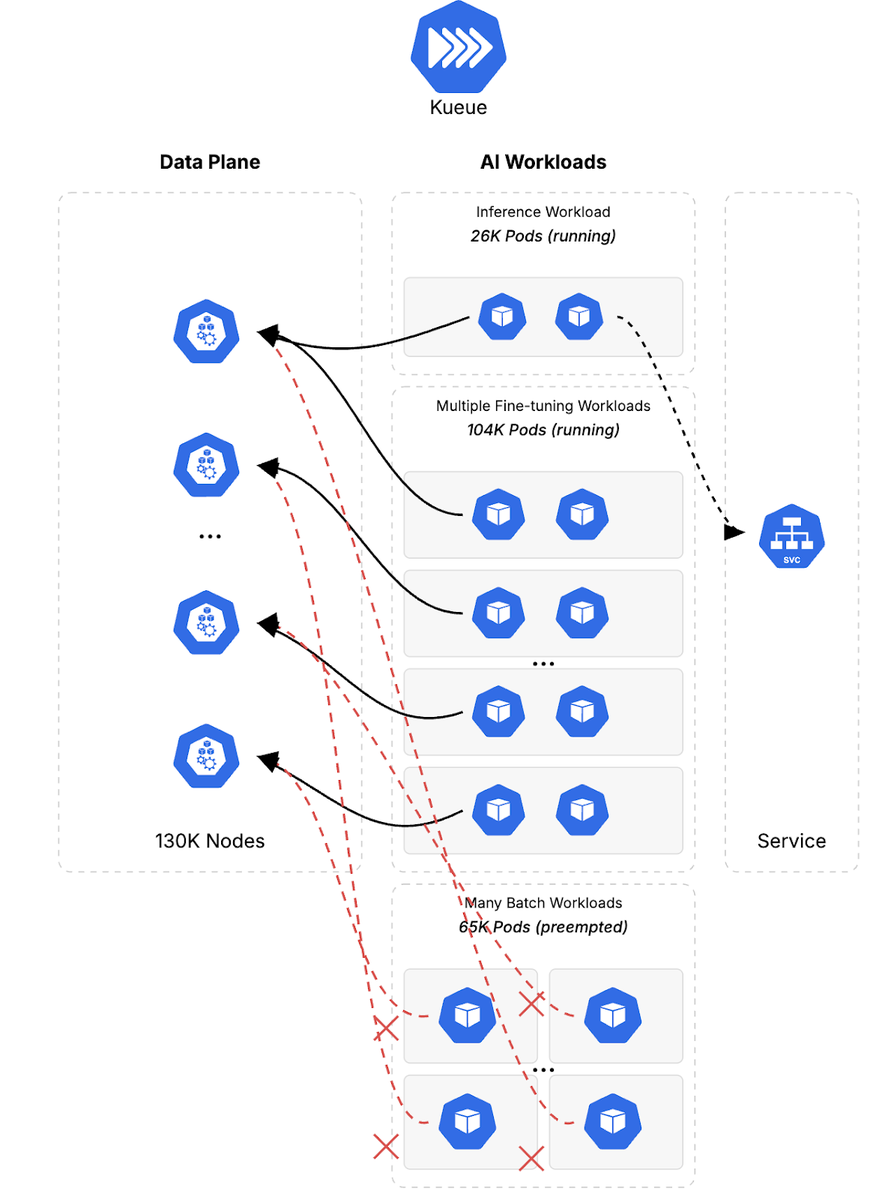

3단계: 실시간 추론 서비스 26,000→52,000 파드로 스케일 업

4단계: 추론 파드 50% 축소 → 남은 리소스로 다시 트레이닝 작업 재투입

이 모든 흐름은 우선순위 변화와 트래픽 급등에도 놀라울 정도로 빠르고 안정적으로 운영됐습니다.

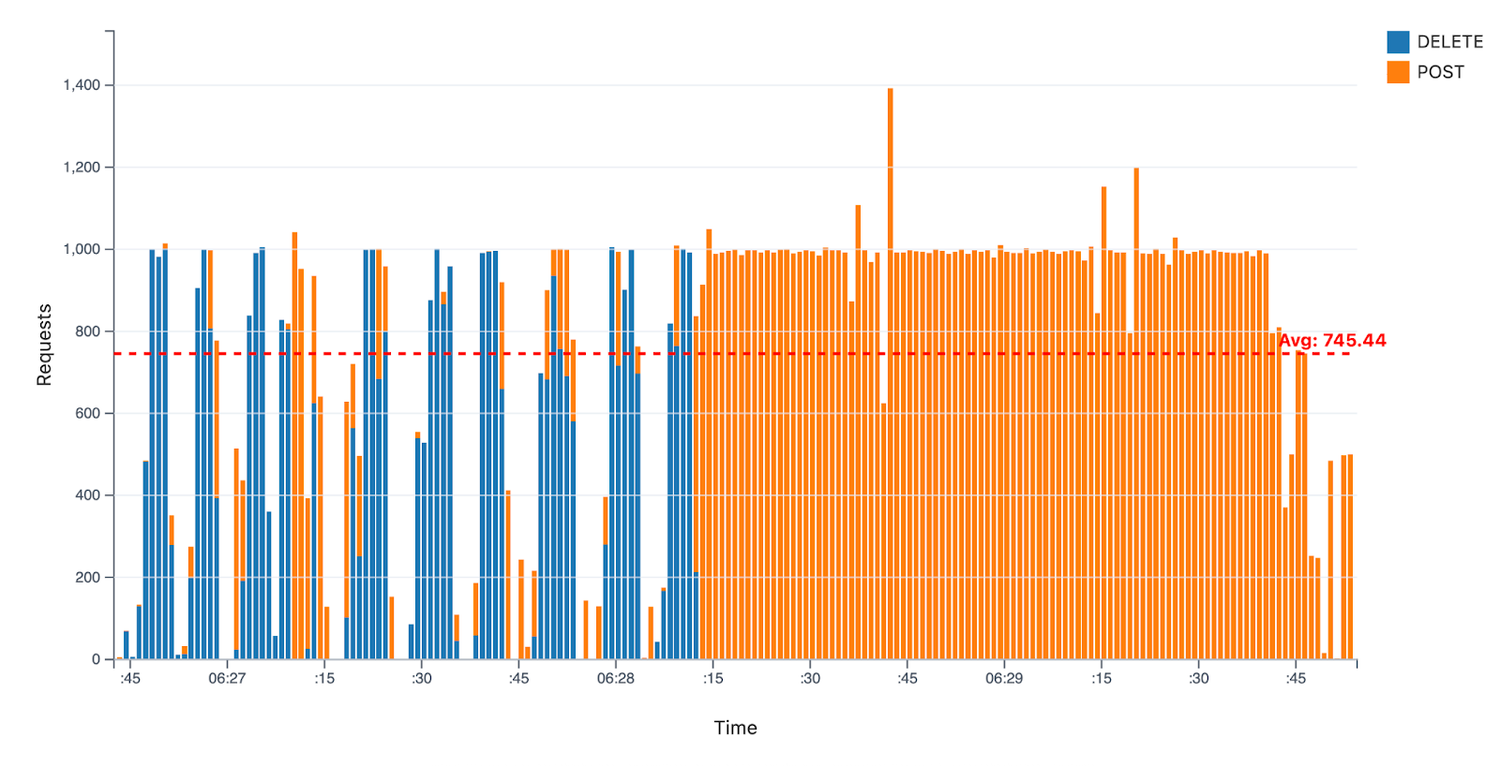

이미지 출처: googleapis

이미지 출처: googleapis

6. 실험 결과: 진짜 현장에서 쓸 만한지 확인된 ‘탄력성’과 ‘속도’

클러스터가 3분 40초 만에 13만 파드를 띄우고, 초당 약 1,000개의 파드 생성·삭제가 지속적으로 이뤄졌습니다. 우선순위 변경에 따라 수만 개 파드가 90초 만에 전환됐고, 서비스 응답시간(P99 기준)이 10초 내외로 안정적으로 유지됐습니다.

이미지 출처: googleapis

이미지 출처: googleapis  이미지 출처: googleapis

이미지 출처: googleapis

이런 수준의 탄력성(Elasticity)과 속도, 그리고 안정성은 앞으로 점점 더 커질 AI 인프라의 필수 요건이 될 것입니다.

7. 무엇이 달라졌나: 모든 규모의 클러스터에 돌아오는 혜택

13만 노드 클러스터 실험은 단지 극한의 상황을 위한 것이 아니라, 수십~수백 노드만 쓰는 일반적인 사용자의 시스템에도 여러 혜택을 줍니다.

시스템 오류나 남용 대응력 강화

컨트롤러·API 서버의 속도 개선

자원 우선순위·탄력적 재배치 등 실서비스에 바로 적용

“AI가 인프라를 바꾼다”는 구체적인 예시가 바로 이런 부분입니다.

마무리: AI·인공지능 시대, 인프라의 상상력도 함께 커진다

구글의 13만 노드 Kubernetes 클러스터 실험은 단지 숫자 맞추기 경쟁이 아니라, AI 시대의 인프라 구조가 어떻게 진화해야 할지를 직접 보여준 사례입니다.

대형 AI 모델을 운영하는 환경뿐 아니라, 작고 단순한 클러스터조차도 더 빠르고, 더 탄력적으로, 그리고 더 유연하게 동작하는 혁신의 수혜자가 되고 있습니다.

향후 인공지능·머신러닝 워크로드나 대용량 컴퓨팅을 고민하는 개발자, 엔지니어, 그리고 의사 결정자라면, 구글의 이런 실험들이 실제로 어떤 식으로 서비스와 비용 효율, 그리고 운영 안정성을 바꿀 수 있을지 꼭 눈여겨봐야 할 것입니다.

참고

[1] How we built a 130,000-node GKE cluster | Google Cloud Blog - Google Cloud

[2] Google's 130,000-Node Kubernetes Colossus: Engineering the Future of AI-Scale Computing - WebProNews

[3] GCP - How Google Does It: Building the largest known Kubernetes cluster, with 130,000 nodes - Cloud bites from the grill - CloudSteak