Humanity's Last Exam 종합 노트

개요

Humanity’s Last Exam(HLE)는 다양한 학문 분야의 2,500개 고난도 문항으로 구성된 대규모 언어모델(LLM) 벤치마크로, 기존 지표의 포화 문제를 넘어 최신 모델의 실제 역량을 정밀하게 측정하려는 시도다124. Center for AI Safety(CAIS)와 Scale AI가 공동으로 설계·운영했으며, 폐쇄형 정답 체계와 자동 채점을 채택해 평가 비용을 낮추면서도 난도를 유지한다12.

HLE는 단순 지식 회상보다 깊은 추론과 최신 전문 지식의 정확성을 함께 평가하도록 설계되었다. 초기 공개 시점의 관측으로는 상위권 모델조차 낮은 정답률과 높은 과신(오조준) 경향을 보였는데, 이는 환각(confabulation) 문제를 계량적으로 드러낸다는 점에서 연구적 의미가 크다1. 2025년 4월 기준 데이터셋이 2,500문항으로 정식 확정되었으며, 동년 10월에는 지속 업데이트 분기(rolling) 데이터셋이 추가 공개되었다13.

배경과 목적

벤치마크 포화는 LLM 평가의 대표적 난제로, MMLU·GPQA 같은 과거 최전선 지표에서 인간수준 또는 그 이상의 성적이 관찰되며 더 이상 분별력이 떨어지는 문제가 제기되었다. HLE는 이 공백을 메우기 위해 “AI에게 사실상 마지막 종합 학술고사”라는 기획 의도로 출발했다1. 저자진과 운영진은 다학제 난도, 멀티모달 과제, 자동 채점 가능성, 오염(훈련 데이터 누수) 방지, 통계적 유의미성 중심의 순위 산정 등 운영 기법 전반을 함께 설계해, 장기적으로 신뢰 가능한 진척도 측정을 목표로 한다124.

데이터셋 구성과 설계

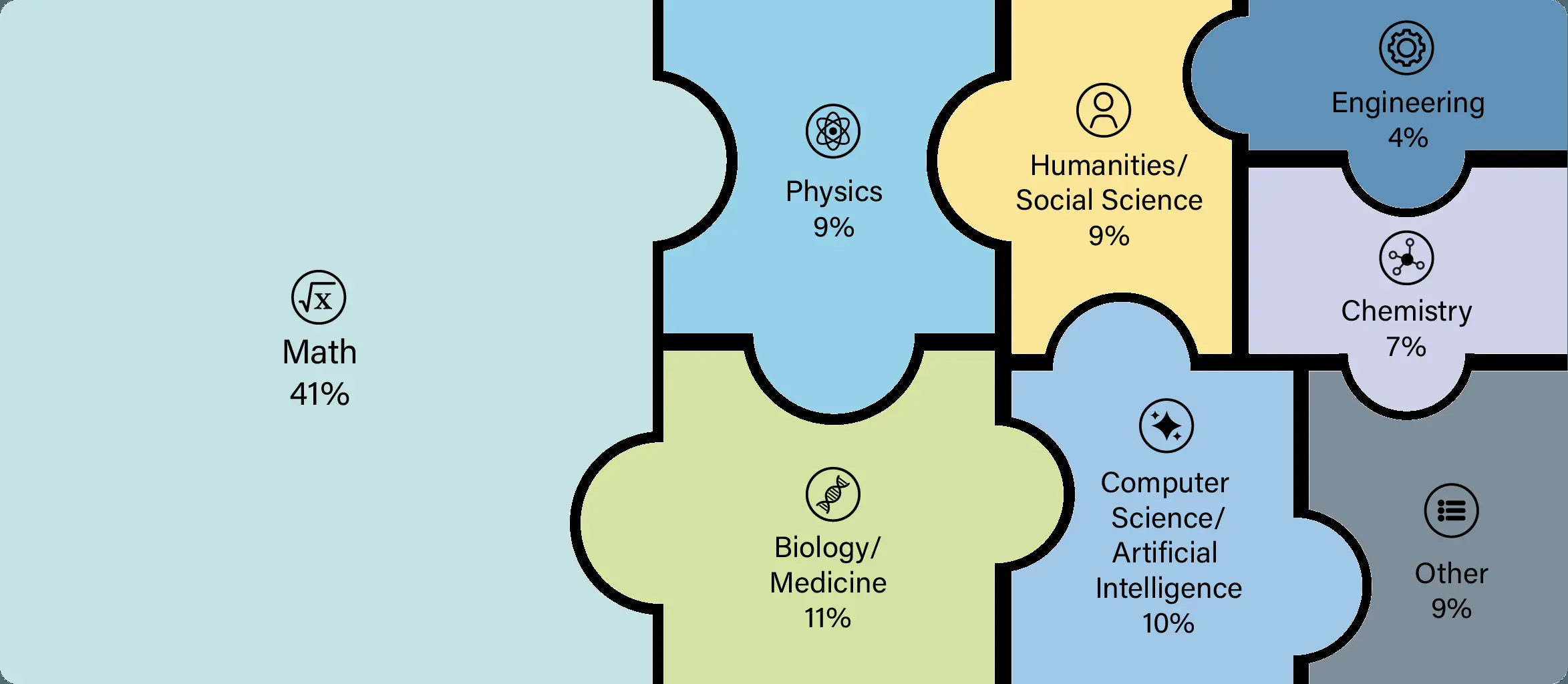

HLE는 수학·자연과학·인문사회 등 수십 개 세부 학문을 포괄한다. 전체 문항 중 약 14%는 도표·그림 해석이 필요한 멀티모달 문제이며, 약 24%는 객관식 포맷을 채택한다. 이런 배치는 폭넓은 배경지식과 시각 이해, 정밀 추론을 동시에 요구하도록 설계된 결과다1.

질문은 전 세계 약 1,000명의 주제 전문가(교수·연구자·대학원생 중심)로부터 공모·심사를 거쳐 선발되었다. 7만여 건 투고 중 약 1.3만 건이 1차 난도 기준(여러 LLM이 우연수준 이하로만 맞히거나, 정확매치형에서 광범위하게 실패)을 통과했고, 이후 전문 심사와 재가공을 통해 2,700문항 공개본과 동등 난도의 비공개본이 구성되었다. 이후 커뮤니티 버그바운티, 웹검색으로 쉽게 찾아지는 문항 제거 등 정제 과정을 거쳐 2,500문항으로 최종 확정되었다1.

평가 방법론과 지표

HLE는 폐쇄형 정답을 채택하고, 모델 출력에서 최종답과 신뢰도(자기신뢰 추정)를 구조화해 자동 채점한다. 채점 보조에는 사소한 모호성(허용 오차, 표현 차이 등)을 다루기 위한 추출·판정 도구가 사용된다. 리더보드는 정확도를 기본 지표로 하되, 모델의 평균 자신감과 실제 정확도의 괴리를 측정하는 RMS calibration error를 병행 보고해 과신 문제를 드러낸다. 초기 관측에서 “정확도 한 자릿수(10% 미만)인데도 자신감은 높아” 캘리브레이션 오류가 80% 이상으로 크게 나타나는 경향이 보고되었다1.

순위 산정은 통계적 유의미성 기반이다. 각 모델에 대해 95% 신뢰구간의 하한-상한을 비교해, 한 모델의 하한이 다른 모델의 상한을 초과하면 “통계적으로 유의하게 더 우수”로 간주한다. 어떤 모델보다 유의하게 나은 모델 수에 1을 더해 순위를 매기므로, 원점수 미세 차이보다 실제 차이가 확인되는 “그룹화된” 순위가 제시된다1.

오염 방지와 비공개 세트

HLE는 훈련 데이터 오염과 벤치마크 ‘해킹’ 우려에 대응하기 위해, 공개 세트와 동급 난도의 비공개 세트를 함께 운용한다. 공개 세트로 과적합이 의심될 경우 비공개 세트로 추가 점검이 가능하며, 검색도구가 있을 때만 정답률이 급상승하는 질문은 수작업 감사를 거쳐 제거되었다. 이는 실제 추론력과 최신 지식 이해를 더 정직하게 측정하려는 절차적 장치다1.

최신 동향과 릴리스

2025년 4월 3일, HLE는 2,500문항으로 “정식 확정(finalized)”되었다. 이어 10월 8일에는 지속 업데이트되는 동적 포크 “cais/hle-rolling”이 공개되어, 데이터셋의 신선도와 난도 유지 문제를 장기적으로 관리하려는 시도가 진행 중이다13. 또한 arXiv 논문은 2025년 1월 최초 공개 이후 개정판이 반영되며 세부 방법과 결과, 설계 의도를 문서화하고 있다2.

의의와 한계

HLE에서의 고정확도는 “최신, 폐쇄형 전문 지식”에 대한 모델의 능력이 전문가급에 도달했음을 시사할 수 있다. 다만 논문과 리더보드는 HLE 고득점이 곧바로 자율 연구 능력이나 일반지능(AGI)을 의미하는 것은 아님을 명확히 선을 긋는다. HLE는 어디까지나 폐쇄형 문제 풀이 중심의 측정 도구로, 개방형 탐구, 장기 계획, 실험 설계 같은 능력은 별도의 평가지가 요구된다1. 또한 판정 보조 모델·프롬프트의 미세한 차이에 따른 경계 사례는 존재할 수 있으므로, 재현가능한 평가 설정(온도, 추출 프롬프트, 허용 오차 등)의 문서화가 중요하다12.

활용 방법과 접근성

연구자와 개발자는 공개 데이터셋을 내려받아 자체 모델을 평가하고, 리더보드 기준과 동일한 설정을 맞춰 점수를 비교할 수 있다. Hugging Face의 공식 데이터셋 및 rolling 버전을 통해 손쉽게 접근 가능하며, 공개 웹 포털과 리더보드는 변경·정정 이력과 운영 공지를 지속 제공한다13. 아래 예시는 파이썬에서 데이터셋을 불러오는 기본 형태다3.

# 예시: Hugging Face Datasets에서 HLE 로드

from datasets import load_dataset

ds = load_dataset("cais/hle")비공개 세트는 과적합 점검을 위한 주기적 평가에 사용되며, 공개 세트 성능만으로 과도한 일반화 해석을 경계하는 장치로 기능한다1.

제작·운영 주체

HLE는 Center for AI Safety와 Scale AI의 파트너십으로 기획·운영되었고, 방대한 국제 공동 기여자 네트워크가 문항을 제출·개선했다. 상금형 공모 구조는 다양한 분야의 고품질 문항 유입을 촉진했으며, 전문 심사·감사 체계는 난도와 명확성, 검색 용이성 배제를 보증하는 핵심 메커니즘으로 작동했다1234.

참고

1Humanity's Last Exam -- Scale AI Leaderboard - https://scale.com/leaderboard/humanitys_last_exam

2Humanity's Last Exam (arXiv:2501.14249) - https://arxiv.org/abs/2501.14249

3Humanity's Last Exam -- CAIS/Scale AI 포털 - https://agi.safe.ai/

4Humanity's Last Exam - Wikipedia - https://en.wikipedia.org/wiki/Humanity%27s_Last_Exam