GitHub Models로 무료 LLM API 사용법 및 토큰 발급 가이드

github models 란?

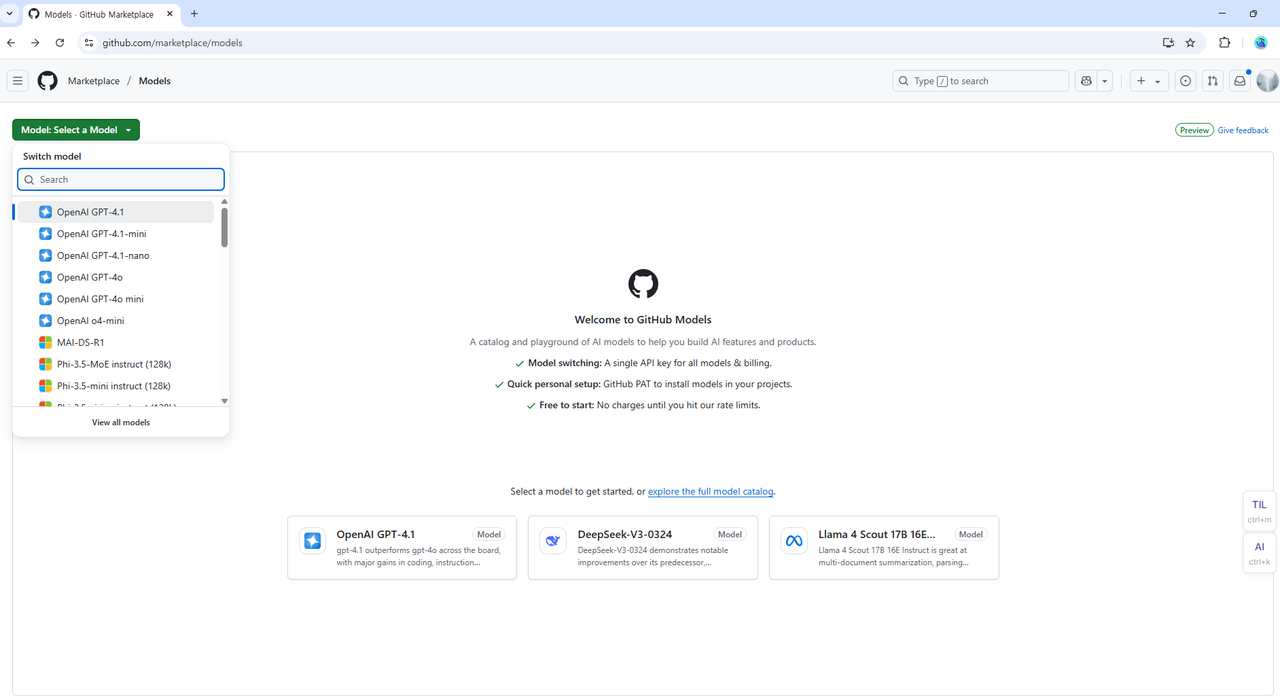

Github 에서 GPT, DeepSeek 같은 LLM 모델을 사용할 수 있게 제공해 주는 서비스입니다. 무려 무료 사용량을 제공하여 LLM 을 편리하게 사용해 볼 수 있습니다.

https://github.com/marketplace/models

위의 주소에 가시면 다양한 모델을 사용해 보실 수 있습니다.

사용법

LLM은 API 를 통해 사용합니다. API 는 외부에서 서비스를 사용할 수 있게 해주는 시스템입니다. API 키가 있으면 Github Models 로 요청을 보내서 사용할 수 있는 셈이지요. 이 API 키가 있으면 make, n8n, 코드 등 여러 외부 환경에서 LLM을 활용할 수 있습니다.

기억해 주세요. LLM 은 채팅에서만 활용할 수 있게 만들어진 것이 아닙니다. 다양한 환경에서 AI 를 활용할 수 있습니다.

저는 GPT 4.1 Model 을 사용해 보겠습니다. 위의 플레이그라운드에서 모델을 선택하고 Code 를 선택하면 코드를 볼 수 있습니다. 아래는 javascript 코드입니다.

import OpenAI from "openai";

const token = process.env["GITHUB_TOKEN"];

const endpoint = "https://models.github.ai/inference";

const model = "openai/gpt-4.1";

export async function main() {

const client = new OpenAI({ baseURL: endpoint, apiKey: token });

const response = await client.chat.completions.create({

messages: [

{ role:"system", content: "" },

{ role:"user", content: "What is the capital of France?" }

],

temperature: 1,

top_p: 1,

model: model

});

console.log(response.choices[0].message.content);

}

main().catch((err) => {

console.error("The sample encountered an error:", err);

});위에서 보시면 token 에 process.env["GITHUB_TOKEN"] 을 사용하는 것을 보실 수 있으시죠? 이것이 API 키입니다. 깃허브 토큰을 받아서 API 키로 사용할 수 있는 것이지요! openai 패키지도 그대로 사용할 수 있습니다.

Github PAT (Personal Access Token) 발급받기

Fine-grained PAT 발급받기 (보안 강화 버전)

GitHub에 로그인한 후, 우측 상단의 프로필 아이콘을 클릭하고 Settings를 선택합니다.

좌측 사이드바 맨 아래쪽에 있는 Developer settings를 클릭합니다.

Personal access tokens > Fine-grained tokens를 선택합니다.

Generate new token을 클릭합니다.

토큰 기본 설정:

Token name: 토큰의 이름 (예: "GitHub Models Token")

Expiration: 만료 기간

Description: 선택사항

Repository access:

Public Repositories (read-only) 선택 (GitHub Models는 공개 리소스)

Permissions:

Repository permissions는 설정하지 않아도 됩니다

Account permissions에서 "Models" 찾기

Models: Read 권한 선택 (중요!)

Generate token을 클릭하고 토큰을 안전하게 보관합니다. 토큰은 절대 외부에 노출하지 마세요.

환경변수 설정하기

토큰을 코드에 직접 넣는 것은 보안상 위험합니다. 환경변수로 설정하는 방법을 알아봅시다.

Windows

bash 는 powershell 과 같은 터미널 환경을 말합니다.

set GITHUB_TOKEN=your_token_hereMac/Linux

bash

export GITHUB_TOKEN=your_token_here.env 파일 사용하기 (추천)

프로젝트 루트에 .env 파일을 만들고:

GITHUB_TOKEN=your_token_here.gitignore에 .env 추가하는 것을 잊지 마세요!

그리고 코드에서 dotenv 패키지를 사용:

javascript

import dotenv from 'dotenv';

dotenv.config();

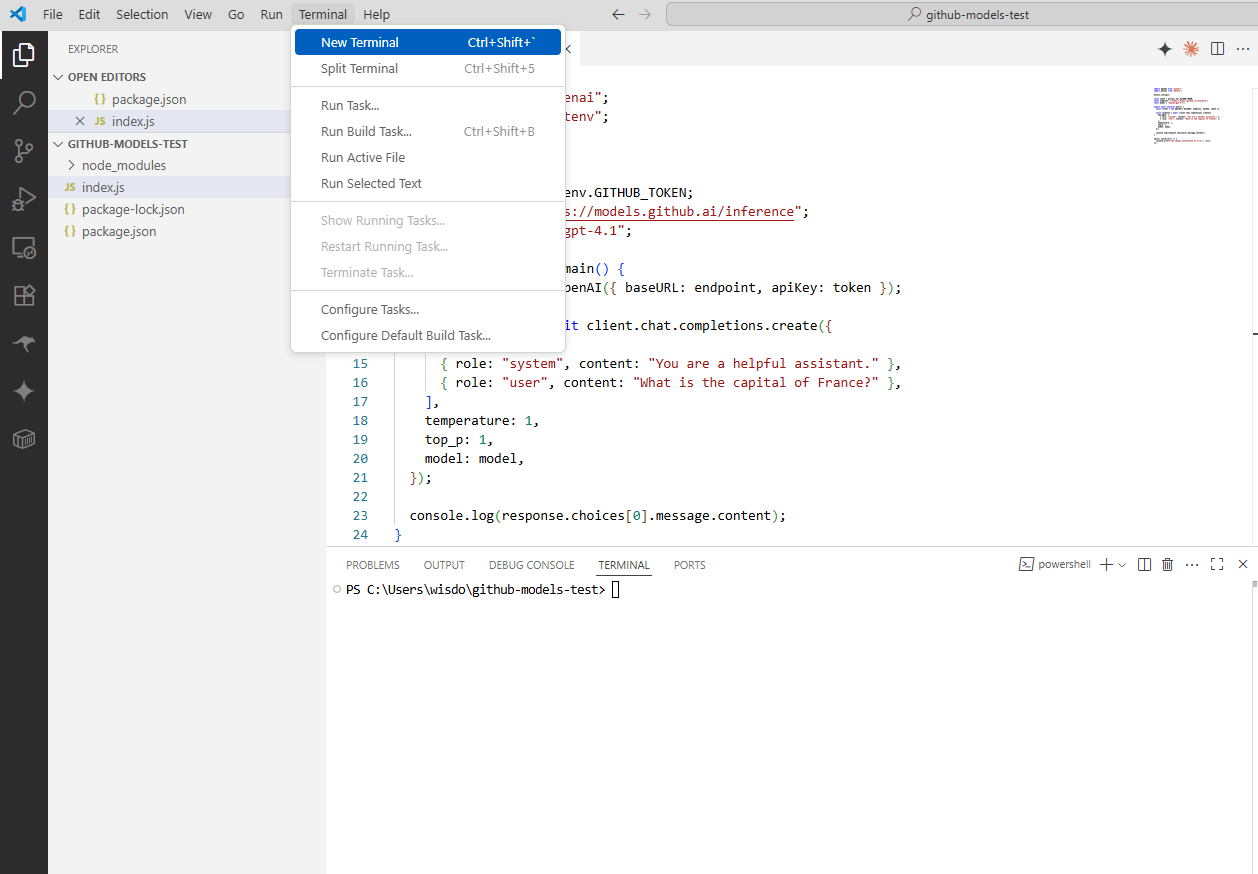

const token = process.env.GITHUB_TOKEN;프로젝트 설정 및 실행

새 프로젝트 폴더를 만들고 초기화합니다:

bash

mkdir github-models-test

cd github-models-test

npm init -y필요한 패키지를 설치합니다:

bash

npm install openai dotenvpackage.json에 type을 추가합니다 (ES6 모듈 사용을 위해):

vscode 를 열어 package.json 파일을 확인하여 수정합니다.

{

"type": "module",

// ... 기타 설정

}index.js파일을 만들고 코드를 작성합니다:

javascript

import OpenAI from "openai";

import dotenv from "dotenv";

dotenv.config();

const token = process.env.GITHUB_TOKEN;

const endpoint = "https://models.github.ai/inference";

const model = "openai/gpt-4.1";

export async function main() {

const client = new OpenAI({ baseURL: endpoint, apiKey: token });

const response = await client.chat.completions.create({

messages: [

{ role: "system", content: "You are a helpful assistant." },

{ role: "user", content: "What is the capital of France?" }

],

temperature: 1,

top_p: 1,

model: model

});

console.log(response.choices[0].message.content);

}

main().catch((err) => {

console.error("The sample encountered an error:", err);

});위에서 .env 파일 사용하기 을 보고 .env 파일을 만들고 키를 추가합니다.

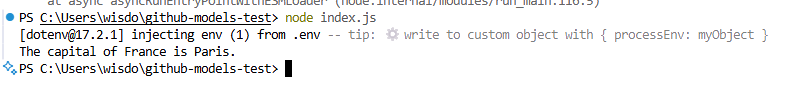

GITHUB_TOKEN=your_token_here터미널 환경에서 실행합니다:

bass

node index.js

완성!

다음에 시간이 되면 n8n 에서 사용하는 부분도 포스팅 해보겠습니다.

무료 사용량

GitHub Models 요금제별 사용 제한

Low 등급 모델

| 제한 항목 | Copilot Free | Copilot Pro | Copilot Business | Copilot Enterprise |

|---|---|---|---|---|

| 분당 요청 수 | 15 | 15 | 15 | 20 |

| 일일 요청 수 | 150 | 150 | 300 | 450 |

| 요청당 토큰 수 | 입력 8,000 출력 4,000 | 입력 8,000 출력 4,000 | 입력 8,000 출력 4,000 | 입력 8,000 출력 8,000 |

| 동시 요청 수 | 5 | 5 | 5 | 8 |

High 등급 모델

| 제한 항목 | Copilot Free | Copilot Pro | Copilot Business | Copilot Enterprise |

|---|---|---|---|---|

| 분당 요청 수 | 10 | 10 | 10 | 15 |

| 일일 요청 수 | 50 | 50 | 100 | 150 |

| 요청당 토큰 수 | 입력 8,000 출력 4,000 | 입력 8,000 출력 4,000 | 입력 8,000 출력 4,000 | 입력 16,000 출력 8,000 |

| 동시 요청 수 | 2 | 2 | 2 | 4 |

Embedding 모델

| 제한 항목 | Copilot Free | Copilot Pro | Copilot Business | Copilot Enterprise |

|---|---|---|---|---|

| 분당 요청 수 | 15 | 15 | 15 | 20 |

| 일일 요청 수 | 150 | 150 | 300 | 450 |

| 요청당 토큰 수 | 64,000 | 64,000 | 64,000 | 64,000 |

| 동시 요청 수 | 5 | 5 | 5 | 8 |

Azure OpenAI o1-preview

| 제한 항목 | Copilot Free | Copilot Pro | Copilot Business | Copilot Enterprise |

|---|---|---|---|---|

| 분당 요청 수 | 사용 불가 | 1 | 2 | 2 |

| 일일 요청 수 | 사용 불가 | 8 | 10 | 12 |

| 요청당 토큰 수 | 사용 불가 | 입력 4,000 출력 4,000 | 입력 4,000 출력 4,000 | 입력 4,000 출력 8,000 |

| 동시 요청 수 | 사용 불가 | 1 | 1 | 1 |

Azure OpenAI o1 및 o3

| 제한 항목 | Copilot Free | Copilot Pro | Copilot Business | Copilot Enterprise |

|---|---|---|---|---|

| 분당 요청 수 | 사용 불가 | 1 | 2 | 2 |

| 일일 요청 수 | 사용 불가 | 8 | 10 | 12 |

| 요청당 토큰 수 | 사용 불가 | 입력 4,000 출력 4,000 | 입력 4,000 출력 4,000 | 입력 4,000 출력 8,000 |

| 동시 요청 수 | 사용 불가 | 1 | 1 | 1 |

Azure OpenAI o1-mini, o3-mini, o4-mini

| 제한 항목 | Copilot Free | Copilot Pro | Copilot Business | Copilot Enterprise |

|---|---|---|---|---|

| 분당 요청 수 | 사용 불가 | 2 | 3 | 3 |

| 일일 요청 수 | 사용 불가 | 12 | 15 | 20 |

| 요청당 토큰 수 | 사용 불가 | 입력 4,000 출력 4,000 | 입력 4,000 출력 4,000 | 입력 4,000 출력 4,000 |

| 동시 요청 수 | 사용 불가 | 1 | 1 | 1 |

DeepSeek-R1, DeepSeek-R1-0528, MAI-DS-R1

| 제한 항목 | Copilot Free | Copilot Pro | Copilot Business | Copilot Enterprise |

|---|---|---|---|---|

| 분당 요청 수 | 1 | 1 | 2 | 2 |

| 일일 요청 수 | 8 | 8 | 10 | 12 |

| 요청당 토큰 수 | 입력 4,000 출력 4,000 | 입력 4,000 출력 4,000 | 입력 4,000 출력 4,000 | 입력 4,000 출력 4,000 |

| 동시 요청 수 | 1 | 1 | 1 | 1 |

xAI Grok-3

| 제한 항목 | Copilot Free | Copilot Pro | Copilot Business | Copilot Enterprise |

|---|---|---|---|---|

| 분당 요청 수 | 1 | 1 | 2 | 2 |

| 일일 요청 수 | 15 | 15 | 20 | 30 |

| 요청당 토큰 수 | 입력 4,000 출력 4,000 | 입력 4,000 출력 4,000 | 입력 4,000 출력 8,000 | 입력 4,000 출력 16,000 |

| 동시 요청 수 | 1 | 1 | 1 | 1 |

xAI Grok-3-Mini

| 제한 항목 | Copilot Free | Copilot Pro | Copilot Business | Copilot Enterprise |

|---|---|---|---|---|

| 분당 요청 수 | 2 | 2 | 3 | 3 |

| 일일 요청 수 | 30 | 30 | 40 | 50 |

| 요청당 토큰 수 | 입력 4,000 출력 8,000 | 입력 4,000 출력 8,000 | 입력 4,000 출력 12,000 | 입력 4,000 출력 12,000 |

| 동시 요청 수 | 1 | 1 | 1 | 1 |

참고: 이 제한 사항은 사전 통지 없이 변경될 수 있습니다.