로컬 컴퓨터 검색 시스템 구축 시도 (2)

며칠 동안 다양한 시도를 했고 또한 실패도 했습니다.

그러면서 배운 점이 있기에 남겨 봅니다.

LLM은 가능하다고 하지만 꼭 가능하진 않다

예를 들어 저는 일종의 AI 활용 윈도우 탐색기를 만들고 싶었던 건데, 처음 프롬프트를 잘 못 넣어서인지 엉뚱한 방향으로 프로젝트가 진행되더군요. 그게 옳은 방향이 아니었다는 것을 어제 개발자 지인을 만나 대화하다 알게 됐습니다.

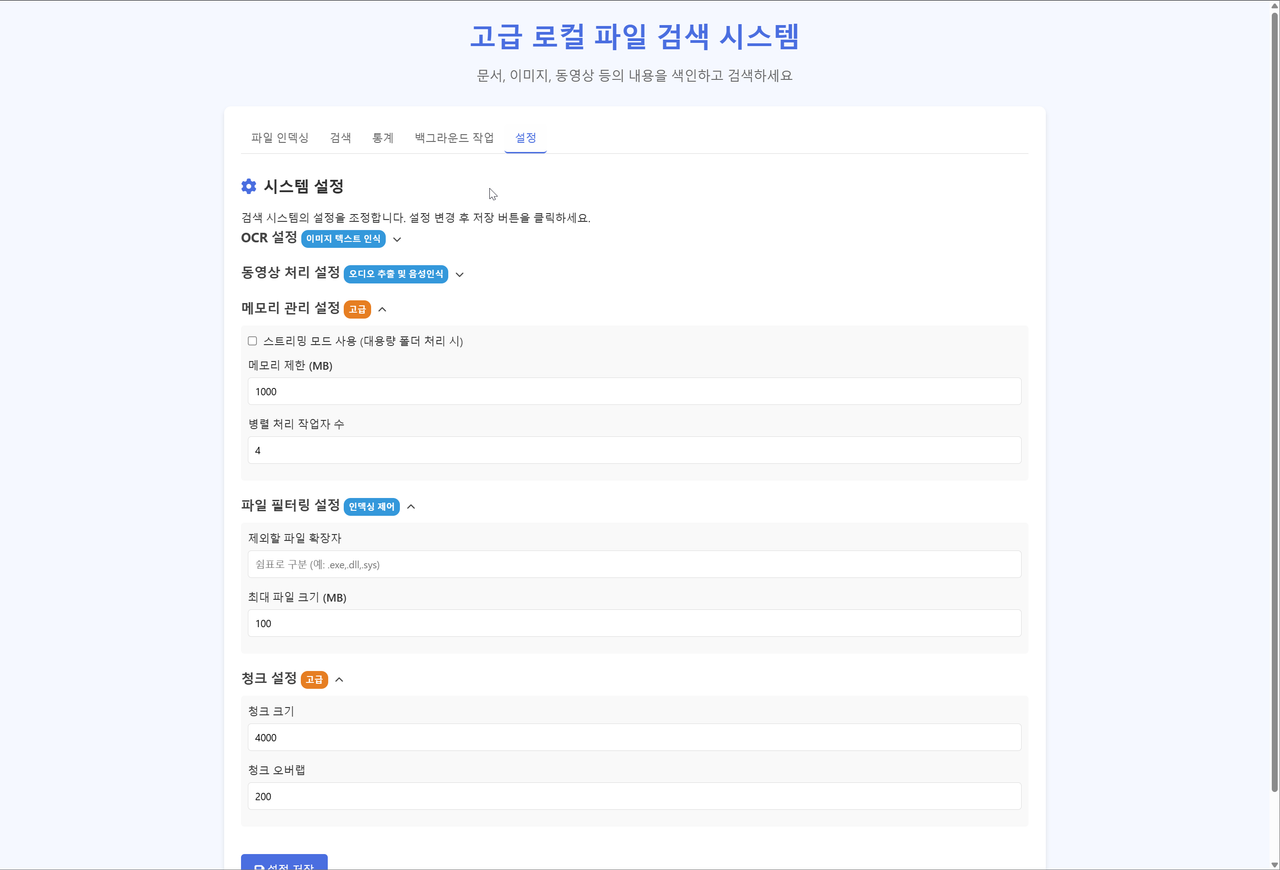

*지금은 똥이되어 버린 시스템 화면

구조적 사고가 중요하다

처음부터 어떤 준비 사항이 필요하고, 어떤 기술들을 활용할 수 있고, 어떠한 구조로 만들 수 있는지 고민하고 이를 정리해서 프롬프트를 작성하고 만들기 시작했다면, 조금 더 나은 결과를 만들 수 있지 않았을까 생각합니다.

Q. AI를 활용한 윈도우 탐색기를 만들려면 어떻게 구성하고 설계해야 할까?

AI 파일 탐색기 설계 및 구현 가이드

실제로 AI 파일 탐색기를 개발하려면 다음과 같은 구성과 설계 요소를 고려해야 합니다:

1. 시스템 아키텍처

전체 구조

프론트엔드: 사용자 인터페이스 (웹 또는 데스크톱 앱)

백엔드: 파일 시스템 관리 및 API 서비스

AI 서비스: 자연어 처리, 이미지 인식, 콘텐츠 분석 등

데이터베이스: 메타데이터, 사용자 설정, 학습 데이터 저장

기술 스택 제안

프론트엔드: React/Next.js, Electron(데스크톱용)

백엔드: Node.js/Express, Python/FastAPI, .NET Core

AI 서비스: TensorFlow/PyTorch, Hugging Face Transformers

데이터베이스: MongoDB(메타데이터), PostgreSQL(관계형 데이터)

2. 핵심 기능 구현 방법

파일 시스템 통합

운영체제 파일 시스템 API와 연동 (Windows API, POSIX 등)

클라우드 스토리지 통합 (Google Drive, Dropbox 등의 API)

파일 이벤트 감지 및 인덱싱 시스템 구축

AI 기능 구현

자연어 처리: 파일 검색 및 명령어 해석을 위한 NLP 모델 (BERT, GPT 등)

이미지 분석: 사진, 문서 스캔 등의 콘텐츠 인식 (Vision Transformers, ResNet 등)

문서 이해: PDF, 워드 문서 등의 내용 분석 (LangChain, LlamaIndex 등의 RAG 시스템)

사용자 행동 학습: 사용 패턴 분석 및 추천 모델 (머신러닝 알고리즘)

데이터 모델링

파일 메타데이터: 파일명, 경로, 크기, 생성/수정 시간, 파일 유형

콘텐츠 메타데이터: 추출된 키워드, 요약, 분류 태그

사용자 상호작용 데이터: 파일 접근 빈도, 관련 파일 그룹, 작업 컨텍스트

3. 개발 접근법

1단계: 기본 파일 탐색기 개발

파일 시스템 연동 및 기본 UI 구현

파일 메타데이터 인덱싱 시스템 구축

2단계: AI 기능 통합

텍스트 검색 및 자연어 명령 처리

콘텐츠 기반 파일 분류 및 태깅

사용자 행동 패턴 분석 시스템

3단계: 고급 기능 개발

실시간 파일 추천 시스템

문서 내용 자동 요약 및 관계 분석

멀티모달 검색 (텍스트, 이미지, 오디오)

4. 기술적 고려사항

확장성

마이크로서비스 아키텍처로 AI 서비스 분리

비동기 작업 처리를 위한 메시지 큐 시스템 (RabbitMQ, Kafka)

분산 파일 인덱싱 시스템

성능

대용량 파일 인덱스 처리를 위한 최적화

AI 모델 경량화 및 캐싱 전략

점진적 인덱싱 및 백그라운드 처리

보안

파일 접근 권한 관리

민감 정보 처리 정책

로컬 처리 vs 클라우드 처리 전략

5. 배포 및 지속적 개선

배포 옵션

데스크톱 애플리케이션 (Electron)

웹 애플리케이션 (클라우드 서비스 연동)

하이브리드 접근법 (로컬 에이전트 + 웹 인터페이스)

사용자 피드백 루프

사용 패턴 분석을 통한 AI 모델 개선

A/B 테스트 시스템

사용자 피드백 수집 메커니즘

[이상 Claude 답변]

더 많은 준비가 필요하다

아마 시간적 여유가 있다면 ChatGPT의 가이드에 따라 진행할텐데, 이 프로젝트를 진행하려면 그래픽 카드도 사야하고, 시간도 오래 걸릴 것 같더군요. 다음에 진행해 보는 것으로 하고 리서치 결과를 남겨 봅니다.

Q. AI를 활용한 윈도우 탐색기를 만들 수 있을까? 이런 기능들이 들어가면 좋겠어.

파일 분류 및 조직화 - AI가 파일 내용, 메타데이터, 사용 패턴 등을 분석하여 자동으로 파일을 분류하고 정리합니다.

지능형 검색 - 단순 키워드가 아닌 자연어 질의를 통해 파일을 찾을 수 있습니다. (예: "지난주 마케팅 회의 관련 문서 찾아줘")

콘텐츠 요약 - 문서, 이미지, 비디오 등의 콘텐츠를 미리보기로 자동 요약해줍니다.

사용자 행동 예측 - 사용자의 작업 패턴을 학습하여 자주 사용하는, 또는 필요할 것 같은 파일을 추천합니다.

자동 태깅 및 추천 - 이미지나 문서의 내용을 분석해 자동으로 태그를 붙이고, 사용자의 파일 사용 패턴을 학습하여 자주 사용하는 파일이나 폴더를 추천하는 기능을 구현할 수 있습니다.

어떻게 구성하고 설계해야 할까? 또한 어떤 성능의 컴퓨터가 필요할까? 개인 사용용이고 처음 인덱싱 이후는 수동 트리거 방식도 괜찮아. 모든 기능을 로컬 PC에서 실행하돼 Gemini api, openAI api는 붙여도 돼. 개발 언어나 플랫폼은 무엇이든 괜찮아.

[이하 딥 리서치 결과]AI 기반 개인용 파일 탐색기 설계 및 요구사항

AI 기능이 포함된 파일 탐색기 시스템 아키텍처 예시. 파일 크롤러/인덱싱 모듈이 로컬 디스크의 파일을 분석하여 인덱스 DB에 저장하고, NLP/비전 모델로부터 추출된 태그·요약 등의 메타데이터를 함께 저장한다. 검색/추천 모듈은 자연어 쿼리를 해석하고 인덱스를 조회하며, 사용자 행동 로그를 기반으로 추천을 제공한다. 사용자는 AI 탐색기 UI에서 자연어로 파일을 검색하거나 요약 미리보기를 요청할 수 있다.

주요 구성 요소 및 전체 시스템 구조

개인 PC에서 로컬로 동작하는 AI 파일 탐색기를 설계하기 위해, 다음과 같은 핵심 컴포넌트로 구성된 아키텍처를 제안한다:

파일 인덱싱 모듈: 지정한 폴더나 드라이브를 수동 트리거로 스캔하여 파일 목록을 구축한다. 각 파일의 내용, 메타데이터(예: 작성일, 크기)를 추출하고, 필요한 경우 파일 형식에 맞게 파싱한다. 텍스트 문서는 전문(全文)을 추출하고, 이미지·영상은 썸네일이나 대표 프레임 및 임베딩 벡터를 생성한다. 이 단계에서 Python의

os모듈이나 .NET의 File API로 파일을 순회하고, Apache Tika 같은 도구를 활용하여 PDF, 오피스 문서 등의 본문 텍스트를 얻을 수 있다. 인덱싱 모듈은 향후 빠른 검색을 위해 이 데이터를 인덱스 DB에 저장한다. 초기 인덱싱은 데이터 양에 따라 시간이 오래 걸릴 수 있으므로, 최초 설치 시 사용자 확인 후 밤시간 등에 수행하거나 폴더별로 단계적으로 진행할 수 있다.AI 분석 모듈: 파일 내용에 대한 심층 분석과 태깅을 수행한다. 인덱싱된 텍스트는 NLP 모델을 통해 주요 키워드 추출, 주제 분류, 요약 생성 등을 미리 해둘 수 있다. 예를 들어 한 PDF 보고서를 인덱싱할 때, 미리 핵심 내용을 요약해 두면 사용자가 미리보기 할 때 즉시 제공할 수 있다. 이미지와 영상은 컴퓨터 비전 모델을 사용하여 자동 태그를 생성한다. 예를 들어 사진에서 인물, 배경 장소, 물체 등을 식별하여

"인물", "바다", "해질녘"같은 태그를 달거나, 이미지 임베딩을 생성해 유사 이미지 검색에 대비한다

. 영상의 경우 키 프레임 추출 및 간략 설명(예: 장면 전환 기반)이나, 만약 영상에 음성이 있다면 Whisper 모델 등을 이용해 자막 추출 후 요약할 수 있다. 이러한 AI 분석은 Python 기반으로 구현할 경우, Hugging Face의 Transformers 라이브러리를 이용한 요약 모델(예: BART, T5)이나 토픽 분류 모델, spaCy를 통한 개체명 인식 등을 활용하고, 이미지 태깅에는 YOLO(객체 인식)나 CLIP 임베딩 모델 등을 사용할 수 있다. 분류/태깅 결과는 파일의 메타데이터로 저장되어 이후 검색 및 추천에 활용된다

.

검색 및 추천 엔진: 사용자의 자연어 검색 쿼리를 처리하고 관련 결과를 찾아주는 모듈이다. 사용자가 탐색기 UI에 "지난주 작업한 공룡 관련 문서 찾아줘"와 같이 입력하면, 시스템은 해당 문구를 이해하여 날짜 필터(지난주)와 주제 필터(공룡)에 해당하는 파일을 찾는다

. 이를 위해 벡터 임베딩 기반의 시맨틱 검색과 전통적인 키워드 검색을 모두 활용한다. 검색 인덱스 DB는 앞서 구축한 전문(全文) 인덱스와 태그 메타데이터를 포함하며, 여기에 벡터 검색 인덱스(예: FAISS나 Annoy 라이브러리)도 구축되어, 쿼리를 임베딩한 후 코사인 유사도 등으로 의미적으로 가까운 문서나 이미지를 찾는다

. 예를 들어 "프로젝트 예산 보고서"라고 검색하면, 파일명에 "예산"이 없어도 내용에 예산 관련 표나 금액이 언급된 보고서를 찾아준다. 자연어 쿼리 해석을 위해 경량 NLP모델을 사용해 쿼리에서 시간, 주제, 파일 유형 등을 파싱하거나, OpenAI GPT-4나 Google Gemini API에 쿼리를 전달해 의도를 분석할 수도 있다. 검색 결과는 관련도 순으로 정렬되고, 각 결과에는 미리 생성된 요약이나 미리보기 정보를 함께 표시하여 사용자의 판단을 돕는다. 또한 이 모듈은 사용자 행동 예측(추천) 기능도 포함하는데, 예를 들어 사용 패턴 분석기가 "매주 월요일 오전에 지난주 작업 폴더를 열었다"는 것을 학습했다면, 월요일 아침에 해당 폴더를 바로 제안하거나, 현재 작업 중인 파일들과 관련된 다른 문서를 추천해줄 수 있다. 이러한 추천은 사용자의 파일 열람 빈도, 열었던 순서 등을 지속적으로 기록/학습하여 구현하며, 협업필터링처럼 복잡하지는 않지만 Markov Chain이나 간단한 머신러닝 분류로 "다음에 열 파일"을 예측하는 식이다. 사용 패턴 데이터는 인덱스 DB의 메타데이터(예: last_access_time, access_count 등)로도 업데이트되어 검색 결과 정렬에 반영된다.

사용자 인터페이스 (UI): 이것은 최종 사용자와 상호작용하는 파일 탐색기 애플리케이션이다. Windows 탐색기와 유사한 형태로 파일/폴더 계층을 보여주면서, 상단에 자연어 검색창과 필터 옵션을 제공한다. 사용자는 키워드뿐 아니라 일상 언어로 질의할 수 있고, 결과를 클릭하면 오른쪽 패널 등에 요약 미리보기(텍스트일 경우 핵심 요약 문단, 이미지일 경우 자동 생성된 캡션 등)를 볼 수 있다. UI는 .NET (WPF/WinUI)으로 구현해 Windows에 통합하거나, Electron/웹기술로 데스크톱 앱을 만들어도 된다. 중요한 것은 로컬 PC에서 모든 기능이 동작하도록 하여 네트워크 불필요시에도 작동하고, API를 사용할 경우에도 사용자 동의하에 제한적으로 동작하도록 하는 것이다

. 예를 들어, 사용자가 대용량 PDF 100개를 한꺼번에 요약하려 하면 로컬 모델로는 시간이 오래 걸릴 수 있으므로 OpenAI API를 활용할 옵션을 주되, 개인정보나 민감 데이터는 클라우드로 보내지 않도록 안내하고 선택하게 하는 식이다

. UI에는 스마트 컬렉션 기능을 넣어 자동 그룹화된 가상 폴더들을 제공할 수 있다 (예: "인물 사진 모음", "프로젝트별 문서", "최근 1달내 생성 파일" 등). 이러한 자동 분류는 앞서 태깅된 메타데이터를 활용하여 생성되며, Shade와 같은 AI 탐색기 앱에서도 오토태그 및 스마트 컬렉션 기능을 제공하고 있다

.

위와 같은 구성 요소들이 모듈화되어 상호작용함으로써 전체 시스템이 동작한다. 인덱싱/AI분석 모듈은 보통 백그라운드 서비스로 실행되어 사용자 작업을 방해하지 않고 주기적 또는 수동으로 트리거되며, 검색/추천 모듈은 사용자의 질의 시 실시간으로 인덱스를 조회하고 결과를 반환한다. 모든 데이터는 로컬 인덱스 DB (예: SQLite 또는 Lucene 기반 엔진)에 저장되므로 인터넷이 끊겨도 조회 가능하며, API를 쓰지 않는 한 모든 처리가 로컬에서 일어난다. 이처럼 사생활 보호가 기본인 설계는 사용자가 안심하고 개인 파일에 AI 기능을 적용해볼 수 있게 해준다

.

주요 기술 스택 추천

이 프로젝트에 적합한 기술 스택을 각각의 기능별로 정리하면 다음과 같다:

프로그래밍 언어 & 플랫폼: Windows 데스크톱 애플리케이션이므로 C#/.NET으로 UI와 로컬 DB, 일부 ML통합을 구현하거나, Python으로 백엔드 처리를 하고 Electron 또는 PyQt 등으로 UI를 구현하는 방법이 있다. 언어 제한이 없으므로 개발 편의와 목표 성능에 따라 선택하면 된다. Python은 풍부한 AI 라이브러리로 백엔드 분석에 유리하고, C#은 Windows와의 통합(UI, Shell 확장 등)에 유리하다. 하이브리드 접근으로, Python 백엔드를 서버처럼 두고 C#이나 Electron UI가 IPC/HTTP로 통신하는 구조도 가능하다.

파일 파싱 및 데이터베이스: 다양한 형식의 파일에서 내용을 추출하기 위해 Apache Tika

(Java 기반이지만 CLI/REST로 사용)나, Python의

pdfplumber/PyPDF2(PDF),python-docx(Word),openpyxl(Excel) 등 개별 라이브러리를 활용한다. 이미지 미리보기는 Pillow로 썸네일 생성, 영상은 OpenCV 혹은ffmpeg로 프레임 추출이 가능하다. 추출한 내용과 메타데이터를 저장하는 인덱스 DB로는 SQLite (FTS5) 엔진을 사용하여 가볍게 구현하거나, 문서량이 많다면 Elasticsearch/OpenSearch를 로컬에 설치하여 전문 검색, 필터링 기능을 활용할 수 있다. 다만 Elasticsearch 계열은 메모리 사용이 크므로 개인용으로는 Whoosh (pure Python 검색엔진)나 Lucene.NET처럼 가벼운 옵션이 더 적합하다. 구조화된 메타데이터(파일 경로, 태그, 길이 등)는 SQLite 또는 작은 NoSQL DB (e.g., TinyDB)에 저장하고, 전문 색인은 검색엔진이 담당하는 식으로 구성해도 된다.자연어 처리 (NLP): 문서 내용 요약에는 사전 훈련된 요약 모델이 필요하다. Hugging Face Transformers의

pipeline('summarization')을 통해 BART, Pegasus, T5 모델 등을 사용할 수 있다. 혹은 OpenAI GPT-4 API에 문서 텍스트를 보내 요약을 생성하는 방법도 있다. 단, API 사용 시 비용과 개인정보 이슈를 고려해야 한다. 파일 주제 분류에는 BERT나 Sentence-Transformers 기반의 토픽 임베딩을 생성하고, 미리 정의한 카테고리별 대표 벡터와 비교하여 분류하거나, 간단한 Naive Bayes 분류기를 훈련해 쓸 수도 있다. 키워드 추출은 rake-nltk나 KeyBERT 등을 활용한다. 문서 임베딩은 검색 시 의미 기반 매칭에 활용되므로, 예를 들어 SentenceTransformer의'all-MiniLM-L6-v2'같이 경량 모델로 문서당 384차원 임베딩 벡터를 얻어 FAISS 등에 넣어두면 좋다. 자연어 쿼리 처리도 이와 동일한 임베딩 공간에서 이루어지며, 추가로 날짜 표현 파싱에는dateparser라이브러리 등이 도움된다.컴퓨터 비전 (CV): 이미지 및 동영상 처리를 위해 PyTorch나 TensorFlow 환경에서 동작하는 사전훈련 모델을 활용한다. 이미지 내용 태깅에는 COCO 데이터셋으로 학습된 YOLOv5 모델을 써서 수십 종의 객체를 탐지하고 태그로 활용하거나, Image Captioning 모델인 BLIP를 사용해 한 문장 설명을 생성할 수 있다. 예를 들어 한 여행 사진에 대해 "해변에서 사람 둘이 웃고 있음" 같은 설명을 미리 생성해 두면, 나중에

"해변에서 웃는 사진 찾아줘"같은 검색에 바로 걸릴 수 있다. OpenAI의 CLIP 모델도 유용한데, 이미지와 텍스트를 동일한 벡터 공간에 임베딩해주므로, 이미지를 벡터화해 모아두면 텍스트 쿼리를 벡터화하여 가까운 이미지들을 찾는 멀티모달 검색이 가능하다. 영상은 길이에 따라 처리가 방대해질 수 있으므로, 긴 영상의 경우 샘플 프레임 여러 개를 뽑아 각각 이미지 분석을 하고 태그를 합치거나, OCR을 돌려 화면에 나오는 텍스트(자막 등)를 추출해 두는 것도 검색에 도움이 된다. 필요에 따라 Face Recognition으로 인물별로 사진을 그룹화하거나, Scene Classification으로 이미지/영상의 장면 타입(실내/실외, 밤/낮 등)도 태깅할 수 있다.

추론 가속 및 모델 선택: 모든 AI 모델을 로컬에서 돌릴 경우, ONNX Runtime을 이용해 일부 모델을 ONNX로 변환해 CPU추론 최적화하거나, 가능하면 NVIDIA CUDA/cuDNN이 지원되는 환경에서 PyTorch GPU연산을 사용해야 성능이 나온다. 예를 들어 CLIP 임베딩 수천 개를 생성하는 작업은 GPU가 있으면 수십 배 빠르다. 반면 작은 텍스트 모델(예: MiniLM, 약 30MB)은 CPU로도 충분히 빠르게 돌릴 수 있다. 대규모 LLM(예: 수십억 파라미터)도 활용하려면, 로컬에 LLM 실행환경을 구성해야 한다. 최근에는 7억~7십억 파라미터 정도의 모델을 양자화(int4/int8)하여 CPU에서 돌리는 사례도 있다. 실제로 한 개발자는 Google의 소형 언어모델(약 20억 파라미터 Gemini 2B?)과 LLaVA-vicuna 7B 비전언어 모델을 결합하여 100% 로컬 파일 관리 AI를 구현하기도 했다

. 이처럼 로컬 실행을 위해 경량화된 모델을 선택하거나, 반대로 정확도가 더 필요하면 OpenAI GPT-4나 Google Gemini API를 호출하는 하이브리드 구성을 할 수도 있다.

캐싱 및 기타: 빈번히 사용되는 모델이나 결과는 캐싱이 필수다. 예를 들어 동일 문서를 두번째 열 때 요약을 즉시 보여주려면 최초 생성한 요약을 DB에 저장해두고, 파일 수정시만 업데이트한다. 이미지 임베딩도 한 번 생성하면 파일 해시 등을 키로 캐시하여 재사용한다. 메모리 캐싱에는 Python의

functools.lru_cache나 캐시 라이브러리, 또는 디스크 기반 캐시(DB나 단순 파일) 전략을 쓴다. 또한 대용량 파일은 인덱싱 시 스트리밍 처리가 필요하며, 인덱싱 진행도를 UI에 보여주어 사용자 경험을 높일 수 있다.컴퓨터 성능 요구사항 (하드웨어 스펙)

AI 파일 탐색기는 전통적인 탐색기에 비해 CPU, 메모리, 디스크 성능 요구가 높다. 원활한 동작을 위해 권장되는 사양은 다음과 같다:

CPU: 멀티스레드 파일 인덱싱와 ML추론을 위해 쿼드코어 이상의 프로세서가 바람직하다. 예를 들어 Intel i5/i7 이상 또는 AMD Ryzen 5/7 급의 CPU면, 백그라운드 인덱싱 중에도 다른 작업을 수행하기 수월하다. 인덱싱 프로세스는 I/O와 연산을 병렬로 수행하므로 코어 수가 많을수록 효율적이다. 작은 ML모델 추론은 CPU로도 가능하지만, 요약 모델처럼 연산이 많은 경우 CPU 1개 당 수 초~수십 초 이상 걸릴 수 있어 대기시간이 발생할 수 있다.

GPU: 가능하다면 CUDA 호환 GPU가 있으면 좋다. NVIDIA의 GTX/RTX 시리즈 (예: RTX 3060 이상의 8GB VRAM급)라면 이미지 임베딩이나 대형 모델 요약을 수배에서 수십배 가속할 수 있다. GPU가 없더라도 시스템은 동작하지만, 예를 들어 100페이지짜리 문서 50개를 처음 요약할 때 GPU가 있다면 몇 분이지만, CPU만으로는 수십 분 이상 소요될 수 있다. Gemini API나 OpenAI API를 활용하는 경우엔 로컬 GPU가 없어도 클라우드 연산으로 결과를 얻지만, 그 경우 인터넷 지연과 비용이 추가된다.

RAM: 인덱싱한 데이터와 ML모델을 모두 메모리에 올려두고 쓰는 구조라면 RAM 용량도 충분해야 한다. 16GB 이상을 권장한다. 예를 들어 7억13억 파라미터급 언어모델을 로컬 로드하면 48GB를 점유하며, 여러 개의 모델(요약용, 임베딩용 등)을 동시에 올리면 금방 수 GB가 추가된다. 또 Elasticsearch 같은 엔진을 쓰면 자체적으로 수 GB 메모리를 이용한다. 따라서 16GB는 중간 규모 작업에 여유있고, 데이터량이 아주 많거나 대형 모델 사용시 32GB까지도 고려한다. 다행히 일반 문서 텍스트 위주의 인덱스는 용량이 크지 않아, 수만 개 문서를 인덱싱해도 수백 MB~1GB 수준에서 메모리에 올릴 수 있다. 이미지 임베딩(예: 1만장 이미지에 512차원 벡터 저장시 약 80MB) 등도 부담이 크진 않다.

스토리지: SSD 사용이 필수적이다. 인덱싱 과정에서 랜덤 I/O가 많이 발생하고, 대용량 파일을 빠르게 읽어야 하므로 SSD가 없는 환경에서는 속도가 크게 저하된다. 인덱스 DB 역시 SSD 상에서 동작해야 검색 응답이 빠르다. 저장 공간 측면에서, 인덱스는 원본 데이터 크기에 비례하여 추가 공간을 사용한다. 전문 색인(인버트 인덱스)은 원본 텍스트의 30%50% 정도 공간을 차지할 수 있고, 임베딩 벡터나 썸네일 캐시 등 부가 데이터도 존재한다. 대략 원본 데이터의 10~20% 정도 여유 공간을 추가로 잡는 것을 권장한다. 예를 들어 500GB의 파일을 관리한다면 50100GB 정도는 인덱스/메타데이터용으로 필요할 수 있다. 또한 이미지 썸네일 캐시, 영상 하이라이트 이미지 등도 편의를 위해 저장되는데, 이는 사용자가 설정에서 켜고 끌 수 있게 하여 공간을 관리하도록 한다.

기타: AI 모델 구동을 위해 GPU 드라이버 및 ML 프레임워크 설치가 요구된다. 예를 들어 PyTorch를 GPU모드로 쓰려면 NVIDIA GPU 드라이버와 CUDA Toolkit 호환 버전이 설치되어야 한다. 만약 사용자가 이러한 환경구축에 익숙하지 않다면, 패키징 단계에서 ONNX런타임이나 사전 컴파일된 EXE로 제공하여 의존성을 줄일 수 있다. CPU로만 동작하게 제한한다면 설치가 수월해지지만 성능이 낮아질 수 있다.

설치 및 초기 실행 시 고려사항

모델 및 인덱스 초기화: 처음 프로그램을 설치하면, 필요한 AI 모델 데이터를 다운로드하거나 준비하는 과정이 필요하다. Hugging Face의 모델은 수백 MB 단위 파일이므로, 설치 시 자동 다운로드하거나, 별도 안내하여 사용자가 수동 다운로드하도록 할 수 있다. 이때 사용자에게 외부 모델 다운로드 용량 및 위치를 알려주는 것이 좋다. 또한 OpenAI/Gemini API 키 연동을 지원한다면, 초기 설정 마법사에서 API 키를 입력받아 저장(로컬 암호화)해둔다.

초기 인덱싱 전략: 첫 실행 시 사용자가 원하는 드라이브/폴더에 대해 인덱싱을 수행해야 한다. 전체 드라이브 스캔은 수 시간이 걸릴 수 있으므로, 인터페이스에서 진행 상황(현재 폴더, 진행률)을 표시하고 일시중지/재개 기능을 제공하면 유용하다. 또는 "지금 인덱싱하기"와 "나중에 배경에서 인덱싱" 옵션을 줘서 사용자가 즉시 검색이 필요한지 선택하게 할 수 있다. 인덱싱은 이후 수동 트리거로만 이루어진다면, 파일 변경 모니터링(watchdog)은 기본 비활성화하고, 사용자가 원할 때 갱신하게 한다. 반면, 백그라운드로 파일 시스템 변화를 감지해 증분 인덱싱하는 기능도 선택적으로 제공 가능하다(예: 매일 새로 추가된 파일만 자동 인덱싱).

캐싱 및 성능 튜닝: 초기에는 인덱스가 비어 있으므로, 사용자가 검색을 시도하면 결과가 없을 수 있다. 핵심 시스템이 준비될 때까지 UI에서 "인덱싱 진행 중" 상태를 알리고, 부분적으로라도 결과를 제공하는 게 좋다. 예를 들어 텍스트 파일은 빨리 인덱싱되니 텍스트 결과는 나오지만, 이미지 분석은 아직이라서 더 풍부한 결과는 나중에 얻을 수 있음을 안내한다. 큰 파일의 요약은 미리 생성하지 않고, 사용자가 처음 그 파일을 열 때 생성해서 캐시하는 방식을 택하면 초기 인덱싱 시간을 줄일 수 있다 (즉 Lazy Summarization 전략). 시스템 설정으로 "초기 인덱싱 시 문서 요약 생성 여부" 등을 토글할 수 있게 하여, 성능과 편의의 트레이드오프를 사용자가 선택하게 한다.

보안 및 프라이버시: 설치 시 주의할 점은, 프로그램이 민감한 개인 데이터를 다룬다는 점이다. 따라서 인터넷 통신을 최소화하고, 부득이 통신할 때는 명확히 사용자 동의를 받아야 한다. 예를 들어 "파일 내용을 OpenAI 서버로 보내 요약하는 기능을 사용하시겠습니까?"를 설정에 넣고 기본은 꺼두는 식이다. 또한 생성된 인덱스와 메타데이터에 민감정보가 포함될 수 있음을 안내하고, 원하면 암호화 저장이나 특정 폴더 제외 기능을 제공한다. 기업 환경이라면 초기 실행 전에 프록시/방화벽 설정도 고려해야 하므로, API 통신을 하는 도메인 정보를 명시해야 한다.

유사 프로젝트 참고: 앞서 설계한 개념과 유사한 기능을 제공하는 실제 사례로, Shade 파일 탐색기가 있다. Shade는 로컬에서 AI가 이미지/영상 등을 자동 태그/설명하고, 시각적 유사 검색을 제공하는데, 이러한 기능으로 사용자는 수많은 에셋 중 필요한 것을 쉽게 찾을 수 있었다

. 또한 Windows 11의 Copilot/AI Explorer도 비슷한 아이디어를 구현 중인데, 사용자가 "내 PC 전체를 자연어로 검색"하고 "맥락에 맞는 파일 추천"을 받을 수 있도록 설계되고 있다

. 오픈소스 측면에서는 앞서 언급한 Local-File-Organizer 프로젝트가 LLM과 VLM을 활용해 파일을 내용별로 자동 분류하는 예를 보여준다

. 이들은 완성된 제품이라기보다는 프로토타입에 가깝지만, AI를 활용한 데이터 관리가 개인 사용자 영역에서도 충분한 가치가 있음을 입증하고 있다. 우리의 설계도 이러한 사례를 참고하여, 로컬 자원으로 최대한 프라이버시를 지키면서 사용 편의를 높이는 방향에 초점을 맞추고 있다

.

요약하면, AI 기능을 갖춘 개인용 파일 탐색기는 다양한 AI 기술 스택의 통합을 통해 파일 관리의 패러다임을 바꾸어준다. 자동 분류/태깅으로 폴더 정리 부담을 줄이고, 자연어로 원하는 정보를 묻는 즉각적인 검색으로 업무 생산성을 높이며, 미리보기 요약과 지능형 추천으로 사용자 경험을 향상시킨다

. 이러한 시스템을 구축하려면 초기 투자(인덱싱 시간, 하드웨어 자원 등)가 필요하지만, 일단 세팅이 완료되면 사용자는 훨씬 스마트한 방식으로 개인 데이터를 활용할 수 있을 것이다. (예: "이 사진들 중 강아지가 나온 것만 골라줘", "작년 재무제표 요약 보여줘" 같은 요청에 바로 응답) 앞으로도 모델 경량화와 하드웨어 발전이 지속되면 개인 PC에서도 더욱 강력한 AI 탐색 기능이 실현될 것으로 기대된다

.

참고 문헌: AI 파일 탐색기의 개념과 필요성에 대해서는 BuildPrompt의 블로그 글

, Shade 제품 페이지

, GeeksforGeeks 뉴스

등을 참고하였으며, 구현 측면에서는 GitHub의 Local-File-Organizer 프로젝트

등이 유용한 인사이트를 제공한다.