Cerebras Inference - 가장 빠른 추론 AI 칩

Cerebras Inference

개요

Cerebras Systems는 AI 계산 분야에서 혁신적인 기술을 제공하는 기업으로, 최근 세계에서 가장 빠른 AI 추론 솔루션인 'Cerebras Inference'를 발표했습니다. 이 기술은 Llama 3.1 8B와 70B 모델에서 각각 초당 1,800 토큰과 450 토큰을 생성할 수 있어, 기존의 Nvidia GPU 기반 솔루션보다 20배 빠른 성능을 자랑합니다. 이러한 성능 향상은 AI 개발자들과 기업에게 실제적인 이점을 제공하며, 특히 실시간 및 대량 데이터 처리 요구가 있는 AI 응용 프로그램에서 큰 도움을 줍니다.

주요 성능 및 특징

성능 지표

Cerebras Inference는 Llama 3.1 8B 모델에서 초당 1,800 토큰, Llama 3.1 70B 모델에서 초당 450 토큰을 생성할 수 있습니다. 이는 기존의 Nvidia H100 GPU가 각각 242 토큰과 128 토큰을 생성하는 것과 비교했을 때 월등히 높은 성능입니다.

가격 및 경제성

Cerebras Inference는 높은 성능 뿐만 아니라 경제적인 가격을 제시합니다. 1백만 토큰 당 Llama 3.1 8B는 10센트, Llama 3.1 70B는 60센트로 책정되어 GPU 기반 솔루션보다 현저히 낮은 비용으로 운영할 수 있습니다. 이는 AI 워크로드 비용을 최대 100배 절감할 수 있는 효과를 가져옵니다.

기술적 우수성

16비트 정밀도 유지: Cerebras Inference는 전체 추론 실행 동안 16비트 도메인을 유지하여 최상의 정확도를 제공합니다.

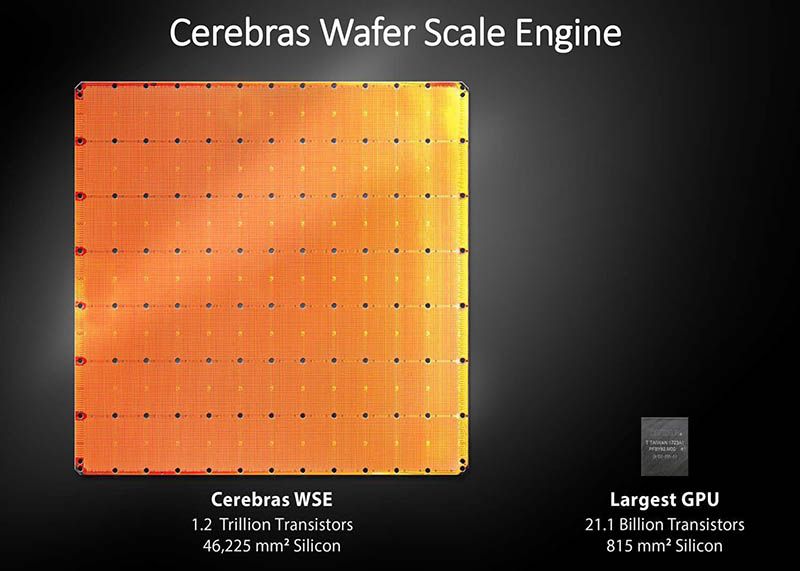

엄청난 메모리 대역폭: Wafer-Scale Engine 3 (WSE-3) 칩은 초당 21페타바이트의 메모리 대역폭을 제공하여, 데이터 전송 속도를 극적으로 향상시킵니다. 이는 GPU보다 7,000배 더 높은 메모리 대역폭입니다.

웨이퍼 스케일 엔진(WSE): 단일 실리콘 웨이퍼를 사용하여 만든 거대한 AI 칩으로, '접시'나 '피자 박스' 크기에 비유될 정도로 큽니다.

최신 WSE-3: 4조 개의 트랜지스터와 90만 개의 AI 최적화 컴퓨팅 코어를 갖춘 5nm 기반의 칩입니다.

사용 사례

AI 에이전트

Cerebras Inference는 실시간 및 다단계 성능 요구가 있는 AI 에이전트 개발에 이상적입니다. 예를 들어, DeepLearning.AI의 앤드류 응(Andrew Ng)은 반복적으로 대형 언어 모델(LLM)을 프롬프트하는 여러 에이전트 워크플로우에서 이 기술이 큰 도움이 될 것이라 강조했습니다.

실시간 분석 및 결정

비즈니스 세계에서는 실시간 분석 및 결정을 가능하게 함으로써 시장 변화에 민첩하게 대응할 수 있습니다. 예를 들어, Perplexity의 공동 창업자인 데니스 야라츠(Denis Yarats)는 이런 초고속 추론이 검색 엔진과 같은 사용자 상호작용을 획기적으로 개선할 것이라고 예측했습니다.

의료 및 연구 분야

AI 모델이 더 큰 데이터 세트를 더 빨리 처리할 수 있어, 의료 분야에서는 빠른 진단과 맞춤형 치료 계획 수립에 큰 도움이 될 수 있습니다. 예를 들어, GlaxoSmithKline의 AI/ML 부문 수석 부사장인 킴 브랜슨(Kim Branson)은 이런 기술이 제약 연구 및 개발에서 중요한 역할을 할 것이라고 밝혔습니다.

비교 및 벤치마크

Artificial Analysis가 독립적으로 검증한 결과에 따르면, Cerebras Inference는 Llama 3.1 8B 모델에서 초당 1,850 토큰, 70B 모델에서 446 토큰을 생성하며 새로운 기록을 세웠습니다. 이는 이전까지 가장 빠른 추론 제공자였던 Groq의 성능을 능가하는 수치입니다.

cerebras (세레브라스) 란?

Cerebras는 인공지능(AI) 분야에서 혁신적인 기술을 개발하는 미국의 스타트업 기업입니다.

결론

Cerebras Inference는 무시할 수 없는 기술적 혁신으로 AI 추론 시장에 새로운 표준을 제시합니다. 이 서비스는 높은 성능과 경제성을 동시에 제공하며, 실시간 AI 응용 프로그램, 대규모 데이터 분석, 그리고 의료 및 연구 분야에서 크게 활용될 수 있습니다. 앞으로도 Cerebras는 더 큰 모델을 지원하고 다양한 최적화 기술을 통해 성능을 지속적으로 향상시킬 계획입니다.

이 노트는 요약·비평·학습 목적으로 작성되었습니다. 저작권 문의가 있으시면 에서 알려주세요.