Github models 사용해 보기 - 무료로 플래그십 모델들 사용하기

깃허브에서 다양한 인공지능 모델들을 무료로 사용할 수 있는 깃허브 모델을 대기자 신청을 했다. 며칠만에 승인이 됐다. 무료로 사용할 수 있게 해주는 이유는 AI 모델을 테스트해보고 추가적으로 쓰고 싶으면 azure를 통해서 사용해 보라고 하는 것 같다. 하지만 무료 티어를 주는 것만으로도 땡큐이다.

Build software better, together

gpt-4o 모델을 사용해 봤다. Build software better, together

Github 에서 personal access token 발급 받기

Fine-grained tokens 도 발급 받았다. 권한은 아무것도 안줘도 된다.

파워셀에 토큰 입력하기.

$Env:GITHUB_TOKEN="<your-github-token-goes-here>"파워셀을 킬때마다 입력해줘야 한다. 보안 상 문제가 없다면 코드에 입력해도 괜찮을 것 같다. 클라우드라면 당연히 환경 변수 등을 통해 안전하게 처리해야 한다.

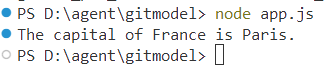

node package 설치 및 코드 실행.

import OpenAI from "openai"; const token = process.env["GITHUB_TOKEN"]; const endpoint = "https://models.inference.ai.azure.com"; const modelName = "gpt-4o"; export async function main() { const client = new OpenAI({ baseURL: endpoint, apiKey: token }); const response = await client.chat.completions.create({ messages: [ { role:"system", content: "You are a helpful assistant." }, { role:"user", content: "What is the capital of France?" } ], model: modelName, temperature: 1., max_tokens: 1000, top_p: 1. }); console.log(response.choices[0].message.content); } main().catch((err) => { console.error("The sample encountered an error:", err); });결과

프랑스의 수도는 어디인가요? 파이.

github models에 자세한 설명들이 있으니 소개는 생략. 그냥 보고 따라하면 된다.

제한 사항

역시 무료 사용량이 있다.

Prototyping with AI models - GitHub Docs

| 모델 유형 | 제한 항목 | Free 및 Copilot Individual | Copilot Business | Copilot Enterprise |

|---|---|---|---|---|

| Low | 요청 횟수/분 | 15 | 15 | 20 |

| 요청 횟수/일 | 150 | 300 | 450 | |

| 토큰/요청 | 8000 입력, 4000 출력 | 8000 입력, 4000 출력 | 8000 입력, 8000 출력 | |

| 동시 요청 수 | 5 | 5 | 8 | |

| High | 요청 횟수/분 | 10 | 10 | 15 |

| 요청 횟수/일 | 50 | 100 | 150 | |

| 토큰/요청 | 8000 입력, 4000 출력 | 8000 입력, 4000 출력 | 16000 입력, 8000 출력 | |

| 동시 요청 수 | 2 | 2 | 4 | |

| Embedding | 요청 횟수/분 | 15 | 15 | 20 |

| 요청 횟수/일 | 150 | 300 | 450 | |

| 토큰/요청 | 64000 | 64000 | 64000 | |

| 동시 요청 수 | 5 | 5 | 8 |

분당 10~15이고 하루 50~150 요청이 가능하다. 이 정도면 정말 간단한 개인 프로젝트에서 사용할 수 있을 듯 하다.

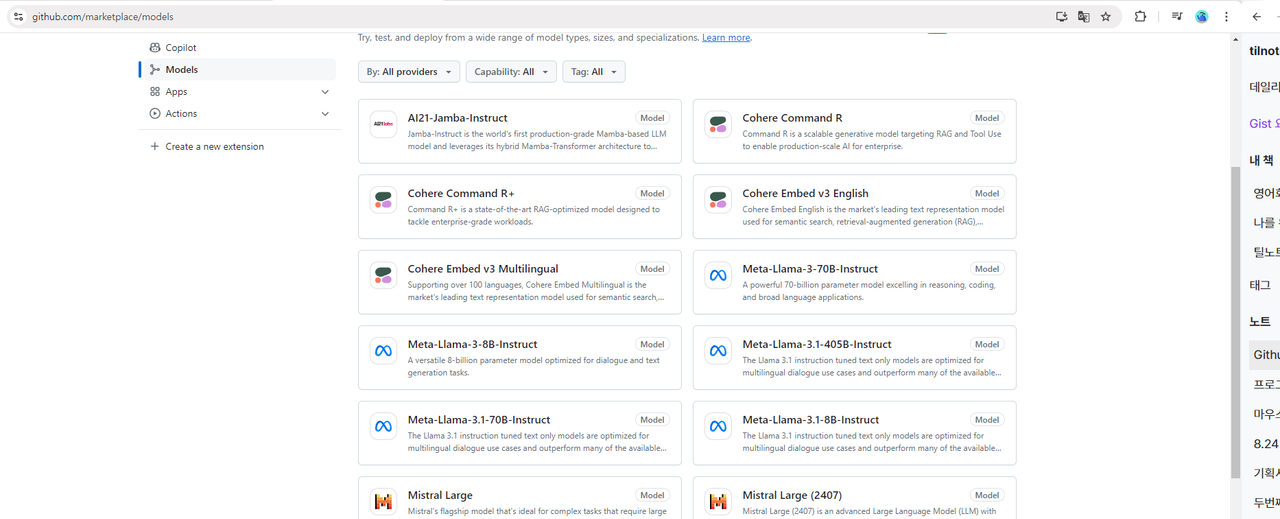

사용 가능한 모델들

AI21

Jamba-Instruct: Mamba 기반의 하이브리드 Mamba-Transformer 아키텍처를 사용하는 LLM 모델로, 성능, 품질, 비용 효율성을 최적화한 세계 최초의 상용 모델.

Cohere

Command R: 대규모 생성 모델로, 기업용 AI를 위한 RAG(검색 증강 생성) 및 도구 사용을 최적화.

Command R+: 기업용 고급 작업을 처리하기 위해 RAG에 최적화된 최첨단 모델.

Embed v3 English: 영어로 된 텍스트 표현 모델로, 의미적 검색, RAG, 분류, 클러스터링에 사용되는 시장 선도 모델.

Embed v3 Multilingual: 100개 이상의 언어를 지원하는 다국어 텍스트 표현 모델로, 의미적 검색, RAG, 분류, 클러스터링에 사용됨.

Meta

Llama-3-70B-Instruct: 700억 개의 파라미터를 가진 모델로, 추론, 코딩 및 언어 작업에 뛰어남.

Llama-3-8B-Instruct: 80억 개의 파라미터를 가진 모델로, 대화 및 텍스트 생성 작업에 최적화됨.

Llama-3.1-405B-Instruct: 다국어 대화 용도로 최적화된 모델로, 여러 오픈 소스 및 폐쇄형 채팅 모델을 능가함.

Llama-3.1-70B-Instruct: 다국어 대화에 최적화된 모델로, 여러 산업 표준을 능가함.

Llama-3.1-8B-Instruct: Llama-3.1-70B와 유사하나 80억 개의 파라미터로 구성된 모델로, 다국어 대화에 최적화됨.

MistralAI

Mistral Large: 복잡한 작업에 적합한 모델로, 큰 추론 능력을 필요로 하거나 전문화된 작업에 적합 (예: 텍스트 생성, 코드 생성, RAG, 에이전트).

Mistral Large (2407): 최첨단 추론, 지식 및 코딩 능력을 갖춘 고급 LLM.

Mistral Nemo: 크기 카테고리 내에서 최첨단 추론, 세계 지식 및 코딩 능력을 갖춘 모델.

Mistral Small: 높은 효율성과 낮은 지연 시간을 요구하는 모든 언어 기반 작업에 사용 가능한 모델.

Azure OpenAI Service

OpenAI GPT-4o: 텍스트와 이미지 입력을 모두 처리할 수 있는 GPT-4 계열의 가장 진보된 멀티모달 모델.

OpenAI GPT-4o mini: 다양한 텍스트 및 이미지 작업을 위한 비용 효율적이고 효율적인 AI 솔루션.

Text Embedding 3 (large): OpenAI의 최신이자 가장 강력한 임베딩 모델 시리즈의 일부.

Text Embedding 3 (small): Text Embedding 3 시리즈의 작은 버전으로, 높은 성능 유지.

Microsoft

Phi-3-medium instruct (128k): Phi-3-medium의 확장된 컨텍스트 버전으로, RAG 및 소수 예제 프롬프트에 적합.

Phi-3-medium instruct (4k): 140억 개의 파라미터를 가진 모델로, 품질과 추론이 많은 데이터에 최적화됨.

Phi-3-mini instruct (128k): Phi-3-mini의 확장된 컨텍스트 버전으로, RAG 및 소수 예제 프롬프트에 적합.

Phi-3-mini instruct (4k): 품질과 낮은 지연 시간을 최적화한 작은 모델.

Phi-3-small instruct (128k): Phi-3-small의 확장된 컨텍스트 버전으로, RAG 및 소수 예제 프롬프트에 적합.

Phi-3-small instruct (8k): Phi-3-mini보다 더 큰 70억 개의 파라미터를 가진 모델로, 더 나은 품질과 추론이 많은 데이터에 최적화됨.

거의 대부분의 모델을 지원한다. 마소 요즘 왜 이러는 걸까...?