구글 젬마 2 공개 - Lamma 70B의 성능에 근접하는 오픈 모델

Gemma 2는 Google이 개발한 경량 및 오픈 모델 제품군입니다. Gemma 2는 90억(9B) 및 270억(27B) 파라미터 크기로 제공되며, 연구자와 개발자들이 쉽고 효율적으로 사용할 수 있도록 설계되었습니다.

이미지 출처 : 구글 블로그 Gemma 2 is now available to researchers and developers

초기 Gemma 모델들은 Gemini 모델과 동일한 연구 결과와 기술로 개발되었으며, CodeGemma, RecurrentGemma(반복 신경망과 로컬 주목을 활용하여 메모리 효율성 개선), PaliGemma (비전) 등의 다양한 모델을 통해 개발자들에게 각기 다른 AI 작업에 맞는 특별한 기능을 제공해 왔습니다. 이러한 흐름을 이어받아 Gemma 2가 공식적으로 전 세계의 연구자와 개발자들에게 출시되었습니다.

특징

우수한 성능: Gemma 2는 9B 및 27B 파라미터 크기로 제공되며, 동일한 크기의 다른 오픈 모델들에 비해 월등한 성능을 자랑합니다. 예를 들어, 27B Gemma 2 모델은 더 큰 모델인 Llama 70B와 필적하는 성능을 제공하지만 그 크기는 절반 미만입니다. (보통 16비트 모델 운용에 필요한 vRam은 2바이트를 곱해서 27*2=54GB이다. 8비트 양자화 등을 한다면 이보다 작은 램에서도 돌아갈 것으로 보인다. gemma.cpp 와 같은 것도 제공한다.)

비용 효율성: 27B Gemma 2 모델은 단일 Google Cloud TPU 호스트나 NVIDIA A100 80GB Tensor Core GPU에서 효율적으로 작동하여, 비용 효율적인 AI 배포가 가능하도록 설계되었습니다. 이는 더욱 많은 사용자들이 접근할 수 있도록 합니다.

하드웨어 최적화: Gemma 2는 다양한 하드웨어에서 높은 속도로 실행될 수 있도록 최적화되었습니다. Google AI Studio에서 성능을 체험하거나, Hugging Face Transformers를 통해 로컬 환경에서 실행할 수 있으며, NVIDIA RTX에서도 사용할 수 있습니다.

지식 증류 기법 : 9B 모델은 대형 모델의 Knowledge Distillation 을 통해 학습하였습니다. 27B는 처음부터 학습시킨 결과물입니다.

| Llama 3 (70B) | Qwen 1.5 (32B) | Gemma 2 (27B) | |

|---|---|---|---|

| MMLU | 79.2 | 74.3 | 75.2 |

| GSM8K | 76.9 | 61.1 | 75.1 |

| ARC-c | 68.8 | 63.6 | 71.4 |

| HellaSwag | 88.0 | 85.0 | 86.4 |

| Winogrande | 85.3 | 81.5 | 83.7 |

| 벤치마크에서 Llama 3 70B에 근접하는 것을 알 수 있습니다. |

사용

Gemma 2는 상업적으로 이용 가능한 gemma 라이센스로 제공되며, 주요 AI 프레임워크와의 호환성을 자랑합니다. Keras, JAX, PyTorch, TensorFlow 등 다양한 툴과의 통합이 가능하며, NVIDIA TensorRT-LLM을 통해 NVIDIA 가속화 인프라에서 최적화된 성능을 제공합니다.

Kaggle 및 Hugging Face Models에서 모델 가중치를 다운로드 받을 수 있습니다. 또한, 연구와 개발을 위해 Kaggle 또는 Colab 노트북에서 무료로 사용할 수 있으며, Google Cloud의 첫 번째 고객에게는 $300 크레딧이 제공됩니다. 학계 연구원들은 Google Cloud 크레딧을 통해 연구를 가속화할 수 있는 Gemma 2 Academic Research Program에 신청할 수 있습니다.

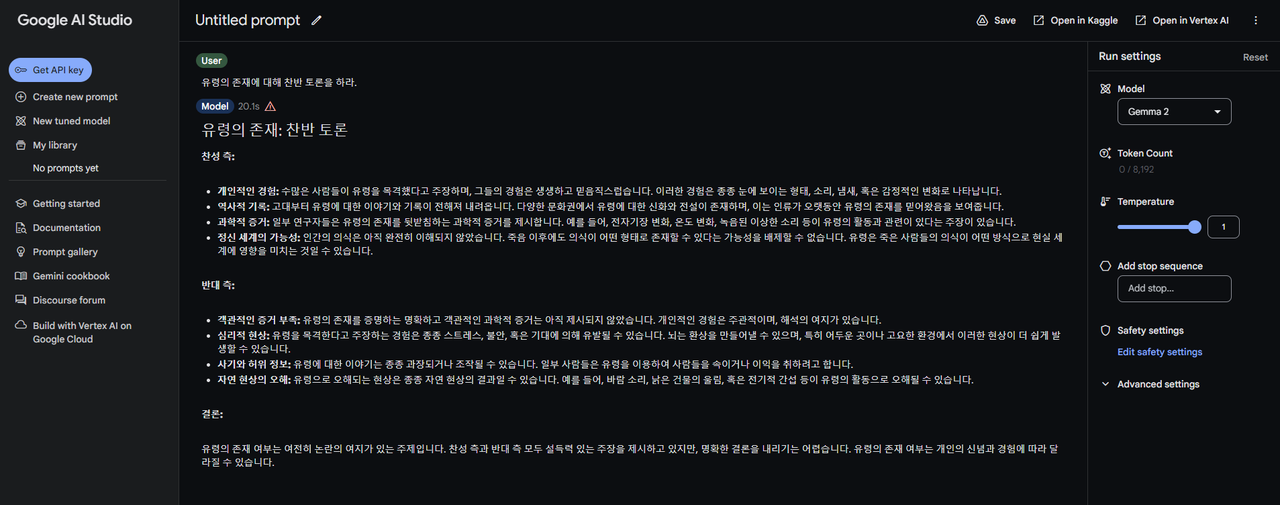

구글 AI 스튜디오에서 사용해 볼 수 있습니다. Google AI Studio | Gemini API | Google for Developers

프롬프트 : 유령의 존재에 대해 찬반 토론을 하라.

유령의 존재: 찬반 토론

찬성 측:

개인적인 경험: 수많은 사람들이 유령을 목격했다고 주장하며, 그들의 경험은 생생하고 믿음직스럽습니다. 이러한 경험은 종종 눈에 보이는 형태, 소리, 냄새, 혹은 감정적인 변화로 나타납니다.

역사적 기록: 고대부터 유령에 대한 이야기와 기록이 전해져 내려옵니다. 다양한 문화권에서 유령에 대한 신화와 전설이 존재하며, 이는 인류가 오랫동안 유령의 존재를 믿어왔음을 보여줍니다.

과학적 증거: 일부 연구자들은 유령의 존재를 뒷받침하는 과학적 증거를 제시합니다. 예를 들어, 전자기장 변화, 온도 변화, 녹음된 이상한 소리 등이 유령의 활동과 관련이 있다는 주장이 있습니다.

정신 세계의 가능성: 인간의 의식은 아직 완전히 이해되지 않았습니다. 죽음 이후에도 의식이 어떤 형태로 존재할 수 있다는 가능성을 배제할 수 없습니다. 유령은 죽은 사람들의 의식이 어떤 방식으로 현실 세계에 영향을 미치는 것일 수 있습니다.

반대 측:

객관적인 증거 부족: 유령의 존재를 증명하는 명확하고 객관적인 과학적 증거는 아직 제시되지 않았습니다. 개인적인 경험은 주관적이며, 해석의 여지가 있습니다.

심리적 현상: 유령을 목격한다고 주장하는 경험은 종종 스트레스, 불안, 혹은 기대에 의해 유발될 수 있습니다. 뇌는 환상을 만들어낼 수 있으며, 특히 어두운 곳이나 고요한 환경에서 이러한 현상이 더 쉽게 발생할 수 있습니다.

사기와 허위 정보: 유령에 대한 이야기는 종종 과장되거나 조작될 수 있습니다. 일부 사람들은 유령을 이용하여 사람들을 속이거나 이익을 취하려고 합니다.

자연 현상의 오해: 유령으로 오해되는 현상은 종종 자연 현상의 결과일 수 있습니다. 예를 들어, 바람 소리, 낡은 건물의 울림, 혹은 전기적 간섭 등이 유령의 활동으로 오해될 수 있습니다.

결론:

유령의 존재 여부는 여전히 논란의 여지가 있는 주제입니다. 찬성 측과 반대 측 모두 설득력 있는 주장을 제시하고 있지만, 명확한 결론을 내리기는 어렵습니다. 유령의 존재 여부는 개인의 신념과 경험에 따라 달라질 수 있습니다.

또는 허깅챗에서 데모를 사용해 볼 수 있습니다다. google/gemma-2-27b-it - HuggingChat

향후 발전 방향

구글은 Gemma 패밀리를 계속 확장할 계획입니다. 추가로 2.6B 파라미터 크기의 Gemma 2 모델이 추가로 출시될 계획입니다. (2.7B의 가중치는 아직 오픈소스로 공개되지 않음.)

참고 문서

시사점

AI가 경량화와 오픈소스화가 이루어진다면 로컬에서 LLM을 활용할 수 있는 시대가 올 것 같습니다. 물론 아직 필요 vRAM이 높기는 하지만 LPU 개발 등 하드웨어 면에서도 다양한 발전이 진행되고 있습니다. 로컬로 활용할 수 있는 시기가 오면 내 컴퓨터에 작은 모델을 활용해 다양한 일들을 할 수 있습니다.

또 90억 모델은 증류기법을 활용했다는 것이 독특합니다. 대형 모델을 증류해서 작은 모델을 만드는 것이 효과가 있다는 의미일 것 같습니다.