ollama 모델 윈도우 로컬에서 돌리기 - llama3 8B

ollama의 윈도우 버전을 다운로드 받는다. : Ollama

나의 경우 c:\ 의 용량이 없어서 d:\ 로 변경하는 작업을 했다.

실행 경로 바꾸기

원래 모델은 사용자명/.ollama/models에 저장된다. 이걸 바꿀 수 있다. llama3 8B는 약 4GB 정도 된다.

모델 저장 및 실행을 다른 경로로 정하기 : Is there a way to change the download/run directory? · Issue #680 · ollama/ollama

윈도우의 경우 환경 변수 편집에서 세팅한다. (윈도우 키 - 환경 변수 입력 - 시스템 환경 변수 편집)

변수를 새로 만들기 한 후 OLLAMA_MODELS 에 D:\ollama_model 와 같이 변수를 만든다.

그리고 ollama를 종료했다가 다시 실행하면 된다.

llama3 실행하기

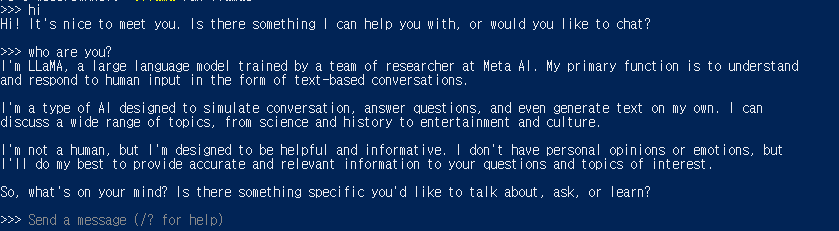

터미널에서 ollama run llama3

이렇게 하면 자동으로 8B 모델이 연결돼서 돌아간다.

크게 느리지 않고 잘 작동한다.

만약 프롬프트를 같이 입력하고 싶으면 다음과 같이 입력한다.

ollama run llama3 hi

ollama 시스템 사양

다음은 올라마에서 모델을 돌리기 위해 필요한 램 사양이다.

7B 모델들을 돌리기 위해서는 최소한 8GB의 램.

13B 모델은 16 GB의 램.

33B 모델은 32GB의 램.

ollama 시작 시 자동 시작 해제하기

윈도우를 시작하면 자동으로 ollama가 실행이 된다. 이를 방지하고 싶은 경우 윈도우키 - 작업 관리자 - 시작 프로그램에서 ollama.exe를 사용안함으로 하면 된다. 이후 올라마를 사용할 때만 시작한 후 사용하면 된다.

깃허브

자세한 사용법은 깃허브를 참고하자. local에서 curl로 rest api까지 지원한다...!

8B 모델은 의미가 있는데 이제 사람들이 작은 LLM을 로컬에서 돌리면서 자신의 에이전트를 만들어서 활용할 수 있기 때문이다.