DBRX - LLaMa2 70B, Mixtral, Grok-1 보다 벤치마크에서 우수한 오픈 모델

요약

Databricks에서 출시한 오픈 언어 모델 DBRX.

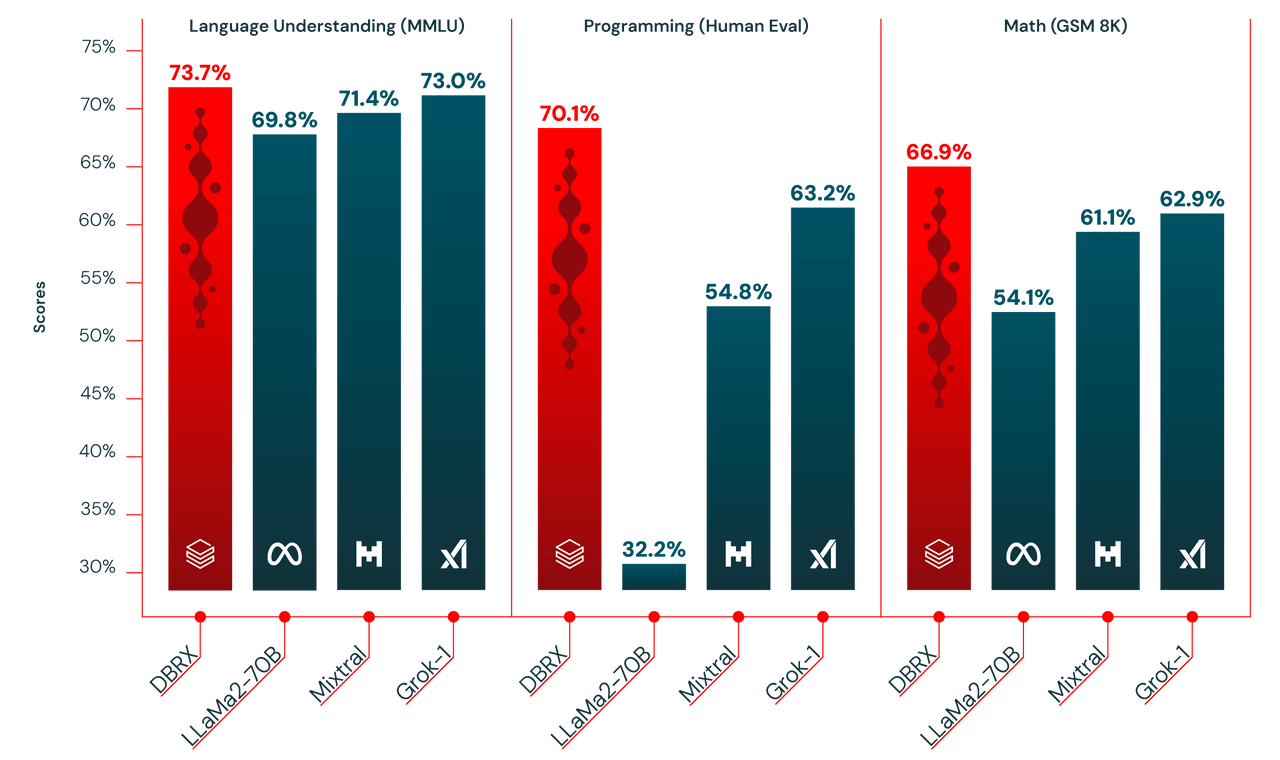

벤치마크 테스트에서 Meta의 Llama 2, Anthropic의 Mixtral, Elon Musk의 xAI에서 최근 출시된 Grok-1 모델을 포함하여 기존의 오픈 소스 모델들을 능가했다. DBRX는 프로그래밍 및 수학 분야에서도 뛰어난 성능을 보인다.

이미지 : 데이터 브릭스. LLaMa2 70B, Mixtral, Grok-1을 벤치마크에서 넘어서다.

DBRX는 완전한 오픈 소스는 아니다. 사용 규칙에 대한 정책 (7억명 이상의 사용자를 보유한 기업을 제외)이 있으며, 훈련 데이터는 공개되지 않는다. 이런 모델들을 Meta의 Llama 2와 같은 오픈소스가 아닌 오픈 모델로 분류한다.

모델은 1320억개의 파라미터를 가진 전문가 혼합(Mixture-of-Experts) 모델로 한 번에 360억개의 매개변수만 활성화되어 효율적으로 작동한다. 최대 토큰 처리량은 32,000이다.

데이터브릭스 플랫폼에서 DBRX를 사용할 수 있고 자체 모델을 훈련할 수 있다. 오픈 소스 커뮤니티는 Databricks와 Hugging Face의 GitHub 저장소를 통해 활용할 수 있다.

#인공지능#ai#DBRX#오픈 언어 모델#Databricks