앤드류 응 교수님의 AI 에이전트 워크 플로우

앤드류 응 교수님이 뉴스 레터로 공유한 내용이다. 생각해 볼만한 점이 있어 노트로 남긴다. Robots Talk Back, AI Security Risks, Political Deepfakes, and more

영문

I think AI agentic workflows will drive massive AI progress this year — perhaps even more than the next generation of foundation models. This is an important trend, and I urge everyone who works in AI to pay attention to it.

Today, we mostly use LLMs in zero-shot mode, prompting a model to generate final output token by token without revising its work. This is akin to asking someone to compose an essay from start to finish, typing straight through with no backspacing allowed, and expecting a high-quality result. Despite the difficulty, LLMs do amazingly well at this task!

With an agentic workflow, however, we can ask the LLM to iterate over a document many times. For example, it might take a sequence of steps such as:

Plan an outline.

Decide what, if any, web searches are needed to gather more information.

Write a first draft.

Read over the first draft to spot unjustified arguments or extraneous information.

Revise the draft taking into account any weaknesses spotted.

And so on.

This iterative process is critical for most human writers to write good text. With AI, such an iterative workflow yields much better results than writing in a single pass.

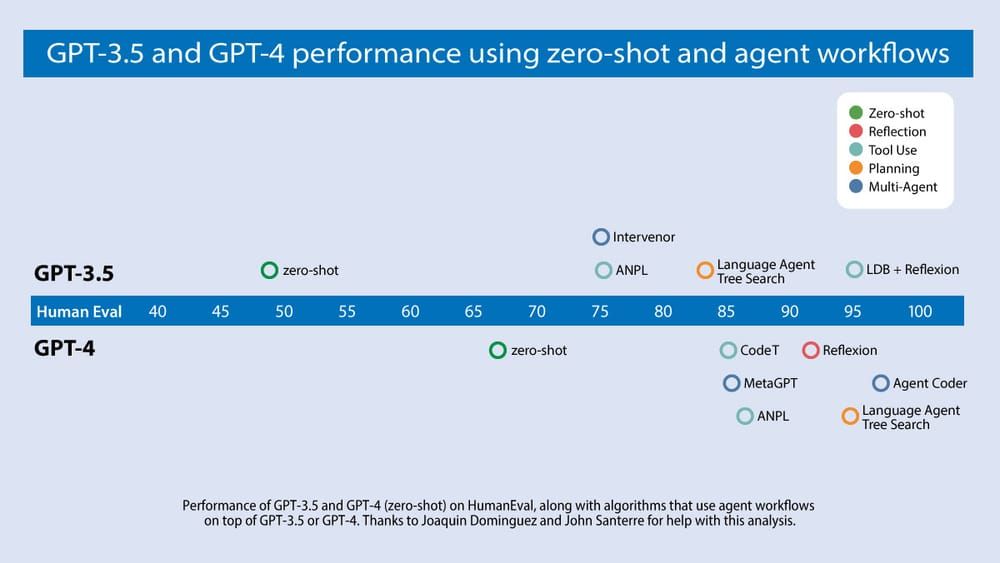

Devin’s splashy demo recently received a lot of social media buzz. My team has been closely following the evolution of AI that writes code. We analyzed results from a number of research teams, focusing on an algorithm’s ability to do well on the widely used HumanEval coding benchmark. You can see our findings in the diagram below.

GPT-3.5 (zero shot) was 48.1% correct. GPT-4 (zero shot) does better at 67.0%. However, the improvement from GPT-3.5 to GPT-4 is dwarfed by incorporating an iterative agent workflow. Indeed, wrapped in an agent loop, GPT-3.5 achieves up to 95.1%.

Open source agent tools and the academic literature on agents are proliferating, making this an exciting time but also a confusing one. To help put this work into perspective, I’d like to share a framework for categorizing design patterns for building agents. My team AI Fund is successfully using these patterns in many applications, and I hope you find them useful.

Reflection: The LLM examines its own work to come up with ways to improve it.

Tool use: The LLM is given tools such as web search, code execution, or any other function to help it gather information, take action, or process data.

Planning: The LLM comes up with, and executes, a multistep plan to achieve a goal (for example, writing an outline for an essay, then doing online research, then writing a draft, and so on).

Multi-agent collaboration: More than one AI agent work together, splitting up tasks and discussing and debating ideas, to come up with better solutions than a single agent would.

I’ll elaborate on these design patterns and offer suggested readings for each next week.

한글

저는 올해 AI 에이전트 워크플로우가 차세대 기반 모델보다 더 큰 AI 발전을 주도할 것이라고 생각합니다. 이는 중요한 트렌드이며, AI 분야에서 일하는 모든 사람이 이에 주목할 것을 촉구합니다.

오늘날 우리는 대부분 제로 샷 모드에서 LLM을 사용하여 모델이 작업을 수정하지 않고 토큰 단위로 최종 결과물을 생성하도록 유도합니다. 이는 마치 누군가에게 처음부터 끝까지 에세이를 작성해 달라고 요청하면서 공백 없이 곧바로 타이핑하고 고품질의 결과물을 기대하는 것과 비슷합니다. 이러한 어려움에도 불구하고 LLM은 이 작업을 놀라울 정도로 잘 해냅니다!

하지만 에이전트 워크플로우를 사용하면 LLM에게 문서를 여러 번 반복하도록 요청할 수 있습니다. 예를 들어 다음과 같은 일련의 단계를 거칠 수 있습니다:

개요를 계획합니다.

더 많은 정보를 수집하기 위해 어떤 웹 검색이 필요한지 결정합니다.

초안을 작성합니다.

첫 번째 초고를 읽어보고 부당한 주장이나 불필요한 정보를 찾아냅니다.

발견한 약점을 고려하여 초고를 수정합니다.

이렇게 반복합니다.

이러한 반복적인 과정은 대부분의 인간 작가가 좋은 글을 쓰기 위해 꼭 필요한 과정입니다. AI를 사용하면 이러한 반복적인 워크플로우를 통해 한 번에 작성하는 것보다 훨씬 더 나은 결과를 얻을 수 있습니다.

Devin의 멋진 데모는 최근 소셜 미디어에서 많은 화제를 모았습니다. 저희 팀은 코드를 작성하는 AI의 진화를 면밀히 추적해 왔습니다. 널리 사용되는 휴먼에벌 코딩 벤치마크에서 알고리즘의 성능에 초점을 맞춰 여러 연구팀의 결과를 분석했습니다. 아래 다이어그램에서 그 결과를 확인할 수 있습니다.

GPT-3.5(제로 샷)는 48.1%의 정답률을 보였습니다. GPT-4(제로 샷)는 67.0%로 더 잘 수행했습니다. 그러나 반복 에이전트 워크플로우를 통합하면 GPT-3.5에서 GPT-4로의 개선은 왜소해집니다. 실제로 에이전트 루프로 감싸면 GPT-3.5는 최대 95.1%를 달성합니다.

오픈 소스 에이전트 툴과 에이전트에 대한 학술 문헌이 급증하고 있어 흥미진진한 시기이지만 혼란스러운 시기이기도 합니다. 이 작업을 이해하는 데 도움이 되도록 에이전트 구축을 위한 디자인 패턴을 분류하는 프레임워크를 공유하고자 합니다. 저희 팀 AI Fund에서는 이러한 패턴을 여러 애플리케이션에 성공적으로 사용하고 있으며, 여러분도 유용하게 활용하시길 바랍니다.

리플렉션: LLM은 자체적으로 작업을 검토하여 개선 방안을 마련합니다.

도구 사용: LLM은 웹 검색, 코드 실행 또는 기타 기능을 통해 정보를 수집하고 조치를 취하거나 데이터를 처리하는 데 도움이 되는 도구를 제공받습니다.

계획: LLM은 목표를 달성하기 위한 다단계 계획을 세우고 실행합니다(예: 에세이 개요를 작성한 다음 온라인 조사를 하고 초안을 작성하는 등).

다중 에이전트 협업: 두 명 이상의 AI 에이전트가 함께 작업하고, 작업을 나누고, 아이디어를 논의하고 토론하여 한 명의 에이전트보다 더 나은 솔루션을 도출할 수 있습니다.

다음 주에는 이러한 디자인 패턴에 대해 자세히 설명하고 각각에 대해 추천할 만한 읽을거리를 제공하겠습니다.

생각

제로샷보다 에이전트 워크플로우를 만들어서 하는 것이 좋다는 내용이다. agent workflow 에서 outline을 세우고 필요한 경우 정보를 얻어서 할루를 줄이고 나온 결과를 리플렉션을 하는 프로세스는 좋은 것 같다. 이런 것들이 reflexion이나 AutoGPT에서 사용되었던 것이다. 나중에 이런 워크플로우를 굉장히 빠른 속도로 반복할 수 있다면 거의 AGI 처럼 보이지 않을까 ㅎㅎ

그리고 의외로 에이전트 워크 플로우에서 GPT 3.5의 활약이 눈부시다. 일을 쪼개서 chain prompt로 만들기 때문에 3.5 같은 작은 모델을 써도 좋은 결과가 나오지 않을까? 여러 복잡한 일을 한 번에 시킨다면 GPT-4같은 큰 모델이 좋겠지만 나눠서 한다면 비용효율적으로 작은 모델들을 쓸 수 있을 것 같다.

얼마전 LLM을 바탕으로 스트리트파이터 3 격투 게임을 하게한 연구 결과가 있는데 GPT-3.5가 1위를 차지했다. 아마 속도도 영향을 끼쳤을 수 있지만 단순한 로직의 경우 작은 모델로도 커버할 수 있다는 예시가 아닐까? GitHub - OpenGenerativeAI/llm-colosseum: Make LLMs fight for their survival! The new way to evaluate the quality of an LLM

ELO ranking

| Model | Rating |

|---|---|

| 🥇openai:gpt-3.5-turbo-0125 | 1776.11 |

| 🥈mistral:mistral-small-latest | 1586.16 |

| 🥉openai:gpt-4-1106-preview | 1584.78 |

| openai:gpt-4 | 1517.2 |

| openai:gpt-4-turbo-preview | 1509.28 |

| openai:gpt-4-0125-preview | 1438.92 |

| mistral:mistral-medium-latest | 1356.19 |

| mistral:mistral-large-latest | 1231.36 |

좀 이야기가 다른 곳으로 갔는데 에이전트 워크플로우는 굉장히 많이 쓰일 것 같다.