AI 슈퍼칩 블랙웰의 탄생 - NVIDIA GTC 2024 키노트

원본 링크 : GTC 2024에서 진행되는 NVIDIA CEO 젠슨 황의 키노트

새벽 5시에 GTC 키노트가 열렸습니다. 저는 보다가 잠들었네요. 2시간 정도의 분량입니다.

중요한 건 새로운 그래픽 프로세서인 Blackwell 입니다.

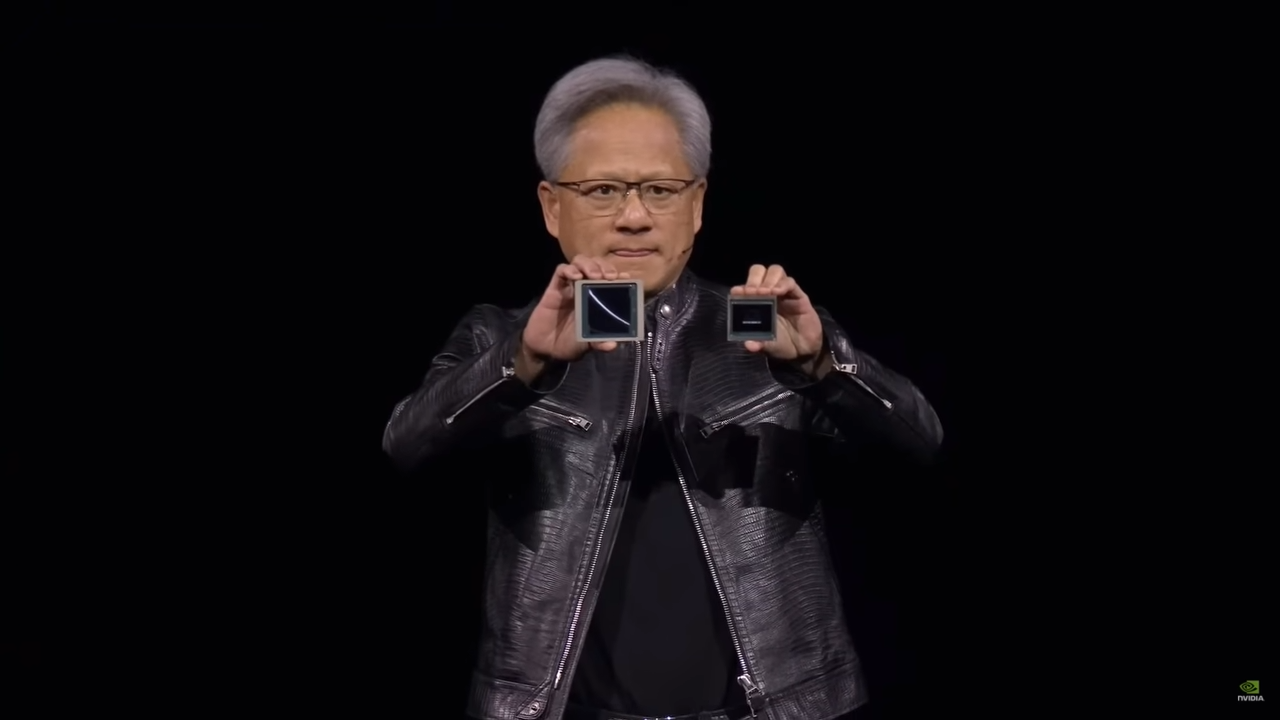

왼쪽에 있는 것이 블랙웰이고 오른쪽의 있는 것이 기존의 Hopper 입니다. (H100 시리즈)

크기가 진짜 커졌네요 ㅋㅋ 이 안에 2080억개의 트랜지스터를 탑재했다고 합니다.

"Hopper is fantastic, but we need bigger GPUs,"

호퍼는 환상적입니다. 하지만 우리는 더 큰 GPU를 필요로 합니다.

첫번째 블랙웰 칩은 GB200 이라는 AI 시스템으로 출시될 예정입니다. GB200은 블랙웰 GPU 2개와 Arm 기반 Grace CPU를 결합한 제품입니다. 이를 엔비디아 GB200 NVL72 수냉 랙으로 구축 시 H100 대비 추론 성능을 최대 30배 높일 수 있습니다. 출처

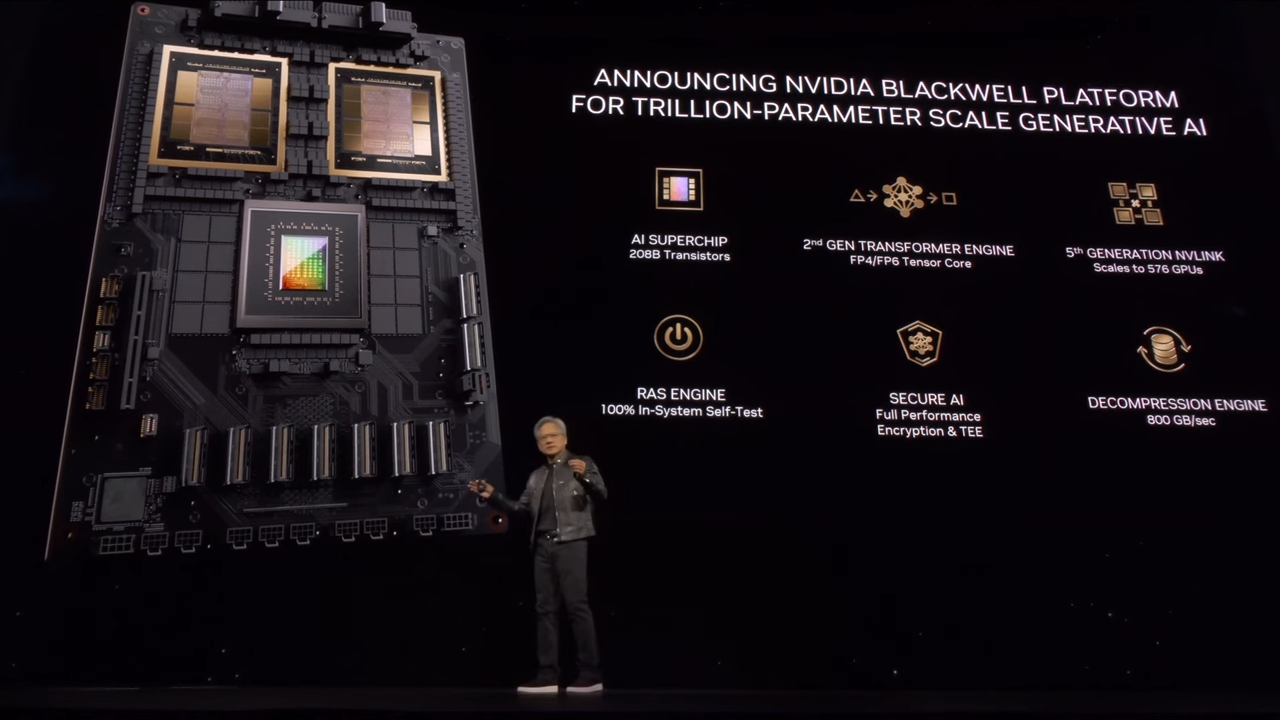

블랙웰 플랫폼

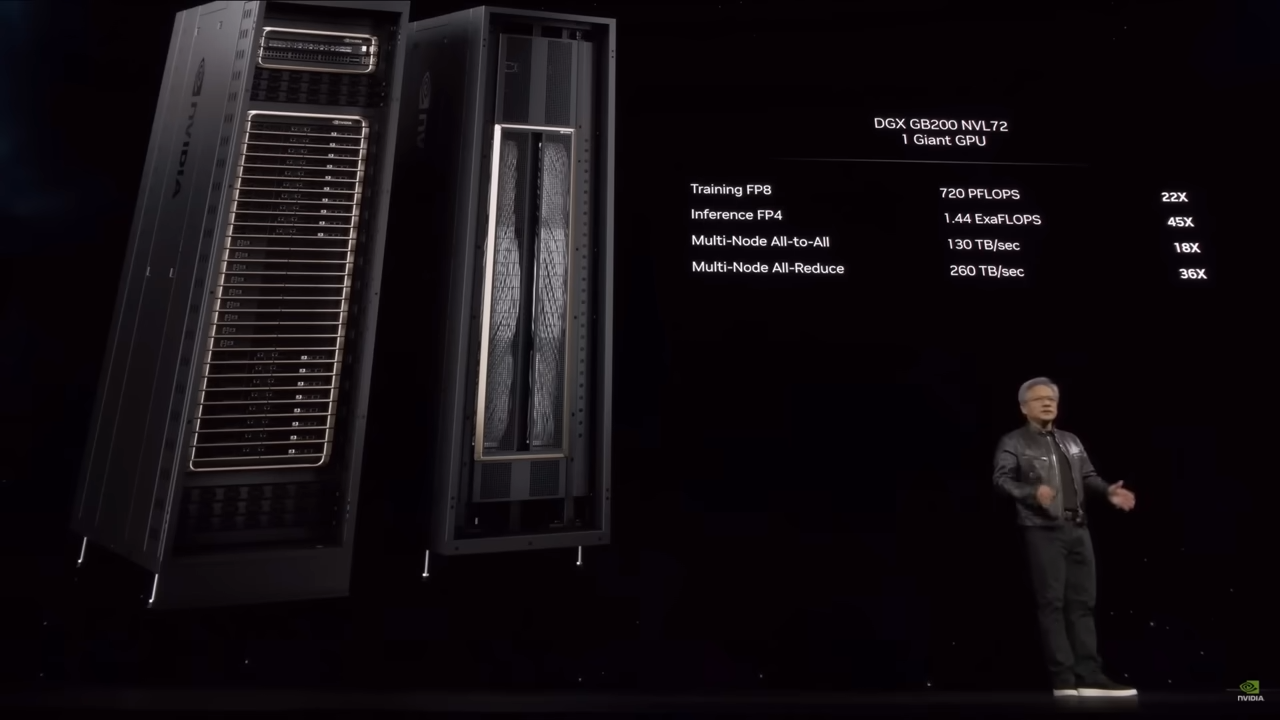

DGX GB200 NVL72 시스템

| 벤치마크 | 성능 | 향상 |

|---|---|---|

| Training FP8 | 720 PFLOPS | 22X |

| Inference FP4 | 1.44 ExaFLOPS | 45X |

| Multi-Node All-to-All | 130 TB/sec | 18X |

| Multi-Node All-Reduce | 260 TB/sec | 36X |

여기에서 보면 FP4 (FP8보다는 낮은 정확도) 에서 1.44 ExaFLOPS를 달성했음을 볼 수 있습니다.

PFLOPS는 PetaFLOPS의 약자로 초당 1000조 곱셈을 의미하는 단위입니다.

ExaFLOPS는 ExaFLOPS의 약자로 초당 100경의 곱셈을 의미하는 단위입니다.

비교:

1 ExaFLOPS는 1000 PFLOPS와 같습니다.

1 PFLOPS는 1000 TFLOPS와 같습니다.

1 TFLOPS는 1000 GFLOPS와 같습니다.

플롭스(FLOPS, FLoating point Operations Per Second)는 1초 동안 수행할 수 있는 부동소수점 연산의 횟수를 말합니다.

참고로 Hewlett Packard Enterprise에서 구축한 슈퍼 컴퓨터인 Frontier 가 1.1 엑사플롭을 자랑합니다. 2021년 테슬라의 오토파일럿을 훈련하는데 든 테슬라 슈퍼 컴퓨터는 1.8 엑사플롭스였습니다.

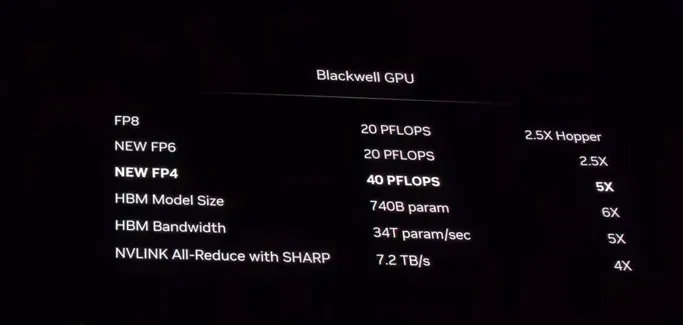

Blackwell 은 개별로 치면 FP8에서 20 petaFLOPS 입니다. hopper보다 평균 약 4배정도 빠릅니다.

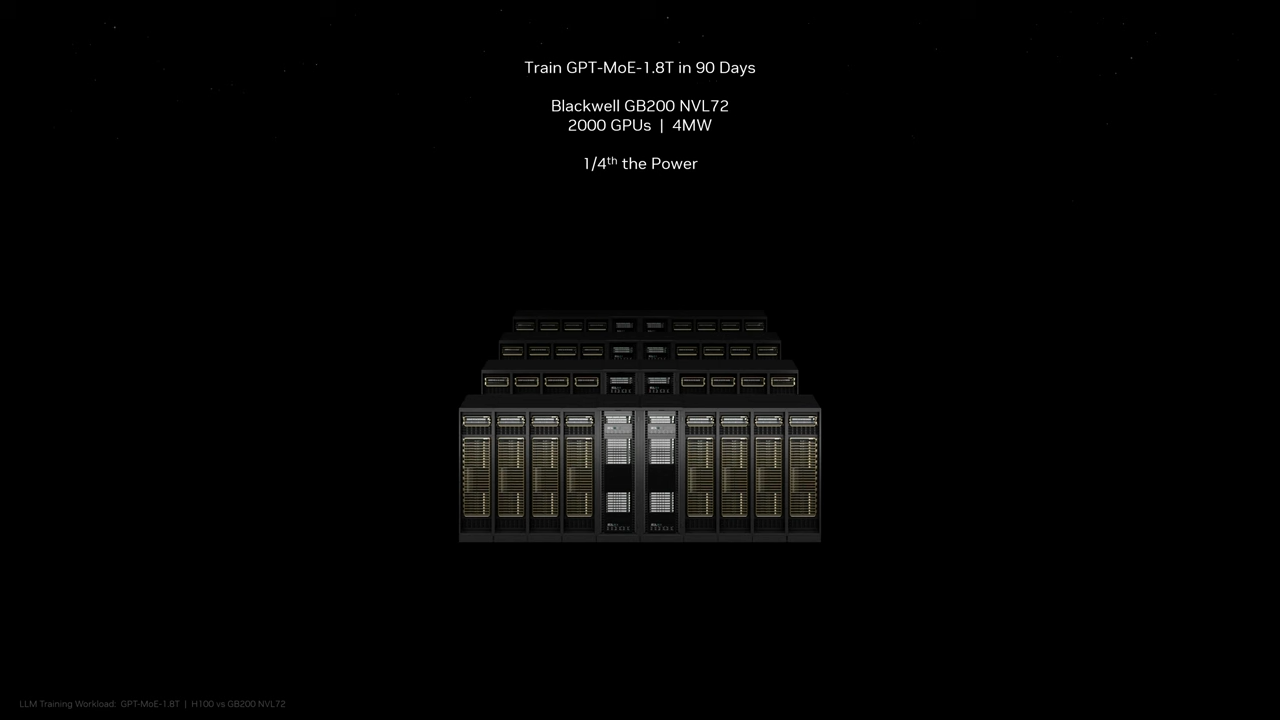

현재 GPT-4로 추측되는 GPT-MoE 1.8T를 Hopper로 훈련하는데 90일이 걸리고 8000 GPU에 15 메가와트를 사용한다고 합니다. 그런데 블랙웰을 사용하면 똑같이 90일에 2000GPU의 4MW로 약 1/4의 파워가 필요하다고 합니다.

와 이제 엑사플롭스의 시대가 온 걸까요. AI로 인해 그럼에도 불구하고 더 많은 컴퓨팅 파워를 필요로 하고 그것이 바로 돈과 연결되는 것 같습니다.

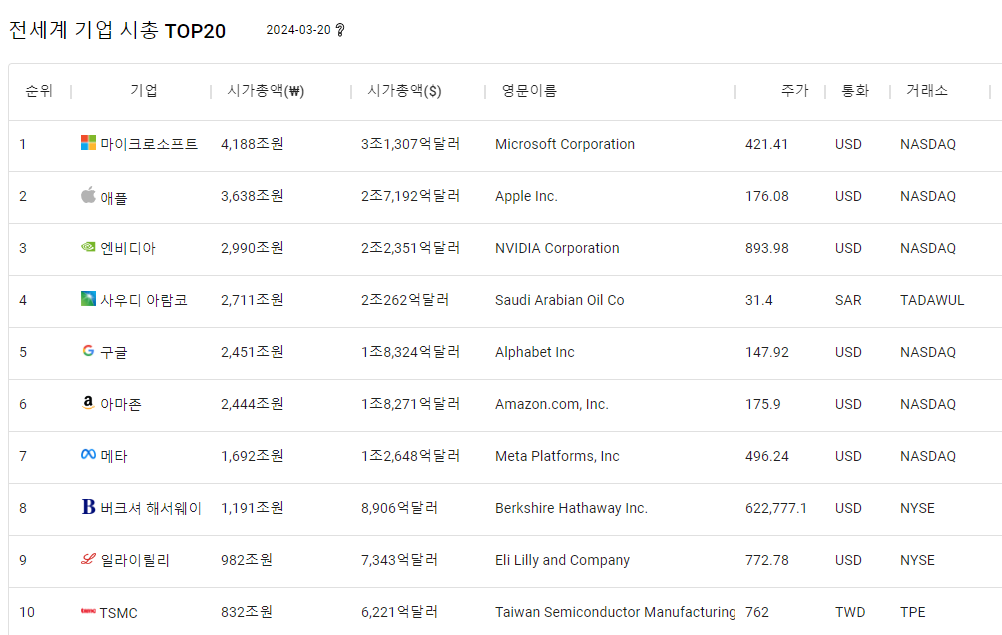

Nvidia

NVIDIA는 GPU가 포함된 그래픽 카드 등을 만드는 칩메이커입니다. 2024년 3월 20일 기준 전세계 시가 총액 3위에 포함된 어마어마한 기업입니다.

출처 : 전세계 기업 시가총액 Top 20 순위 - Top 20 Companies in the world by Market Cap Today)