제미나이 1.5 프로 - 백만 토큰 컨텍스트 러닝

Gemini 1.5 Pro

Mixture–of-Experts(MoE) 아키텍처 바탕. (신경망에서 가장 관련성이 높은 전문 영역 경로만을 선택적으로 활성화)

제미나이 1.0 울트라에 필적하는 성능.

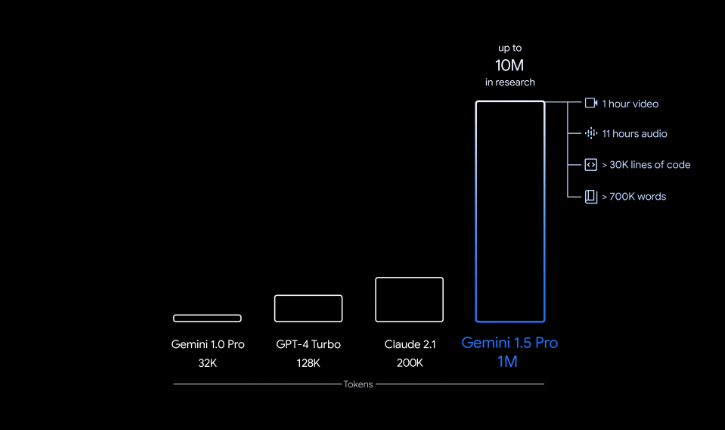

12만 8천개의 토큰 컨텍스트 윈도우. 일부 그룹에게 1백만 토큰 컨텍스트 윈도우 (context window) 제공하여 실험 중.

제미나이 AI 스튜디오 및 버텍스AI에서 제미나이 API와 함께 1.0 울트라를 활용해 개발을 시작할 수 있다.

이걸보면 1M까지 처리가 가능하다. 연구 상으로는 10M까지 처리가 가능하다고 한다.

이걸 활용하면 문맥 기반 학습(in-context learning) 기능을 활용할 수 있다.

우주선 아폴로 11호와 관련된 402페이지 분량의 텍스트를 입력하고 문서 전반에서 발견되는 모든 자세한 정보들과 대화, 사건, 이미지 등을 종합해 추론 가능.

44분 짜리 무성 영화를 입력해서 주요 줄거리 포인트 분석 및 디테일 추론.

구글 AI 스튜디오에서 대기자 등록해서 사용할 수 있다.

생각

gemini 1.5 프로도 의미가 깊은데 백만 토큰까지 처리할 수 있다고 한다. 예를 들어 우리가 어떤 일을 처리할 때 관련 정보를 그냥 같이 입력해 버리면 해당 일에 대해 LLM이 on the fly 로 학습을 하면서 문제를 해결할 수 있다. 여기에서 추가적으로 필요한 정보를 retrieval하거나 reasoning 이 발전한다면 정말 많은 문제들이 이걸로 풀릴 수 있을 것 같다.

딥마인드에 기대하는 것이 이 reasoning 부분인데 이 부분이 기초적인 사고를 할 수 있을 정도로 발달한다면 도대체 어디까지 가능하게 될까?

AI로 인한 변화는 내가 생각하는 것 보다 빠르고 심층적으로 진행되고 있다.