CES 2024 - AI가 모든 곳에 나타나다. (AI is everywhere.)

현재 미국 라스베가스에서 CES 2024가 열리고 있습니다. 한국 시간으로 1월 10일~1월 12일 진행됩니다. CES는 가전제품 전시회이지만 AI를 포함하여 최신 기술들을 볼 수 있는 장이기도 하지요. 그래서 첫날의 눈여겨 볼만한 점들을 살펴 봤습니다.

참고로 모든 라이브와 발표된 영상은 여기에서 확인하실 수 있습니다. CES 2024: How to watch live as Sony, Samsung and more reveal hardware, AI updates | TechCrunch

삼성

삼성은 AI와 연결된 세계에 대해 진심인것 같습니다.

Neo QLED 8K

삼성이 발표한 이 AI 스크린은 NPU를 탑재했습니다. 이 스크린은 AI 업스케일링과 AI Motion Enhancer가 가능하다고 합니다. 또 소리를 상세하게 하는 기능(Amplifier)이 있습니다. 함께 New premier 8K라는 프로젝터도 발표했는데 이 프로젝터는 세계 최초로 8K를 무선으로 전송할 수 있다고 합니다.

Neo 8K를 보면 홈 엔터테인먼트에서 AI로 영상, 게임 등을 향상시키는 방향으로 나아가는 것을 알 수 있습니다. 미래의 콘텐츠는 멀티미디어로 영상, 사운드가 종합적으로 사람들에게 전달될 것 같습니다.

볼리 (Ballie)

삼성의 AI 친구 로봇 볼리입니다. 집 안을 다닐 수 있고 위와 같은 방식으로 스크린을 쏴서 디스플레이를 표현할 수 있습니다. 영상 미팅이나 헬스 등을 할 때도 활용할 수 있습니다.

AI 냉장고

AI vision으로 냉장고에 어떤 재료가 들어가고 나오는지 파악을 할 수 있다고 합니다. 이렇게 파악이 된 재료는 냉장고의 전면 스크린에서 확인할 수 있습니다.

또 이를 바탕으로 삼성 푸드 앱은 새로운 레시피를 추천할 수 있고 삼성의 스마트 띵스와 연결될 수 있습니다.

그 밖에도 옷의 타입과 오염도를 자동으로 인지하는 세탁기, AI 기능이 탑재된 로봇 청소기를 소개했습니다.

삼성은 집을 기술과 AI를 활용해서 향상시키려는 것 같습니다. 제가 알게 된 것은 가전 제품에 LLM 뿐만 아니라 로봇 청소기의 물체 인식 등 작은 수준의 인공지능도 결합이 될 수 있다는 것입니다.

그 밖에 자세한 내용이 필요하시면 유튜브 요약본이나 아래 풀영상을 참고해 주세요.

LG

LG의 경우 AI를 어떻게 실제로 잘 적용하느냐에 중점을 두고 있는 것 같습니다. LG는 기술뿐만 아니라 인간에 대한 애정도 함께 철학에 담으려는거 같네요.

LG의 AI Brain

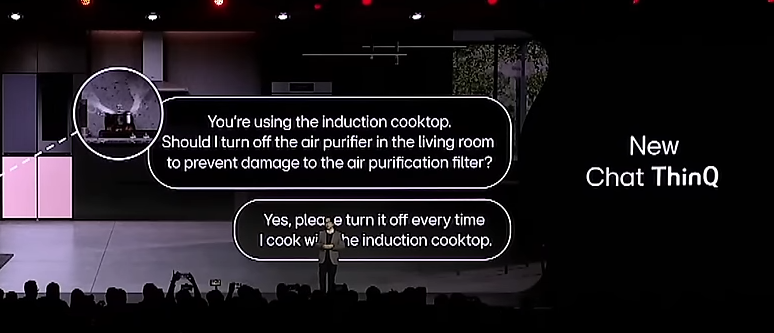

LG의 AI가 LG의 스마트 홈 시스템인 ThinQ에 포함될 것으로 보입니다.

ThinQ에 새로운 채팅을 사용하는 모습입니다. 예시로 AI가 인덕션을 사용하고 있기 때문에 공기청정기를 꺼야하는지 물어보고 있고 사람이 끄라고 이야기하는 모습이네요.

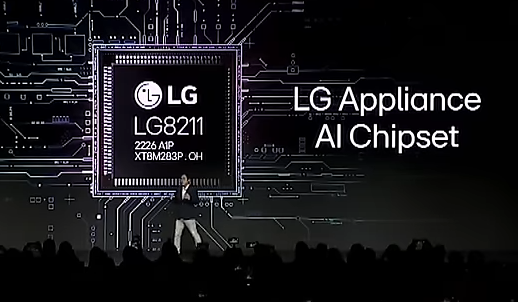

LG의 AI 칩셋

LG가 개발한 가전 AI 칩셋입니다. 이 칩셋이 AI 가전 제품에 포함되어 활용될 것으로 보입니다.

스마트 홈 AI 에이전트

LG의 Smart home agent는 두 발로 다니는 AI 로봇입니다.

마이크, 카메라, 멀티모달 기능이 있어 집 안을 이해하고 사람들과 커뮤니케이션할 수 있습니다. 반려동물을 대체하려는 걸까요...

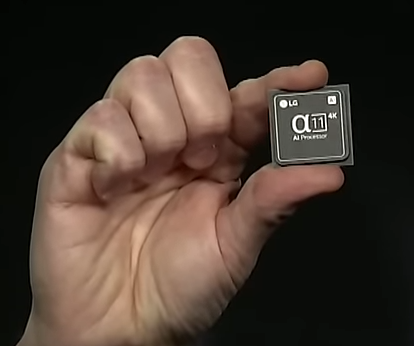

LG OLED TV와 Alpha 11 AI 프로세서

Alpha AI 프로세서는 LG가 오직 올레드만을 위해 개발하고 있는 브랜드입니다. CES에서 11 버전을 공개했습니다.

OLED만을 위한 AI 칩. (보고 있나, 삼성?)

OLED는 각 픽셀이 자체발광할 수 있어 검은색을 온전히 표현할 수 있고 높은 명암비와 선명한 색상을 표편할 수 있는 기술입니다. (보통 LCD 보다 비싼 편입니다.)

OLED T

LG의 투명 올레드 TV입니다. 저는 이게 제일 신기했네요.

이런 식으로 투명한 디스플레이 위에 화면을 표시할 수 있습니다. 이게 가능한 이유가 올레드가 백라이트 없이 픽셀 별로 빛을 낼 수 있는 장치이기 때문이지요.

그 외에도 차량용 시스템, 웹OS 등 다양한 것들을 소개했습니다. 자세한 내용이 필요하시다면 요약본이나 유튜브 영상을 참고해 보세요.

Rabbit의 r1 포켓

대기업들의 화려한 쇼케이스도 있지만 꼭 뛰어난 언더독이 나타나 눈길을 끌지요. 그 중 하나가 바로 래빗의 r1 포켓입니다.

r1은 사용자가 간단한 작업 (차량 호출, 식사 장소 탐색, 숙소 찾기 등) 을 할 때 핸드폰이 아닌 r1을 사용할 수 있는 기기입니다.

출처 : 래빗 홈페이지

r1에게 이야기를 하면 r1이 실행 후 결과를 음성으로 이야기합니다. rabbit은 자체 "large action model" (LAM)을 개발하여 마치 사람이 웹사이트와 모바일 앱 상의 버튼을 클릭하여 작업을 수행할 수 있다고 합니다.

이미 다양한 앱과 서비스들에 대해 학습되어 지원됩니다. 만약 알지 못하는 앱이 있다면 사용자가 앱을 사용하는 것을 보고 배울 수 있다고 합니다. (이 부분은 런칭 때는 제공되지 않았습니다.)

가격은 200달러라고 합니다. 이 장치를 만든 곳은 스웨덴의Teenage Engineering이라고 합니다. 현재 미국에서 3월 말 출시를 목표로 예약 주문을 받고 있다고 합니다.

레빗의 키노트 전체 영상은 여기에서 볼 수 있습니다. rabbit — keynote

실제 사용평은 그렇게 좋지는 않네요.

생각

AI를 정말 여러 군데에서 만날 수 있게 될 것 같습니다. 가전, 로봇, 인프라까지 광범위하게 AI가 적용될 것으로 보입니다.

그리고 래빗의 r1과 같은 말로 AI와 소통할 수 있는 기기는 잘 통할 것 같습니다. 그게 어떤 형태가 될지는 모르겠지만 이어폰, 스피터, 작은 기기의 형태로 분명히 사람들에게 등장하고 많이 쓰이게 될 것 같습니다. 얼마 전 마이크로소프트에서 키보드에 코파일럿 키를 추가했는데 이와 비슷하게 스피커가 컴퓨터나 스마트폰 앞에 등장하여 조종할 수 있을 것 같네요.

한 가지 더 느낀 것은 앞으로의 커뮤니케이션이 음악, 이미지, 동영상 등 다양한 멀티미디어를 사용하여 사람들의 감정과 마음을 울리는 방식이 될 것이라는 점입니다. CES 발표에 멋진 멀티미디어를 사용하여 영화처럼 홍보하는 기업들이 많았습니다.

여러분은 어떠셨나요? 앞으로 우리의 앞에 AI가 어떤 모습으로 나타나게 될까요?