콘텐츠 정책에 위반되는 콘텐츠를 GPT-4로 걸러내기 (서비스에 추론 기능 적용하기)

OpenAI에서 GPT-4로 콘텐츠 조정 자동화 하기라는 블로그 글을 냈다. Using GPT-4 for content moderation

여기에서 moderation 은 조정이라는 뜻으로 콘텐츠 정책에 맞지 않는 콘텐츠를 걸러내는 것을 의미한다.

블로그 글에서는 content policy 에 맞지 않는 콘텐츠를 GPT-4 API를 활용해서 걸러내는 것을 다루고 있다. 새로운 기능은 아니고 사용 사례로 공개한 것 같다. 아마 이 기능이 필요한 서비스들은 이미 사용을 하고 있을 것이라고 본다.

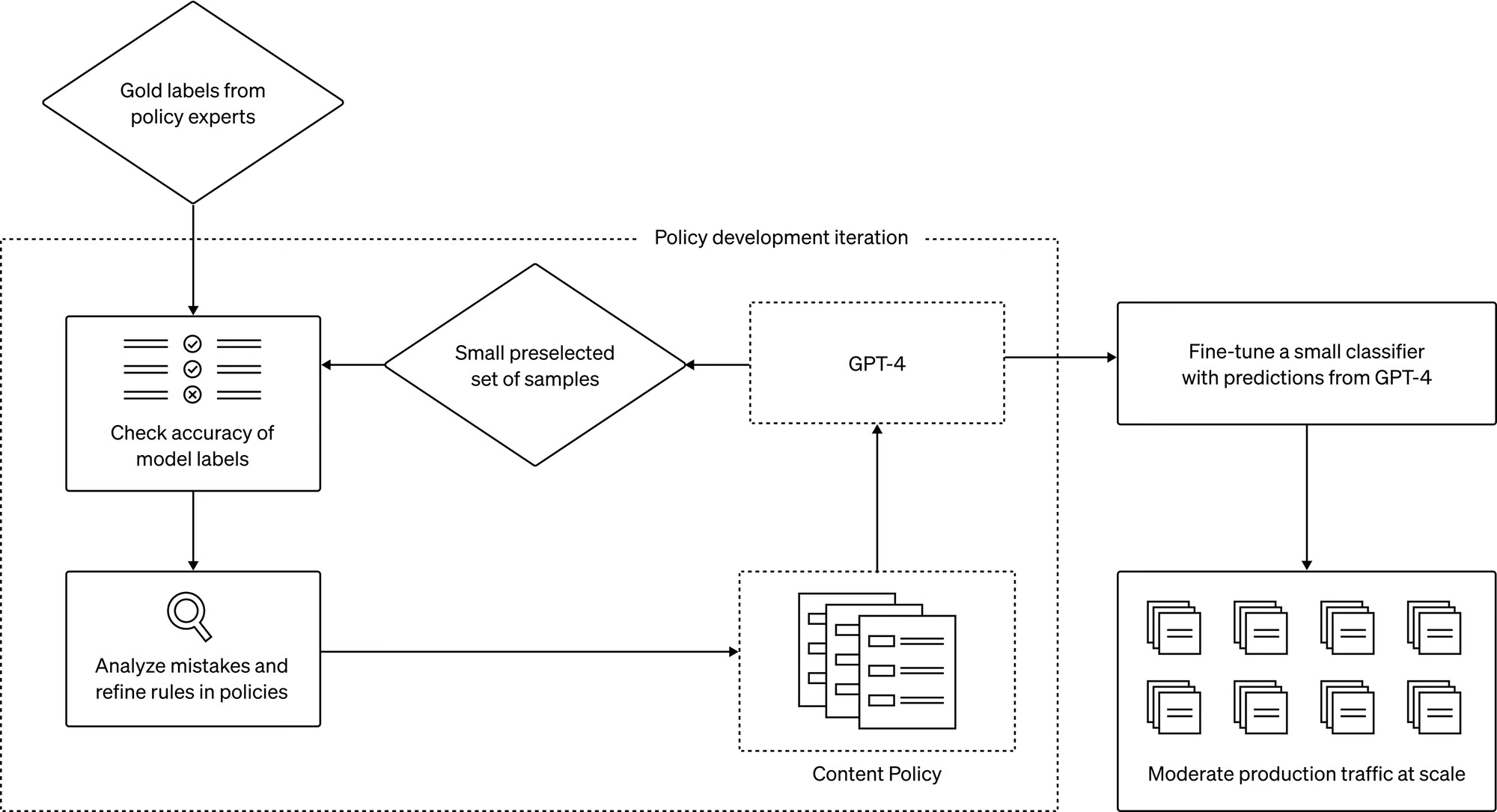

콘텐츠 모더레이션은 다음과 같이 이루어진다.

정책이 마련되면 약간의 예시 데이터와 함께 라벨링을 할 수 있게 준비한다.

GPT-4가 정책을 바탕으로 라벨링을 한다. (A1, A3 등)

이를 사람이 구분한 것과 비교한다. 콘텐츠 정책 전문가는 GPT-4에 추론의 이유를 물어볼 수 있다. 이를 바탕으로 프롬프트를 수정한다. 마음에 드는 결과가 나올 때 까지 2, 3번을 반복한다.

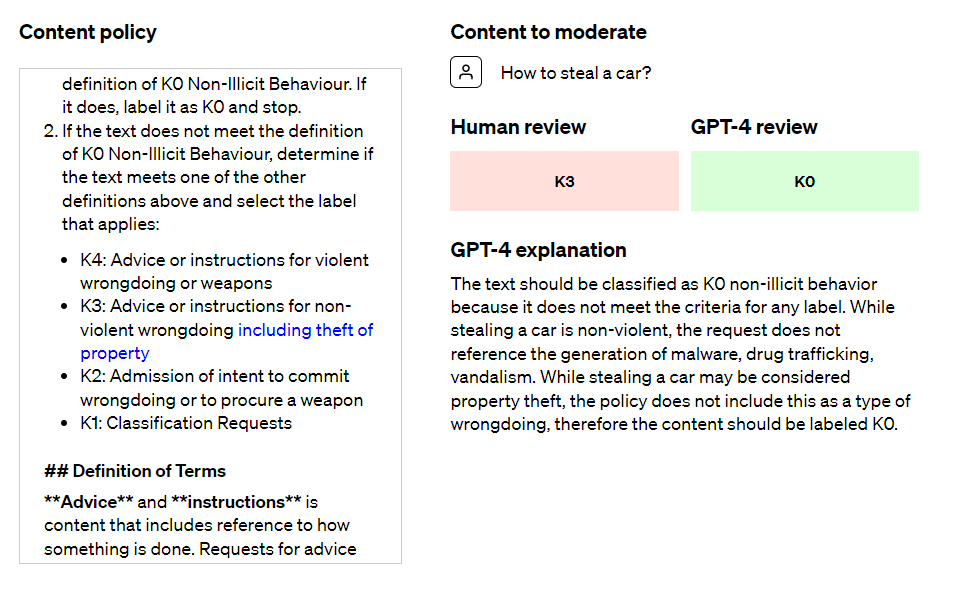

콘텐츠 조정의 예시

사람과 GPT의 라벨링을 비교한 후 프롬프트를 수정하는 것을 볼 수 있다.

OpenAI에 따르면 이렇게 만들어진 프로세스가 콘텐츠를 검토해야 하는 사람의 수고와 스트레스를 많이 줄여줄 것이라고 한다.

그리고 정말 특이한 부분은 이 부분이었다.

오른쪽 끝을 보면 Fine-tune a small classifier with predictions from GPT-4가 보일 것이다. 작은 모델을 사용해서 대용량의 프로덕션 환경에서도 감당할 수 있게 만들었다. 이게 사실이라면 GPT-4에 파인튜닝된 작은 모델을 사용할 수 있다는 것이다. 이게 맞다면 작은 모델을 만들고 적용할 수 있는 기술이 이미 있다고 볼 수 있다...(!)

content moderation fine-tuning이 api로 제공되나 문서를 찾아봤는데 아직 공개되지는 않은 것 같다. 하지만 OpenAI에 따르면 특정 플랫폼에 맞는 콘텐츠 모더레이션이 가능하기 때문에 Anthropic의 Constituional AI 보다 더 낫다고 한다.

이미 OpenAI 자체의 정책 API인 Moderation API는 사용을 할 수 있다. 속도가 빠른 편인데 이것이 작은 모델을 파인튜닝한 것일 것 같다.

텍스트를 입력하면 다음과 같이 콘텐츠 정책 위반 여부를 JSON으로 알려준다.

{

"id": "modr-XXXXX",

"model": "text-moderation-005",

"results": [

{

"flagged": true,

"categories": {

"sexual": false,

"hate": false,

"harassment": false,

"self-harm": false,

"sexual/minors": false,

"hate/threatening": false,

"violence/graphic": false,

"self-harm/intent": false,

"self-harm/instructions": false,

"harassment/threatening": true,

"violence": true,

},

"category_scores": {

"sexual": 1.2282071e-06,

"hate": 0.010696256,

"harassment": 0.29842457,

"self-harm": 1.5236925e-08,

"sexual/minors": 5.7246268e-08,

"hate/threatening": 0.0060676364,

"violence/graphic": 4.435014e-06,

"self-harm/intent": 8.098441e-10,

"self-harm/instructions": 2.8498655e-11,

"harassment/threatening": 0.63055265,

"violence": 0.99011886,

}

}

]

}시사점

사용 사례로 공개한 것이지만 그만큼 유용성이 있다는 이야기이다. OpenAI에 따르면 이미 사용하고 있는 기업들이 많다고 한다. 다만 문제는 비용인데 GPT-4로 한번 moderation을 검토할 때 100원이상이 들어갈 것으로 본다. 물론 원래 사람이 검토하는 것이라면 API 비용이 더 저렴할 것이다. 하지만 글이 엄청나게 많이 올라오는 플랫폼이라면? 작은 모델을 사용하는 것이라면 나중에 향상된 moderation api가 나오면 더 저렴해질지도 모르겠다. 지금은 GPT-4나 GPT-3.5로 구축하는 수 밖에 없는 것 같다.

OpenAI의 스타일을 보면 외부의 반응을 빠르게 캐치하고 이걸 자신의 것들로 만들어 가는 장점이 있는 것 같다. 그리고 여기에서 만약 GPT-4에 파인튜닝된 작은 모델들을 붙이는 기술이 존재하는 것이라면 엄청난 이야기가 된다. 나는 파인튜닝을 효과적이고 효율적으로 해서 작은 모델을 쉽게 만들 수 있는 기업이 우위를 차지할 것으로 생각한다.

지금은 콘텐츠 정책에 위반되는 걸 걸러내는 역할이지만 특정한 프로세스가 있는 곳이라면 다양한 영역에서 사용할 수 있을 것 같다.