구글의 새로운 로봇 RT-2 : 비전과 언어를 행동으로 옮기는 인공지능 모델

Robotic Transformer 2 (RT-2)

RT-2는 시각 정보와 언어 정보를 행동으로 바꿀 수 있는 인공지능 모델입니다. 웹과 로보틱스 데이터에서 학습을 해서 지식을 일반화해서 로봇의 행동으로 옮길 수 있습니다. (VLA : vision-language-action)

이미지 출처 : 구글 딥마인드 블로그

LLM과 유사한 언어능력으로 사물을 인식하고 행동에 대한 계획을 세울 수 있습니다. 예를 들어 쓰레기를 인식하고 이를 버리는 행동에 대한 계획을 세우고, 이를 행동 데이터로 바꿀 수 있는 것이지요. 기존에는 이런 일을 하려면 해당 Task에 대한 트레이닝이 필요했습니다.

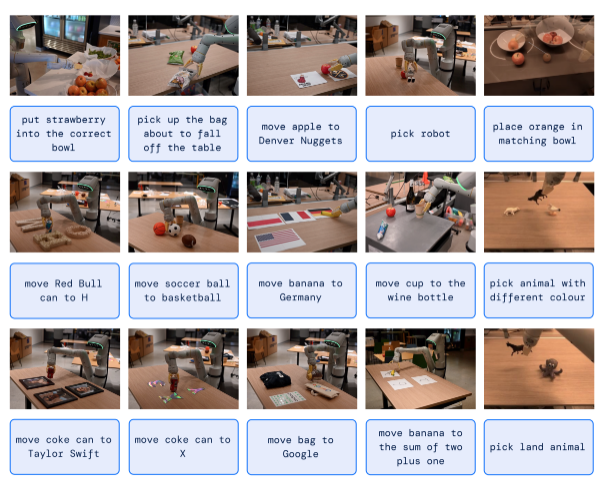

웹의 데이터에서 학습한 일반화된 지식을 가지고 다음과 같이 처음보는 일을 할 수 있었다고 합니다.

딸기를 맞는 그릇에 넣기.

테이블에서 떨어지려고 하는 봉투 잡기.

음료수 캔을 H로 옮기기 등

이렇게 처음보는 행동을 할 수 있는 성공률이 높아졌다고 합니다. RT-1의 경우 32%에서 RT-2는 62%로 증가.

그 밖에 chain of thought prompting을 활용하여 복잡한 문제를 중간 추론 단계로 나누어 진행할 수 있도록 했다고 합니다.

로봇도 인공지능에 있어 주요 요소로 등장할 것 같습니다. 이번 사례는 LLM의 추론 능력을 로봇의 움직임에 실제 적용한 사례라고 볼 수 있습니다. (reasoning + actions)

#인공지능#ai#로봇