StabilityAI에서 FreeWilly 2 공개 - LLaMA 2의 SFT 버전

Stability AI가 Llama2를 파인튜닝한 모델인 FreeWilly 1 과 FreeWilly 2 를 선보였습니다.

프리윌리1은 기존의 LLaMA 65B 모델을 Supervised Fine-Tune (SFT) 한 모델입니다.

마찬가지로 프리윌리2도 LLaMA2 70B 기초 모델을 파인튜닝 한 모델입니다. LLaMA2가 발표된 지 얼마 되지 않았는데 대단하네요.

모두 연구 목적으로 공개된 모델입니다.

모델의 훈련은 Microsoft의 "Orca: Progressive Learning from Complex Explanation Traces of GPT-4" 논문의 방법론을 참고하였다고 하네요. 하지만 데이터 출처는 다르고 여러 데이터셋에서 높은 품질의 지시(high-quality instructions)를 사용하여 60만개의 데이터 포인트를 만들어 냈다고 합니다. 사용된 데이터의 양은 Orca의 약 10% 라고 하네요. Orca 처럼 LLM이 생성한 합성 데이터를 지시로 사용한 것 같습니다.

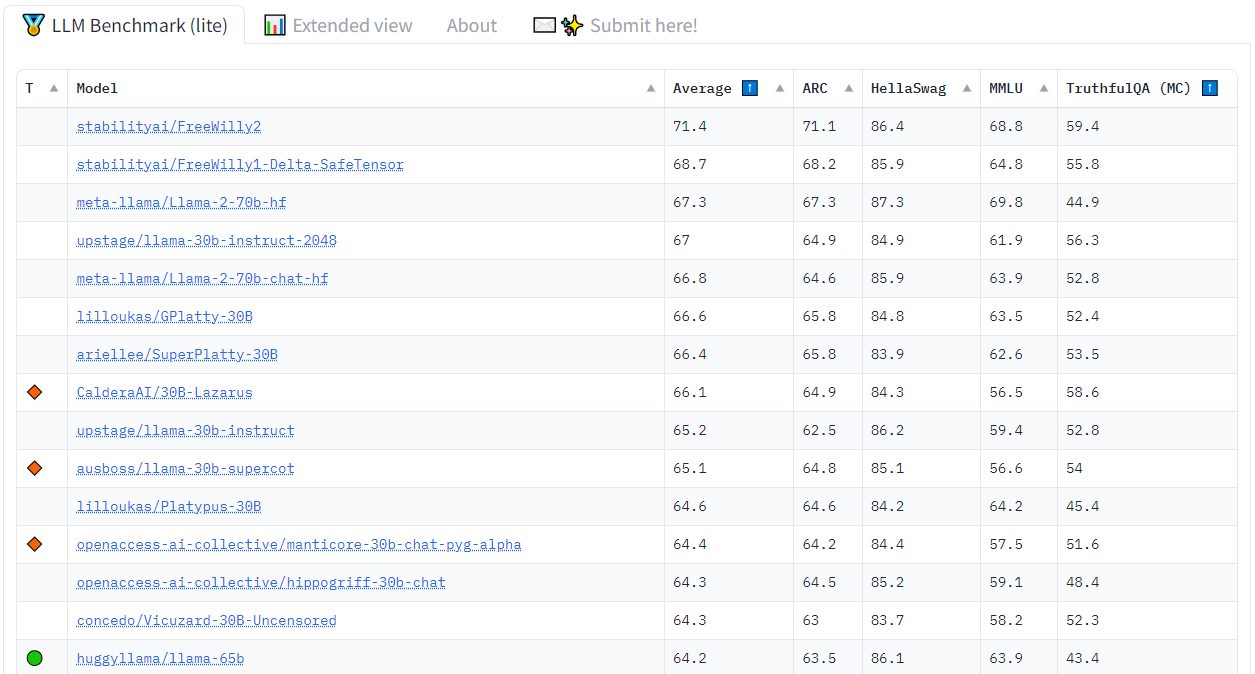

현재 기준(2023년 7월 25일) 으로 Open LLM Leaderboad 에서는 1위를 차지하고 있네요.

이미지 출처 : Open LLM Leaderboard - a Hugging Face Space by HuggingFaceH4

참고로 한국에서 업스테이지에서 튜닝한 llama-30b-instruct-2048 이 4위를 차지하고 있네요. 대단합니다. llama2도 아니고 llama로 파인튜닝한 모델이네요.

프리윌리에 대한 전체 내용은 stability ai 홈페이지에서 확인할 수 있습니다. Meet FreeWilly, Our Large And Mighty Instruction Fine-Tuned Models — Stability AI

현재는 이름을 beluga 로 바꿨다고 하네요.