runway gen1 사용해 보기 - video to video 변환 인공지능 모델

runway의 Gen-1은 Video to video 모델이다. 비디오 인풋에 이미지, Presets(사전 설정), 프롬프트를 적용해서 비디오 아웃풋을 만들어 주는 인공지능 모델이다.

오늘 공식 런칭했다고 해서 사용해 봤다.

비디오 이미지 인풋을 입력한다.

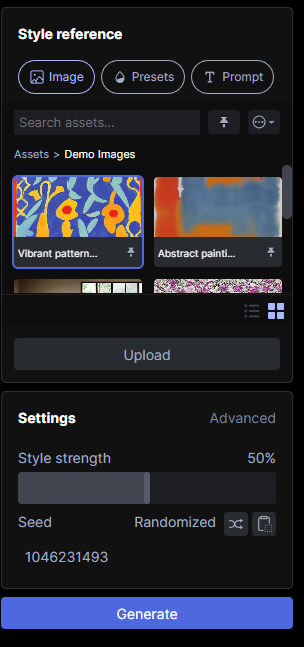

이런 스타일을 입력할 수 있다. 이미지, 프리셋, 프롬프트. 이렇게 셋 중 하나를 선택해서 입력할 수 있다.

Image

나는 이미지 중 Vibrant pattern을 입력해 봤다.

이런 식으로 해당 이미지의 스타일이 동영상 전체에 반영된다. 3초 짜리 아웃풋이 나왔다. 처음 사용하면 약 30초 정도 사용할 수 있는 400 크레딧을 준다. 이 정도면 10번 정도 만들어 볼 수 있다.

preset

샘플 영상에 Pen and Ink 프리셋을 적용해 본 결과

prompt

프롬프트를 사용해서 동영상에 변화를 줄 수 도 있다.

위의 데모 영상에 make her moving을 입력해 봤다.

사람이 바뀌었고 뒤 배경에 움직이는 사람들이 추가되었다.

생각

텍스트를 입력하면 동영상을 만들어주는 걸 생각했는데 그런 건 아닌것 같다. 텍스트에서 동영상을 생성해 주는 것은 gen-2라고 한다. gen-1과 gen-2의 차이점은 gen-1은 입력 데이터 소스가 필요하지만 gen-2는 입력 데이터 소스가 필요하지 않다.

runway는 크레딧 (유료) 을 요구한다. 사용성에 먼저 집중했으면 좋았을것 같은데... 아무래도 리소스 사용하는 것들이 공짜는 아니니깐 그런거겠지? 물론 무료 크레딧도 제공하니 충분히 사용해 볼 수 있다. 하지만 runway는 관심을 가지고 지켜보고 싶은 서비스 중 하나이다. 난 서비스에 있어 나에게 가치를 제공해 준다면 충분히 지불할 의향은 항상 있다.

어디에 써야 할지는 아직은 잘 모르겠다. 조금 더 생각해 봐야 할 것 같다.

동영상을 인공지능을 활용해서 변화를 준다는 것에 의미가 있는 것 같다.