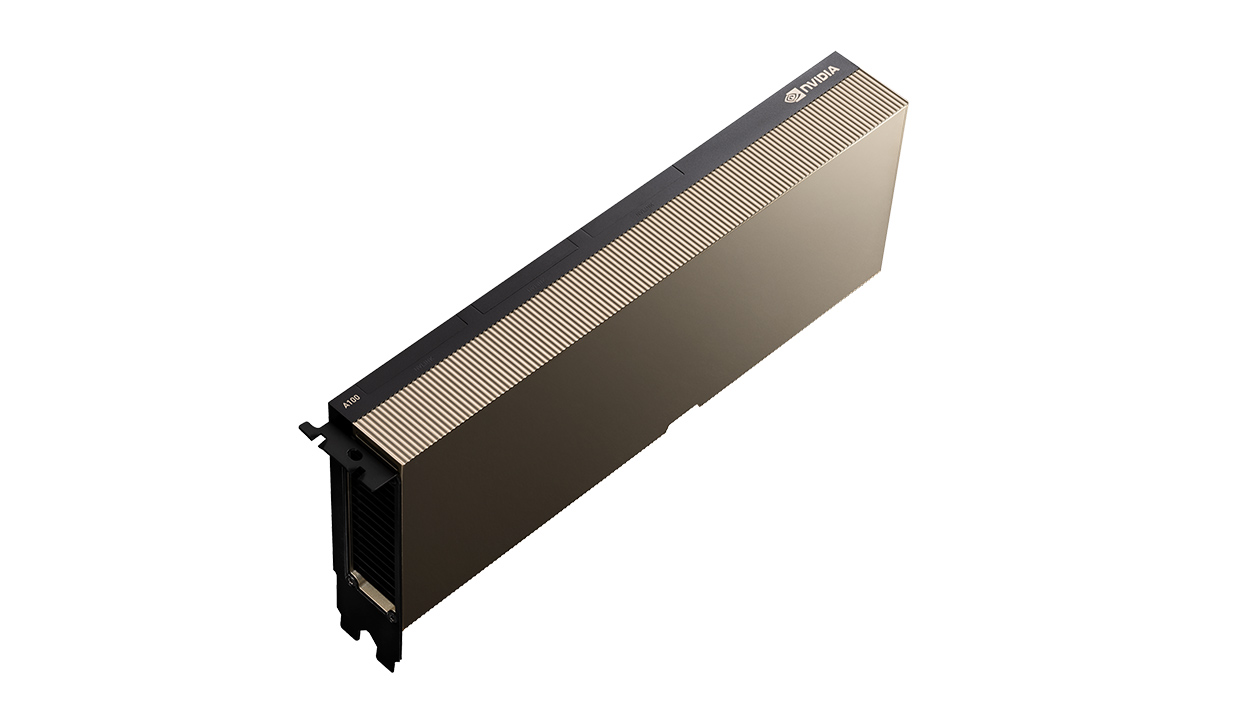

Nvidia A100, H100 - 고성능 GPU

A100 : NVIDIA의 GPU로 40GB 메모리 버전과 80GB 메모리 버전이 있다. 최대 7개의 GPU 인스턴스로 변환할 수 있다. 인공지능 훈련과 데이터 분석 등에 쓰인다. 40GB의 경우 한화로 약 1천만원 정도이고 80GB의 경우 약 15000달러로 한화 약 1900만원 정도이다.

참고로 NVIDIA Tesla T4 D6 16GB의 경우 약 250만원이다.

H100 : NVIDIA H100 Tensor 코어 GPU이다. 최대 256개의 H100을 연결하여 전용 트랜스포머 엔진으로 매개 변수가 조 단위인 언어 모델을 처리할 수 있습니다. 엔터프라이즈 AI에 사용할 수 있다. 하나의 GPU 메모리는 80GB 이다. NVIDIA H100 Tensor 코어 GPU

4세대 Tensor 코어는 FP64, TF32, FP32, FP16, INT8, 그리고 이제 FP8도 포함해 모든 정밀도에서 속도를 개선하여 대규모 언어 모델의 정확도를 유지하면서 메모리 사용량을 줄이고 성능을 향상합니다.

FP 64란? FP 64는 64비트 부동 소수점 형식을 의미한다. FP 64는 double-precision floating-point format으로 64 비트의 컴퓨터 메모리로 소수점이 있는 숫자를 표현하는 방법이다. 매우 크거나 작은 숫자를 높은 정확도로 저장할 수 있다.

TF 32란? NVIDIA에서 새로 도입한 데이터 타입으로 FP32의 대안으로 사용되는 single-precision floating-point format이다. TF32는 텐서 코어에서 행렬 곱셈과 합성곱과 같은 연산을 빠르게 수행할 수 있습니다

텐서 코어란? NVIDIA GPU에 탑재된 특수한 연산 유닛입니다. 텐서 코어는 행렬의 곱셈과 덧셈을 빠르게 수행할 수 있으며, 인공지능과 고성능 컴퓨팅 분야에서 사용됩니다.

INT8 데이터 타입이란? INT8은 딥러닝 모델의 인퍼런스를 위해 quantization 기법을 적용할 때 사용됩니다. quantization 기법(양자화 기법)이란 연산에 필요한 비트 수를 줄여서 연산 속도를 빠르게 하는 방법입니다. (INT8 데이터 타입의 범위는 -128부터 127까지의 정수를 나타낼 수 있는데 신경망 모델에서 사용되는 데이터의 범위는 -1과 1사이인 경우가 많다고 합니다.)

위의 정의는 bing chat을 활용하였습니다.

A100이나 H100은 엔비디아의 GPU로 인공 지능 학습 등에 활용할 수 있는 고성능 GPU 입니다. H100은 트랜스 포머 엔진과 클러스터 연결로 인공 지능 학습이나 추론을 위해 만들어진 초고성능 GPU라고 보면 될 것 같습니다.

NVIDIA A100의 사진

GPU 클라우드에 관심이 생겨서 알아봤습니다.

runpod 기준 A100 80GB는 시간 당 1.890~2.090달러 이네요. 시간 당 약 2달러 정도군요.

A100이나 FP64, INT8의 정의만 알아두어도 인공지능을 이해하는데 많은 도움이 될 것 같습니다.