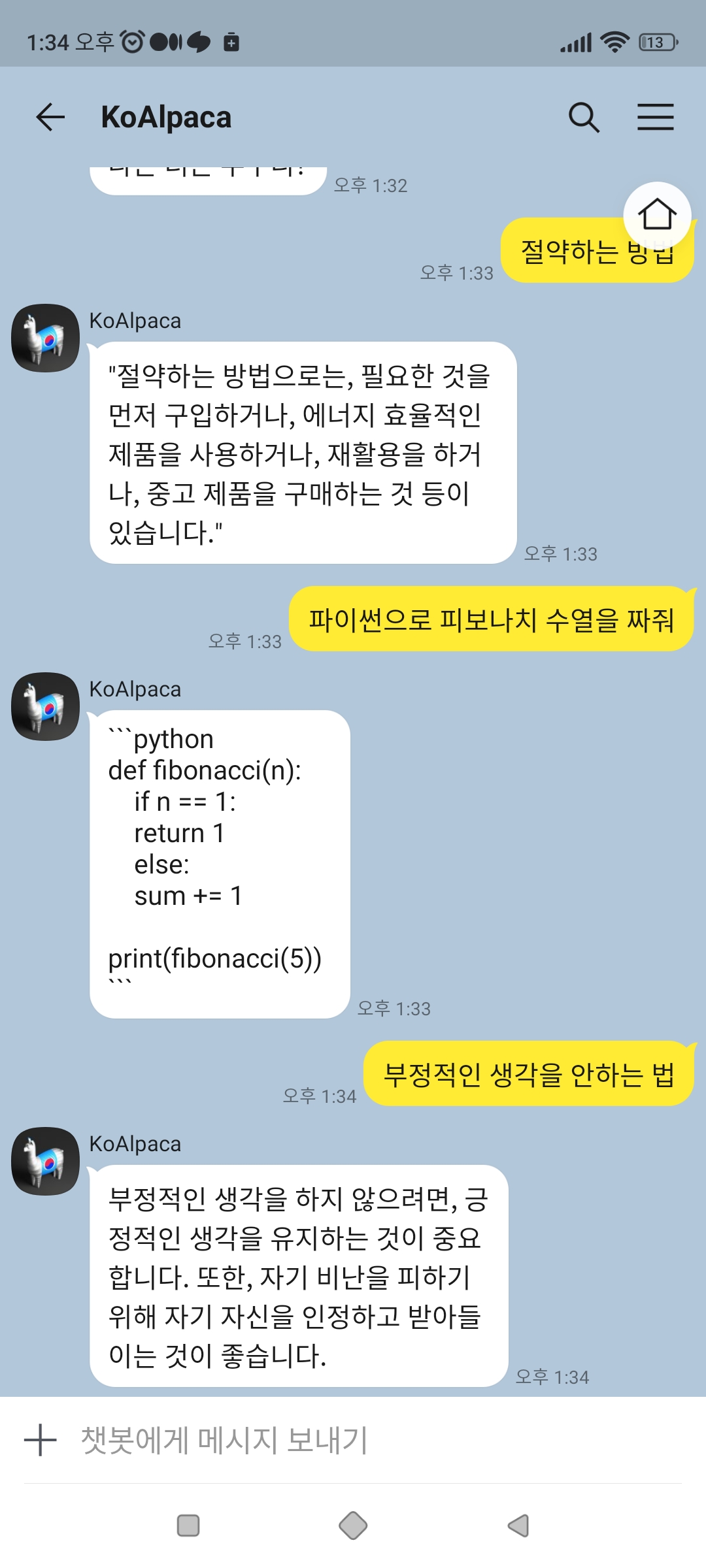

KoAlpaca - 한국어 LLaMA 모델

스탠포드의 알파카에 한국어를 학습시킨 모델

KoAlpaca는 백본 모델로 두 가지 모델을 사용

Polyglot-ko 5.8B 기반 -> https://huggingface.co/beomi/KoAlpaca-Polyglot

Meta LLAMA 7B 기반 -> https://huggingface.co/beomi/KoAlpaca

데이터셋은 Stanford Alpaca의 데이터셋을 DeepL API 서비스를 사용하여 instruction과 input을 번역. output은 애초에 text-davinci-003을 활용했기 때문에 번역하지 않음.

LLAMA 7B 모델학습은 A100 80GB 4대로 학습을 진행.

Polyglot-ko 5.8B 모델 학습 A100 80GB 1대로 진행.

와 진짜 대단하네요 ㅋㅋ Beomi 님이라고 AI/NLP 연구를 하시는 분이 하신것 같습니다. 진짜 놀랍습니다.

카카오톡 봇 : https://pf.kakao.com/_wdRxcxj

텔레그램 봇 : https://t.me/KoAlpacaBot

#인공지능#ai