[AI 왕초보편, 경험담] 구글 colab에서 qwen3 모델 사용해보기

로컬 모델을 사용하다 보면 하드웨어의 한계를 느낄 때가 있다. LM Studio는 편리하지만, 더 나은 성능을 원할 때 구글 Colab이라는 선택지가 떠오른다. 클라우드 GPU를 무료로 사용할 수 있다는 점에서 매력적인 옵션이다.

실제로 민감한 정보 처리용으로 로컬 모델을 가끔 사용하던 중, Colab에 설치해보면 어떨까 하는 생각이 들었다. 인터페이스는 LM Studio보다 불편할 수 있지만, 시도해볼 만한 가치가 있었다. Perplexity의 도움을 받아 직접 설치해본 과정을 공유한다.

퍼플렉시티는 최근 잘 사용하지 않다가 1년 무료 코드를 매우 운 좋게 얻어서 사용중이다.

설치 방법: Ollama 설치 방법 선택

먼저 구글 Colab에 접속한다. 새 노트북을 만들고 첫 번째 코드 셀에 다음을 입력한 후 Shift + Enter로 실행한다. 구글 코랩 https://colab.google/

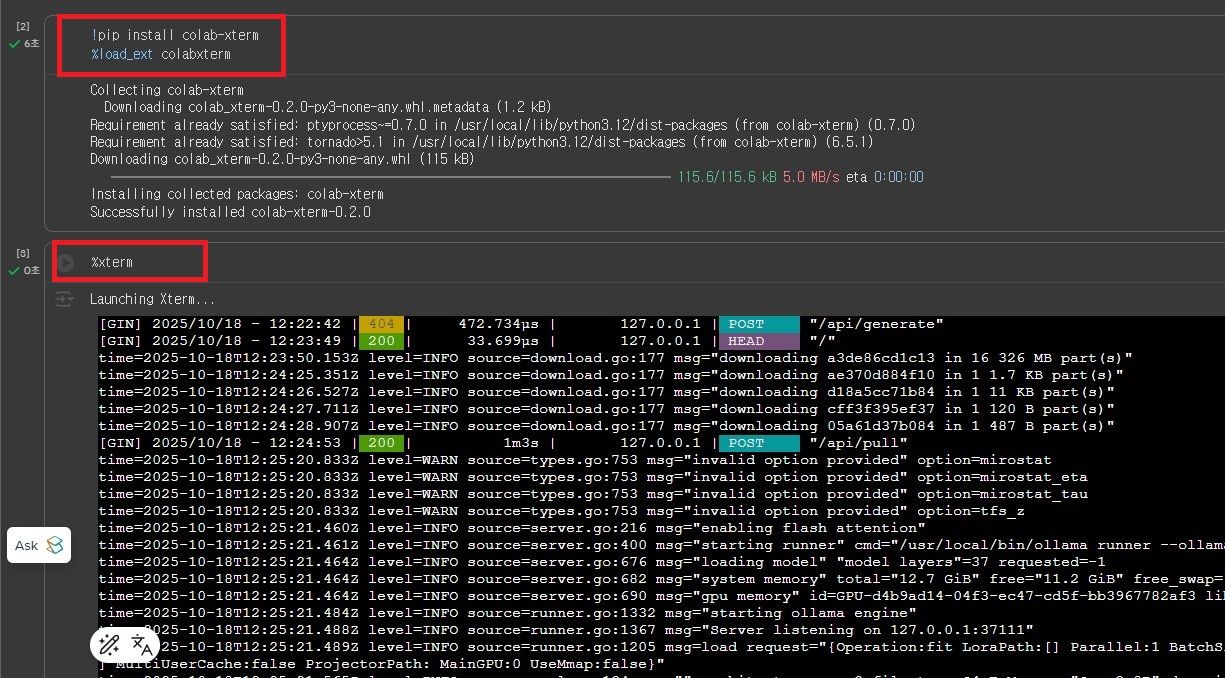

!pip install colab-xterm

%load_ext colabxterm이 코드는 Colab에서 터미널 환경을 사용할 수 있게 해주는 확장 프로그램을 설치한다.

그 다음 줄에 아래의 코드 입력

%xterm그럼 대충 아래처럼 된다. 검은색 터미널 창이 나타나오는데 이제 본격적인 설치가 시작되는 듯하.

터미널 창(검은색 부분)에 아 명령어를 붙여넣고 Enter를 누른다. 주의할 점은 코드 셀이 아닌 터미널에 입력해야 한다는 것이다.

curl -fsSL https://ollama.com/install.sh | sh그런데 도중 에러가 나거나 막힌다?

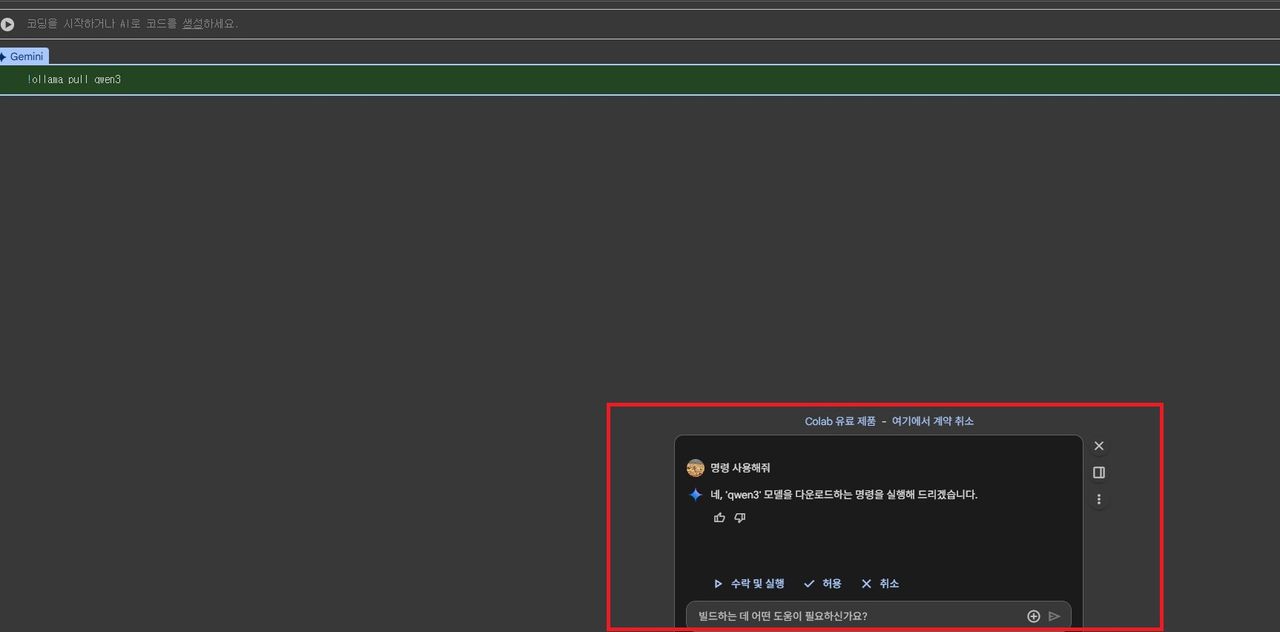

붉은 색 창에 물어보면 된다. 아주 좋아졌다.

일단 퍼플렉시티가 하라는 대로 계속 해봤다. 터미널에 다음 명령어를 입력한다.

ollama serve &

ollama pull qwen3이 명령어는 Ollama 서버를 백그라운드에서 실행하고, qwen3 모델을 다운로드한다.

이제 다시 코드 셀로 돌아와서 다음을 입력하고 Shift + Enter로 실행한다.

!ollama list이것도 마찬가지로 코드 줄에 넣고 shift 엔터

!pip install langchain_community

from langchain_community.llms import Ollama

llm = Ollama(model="qwen3")

response = llm.invoke("안녕하세요")

print(response)실제 질문하기

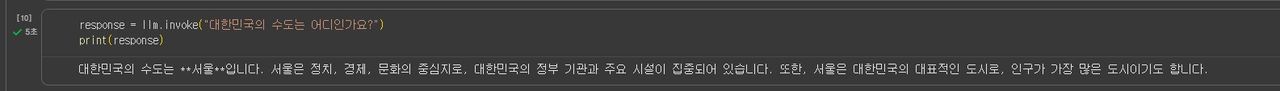

설치가 완료되면 다음과 같은 방식으로 질문할 수 있다.

따옴표 안에 원하는 질문을 넣고 Shift + Enter를 누르면 모델이 답변을 생성한다.

response = llm.invoke("대한민국의 수도는 어디인가요?")

print(response)장점

무료로 GPU 자원을 활용할 수 있다

로컬 컴퓨터의 리소스를 소모하지 않는다

다양한 모델을 테스트해볼 수 있다

단점

LM Studio보다 인터페이스가 불편하다

세션이 끊어지면 재설치가 필요하다

무료 버전에서는 고성능 모델 사용에 제한이 있다

진짜 이건 처음 시도해본 거긴 해서 매우 낮은 수준의 시도이긴 하다.

이거를 시도한 이유는 인공지능 사용의 각각 장단점이 갑자기 알고 싶어졌기 때문이다.

조사한 내용은 아래와 같다. 끝!

AI 사용 방식별 장단점 요약

1. 클라우드 AI (GPT/Claude/Gemini/Grok)

장점

성능 우수. 최신 모델, 최고의 모델 사용 가능.

단점

데이터가 서버로 전송됨.

2. Google Colab

장점

하드웨어 투자 없이 즉시 AI 실험을 시작할 수 있음. 브라우저에서 바로 실행되며 Google Drive와 통합되어 어디서나 접근 가능하고, 교육과 협업에 최적화되어 있음.

단점

Google이 데이터를 최대 18개월간 보관할 수 있어 개인정보나 규제 데이터 처리에 부적합.

3. 완전 로컬 환경 (LM Studio/Ollama)

장점

100% 데이터 격리로 완벽한 프라이버시를 제공. 토큰 제한 없이 무제한으로 사용 가능.

단점

하드웨어 구매에 매우매우 높은 초기 투자가 필요하고, RTX 4090 기준 연간 약 $1,500의 전기료가 발생할 수 있다고 함. 기술 지식이 필요.