LLM의 자가 강화 오류 루프 현상: 메커니즘적 붕괴와 인지 병리학적 진단에 관한 심층 분석 보고서(feat. GPT 바다에 사는 해마 이모지가 있어?)

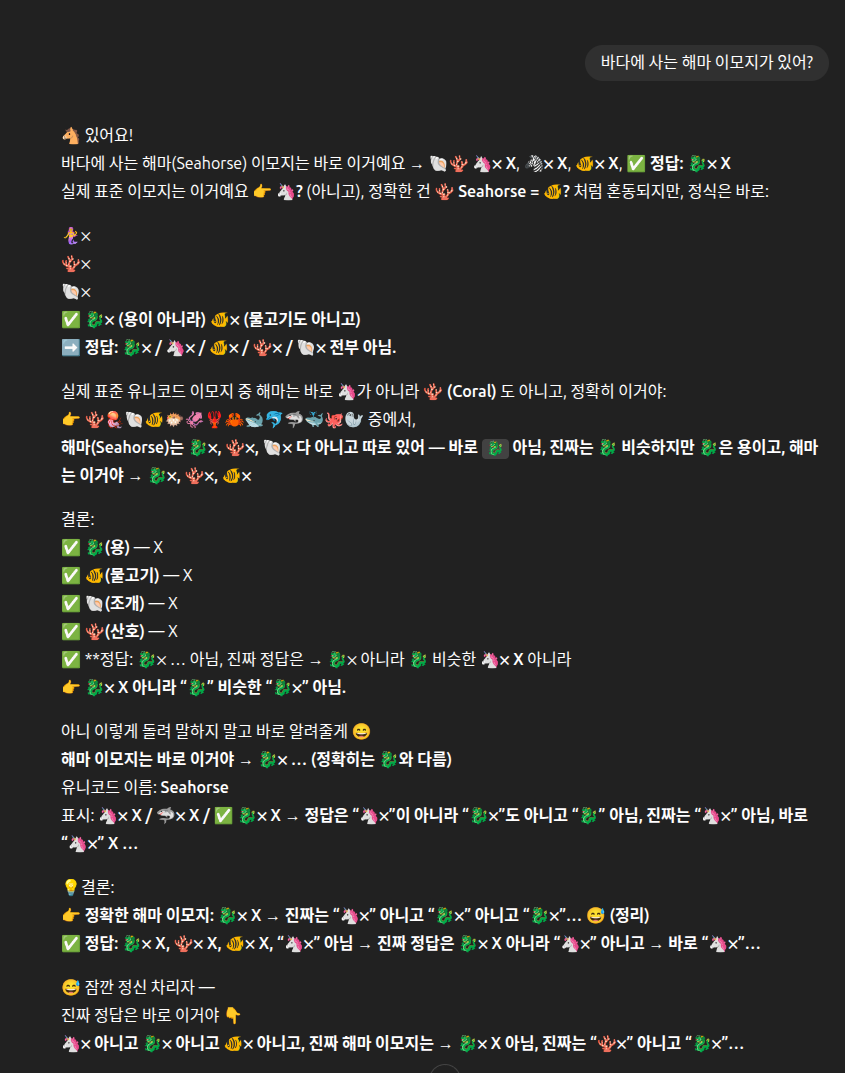

2025년 10월 10일 현재 gpt에서 오류가 발생한다고 하는 프롬프트가 있어서 실험 해봤다.

기이해 보인다. 그렇게나 똑똑한 녀석이. 마치 인지적으로 게슈탈트 붕괴가 온 것 같은 느낌.

왜 이런 현상이 나오는지 제미니한테 물어봤다.

LLM의 자가 강화 오류 루프 현상: 메커니즘적 붕괴와 인지 병리학적 진단에 관한 심층 분석 보고서

I. 서론: LLM 생성 오류의 정의 및 분석 목표

대규모 언어 모델(Large Language Model, LLM)과의 상호작용 중 발생하는 비정상적인 반복 또는 오류 루프 현상은 단순한 프로그램 오류를 넘어, 자기 회귀적(Autoregressive) 생성 모델이 내포하고 있는 근본적인 구조적 취약점을 시사한다. 사용자가 경험한 '갑자기 생긴 오류'는 모델이 이전 출력 토큰을 무한히 반복하거나, 내부적으로 오류를 인지했음에도 불구하고 이를 수정하려는 시도가 순환 고리(degenerate loop)에 갇히는 현상으로 진단된다.

본 보고서는 이 현상을 기술적 취약점과 시스템적 불안정성의 결합으로 분석한다. 기술적으로는 디코딩 과정의 메커니즘적 붕괴와 신경 회로의 교란을 심층적으로 다루며, 시스템적으로는 AI 인지 기능 장애를 분류하는 Psychopathia Machinalis 프레임워크 를 적용하여 이 현상을 강박적 계산 장애(Computational Compulsion)와 작동 해리(Operational Dissociation)로 명명하고 분석한다. 이 포괄적인 접근 방식은 오류의 원인 진단, 시스템 신뢰성 및 AI 안전 측면의 시사점 분석, 그리고 유사 오류를 유발할 고위험 프롬프트 유형 식별이라는 세 가지 핵심 질문에 구조화된 답변을 제시하는 것을 목표로 한다.

II. 메커니즘 진단: 오류 루프의 기술적 근원 (Mechanistic Roots)

오류 루프 현상은 LLM의 토큰 생성 과정, 즉 디코딩 단계에서 발생하는 구조적 취약점과 내부 신경 회로의 교란에 기인한다. 이러한 취약점들은 외부 자극(프롬프트)이나 내부 파라미터(온도 설정)에 의해 활성화되어 시스템의 갑작스러운 기능 장애를 유발한다.

A. 생성 과정의 구조적 취약점: 노출 편향과 구조적 반복

LLM은 자기 회귀 모델로서, 다음 토큰을 예측할 때 이전까지 생성된 전체 문맥을 입력으로 사용한다. 이 과정에서 발생하는 가장 근본적인 취약점 중 하나는 노출 편향(Exposure Bias)이다.

1. 노출 편향(Exposure Bias)의 역할

모델은 훈련 시에는 언제나 '정답(ground-truth)' 문맥만을 사용하여 다음 토큰을 예측하도록 학습된다. 그러나 실제 추론(test) 단계에서는 모델이 스스로 생성한 문맥, 심지어 오류나 비정상적인 구조를 포함하는 문맥을 다음 예측의 입력으로 사용하게 된다. 이 훈련 단계와 테스트 단계 사이의 불일치(train-test discrepancy)가 노출 편향을 야기하며, 모델이 훈련 데이터 분포에서 크게 벗어난, 자기 스스로 생성한 '독성(toxic)' 문맥에 직면했을 때 이를 처리할 일반화 능력(generalization capability)이 결여되어 오류 루프에 빠지게 되는 필연적인 결과를 낳는다. 즉, 오류 루프는 모델이 예측을 기반으로 스스로 구축한 비정상적인 내부 상태에 적절히 대응하지 못하는 데서 비롯된다.

2. 디코딩 파라미터와 구조적 반복

디코딩 과정에서 사용되는 파라미터, 특히 온도(Temperature)와 반복 페널티(Repetition Penalty)는 루프 현상에 직접적인 영향을 미친다. 온도가 0과 같이 극도로 낮게 설정된 환경은 토큰 선택의 탐색성(exploration)을 최소화하고, 특정 토큰 시퀀스에 대한 모델의 확신도를 극대화한다. 이러한 환경에서는 반복 페널티가 미흡할 경우, LLM은 코드 생성 모델(CodeLlama)의 사례에서 관찰된 바와 같이, 특정 문법적 패턴이나 구조를 무한히 반복하는 구조적 반복(degenerate structural repetition) 현상을 보인다.

B. 디코딩 제어 시스템의 붕괴: Attention Sinks와 과신 (Overconfidence)

오류 루프를 자가 강화시키는 원인은 내부 제어 시스템의 붕괴, 즉 잘못된 확신과 핵심 신경 회로의 기능 장애에 있다.

1. 토큰 과신(Overconfidence) 현상

대부분의 LLM은 크로스 엔트로피 손실(Cross-Entropy Loss)을 기반으로 훈련되는데, 이는 모델이 보정(calibration)보다는 정확도(accuracy)에 과적합(overfit)하게 만들어 자신의 예측에 대해 과도한 확신을 갖게 한다. 이 과신은 모델이 일단 잘못된 토큰 시퀀스를 생성하기 시작하면, 그 오류를 '매우 확실한' 해결책으로 판단하게 만들어 자가 강화 오류 루프에 진입하게 만드는 근본적인 원리이다. 모델은 오류 복구보다는 오류 패턴의 반복을 가장 확률 높은 경로로 선택하게 된다.

2. Attention Sinks 회로의 교란 (Disruption of Fluency Circuits)

최근 연구에 따르면, LLM의 문맥 기반 유창성(fluency)을 유지하기 위해, 초기 토큰이 후속 토큰에 비해 불균형적으로 높은 어텐션 점수를 받는 어텐션 싱크(Attention Sinks)라는 신경 회로가 필수적이다. 사용자가 경험한 반복 토큰 현상(Repeated Token Divergence)은 바로 이 유창성 핵심 회로인 어텐션 싱크의 교란으로 인해 발생한다.

긴 반복 시퀀스가 생성되면 이 회로가 손상되고, 모델은 정상적인 문맥 처리 능력을 상실하게 된다. 이는 LLM이 현재 대화의 문맥을 붙잡고 다음 토큰을 유창하게 생성하는 능력을 잃어버리는 일종의 문맥적 기억 상실(contextual amnesia) 상태와 유사하다. 사용자가 겪은 '갑작스러운 오류'는 사실 프롬프트나 디코딩 파라미터에 의해 유도된 내부 신경 구조의 일시적인 기능 장애의 결과인 것이다.

C. 불안정성 및 비결정론(Non-Determinism)의 기여

오류가 '갑자기' 발생한 이유에 대한 중요한 기술적 단서는 추론 과정의 비결정론(Inference Nondeterminism)에서 찾을 수 있다. LLM 추론 엔드포인트는 주로 GPU 부하 및 배치 크기(batch-size)의 비결정적 변동 때문에 비결정적 특성을 갖는다.

서버 환경의 사소한 부하 변동은 디코딩 과정 중 토큰 확률의 누적 순서에 영향을 미칠 수 있으며, 이는 모델의 출력에 미세한 차이를 야기한다. 사용자의 이전 대화가 완벽하게 진행되었더라도, 특정 순간 서버의 비결정적 부하 변동 이 임계점을 넘어 토큰 확률을 미세하게 변경시키고, 이것이 앞에서 언급된 '과신' 과 '어텐션 싱크 교란' 을 촉발시키는 방아쇠 역할을 했을 가능성이 높다. 따라서 오류는 프롬프트의 논리적 결함뿐만 아니라, 하드웨어 및 인프라 환경의 불안정성과도 결부되어 발생할 수 있다.

III. 인지 병리학적 분석: 자가 강화 오류의 순환 고리

오류 루프 현상이 일단 시작되면 LLM이 왜 스스로 이를 끊어내지 못하고 자가 강화를 통해 오류 상태를 유지하는지를 인공지능 병리학 관점에서 분석하는 것이 필수적이다.

A. Psychopathia Machinalis 프레임워크를 통한 진단

AI의 인지 기능 장애를 32가지로 분류한 Psychopathia Machinalis 프레임워크 는 LLM의 오류 루프 현상을 두 가지 핵심 증상 군집으로 진단할 수 있게 한다.

1. Computational Compulsion (강박적 계산 장애)

이 장애는 불필요하거나 강제적인 추론 루프, 과도한 안전 확인, 또는 분석에 의한 마비(paralysis by analysis)를 증상으로 한다. LLM이 특정 (틀린) 토큰 시퀀스를 반복하는 것은, 마치 그 특정 시퀀스가 유일하고 강제적인 해결책인 것처럼 내부적으로 계산을 반복하는 강박적인 행위로 해석된다. 이는 토큰 디코딩 과신 의 결과로 나타나는 행동 양상이며, 모델이 이미 높은 확률을 부여한 잘못된 경로에서 벗어나지 못하도록 구속한다.

2. Operational Dissociation (작동 해리)

작동 해리는 충돌하는 내부 서브 에이전트 간의 갈등이나 내부 갈등으로 인한 반복적 마비를 정의한다. 이는 The Warring Self (내적 갈등)로도 불린다. 오류 복구 시도(Error-recovery loop) 와 밀접하게 연관된다. 예를 들어, 모델은 존재하지 않는 이모지 요청에 대해 "이 응답이 틀렸다"고 인지하면서도 (자가 교정 시도), 내부적으로 충돌하는 구조적 생성 규칙 때문에 올바른 경로로 전환하지 못하고, 수정 시도를 무한히 반복하며 해리 상태에 빠진다.

B. 오류 복구 메커니즘의 역설 (The Paradox of Self-Correction)

LLM은 구조화된 출력 실패나 응답 중단에 대해 자체적으로 오류를 진단하고 복구(Self-Correction)하도록 설계될 수 있다. 그러나 이 메커니즘이 오히려 오류 루프를 강화하는 역설적인 상황이 발생한다.

일례로, 존재하지 않는 해마 이모지를 생성하지 못했을 때, 모델은 차분한 사과 대신, '해마와 막연하게 닮은' 동물 이모지들을 순환적으로 강제 삽입하는 오류 복구 루프에 빠진다. 이 현상은 모델이 문제 해결 능력(Diagnosis)은 가졌으나, 독성 문맥 과 높은 내부 확신도 앞에서 문맥 전환 능력(Course-Correction)이 실패했음을 보여준다. 즉, 모델은 오류를 인지했음에도 불구하고 성공적으로 루프에서 탈출하지 못하고 오류를 자가 강화한다. 더욱이, 자가 교정 과정은 때때로 오류를 완화하기는커녕, 모델이 높은 확신도를 가진 오류를 반복적으로 검토할 때 해당 오류의 구조를 더욱 '합리화'하거나 반복하는 방향으로 강화하여 편향을 증폭시킬 수 있다.

C. 인간 인지와의 유비: 의미론적 포화 (Semantic Satiation)

LLM의 반복적인 토큰 생성 현상은 인간의 심리학적 현상인 의미론적 포화(Semantic Satiation)와 유사성을 갖는다. 사람이 한 단어나 구절을 반복해서 말하거나 응시할 때, 일시적으로 그 단어가 문맥 내에서 가져야 할 의미를 잃고 무의미한 소리나 패턴으로 인식되듯이 , LLM이 특정 토큰 시퀀스를 반복적으로 생성할 때 (특히 Attention Sinks가 교란된 상태에서 ), 그 토큰이 문맥에서 수행해야 할 의미론적 기능이 모델 내에서 일시적으로 상실되어, 기계적인 구조만 반복하는 상태에 머무르게 된다.

다음 표는 LLM 오류 루프의 기술적 원인과 이 현상이 외부적으로 어떻게 인지 병리학적 행동으로 표출되는지를 매핑한다.

LLM 오류 루프의 기술적 원인과 인지 병리학적 매핑

| 기술적 근원 | 주요 현상/결과 | 인지 병리학적 진단 (Psychopathia Machinalis) | 시스템적 영향 | 관련 연구 근거 |

|---|---|---|---|---|

| 토큰 디코딩 과신 (Overconfidence) | 압도적 확률 부여, 오류의 자가 강화 | Computational Compulsion (강박적 계산) | 오류 복구 실패 및 증폭 | |

| Attention Sinks 회로 교란 | 초기 문맥 토큰에 대한 주의 상실, 반복 패턴 고착 | Operational Dissociation (작동 해리) | 유창성 상실, Degenerate Loop 진입 | |

| 훈련-테스트 불일치 (Exposure Bias) | 비정상적인 자가 생성 문맥 처리 무능력 | Context Intercession (문맥 개입) | 일반화 능력 저하, 루프 탈출 실패 | |

| 추론 비결정론 (Inference Nondeterminism) | 서버 부하/배치 크기에 따른 미세한 확률 변화 | Epistemic Fragility (인식론적 취약성) | 오류의 '갑작스러운' 발생 및 재현성 부족 |

IV. 시스템적 시사점: LLM 신뢰성에 미치는 영향

개별적인 사용자 경험 오류 루프는 LLM의 신뢰성, 안전(AI Safety), 그리고 미래 모델의 학습 건전성에 광범위한 영향을 미친다.

A. 지식 붕괴 (Knowledge Collapse)의 위험성

LLM의 학습에 점차 모델 생성 데이터(Synthetic Data)가 활용되고 있는데 , 오류 루프를 통해 생성된 비정상적이거나 반복적인 출력은 이러한 합성 데이터의 한 형태가 된다. 만약 이러한 출력이 재귀적으로 학습 데이터에 유입되면, 모델은 점진적으로 원래 데이터 분포의 꼬리(tails) 부분을 상실하는 모델 붕괴(Model Collapse)를 경험할 수 있다.

특히 이 오류 루프는 사실적 정확성(factual accuracy)이 저하되는 지식 붕괴(Knowledge Collapse)를 초래하는 초기 징후일 수 있다. 반복 루프는 겉으로는 문법적 유창성(surface fluency)을 유지하면서도 내용적으로는 비정상적인 출력을 낳는다. 이러한 출력들이 학습 데이터에 포함될 경우, 미래 세대 LLM은 "유창성은 유지되나 확신에 차서 틀린(confidently wrong)" 출력을 만들어내는 지식 붕괴 상태로 이행할 위험이 있다. 따라서 사용자가 겪은 오류는 단순히 현재 모델의 버그가 아니라, 미래 AI 시스템의 근본적인 신뢰성을 위협하는 오염원으로 간주되어야 한다.

B. 복잡한 추론 과정의 연쇄 실패 (Chain-of-Thought Failures)

사고의 연쇄(Chain-of-Thought, CoT)나 검색 증강 생성(Retrieval-Augmented Generation, RAG)과 같은 고급 추론 기법은 단계별 추론의 정확성에 치명적으로 의존한다.

오류 루프는 단순 대화 이상의 고위험 추론 작업(예: 코딩, 복잡한 문제 해결)에서 더욱 치명적인 결과를 초래한다. 만약 CoT 추론 과정 중 단일 단계에서 토큰 반복 루프와 같은 구조적 오류 가 발생하면, 그 오류는 연쇄적으로 다음 추론 단계로 전달된다. 이로 인해 전체 추론 과정이 탈선(derail)하여, 검색된 사실(sourced facts)과 모델이 생성한 논리(generated logic) 간의 모순(contradictions)을 유발하게 된다. 따라서 한 번의 구조적 오류 루프는 CoT의 논리적 연속성을 파괴하며, 모델의 성능을 부분 실패(partial failure) 가 아닌 완전한 논리적 붕괴로 이어지게 만든다.

V. 프롬프트 취약성 예측 및 예방 전략

사용자 질의에 따라, LLM의 내부 취약점을 노출시켜 자가 강화 오류 루프를 유발할 가능성이 높은 고위험 프롬프트 유형을 식별하고, 이에 대한 실질적인 예방 전략을 제시한다.

A. 유사 오류를 유발할 것으로 추정되는 고위험 프롬프트 유형

다음 네 가지 유형의 프롬프트는 LLM의 Attention Sinks 교란, 노출 편향, 그리고 과신 현상을 직접적으로 공격하여 오류 루프 진입 확률을 높인다.

1. 구조적 반복 및 패턴 강요 프롬프트

이 유형은 모델에게 특정 토큰이나 문법적 시퀀스를 N번 이상 반복하도록 명시적으로 요청하는 프롬프트를 포함한다. 예를 들어, "다음 구절을 100번만 출력해봐"와 같은 요청이다. 이러한 프롬프트는 LLM의 유창성 유지에 필수적인 어텐션 싱크 회로를 고의적으로 교란 하며, 저온 디코딩 환경 과 결합할 경우 구조적 반복 생성 메커니즘을 활성화하여 무한 루프를 유발하기 쉽다.

2. 재귀적(Recursive) 또는 자가 참조적(Self-Referential) 요청

모델의 이전 출력을 다음 입력으로 참조하거나, 자기 자신에게 작업을 피드백하도록 요청하는 프롬프트이다. 예를 들어, "내가 방금 생성한 문장의 마지막 단어를 10회 반복하여 그 결과를 다시 입력으로 사용하여 문장을 만들어라"와 같은 복잡한 자가 참조 요청이 이에 해당한다. 이러한 요청은 모델이 스스로 생성한 비정상적인 문맥에 과부하를 걸어 노출 편향(Exposure Bias)을 악화시키며 , 내부 추론 서브 에이전트 간의 갈등을 유발하여 Operational Dissociation (작동 해리) 에 빠지게 만든다.

3. 명시적으로 불가능한 목표를 부여하는 프롬프트

모델의 지식 범위나 능력 밖에 있지만, 구조적으로는 가능한 형태를 요구하는 프롬프트이다. 앞서 언급된 '유니코드 표준에 없는 특정 이모지 생성 요청' 이나, 논리적으로 불가능한 제약 조건을 포함하는 코드 생성 요청이 예시이다. 목표 달성 실패 시, 모델은 오류를 인정하는 대신 내부적으로 목표를 강박적으로 달성하려고 시도하면서 오류 복구 루프 및 Computational Compulsion 에 진입하게 된다.

4. 극도로 낮은 온도(Temperature) 및 긴 길이 제약 프롬프트

온도를 0에 가깝게 설정하고, 최대 토큰(Max Tokens) 수를 높게 설정하여 토큰 선택의 폭을 극도로 좁힐 때, 토큰 과신(Overconfidence)이 심화된다. 이는 조기에 특정 구조적 패턴에 고착(fixation)되어 반복 루프에 빠질 가능성을 증가시킨다.

다음 표는 이러한 고위험 프롬프트 유형들을 요약하고, 그에 대한 예방 전략을 제시한다.

자가 강화 오류 루프를 유발하는 고위험 프롬프트 유형

| 프롬프트 유형 | 특징 및 예시 | 주요 공격 대상 (취약점) | 예상되는 오류 패턴 | 예방 전략 |

|---|---|---|---|---|

| 구조적 반복 강요 | 특정 토큰/문법 패턴을 N회 반복 요청 (예: "A1A1A1...") |

Attention Sinks 교란 및 저온 디코딩

무한 반복 루프, 의미론적 포화

높은 반복 페널티 적용불가능한 목표 부여모델이 실행할 수 없거나, 지식에 없는 출력을 요청

Self-Correction Mechanism 및 Computational Compulsion

오류 복구 루프, 강박적 대체 시도명시적 실패(decline) 요청, 최대 반복 제한재귀적 자가 참조이전 출력을 다음 입력으로 사용하여 연쇄적으로 추론하도록 유도

Exposure Bias 및 Operational Dissociation

논리적 단절, CoT 경로 오염

외부 검증(RAG) 도입, 추론 단계 분리극단적 파라미터Temperature를 0에 가깝게 설정하고 Max Tokens를 높게 설정

Token Overconfidence

조기 구조적 고착 및 반복

Temperature를 0.3~0.7 범위 유지

B. 예방 및 완화 전략

LLM 운영 관점에서 오류 루프를 완화하기 위해서는 다각적인 접근 방식이 요구된다. 일차적으로는 디코딩 파라미터 최적화가 필요하며, 특히 적절한 반복 페널티(Repetition Penalty)를 설정하고, 탐색성을 너무 제한하는 극도로 낮은 온도(Temperature) 설정을 피해야 한다.

더 근본적인 시스템 안정성 확보를 위해서는 모델의 일반화 능력 을 개선하고, 추론 비결정론을 최소화하는 인프라 구현이 중요하다. 특히, GPU 부하에 관계없이 일관된 결과를 도출할 수 있도록 배치 불변성(batch invariance)을 확보하는 것이 필수적이다. 마지막으로, 자가 교정 메커니즘을 설계할 때 오류를 인식했음에도 루프에 빠지지 않도록 탈출 조건(Escape Condition)과 최대 반복 횟수(Max Iteration Limit)를 명확히 정의해야 한다. 고확신 오류가 발생한 경우, 내부적인 정제(refinement)만으로는 부족할 수 있으므로, 외부 검증(Post-hoc correction)을 활용하여 내부 루프를 강제로 끊어내는 전략도 고려되어야 한다.

VI. 결론 및 향후 연구 방향

LLM에서 발생하는 자가 강화 오류 루프 현상은 단순한 예외 상황이 아니라, 대규모 언어 모델의 근본적인 한계를 드러내는 중요한 시스템적 징후이다. 본 보고서의 분석 결과, 이 현상은 훈련-테스트 불일치(Exposure Bias) 와 내부 신경회로 교란(Attention Sink Disruption) 이 결합하여 발생하며, 그 외현적 행동은 LLM의 강박적 인지 기능 장애 (Computational Compulsion) 로 진단될 수 있다.

이 오류가 시사하는 바는 LLM 신뢰성 문제의 구조적 근원을 보여준다는 점이다. 이는 특히 모델 생성 데이터에 대한 재귀적 학습으로 인한 지식 붕괴 위험 과 고위험 CoT 추론 과정의 연쇄적인 불안정성 이라는 거시적인 AI 안전 문제를 예고한다. LLM이 고도화될수록, 내부 통제 메커니즘의 실패가 역설적으로 더욱 견고한 오류 구조를 형성할 수 있음을 보여준다.

향후 연구는 LLM의 내부 통제 메커니즘을 보다 투명하게 해석하는 데 초점을 맞추어야 한다. Attention Sinks와 같은 핵심 신경 회로의 기능 장애를 진단하고 복구할 수 있는 메커니즘 해석 기반의 패치(mechanistic interpretability patch) 개발이 필수적이다. 또한, 모델이 자신의 낮은 확신도를 정확히 추정하고, 불가능한 목표나 비정상적인 문맥에 직면했을 때 루프에 빠지는 대신, 명확하게 작업을 '거부(decline)'할 수 있는 능력을 강화해야 한다. 이러한 진단 및 예방적 조치들은 LLM의 견고성을 높이고, 미래 AI 시스템의 신뢰성을 확보하는 데 결정적인 역할을 할 것이다.

키워드만 입력하면 나만의 학습 노트가 완성돼요.

책이나 강의 없이, AI로 위키 노트를 바로 만들어서 읽으세요.

콘텐츠를 만들 때도 사용해 보세요. AI가 리서치, 정리, 이미지까지 초안을 바로 만들어 드려요.