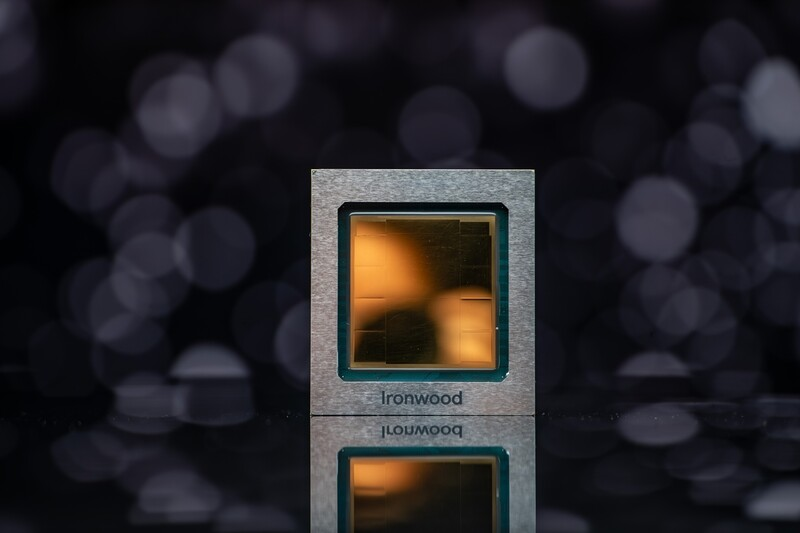

구글 아이언우드 TPU: 2025년 AI 추론 시대를 위한 차세대 텐서 처리 장치 발표

구글 아이언우드 TPU 개요 및 개발 배경

구글은 2025년 4월 9일, Google Cloud Next '25 컨퍼런스에서 자사의 7세대 텐서 처리 장치(Tensor Processing Unit, TPU)인 아이언우드(Ironwood)를 공식 발표했습니다. 아이언우드는 구글이 자체 개발한 AI 가속기 중 역대 가장 강력하고 확장성이 뛰어나며 에너지 효율적인 칩으로, 특히 추론(inference) 워크로드에 최적화되어 설계된 최초의 TPU입니다. 이는 지난 10년 이상 구글 내부의 가장 까다로운 AI 학습 및 서비스 워크로드를 구동하고 클라우드 고객에게 동일한 기능을 제공해 온 TPU 기술력의 최신 결과물입니다.

구글은 아이언우드의 등장을 '추론의 시대(age of inference)'를 뒷받침하기 위한 핵심 기술로 설명합니다. 이는 기존 AI 모델이 주로 인간의 해석을 위해 실시간 정보를 제공하는 반응형 시스템이었던 것에서 벗어나, AI 에이전트가 선제적으로 데이터를 검색하고 생성하여 협업적으로 통찰력과 해답을 제공하는 시대로의 전환을 의미합니다. 아이언우드는 이러한 차세대 생성형 AI와 '사고하는 모델(thinking models)'이 요구하는 방대한 계산 및 통신 요구 사항을 충족하도록 특별히 설계되었습니다.

아이언우드는 대규모 언어 모델(LLM), 전문가 혼합(Mixture of Experts, MoE) 모델, 고급 추론 작업 등을 포함하는 '사고하는 모델'의 복잡한 계산 및 통신 요구를 효과적으로 관리하도록 설계되었습니다. 이러한 모델들은 막대한 병렬 처리 능력과 효율적인 메모리 접근을 필요로 합니다. 아이언우드는 칩 내에서 데이터 이동과 지연 시간을 최소화하면서 대규모 텐서 조작을 수행하도록 설계되었으며, 단일 칩의 용량을 훨씬 뛰어넘는 최첨단 계산 요구 사항을 해결하기 위해 저지연, 고대역폭의 칩 간 상호 연결(Inter-Chip Interconnect, ICI) 네트워크를 갖추고 있습니다. 이를 통해 전체 TPU 포드 규모에서 조정된 동기식 통신을 지원합니다.

주요 기술 사양 및 성능

아이언우드 TPU는 이전 세대 대비 획기적인 성능 향상과 효율성을 제공합니다. 개별 칩은 최대 4,614 TFLOPs의 연산 성능을 제공하며, 이는 AI 워크로드 처리 능력에서 기념비적인 도약을 의미합니다. 특히, 아이언우드는 FP8(8비트 부동소수점) 데이터 형식을 지원하는 최초의 구글 TPU입니다. 이전 세대 TPU는 주로 추론을 위해 INT8 정수 형식을, 학습을 위해 BF16 부동소수점 형식을 지원했습니다.

메모리 측면에서 아이언우드는 칩당 192GB의 고대역폭 메모리(High Bandwidth Memory, HBM)를 탑재하여, 이전 세대인 트릴리움(Trillium, TPU v6) 대비 6배 증가한 용량을 제공합니다. 이는 더 큰 모델과 데이터셋을 처리할 수 있게 하여 빈번한 데이터 전송 필요성을 줄이고 성능을 향상시킵니다. HBM 대역폭 또한 칩당 7.2 TBps로 크게 향상되어, 트릴리움 대비 4.5배 증가했습니다. 이 높은 대역폭은 최신 AI에서 흔히 볼 수 있는 메모리 집약적인 워크로드에 필수적인 빠른 데이터 접근을 보장합니다.

네트워킹 측면에서는 향상된 ICI(Inter-Chip Interconnect) 기술이 적용되었습니다. 칩 간 양방향 ICI 대역폭은 1.2 Tbps로, 트릴리움 대비 1.5배 향상되어 칩 간의 더 빠른 통신을 가능하게 하고 대규모 분산 학습 및 추론을 효율적으로 지원합니다. 또한, 아이언우드는 전력 효율성 측면에서도 상당한 개선을 이루었습니다. 구글에 따르면 아이언우드의 와트당 성능(perf/watt)은 트릴리움 대비 2배 향상되었으며, 2018년에 출시된 첫 클라우드 TPU(TPU v2 추정)와 비교하면 약 30배 더 전력 효율적입니다. 이는 AI 성능 제공에 있어 가용 전력이 제약 조건 중 하나인 시대에 고객 워크로드에 대해 와트당 훨씬 더 많은 용량을 제공함을 의미합니다.

아키텍처 및 시스템 구성

아이언우드 TPU는 구글 클라우드의 AI 하이퍼컴퓨터(AI Hypercomputer) 프레임워크의 핵심 구성 요소 중 하나로 제공됩니다. 고객은 AI 워크로드 요구 사항에 따라 두 가지 주요 구성으로 아이언우드를 활용할 수 있습니다: 256개 칩 구성과 9,216개 칩 구성입니다. 이 두 구성 모두 단일 스케일업 포드(pod)로 제공됩니다.

특히 9,216개 칩으로 구성된 대규모 포드는 총 42.5 Exaflops의 연산 능력을 제공합니다. 이는 현존하는 세계 최대 슈퍼컴퓨터 중 하나인 엘 캐피탄(El Capitan)이 포드당 제공하는 1.7 Exaflops의 24배가 넘는 연산 능력에 해당합니다. 이러한 대규모 병렬 처리 능력은 초거대 규모의 밀집형 LLM이나 MoE 모델의 학습 및 추론과 같이 가장 까다로운 AI 워크로드에 필수적입니다. 이 거대한 규모에서 최대 성능을 지원하기 위해 아이언우드의 메모리 및 네트워크 아키텍처는 적절한 데이터가 항상 사용 가능하도록 보장합니다.

아이언우드 시스템은 첨단 액체 냉각 솔루션을 채택하여 지속적이고 무거운 AI 워크로드 하에서도 표준 공랭식 냉각 대비 최대 2배의 성능을 안정적으로 유지할 수 있습니다. 9,216개 칩으로 구성된 대형 포드는 약 10MW의 전력을 소비하는 것으로 추정됩니다. TPU 포드는 규모에 따라 2D 또는 3D 토러스(torus) 구성의 ICI 네트워크를 사용합니다. 또한, 구글 딥마인드가 개발한 자체 ML 런타임인 패스웨이즈(Pathways)는 여러 TPU 칩에 걸쳐 효율적인 분산 컴퓨팅을 가능하게 합니다. 구글 클라우드의 패스웨이즈는 단일 아이언우드 포드를 넘어 수십만 개의 아이언우드 칩을 함께 구성하여 생성형 AI 연산의 경계를 빠르게 확장할 수 있도록 지원합니다.

이전 세대 TPU와의 비교

아이언우드(TPU v7p로 추정)는 이전 세대 구글 TPU들과 비교하여 여러 측면에서 상당한 발전을 이루었습니다. 특히 추론 성능과 효율성에 중점을 둔 아이언우드는 TPU v5p의 후속 모델로 간주되며, 반면 트릴리움(TPU v6/v6e)은 TPU v5e의 후속 모델로 여겨집니다. 이러한 이원화된 개발 라인은 특정 워크로드에 최적화된 칩을 제공하려는 구글의 전략을 반영합니다.