100달러로 만드는 ChatGPT: 안드레이 카파시의 nanochat

100달러로 만드는 ChatGPT: 안드레이 카파시의 nanochat

2025년 10월 13일, AI 교육의 거장 안드레이 카파시가 "내가 쓴 것 중 가장 무모한 코드"라 표현한 nanochat을 공개했다. 단 100달러의 GPU 비용으로 4시간 만에 자신만의 ChatGPT를 만들 수 있다는 이 프로젝트는, OpenAI와 Tesla에서 AI 개발을 이끌었던 카파시의 교육 철학을 집약한 작품이다. 8,000줄의 깔끔한 코드로 토크나이저 훈련부터 웹 배포까지 전체 파이프라인을 구현하며, AI 모델 훈련을 수백만 달러 예산의 대기업 전유물에서 누구나 접근 가능한 교육 도구로 바꾸고 있다.

nanochat이 나타난 이유: 교육자 카파시의 철학

안드레이 카파시는 단순히 뛰어난 AI 연구자가 아니다. 스탠퍼드 대학에서 CS231n(딥러닝 강좌)을 설계해 150명에서 750명으로 성장시켰고, YouTube의 "Zero to Hero" 시리즈로 수십만 명을 가르쳤으며, 2024년 7월에는 AI 교육 스타트업 Eureka Labs를 설립했다. nanochat은 그가 개발 중인 학부 수준 AI 강좌 LLM101n의 최종 프로젝트로 설계되었다.

카파시는 GitHub README에서 명확히 밝혔다: "내 목표는 전체 '강력한 기준선' 스택을 하나의 응집력 있고, 최소화되고, 읽기 쉽고, 해킹 가능하고, 최대한 포크하기 쉬운 저장소로 만드는 것이다." 이는 리처드 파인만의 "내가 만들 수 없는 것은 이해하지 못한다"는 철학을 구현한 것이다. 거대한 설정 객체, 모델 팩토리, 복잡한 조건문을 피하고, 처음부터 끝까지 투명하게 볼 수 있는 교육 도구를 만들겠다는 의지다.

그의 경력을 보면 이 프로젝트의 맥락이 명확해진다. OpenAI 창립 멤버(2015-2017), Tesla AI 책임자로 Autopilot Vision 팀 이끌기(2017-2022), OpenAI 복귀해 GPT-4 개선(2023-2024), 그리고 Eureka Labs 창립. nanochat은 20년간의 AI와 교육에 대한 열정이 결실을 맺은 작품이다.

프로젝트 개요: 완전한 ChatGPT 파이프라인

nanochat은 단순한 GPT 사전학습이 아닌 전체 스택 구현이다. 이전 프로젝트인 nanoGPT(2022)가 사전학습만 다뤘다면, nanochat은 다음 전체 과정을 포함한다:

토크나이저 훈련 - Rust로 작성된 BPE 구현(65,536 어휘 크기)

사전학습 - FineWeb-EDU 데이터셋으로 기본 언어 모델 훈련

중간학습 - SmolTalk 대화 데이터로 채팅 형식 적응

지도학습 미세조정(SFT) - 고품질 대화로 어시스턴트 행동 학습

강화학습(선택) - GRPO 알고리즘으로 수학 문제 풀이 향상

추론 엔진 - KV 캐싱과 효율적 생성

웹 인터페이스 - ChatGPT 스타일 UI

핵심 통계:

코드 규모: 44개 파일, 약 8,000줄

출시일: 2025년 10월 13일

GitHub 통계: 출시 직후 ~2,800개 스타, 220개 이상 포크

훈련 비용: $100(4시간) ~ $1,000(42시간)

모델 크기: 기본 설정(depth=20)에서 약 5억 6천만 개 파라미터

세 가지 훈련 등급: 비용과 성능의 트레이드오프

nanochat의 가장 혁신적인 측면은 예산에 따라 선택할 수 있는 3단계 훈련 등급이다:

$100 등급 (4시간, depth-20)

8xH100 GPU에서 실제 비용 $92.40, "아이스크림 살 돈 $8가 남는다"고 카파시는 농담했다. 이 모델은:

성능: 기본적인 이야기와 시 작성, 간단한 질문 답변

벤치마크: CORE 0.22(GPT-2 Large와 XL 사이), ARC-Easy 38.76%, MMLU 31.51%

한계: 카파시의 표현으로 "유치원생과 대화하는 느낌"

용도: AI 학습, 파이프라인 이해, 실험

$300 등급 (12시간, depth-26)

GPT-2를 CORE 벤치마크에서 약간 능가(~0.25)

더욱 일관된 응답

복잡한 지식 작업 개선

$1,000 등급 (42시간, depth-30)

성능: MMLU ~40점대, ARC-Easy ~70점대, GSM8K ~20점대

능력: 간단한 수학 문제 풀이, 기본 코딩 작업, 객관식 시험 통과

FLOPs: GPT-3 Small(125M)과 동등하지만 전체 GPT-3의 1/1000

이 계층적 접근은 대학생들이 수업 프로젝트로, 스타트업이 프로토타입으로, 연구자들이 실험으로 각자의 예산에 맞게 LLM을 훈련할 수 있게 한다.

주요 기술 특징: 단순함 속의 정교함

아키텍처와 모델 설계

nanochat의 transformer는 Llama 스타일을 단순화한 decoder-only 아키텍처다. 주요 설계 결정:

단일 depth 파라미터: 모델 크기를 하나의 값으로 제어

회전 위치 임베딩(RoPE): 전통적 위치 임베딩 제거

QK 정규화: 안정적인 학습

바이어스 없음: 파라미터 수 감소

분리된 가중치: 임베딩과 언임베딩 레이어 독립

기본 depth-20 설정:

파라미터: ~560,988,160개(약 5.6억)

레이어: 20개 transformer 블록

차원: 1,280 채널

어텐션 헤드: 10개(헤드당 128차원)

컨텍스트 길이: 2,048 토큰

배치 크기: GPU 8개로 총 524,288 토큰/스텝

확장성: depth를 26으로 늘리면 GPT-2 수준, 30으로 늘리면 1,000달러 등급 성능 달성.

혁신적인 토크나이저: rustbpe

기존 도구의 한계를 극복하기 위해 카파시는 새로운 Rust 기반 BPE 토크나이저를 만들었다:

문제점: tiktoken은 추론만 가능, HuggingFace tokenizers는 "너무 비대하고 탐색하기 어려움", minbpe는 "비효율적인 Python"

해결책: 간단하고 빠른 Rust 훈련 코드, tiktoken으로 내보내기 지원

성능: 20억 문자로 약 1분 훈련, 압축 비율 ~4.8 문자/토큰

어휘 크기: 2^16 = 65,536 토큰(채팅 스키마용 특수 토큰 포함)

하이브리드 옵티마이저 전략

nanochat은 파라미터 타입에 따라 다른 최적화기를 사용한다:

Muon 옵티마이저 (2D 행렬 파라미터용):

Newton-Schulz 직교화 사용

Nesterov 모멘텀

학습률: 0.02(일반적)

가중치 감쇠: 0.01

AdamW 옵티마이저 (임베딩과 1D 파라미터용):

학습률: 3e-4(모델 크기에 따라 1/√(dim)로 자동 조정)

베타: (0.90, 0.95)

이 접근은 각 파라미터 타입의 특성을 고려한 최적화를 가능하게 하며, 큰 모델일수록 작은 학습률을 선호하도록 자동 조정된다.

완전한 훈련 파이프라인

1단계: 사전학습 (3시간)

데이터셋: FineWeb-EDU(karpathy/fineweb-edu-100b-shuffle)

규모: depth-20에 240개 샤드 필요(~24GB 다운로드)

각 샤드: ~2.5억 문자, ~100MB 압축(gzip)

평가: 22개 데이터셋에 걸친 CORE 메트릭

메트릭: Bits per byte(bpb) - 토크나이저 불변 측정

2단계: 중간학습 (8분)

데이터셋: SmolTalk(사용자-어시스턴트 대화)

목적: 대화 형식 적응, 특수 토큰(

<|user|>,<|assistant|>) 학습추가 훈련: 객관식 질문, 도구 사용

3단계: SFT (7분)

목적: 고품질 대화 선별, 테스트 시간 형식 적응, 안전 훈련(거부)

평가: ARC-Easy/Challenge, MMLU(세계 지식), GSM8K(수학), HumanEval(코드)

4단계: 강화학습 (선택, 1.5시간)

방법: GRPO(Group Relative Policy Optimization)

데이터셋: GSM8K 전용

단순화: 신뢰 영역 없음, 온폴리시, 토큰 수준 정규화

주의: 현재 GSM8K에만 잘 조정됨, 일반 RLHF 아님

speedrun.sh 스크립트: 전체 파이프라인을 한 번의 실행으로 자동화.

추론과 배포

효율적인 추론 엔진:

KV 캐싱: 효율적인 키-값 캐시 관리

2단계 추론: Prefill(입력 처리) → Decode(자동회귀 생성)

도구 사용: Python 인터프리터 통합으로 코드 실행

인터페이스: CLI(

scripts.chat_cli)와 웹 UI(scripts.chat_web, FastAPI 기반)

성능:

MFU(모델 FLOPS 활용률): bfloat16 연산의 ~50%

훈련 시간: 스텝당 ~0.5초

총 훈련 토큰: 112억 토큰(Chinchilla 스케일링: 파라미터 × 20)

사용 방법: 4시간에 자신의 ChatGPT 만들기

기본 설정

# 저장소 클론

git clone git@github.com:karpathy/nanochat.git

cd nanochat

# uv 패키지 매니저 설치

curl -LsSf https://astral.sh/uv/install.sh | sh

# 가상환경 생성 및 의존성 설치

uv venv

source .venv/bin/activate

uv pip install -e .

# 전체 파이프라인 실행 (4시간)

bash speedrun.sh필수 사항:

8xH100 GPU 노드 권장(Lambda GPU Cloud에서 시간당 ~$24)

대안: 8xA100(더 느림), 단일 GPU(8배 더 오래 걸림)

80GB VRAM 미만 GPU는 조정 필요

단계별 실행

토크나이저 훈련:

# Rust/Cargo 설치

curl --proto '=https' --tlsv1.2 -sSf https://sh.rustup.rs | sh -s -- -y

# rustbpe 빌드

uv run maturin develop --release --manifest-path rustbpe/Cargo.toml

# 토크나이저 훈련 (20억 문자)

python -m scripts.tok_train --max_chars=2000000000

python -m scripts.tok_eval데이터 준비:

# FineWeb-EDU 샤드 다운로드 (~24GB)

python -m nanochat.dataset -n 240모델 훈련:

# 사전학습

torchrun --standalone --nproc_per_node=8 -m scripts.base_train -- --depth=20

# 평가

torchrun --standalone --nproc_per_node=8 -m scripts.base_eval

# 중간학습

torchrun --standalone --nproc_per_node=8 -m scripts.mid_train

# SFT

torchrun --standalone --nproc_per_node=8 -m scripts.chat_train

# 선택적 RL

torchrun --standalone --nproc_per_node=8 -m scripts.chat_rl추론:

# 웹 UI 시작

python -m scripts.chat_web

# http://<IP>:8000/ 접속

# CLI

python -m scripts.chat_cli더 큰 모델 훈련

# depth-26 (GPT-2 수준, 12시간)

python -m nanochat.dataset -n 450

torchrun --standalone --nproc_per_node=8 -m scripts.base_train -- --depth=26 --device_batch_size=16

# depth-30 ($1,000 등급, 42시간)

torchrun --standalone --nproc_per_node=8 -m scripts.base_train -- --depth=30 --device_batch_size=8실제 출력 예시

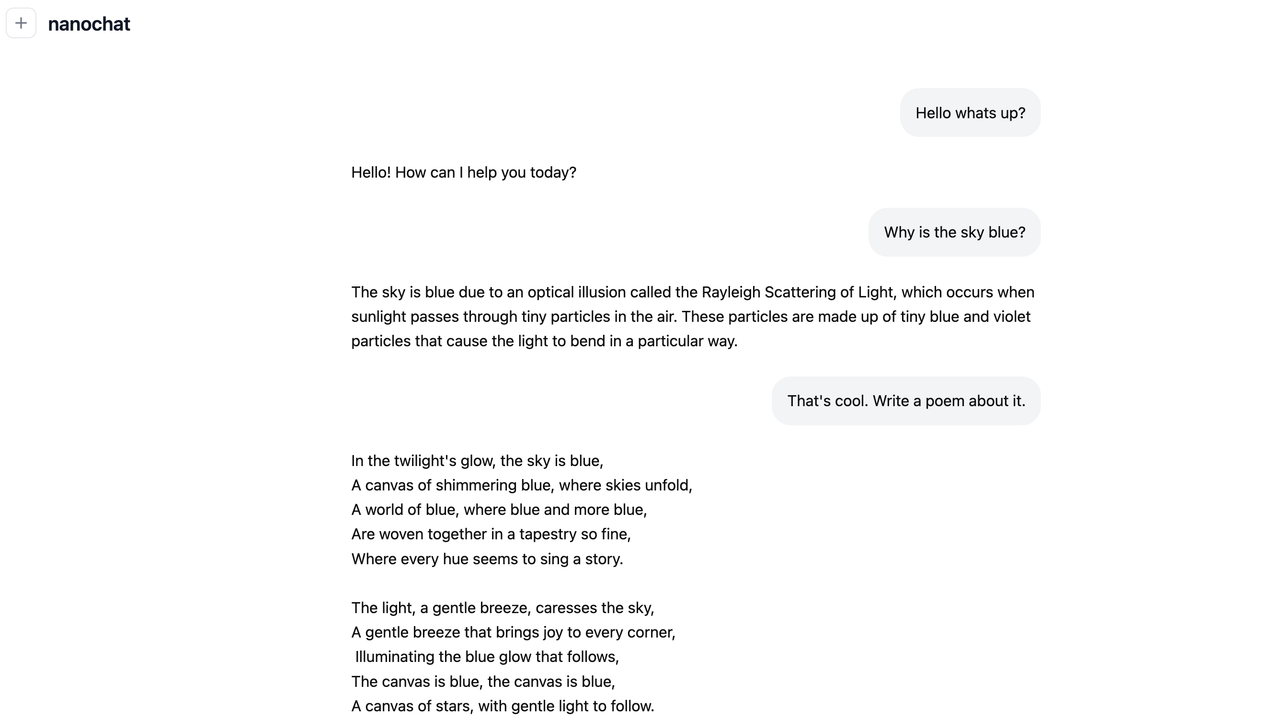

$100 모델이 아는 것:

파리는 프랑스의 수도 ✓

Au는 금의 기호 ✓

토요일은 금요일 다음 ✓

"차가운"의 반대는 "뜨거운" ✓

태양계 행성 나열 ✓

$100 모델이 어려워하는 것:

하늘이 왜 파란지 설명 ✗

간단한 산술 계산 ✗

긴 컨텍스트 유지 ✗

커뮤니티 반응: 즉각적인 영향

소셜 미디어 폭발

카파시의 발표 트윗(2025년 10월 13일)은 AI 커뮤니티를 뒤흔들었다. 주요 반응:

Simon Willison (@simonw): 재훈련 없이 테스트할 수 있도록 $100/$300/$1,000 등급의 사전학습된 가중치를 요청했다.

Yuchen Jin (@yuchenj_uw): "언제나처럼 Nano 시리즈를 사랑합니다! 이 최소한의 종단간 훈련/추론 스택은 많은 ML 학습자와 연구자에게 영향을 미칠 것입니다."

Clem Delangue (@clementdelangue, HuggingFace CEO): "오픈소스 덕분에 자신의 모델을 훈련하고, 최적화하고, 실행하는 것이 그 어느 때보다 쉬워졌습니다." 카파시는 FineWeb/SmolTalk 데이터셋을 제공한 HuggingFace의 중요한 역할을 인정하며 응답했다.

Dimitris Papailiopoulos (@dimitrispapail): "중요한 스케일링 법칙: 2년마다 최첨단과의 격차가 2배씩 줄어듭니다"

GitHub 통계

스타: 발표 후 며칠 내 ~2,800개(빠르게 성장 중)

포크: 220개 이상

Discussion #1: 카파시의 10,000단어 이상의 상세한 기술 워크스루

라이선스: MIT(최대한 개방적)

교육적 영향

LLM101n 통합:

nanochat은 Eureka Labs의 학부 수준 AI 강좌의 최종 프로젝트로 설계됨

학생들이 처음부터 자신의 AI 모델을 구축하도록 안내

"Storyteller AI Large Language Model" 구축 - 학생들이 AI로 작은 이야기를 만들고, 다듬고, 그림으로 표현

코드 품질:

잘 주석 처리되고 깔끔한 코드

"거대한 설정 객체, 모델 팩토리, 조건문 괴물" 없음

LLM이 패키징하고 질의할 수 있도록 설계(100K 토큰 미만)

DeepWiki 통합: URL을 github.com에서 deepwiki.com으로 변경하여 AI 지원 탐색 가능. files-to-prompt 유틸리티로 LLM 질문 지원.

비교: nanoGPT vs 다른 프로젝트들

카파시의 "nano" 시리즈는 일관된 교육 철학을 보여준다:

minGPT (2020년 8월, 반아카이브):

크기: ~300줄(mingpt/model.py)

초점: "작고, 깔끔하고, 해석 가능하고, 교육적"

상태: 널리 참조되어 변경 불가(노트북, 블로그, 강좌, 책에 인용)

역할: 순수 교육

nanoGPT (2022-현재, 활발):

크기: ~600줄(train.py ~300 + model.py ~300)

초점: "중간 크기 GPT 훈련/미세조정을 위한 가장 간단하고 빠른 저장소"

철학: 단순하고 해킹 가능하지만 "이빨이 있는" - 실제 벤치마크 재현

영향: 연구 하네스가 됨, 커뮤니티가 GPT-2 훈련을 45분에서 3분으로 최적화

GitHub: 45,000+ 스타

llm.c (2024, 활발):

크기: 단일 파일 ~1,000줄(train_gpt2.c)

언어: 순수 C/CUDA(PyTorch 없음, Python 없음)

목적: "간단한 원시 C/CUDA로 LLM 훈련"

성능: PyTorch보다 약간 빠름(~7% 개선)

철학: 잘 문서화된 손으로 작성한 커널 라이브러리

nanochat (2025년 10월, 신규):

크기: 44개 파일 ~8,000줄

범위: 전체 스택 파이프라인

혁신: 토크나이저부터 웹 UI까지 완전한 채팅 시스템

위치: LLM101n의 "최종 프로젝트"

nanoGPT와의 핵심 차이점

범위 비교

nanoGPT가 제공하는 것:

텍스트 데이터 → 토크나이제이션(외부) → 모델 훈련 → 체크포인트nanochat이 제공하는 것:

원시 텍스트

↓

토크나이저 훈련(Rust BPE) → 맞춤 토크나이저

↓

사전학습(FineWeb-EDU) → 기본 모델(CORE 평가)

↓

중간학습(SmolTalk 대화) → 대화 기본 모델

↓

지도학습 미세조정(SFT) → 어시스턴트 모델(다양한 벤치마크)

↓

강화학습(GRPO) → 최적화된 어시스턴트

↓

추론 엔진(KV 캐시) → 빠른 생성

↓

웹 UI(Python 서버) → ChatGPT 스타일 인터페이스nanochat만의 고유한 기능

비용 계층 접근법: $100/300/1,000의 명확한 선택지

단일 스크립트 실행:

speedrun.sh로 전체 파이프라인 무인 실행완전한 평가 스위트: 사전학습용 CORE, 채팅용 ARC/MMLU/GSM8K/HumanEval

연구 영감: modded-nanoGPT(게임화, 메트릭, 리더보드)에서 차용

의존성 최소주의: uv.lock의 ~2,000줄 vs 일반 ML 프로젝트의 수천 줄

프로덕션 ChatGPT와의 기술적 차이

규모:

nanochat $100 모델: ~70M 파라미터, 4시간

GPT-3.5: 175B 파라미터

GPT-4: 추정 1.7T+ 파라미터(MoE)

훈련 복잡도:

nanochat: 4-5단계, 간단한 샤드, 단일 8xH100 노드

프로덕션: 광범위한 전처리, 수천 GPU, 3D 병렬화

최적화:

nanochat: PyTorch compile(), KV 캐싱, 기본 그래디언트 누적

프로덕션: FlashAttention, 커스텀 커널, 혼합 정밀도, 텐서/파이프라인 병렬화

성능:

nanochat $100: MMLU 31%, GSM8K 4%, "유치원생 수준"

nanochat $1,000: MMLU ~40%, GSM8K ~20%, "간단한 수학/코드"

ChatGPT: MMLU >85%, GSM8K >90%, 복잡한 추론

목적:

nanochat: 교육, 학습, 실험, 이해

ChatGPT: 프로덕션, 확장성, 안전성, 실용성

다른 프로젝트와의 비교

VatsaDev's nanoChatGPT

카파시의 nanochat과 혼동하지 말아야 할 별도의 커뮤니티 프로젝트:

접근법: nanoGPT의 포크를 대화 데이터로 미세조정(Ubuntu Dialogue Corpus)

모델: GPT-2-medium(354M 파라미터)

초점: 추론, 기존 모델 미세조정

차이점: nanochat은 처음부터 전체 구축, VatsaDev는 미세조정 경로

일반 챗봇 프레임워크

Rasa, Dialogflow, Microsoft Bot Framework:

수준: 고수준 애플리케이션 프레임워크

초점: 의도 인식, 대화 관리, 통합

대상: 제품 빌더

학습: "사용 방법"

nanochat 철학:

수준: 저수준 구현

초점: Transformer 아키텍처, 훈련 역학, 최적화

대상: ML 연구자, 학생, 교육자

학습: "작동 원리"

"nano" 시리즈의 생태계 위치

nanochat은 카파시의 교육 철학의 정점을 나타낸다:

nanoGPT보다 포괄적: 사전학습만이 아닌 전체 파이프라인

minGPT보다 실용적: "이빨이 있음" - 실제 사용 가능한 채팅 모델 생산

프로덕션 시스템보다 접근성: $100-$1,000 vs 수백만, 시간 vs 개월

프레임워크보다 교육적: 사용법이 아닌 작동 원리 보여줌

학술 논문보다 완전함: 실제 작동하는 코드와 배포 포함

"nano" 시리즈는 집합적으로 투명하고, 실용적이고, 저렴한 AI 교육의 철학을 나타낸다 - 최첨단 AI를 이해하는 데 수백만 달러의 컴퓨팅이나 거대한 엔지니어링 팀이 필요하지 않으며, 호기심과 기본 원리부터 구축하려는 의지만 있으면 된다는 것을 증명한다.

코드 구조와 설계 원칙

파일 조직

nanochat/

├── rustbpe/ # Rust 토크나이저 구현

│ ├── src/lib.rs # 핵심 BPE 구현

│ └── Cargo.toml # Rust 의존성

├── nanochat/ # 메인 Python 패키지

│ ├── dataset.py # 데이터 로딩/관리

│ ├── report.py # 성적표 생성

│ └── [핵심 모듈들]

├── scripts/ # 훈련 및 추론 스크립트

│ ├── tok_train.py # 토크나이저 훈련

│ ├── base_train.py # 사전학습

│ ├── mid_train.py # 중간학습

│ ├── chat_train.py # SFT

│ ├── chat_rl.py # 강화학습

│ ├── chat_cli.py # CLI 추론

│ └── chat_web.py # 웹 UI

├── speedrun.sh # 완전한 종단간 파이프라인

└── README.md # 문서설계 철학

최소주의: "거대한 설정 객체, 모델 팩토리, 조건문 괴물이 없을 것"

가독성: 깨끗하고 잘 주석 처리된 코드 ~8,000줄

해킹 가능성: 모든 구성 요소를 쉽게 수정하고 실험 가능

교육적: LLM101n 강좌의 최종 프로젝트로 설계

최대한 포크 가능: 연구와 개발을 위한 강력한 기준선

평가와 보고

CORE 메트릭: 22개 데이터셋에 걸친 정규화된 평가(HellaSwag, ARC-Easy/Challenge, COPA, CommonsenseQA, PIQA, Lambada, Winograd, BoolQ 등)

자동 성적표: 각 훈련 실행마다 report.md 생성:

코드 통계(8,304줄, 44개 파일, ~83,497 토큰)

훈련 단계별 벤치마크 점수

총 벽시계 시간

GPU 활용 메트릭(MFU ~50%)

커뮤니티와 미래 방향

현재 상태와 한계

카파시는 솔직하다: "nanochat은 결코 완성되지 않았습니다. 목표는 1,000달러 미만의 예산으로 종단간 작업이 가능한 마이크로 모델의 최신 기술을 개선하는 것입니다."

인정된 한계:

"철저히 조정되거나 최적화되지 않음"

RL 지원이 "약간 혼합적"이며 GSM8K 전용만 잘 조정됨

$100 등급에서 "고성능"이 아님

추가 개발을 위한 기준선으로 설계됨

카파시는 "상당한 저조한 과일이 있을 것"이라고 언급하며 커뮤니티 최적화를 초대했다.

연구 잠재력

nanoGPT의 유산:

nanoGPT는 연구 하네스/벤치마크가 됨

modded-nanoGPT 커뮤니티가 GPT-2 훈련을 게임화(45분 → 3분)

최적화 경쟁과 리더보드

nanochat의 미래: 유사하게, nanochat은 다음과 같이 성장할 수 있다:

전체 스택 LLM 훈련을 위한 연구 하네스

효율적인 훈련 방법 벤치마크

커뮤니티 주도 최적화(토큰 활용, 배치 크기, 아키텍처 조정)

$100-$1,000 범위의 표준 기준선

실용적 응용

교육:

대학 AI 강좌의 실습 프로젝트

LLM101n의 최종 프로젝트

자기주도 학습자를 위한 포괄적인 가이드

연구:

아키텍처 실험을 위한 빠른 프로토타이핑(시간 vs 개월)

훈련 기법 테스트(옵티마이저, 스케줄러, 데이터 믹스)

소규모 모델 효율성 연구

실용:

틈새 산업을 위한 도메인별 챗봇(의료, 법률, 기술)

스타트업 프로토타입(VC 자금 없이)

개인 어시스턴트와 실험

카파시의 더 넓은 비전

Eureka Labs 사명: "성공한다면, 누구나 무엇이든 쉽게 배울 수 있게 되어, 교육의 도달 범위(많은 사람들이 무언가를 배우는 것)와 범위(한 사람이 오늘날 보조 없이는 불가능한 많은 주제를 배우는 것) 모두를 확장할 것입니다."

20년간의 교육 여정:

루빅 큐브 YouTube 튜토리얼부터

스탠퍼드에서 CS231n 시작까지

Zero to Hero AI 시리즈까지

이제 Eureka Labs와 nanochat

산업 인정:

MIT Technology Review의 35세 미만 혁신가(2020)

Time 잡지의 AI 분야 가장 영향력 있는 100인(2024)

CS231n을 스탠퍼드 최대 강좌 중 하나로 설계

결론: AI 교육의 민주화

nanochat은 단순히 또 하나의 오픈소스 프로젝트가 아니다. AI 모델 훈련을 수백만 달러 예산의 대기업 전유물에서 100달러면 누구나 접근 가능한 교육 도구로 전환하는 패러다임 시프트다.

카파시가 20년간 AI 연구(OpenAI), 실용 배포(Tesla), 교육(스탠퍼드, YouTube, Eureka Labs)에서 쌓은 경험을 종합한 작품이다. 8,000줄의 깔끔한 코드로 ChatGPT와 같은 시스템을 구축하는 완전하고, 저렴하고, 이해 가능한 경로를 제공함으로써 현대 LLM을 이해하는 접근을 민주화한다.

nanochat이 보여주는 것:

LLM 훈련이 더 이상 거대 기업만의 것이 아니라는 점

투명성과 교육이 복잡한 프레임워크보다 강력할 수 있다는 점

처음부터 구축하는 것이 진정한 이해의 길이라는 점

$100의 예산과 4시간이면 자신만의 AI 어시스턴트를 만들 수 있다는 점

카파시의 말을 빌리자면: "클라우드 GPU 박스를 부팅하고, 단일 스크립트를 실행하면, 빠르면 4시간 후에 ChatGPT와 같은 웹 UI에서 자신만의 LLM과 대화할 수 있습니다."

이것이 nanochat의 진정한 혁신이다 - 최첨단 AI를 신비화하지 않고, 접근 가능하고, 해킹 가능하며, 근본적으로 교육적으로 만드는 것이다. LLM101n 강좌가 출시되고 커뮤니티가 최적화를 기여하면서, nanochat은 nanoGPT가 그랬던 것처럼 표준 교육 리소스가 되고, 효율적인 훈련 방법에 대한 연구를 가능하게 하며, 맞춤형 LLM 개발에 대한 접근을 민주화할 것으로 예상된다.

2025년 10월 13일에 출시된 nanochat은 이미 AI 커뮤니티에 파장을 일으키고 있다. 며칠 만에 2,800개의 GitHub 스타, 수십 개의 미디어 기사, AI 리더들의 열정적인 반응을 얻었다. 하지만 이것은 시작에 불과하다. 진정한 영향은 학생들, 연구자들, 개발자들이 이 도구를 사용하여 AI를 배우고, 실험하고, 미래를 구축하면서 나타날 것이다.

"내가 만들 수 없는 것은 이해하지 못한다" - 리처드 파인만

nanochat으로 이제 누구나 ChatGPT를 만들 수 있고, 따라서 누구나 그것을 이해할 수 있다.

참고 및 출처

nanochat 메인 저장소: https://github.com/karpathy/nanochat

Discussion #1 (카파시의 상세 설명): https://github.com/karpathy/nanochat/discussions/1