[LM Studio] 오프라인 로컬에서 LLM을 구동하는 쉬운 방법

👾 LM Studio - Discover and run local LLMs

LM Studio를 사용하면 완전히 오프라인 상태에서도 자신의 노트북에서 직접 LLM을 구동할 수 있습니다.

앱 내 채팅 UI나 로컬 서버를 통해 OpenAI와 호환되는 모델을 활용할 수 있습니다.

사용하고 싶은 모델 파일은 HuggingFace 저장소에서 간편하게 다운로드 받을 수 있습니다.

Llama 2, Orca, Vicuna, Nous Hermes, WizardCoder, MPT 등 ggml 포맷을 지원하는 Llama, MPT, StarCoder 모델이라면 어떤 것이든 호환됩니다.

앱 홈페이지에서는 새롭고 주목할 만한 LLM들도 살펴볼 수 있습니다.

![[LM Studio] 오프라인 로컬에서 LLM을 구동하는 쉬운 방법 image 1](https://server.tilnote.io/images/pages/b19b9286-942d-4ee1-94d8-b9cbd42163fb.png)

LM Studio를 사용하기 위한 최소 요구사항은 M1/M2/M3 Mac이나 AVX2를 지원하는 프로세서가 탑재된 Windows PC입니다. Linux는 현재 베타 버전으로 제공되고 있습니다.

사용방법

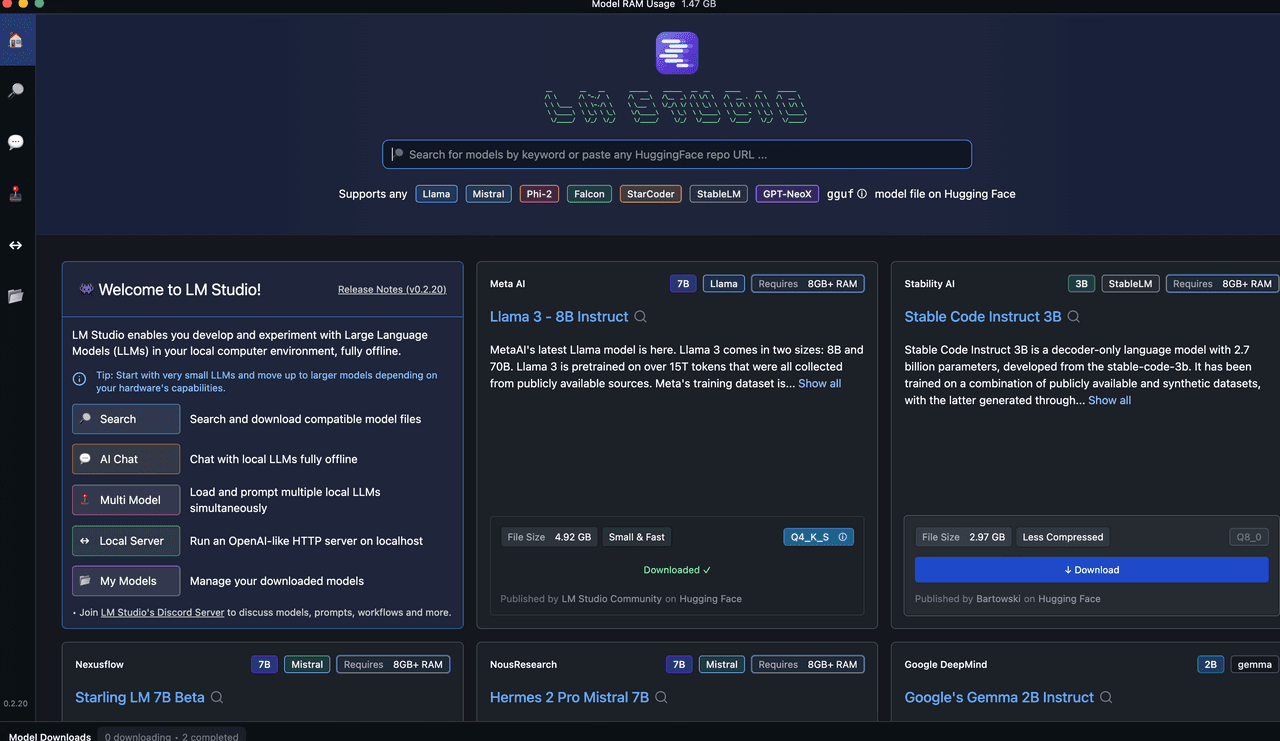

홈 탭을 누릅니다.

![[LM Studio] 오프라인 로컬에서 LLM을 구동하는 쉬운 방법 image 2](https://server.tilnote.io/images/pages/56b5f440-1e50-4ede-8fbc-667df825c36c.png)

메뉴에 있는 기능 설명은 다음과 같습니다.

![[LM Studio] 오프라인 로컬에서 LLM을 구동하는 쉬운 방법 image 3](https://server.tilnote.io/images/pages/6acd8e03-b53f-4936-aae4-559a56262f39.png)

LM Studio는 여러분의 로컬 컴퓨터 환경에서 LLM(Large Language Model)을 개발하고 실험할 수 있게 해주는 도구입니다. 완전히 오프라인 상태에서 사용 가능하죠.

주요기능

LM Studio의 주요 기능은 다음과 같습니다:

Search: 호환되는 모델 파일들을 검색하고 다운로드할 수 있습니다.

AI Chat: 오프라인에서 로컬 LLM과 채팅할 수 있는 기능입니다.

Multi Model: 하드웨어 성능에 따라 여러 개의 로컬 LLM을 동시에 로드하고 사용할 수 있습니다.

Local Server: 로컬 호스트에서 OpenAI와 유사한 HTTP 서버를 구동할 수 있습니다.

My Models: 다운로드 받은 모델들을 관리할 수 있는 메뉴입니다.

처음 사용하실 때는 작은 규모의 LLM부터 시작해서 하드웨어 성능에 맞춰 점차 큰 모델로 확장해 나가시는 것이 좋습니다.

LM Studio의 디스코드 서버에 가입하시면 모델, 프롬프트, 워크플로우 등에 대해 다른 사용자들과 토론하고 정보를 공유할 수 있습니다.

이 툴을 활용하면 누구나 손쉽게 자신만의 로컬 환경에서 LLM을 체험하고 개발할 수 있게 됩니다.

Llama 3 8B Instruct 를 다운로드 받아 보겠습니다. 요구사항은 8기가 랩 이상이 필요하며 파일 크기는 4.92 기가네요.

![[LM Studio] 오프라인 로컬에서 LLM을 구동하는 쉬운 방법 image 4](https://server.tilnote.io/images/pages/34c12fbc-7c0d-462f-bddb-df8c6813bd95.png)

AI Chat 메뉴를 선택합니다.

![[LM Studio] 오프라인 로컬에서 LLM을 구동하는 쉬운 방법 image 5](https://server.tilnote.io/images/pages/e66761d4-91aa-4fc7-a65c-ea11ed877771.png)

오른쪽에 Settings 에서 원하는 모델을 선택합니다. (모델을 다운 받아야 세팅이 됩니다.)

저는 Llama 3 8B Instruct을 선택했으므로 이것으로 선택하겠습니다.

![[LM Studio] 오프라인 로컬에서 LLM을 구동하는 쉬운 방법 image 6](https://server.tilnote.io/images/pages/f064e8d0-5408-46a4-a063-1667c34048a9.png)

![[LM Studio] 오프라인 로컬에서 LLM을 구동하는 쉬운 방법 image 7](https://server.tilnote.io/images/pages/86f8a868-168b-403c-8971-5e94110f8f23.png)

ACCEPT NEW SYSTEM PROMPT를 선택합니다.

![[LM Studio] 오프라인 로컬에서 LLM을 구동하는 쉬운 방법 image 8](https://server.tilnote.io/images/pages/c989f222-9260-476a-a3f9-c0ac76c121bd.png)

상단에 다운 받은 모델 중에서 사용할 모델을 선택합니다.

![[LM Studio] 오프라인 로컬에서 LLM을 구동하는 쉬운 방법 image 9](https://server.tilnote.io/images/pages/924def38-adf4-4df9-8f5e-1bf10684c6f5.png)

(phi 2를 사용하다가 라마 3로 바꾸게 되면 이렇게 됩니다.

![[LM Studio] 오프라인 로컬에서 LLM을 구동하는 쉬운 방법 image 10](https://server.tilnote.io/images/pages/c64474e2-d034-41c5-9775-f2a5e2f80a79.png)

![[LM Studio] 오프라인 로컬에서 LLM을 구동하는 쉬운 방법 image 11](https://server.tilnote.io/images/pages/ab77add4-f700-40b7-9232-17c656f10fc8.png)

모델을 선택하였으니 준비가 되었습니다. 대화를 나눠 보겠습니다.

![[LM Studio] 오프라인 로컬에서 LLM을 구동하는 쉬운 방법 image 12](https://server.tilnote.io/images/pages/dc8f0288-cf8a-4f5d-9b3b-50e2c081faf2.png)

이 부분을 보면서 자신의 컴퓨터 사양과 모델이 적합한지 판단할 수 있습니다.

phi 2 와 대화를 나눌 때는 잘 진행이 되었습니다.

![[LM Studio] 오프라인 로컬에서 LLM을 구동하는 쉬운 방법 image 13](https://server.tilnote.io/images/pages/8f711e72-4731-48e5-9510-cb7594df038f.png)

저는 m2, 8기가 램이라서 llama 3 를 돌리면 매우 느려지네요. (ㅠㅠ)

![[LM Studio] 오프라인 로컬에서 LLM을 구동하는 쉬운 방법 image 14](https://server.tilnote.io/images/pages/30a70843-1e16-4aae-bb04-fb37e3be38d9.png)

로컬 서버 설정 (솔직히 이 부분은 내 능력 밖이라 설명하기 어렵다)

![[LM Studio] 오프라인 로컬에서 LLM을 구동하는 쉬운 방법 image 15](https://server.tilnote.io/images/pages/53e2872c-6345-4043-a4f4-7253bd20f486.png)

Local Inference Server는 OpenAI API의 일부 엔드포인트를 모방하는 로컬 HTTP 서버를 시작하는 기능입니다.

주요 엔드포인트로는 /v1/chat/completions, /v1/embeddings, /v1/models 등이 지원됩니다.

사용 방법은 간단합니다. 화면에 보이는 Configuration 섹션에서 Server Port를 설정하고 Start Server 버튼을 클릭하면 서버가 시작됩니다.

시작된 서버는 POST /v1/embeddings 엔드포인트를 통해 텍스트 임베딩 모델을 활용할 수 있게 해줍니다. Examples 섹션의 코드 예시처럼 curl이나 프로그래밍 언어의 HTTP 클라이언트로 API를 호출하면 됩니다.

Advanced Configuration을 펼치면 CORS 설정, Request Queuing 등 고급 옵션을 조정할 수 있고, 서버 로그도 화면 하단에서 확인 가능합니다.

My Model 로 들어가면 다운받은 모델을 확인할 수 있습니다.

![[LM Studio] 오프라인 로컬에서 LLM을 구동하는 쉬운 방법 image 16](https://server.tilnote.io/images/pages/6ef051e4-2509-41c0-ae3a-9228ed50721a.png)

![[LM Studio] 오프라인 로컬에서 LLM을 구동하는 쉬운 방법 image 17](https://server.tilnote.io/images/pages/d9db7a09-41f2-4f03-99f9-96ddf94903a7.png)